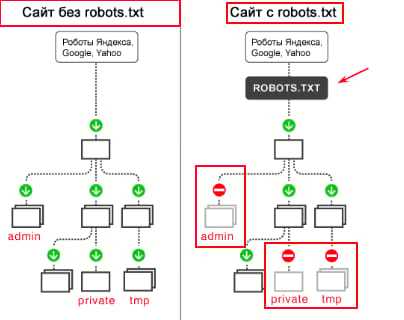

По умолчанию платформа Tilda не предоставляет прямого доступа к файлу robots.txt, так как все проекты размещаются на серверах Tilda Publishing. Однако изменить или дополнить содержимое этого файла можно через встроенные настройки сайта, что позволяет управлять индексацией страниц и контролировать поведение поисковых роботов.

Для изменения файла robots.txt необходимо перейти в настройки проекта: в панели управления выберите нужный сайт, затем откройте раздел Настройки → SEO. В блоке «robots.txt» можно добавить собственные инструкции, которые автоматически дополнят стандартное содержимое, генерируемое системой. Это особенно важно для исключения отдельных страниц из индексации, например, временных лендингов или страниц с параметрами.

Если сайт размещается на собственном домене и используется прокси-сервер или CDN с возможностью управления файлами, возможно полное переопределение файла robots.txt. Но при размещении исключительно на Tilda, единственный доступный способ – редактирование через интерфейс настроек, что ограничивает гибкость, но при этом достаточно для большинства SEO-задач.

Рекомендация: после внесения изменений проверьте результат через Google Search Console, используя инструмент «Проверка robots.txt», чтобы убедиться в корректности синтаксиса и правильной интерпретации директив поисковыми системами.

Как изменить файл robots.txt на Tilda

На Tilda нет прямого доступа к серверу или файловой системе, поэтому редактирование файла robots.txt происходит через встроенные настройки. Чтобы внести изменения, перейдите в «Настройки сайта» – «SEO». В нижней части страницы находится поле «Дополнительные правила для robots.txt».

Добавьте необходимые директивы, например:

User-agent: *

Disallow: /private/

Allow: /

Если нужно полностью закрыть сайт от индексации, укажите:

User-agent: *

Disallow: /

После внесения изменений нажмите «Сохранить» и опубликуйте сайт заново, чтобы обновлённый файл стал доступен по адресу https://ваш_домен/robots.txt.

Убедитесь в результате: откройте robots.txt в браузере или используйте инструменты проверки от Google Search Console. Не дублируйте директивы, это может вызвать ошибки интерпретации поисковыми системами.

Где находится файл robots.txt в Tilda

В Tilda файл robots.txt не хранится на сервере проекта в виде отдельного файла. Его содержимое формируется системой автоматически и доступно по адресу https://ваш_домен/robots.txt после подключения собственного домена.

До публикации сайта на собственном домене доступ к robots.txt отсутствует. Временные домены Tilda (например, project12345.tilda.ws) не предоставляют этот файл.

После подключения домена и публикации сайта Tilda генерирует файл robots.txt с базовыми директивами, такими как разрешение для всех роботов и указание на карту сайта:

User-agent: *

Sitemap: https://ваш_домен/sitemap.xml

Чтобы просмотреть или проверить текущий robots.txt, откройте его напрямую в браузере по ссылке https://ваш_домен/robots.txt. Внести изменения можно только через настройки проекта в панели Tilda, поскольку прямого доступа к файлу нет.

Как добавить собственный файл robots.txt через настройки сайта

На платформе Tilda нельзя напрямую редактировать файл robots.txt, но можно добавить собственную версию через настройки сайта. Это доступно только на платных тарифах, начиная с Business.

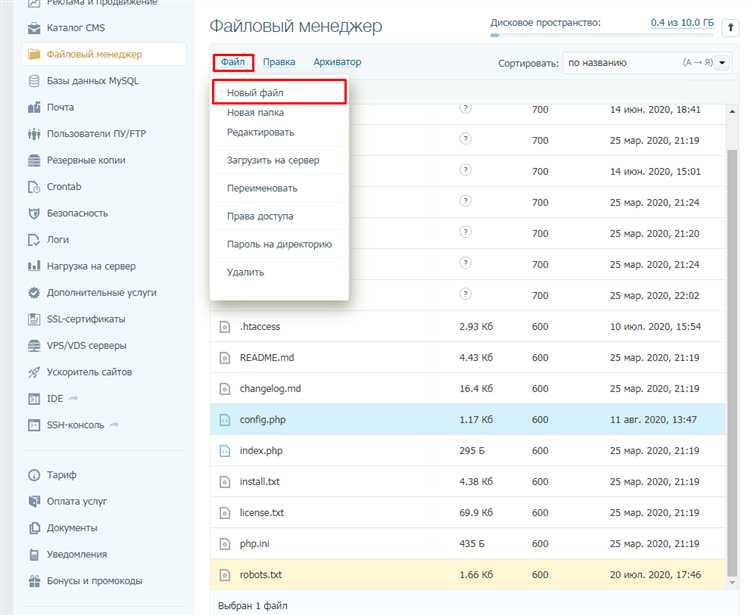

- Откройте «Настройки сайта» в панели управления проекта.

- Перейдите в раздел «SEO».

- Найдите блок «robots.txt» и включите опцию «Задать собственный robots.txt».

- В текстовое поле вставьте свой файл. Пример содержимого:

User-agent: * Disallow: /private/ Allow: / Sitemap: https://example.com/sitemap.xml

- Указывайте абсолютные пути, начиная с корня сайта.

- Файл не должен содержать синтаксических ошибок: каждая директива – с новой строки, без лишних пробелов.

- Проверьте файл через инструмент «robots.txt Tester» в Google Search Console, чтобы исключить блокировку важных страниц.

После сохранения изменений файл будет доступен по адресу https://ваш-домен.ru/robots.txt. Убедитесь, что он обновился, очистив кэш браузера или проверив через curl-запрос.

Что делать, если robots.txt не отображается после публикации

Если после публикации сайта на Tilda файл robots.txt недоступен по адресу yourdomain.com/robots.txt, выполните следующие шаги для устранения проблемы.

1. Убедитесь, что сайт подключён к собственному домену. На бесплатных поддоменах Tilda (например, project123.tilda.ws) robots.txt формируется автоматически и не подлежит редактированию. Пользовательский файл работает только при подключении внешнего домена.

2. Проверьте, что вы добавили файл robots.txt в разделе «Настройки сайта» → «SEO» → «robots.txt». Введите нужный текст и нажмите «Сохранить». Публикация должна быть выполнена заново после внесения изменений.

3. Если после публикации robots.txt всё ещё недоступен, очистите кэш браузера или откройте ссылку в режиме инкогнито. Tilda может кэшировать файл до 10–15 минут после обновления.

4. Убедитесь, что DNS-записи домена корректны. Неправильные A- или CNAME-записи могут вести на другой сервер, где файл отсутствует.

5. Проверьте наличие SSL-сертификата. При переходе на https:// без SSL может произойти редирект или блокировка, в результате чего robots.txt не загружается.

6. Используйте сторонние инструменты, например robots.txt tester, чтобы убедиться, что файл действительно недоступен не только в вашем браузере.

7. Если проблема сохраняется, временно отключите подключённые сторонние CDN или прокси, которые могут перезаписывать или блокировать доступ к robots.txt.

8. Обратитесь в техническую поддержку Tilda, если ни один из способов не дал результата. Укажите точный домен и подтвердите публикацию через внешний хостинг.

Как временно закрыть сайт от индексации через robots.txt

Чтобы запретить поисковым системам индексировать сайт, необходимо внести конкретные правила в файл robots.txt. Это особенно актуально на этапе разработки или редизайна.

- Откройте Tilda: в «Настройках сайта» перейдите в раздел «SEO» → «Редактировать robots.txt».

- Добавьте следующие строки:

User-agent: * Disallow: /

User-agent: *– правило применимо ко всем поисковым роботам.Disallow: /– запрещает индексацию всех страниц сайта.

Сохраните изменения и опубликуйте сайт заново, чтобы правила вступили в силу.

Для проверки используйте инструмент Google Robots.txt Tester. Убедитесь, что указанные правила действительно блокируют доступ к страницам.

Важно: такой запрет не удаляет сайт из поисковой выдачи, если он уже был проиндексирован. Для удаления используйте «Удаление URL» в Google Search Console.

Когда работа над сайтом завершена, обязательно удалите строки Disallow: / и обновите файл, иначе сайт останется недоступным для индексации.

Какие директивы можно использовать в файле robots.txt на Tilda

Файл robots.txt на платформе Tilda позволяет регулировать доступ поисковых систем к контенту сайта. Для этого можно использовать несколько ключевых директив. Рассмотрим основные из них:

User-agent – указывает, к какому поисковому боту применяются следующие правила. Например, для всех поисковых систем можно использовать:

User-agent: *

Если нужно ограничить доступ только для одного бота, например, для Googlebot, следует указать:

User-agent: Googlebot

Disallow – запрещает индексацию определённых страниц или разделов сайта. Пример:

Disallow: /private/

Эта директива блокирует доступ к каталогу «/private/». Если нужно запретить индексацию только одной страницы, указывается путь к ней:

Disallow: /private/page.html

Allow – даёт разрешение на индексацию отдельных страниц или файлов, даже если они находятся в запрещённых разделах. Например, можно разрешить индексацию изображений в закрытой папке:

Disallow: /private/ Allow: /private/image.jpg

Sitemap – указывает путь к файлу карты сайта, что помогает поисковым системам лучше индексировать страницы. Пример:

Sitemap: https://example.com/sitemap.xml

Crawl-delay – устанавливает задержку между запросами поискового робота, чтобы не перегружать сервер. Для Tilda этот параметр редко применяется, но он может быть полезен для сайтов с большим количеством страниц:

Crawl-delay: 10

Host – в случае, если сайт доступен по нескольким доменам, можно указать основной, чтобы избежать дублирования контента:

Host: www.example.com

Использование этих директив позволяет гибко контролировать доступ поисковых систем к сайту, что важно для SEO-оптимизации и защиты конфиденциальных данных.

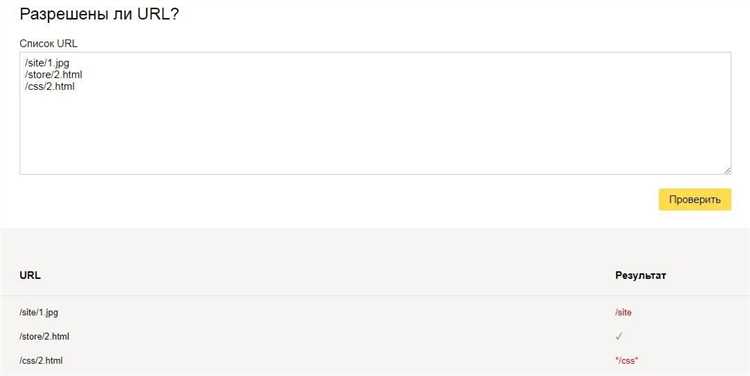

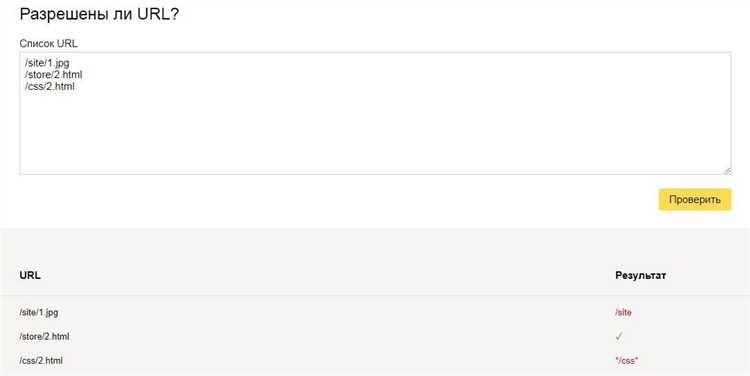

Как проверить, что изменения в robots.txt применились

Для проверки того, что изменения в файле robots.txt вступили в силу, существует несколько способов. Один из них – использовать Google Search Console. После того как файл будет обновлён, зайдите в инструмент «Проверка URL» и введите путь к robots.txt вашего сайта. Google Search Console покажет актуальную версию файла, которую он видит, и позволит удостовериться, что изменения корректно применились.

Другой способ – это ручная проверка файла через браузер. Просто введите в адресной строке URL вашего сайта с добавлением «/robots.txt» (например, example.com/robots.txt). Вы увидите текущую версию файла. Если изменения были сделаны правильно, они должны отображаться на странице.

Можно также использовать инструменты для анализа robots.txt, такие как Screaming Frog SEO Spider. Эта программа позволяет сканировать сайт и проверять, какие директивы из robots.txt применяются к каждой странице. Если изменения в файле правильные, программа отразит их в отчёте.

Ещё один способ – это проверить поведение поисковых ботов. Например, если вы заблокировали определённые страницы, можно попытаться найти их через поисковую систему. Если страницы не появляются в результатах поиска, значит, изменения вступили в силу.

Наконец, важно помнить, что поисковые системы могут не сразу обновлять свою информацию. Обычно изменения в robots.txt могут занять от нескольких часов до нескольких дней, чтобы они были учтены и применены поисковыми системами.

Вопрос-ответ:

Как изменить файл robots.txt на Tilda?

Для того чтобы изменить файл robots.txt на Tilda, нужно выполнить несколько простых шагов. Во-первых, зайдите в раздел «SEO» в настройках вашего сайта на Tilda. Далее выберите вкладку «robots.txt» и откроется редактор, в котором можно вручную добавить необходимые строки, например, запретить или разрешить доступ к различным страницам сайта для поисковых систем. После этого не забудьте сохранить изменения.

Можно ли добавить дополнительные правила в файл robots.txt на Tilda?

Да, на Tilda можно добавить дополнительные правила в файл robots.txt. В редакторе, который доступен в настройках сайта, можно самостоятельно вводить строки с нужными директивами, например, запретить доступ к определённым папкам или страницам сайта, разрешить доступ к специфическим разделам и т. д. Главное — не забыть после внесения изменений сохранить файл, чтобы они вступили в силу.

Зачем менять файл robots.txt на Tilda?

Изменение файла robots.txt на Tilda важно для того, чтобы управлять индексацией страниц вашего сайта поисковыми системами. Например, вы можете закрыть от индексации страницы, которые не имеют значения для SEO, такие как страницы с фильтрами, дублирующие контент, или временные страницы. Это поможет улучшить эффективность индексации сайта и его видимость в поисковых системах.

Как проверить, что файл robots.txt на Tilda работает правильно?

Для проверки корректности работы файла robots.txt можно использовать инструменты для веб-мастеров, например, Google Search Console. В Google Search Console есть возможность протестировать файл robots.txt, чтобы убедиться, что поисковые системы правильно интерпретируют ваши правила. Также можно проверить доступность файла через браузер, перейдя по ссылке вида www.вашсайт/robots.txt и убедившись, что он открывается с правильным содержимым.

Как изменить файл robots.txt на Tilda?

Чтобы изменить файл robots.txt на Tilda, нужно пройти несколько простых шагов. Вначале откройте настройки вашего сайта в админке Tilda. Перейдите в раздел «SEO» и найдите пункт «Файл robots.txt». Здесь вы можете добавить, изменить или удалить директивы, которые будут управлять доступом поисковых систем к вашему сайту. После внесения изменений, не забудьте сохранить изменения, чтобы они вступили в силу.