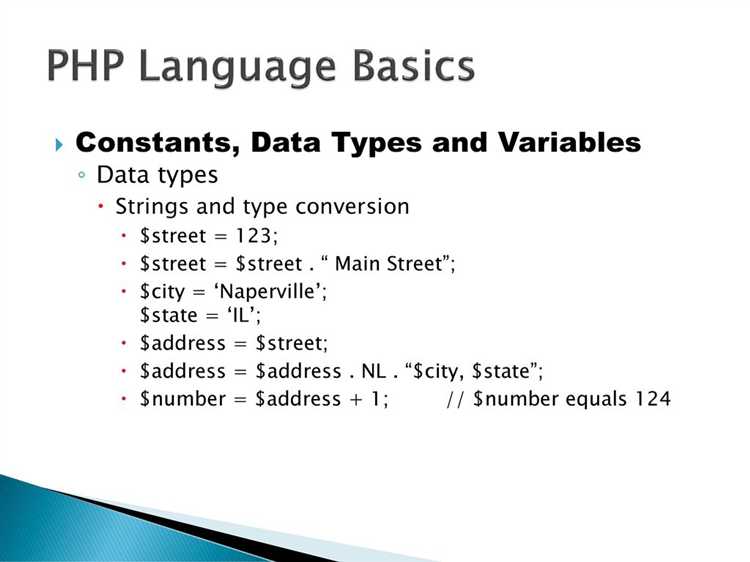

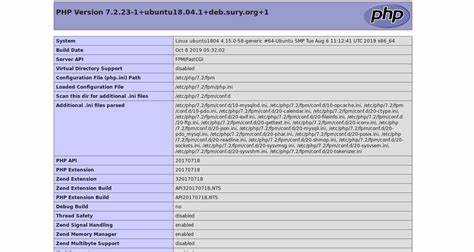

Большинство ботов оставляют технические следы, которые можно зафиксировать на стороне сервера. Один из первых признаков – отсутствие или аномальное значение заголовка User-Agent. Многие скрипты не передают его вовсе или используют нестандартные строки. В PHP доступ к заголовку осуществляется через $_SERVER[‘HTTP_USER_AGENT’]. Если значение пустое или содержит подозрительную строку, это может быть бот.

Следующий признак – необычная частота запросов с одного IP. Для фиксации этого поведения можно сохранять временные метки обращений в сессию, файл или базу данных. Если один и тот же IP делает десятки запросов за секунду – это нехарактерно для человека. Например, можно использовать microtime(true) и сравнивать разницу между текущим и предыдущим обращением.

Еще один способ – проверка поддержки JavaScript. PHP сам по себе не может напрямую определить это, но можно сгенерировать уникальный токен и передать его на клиент с помощью JS, после чего проверить его наличие в следующем запросе. Боты, не исполняющие JavaScript, не смогут его вернуть. Такой механизм позволяет отсеивать базовые сканеры.

Дополнительно полезно анализировать заголовок Referer. Его отсутствие в сочетании с другими признаками может указывать на автоматический запрос. Проверка значения через $_SERVER[‘HTTP_REFERER’] помогает выявить обращения, сделанные вне контекста сайта, что характерно для парсеров и ботов.

Комбинация этих методов позволяет с высокой вероятностью выявить нежелательный трафик и принять меры – от простого логирования до блокировки доступа на уровне PHP или веб-сервера.

Проверка заголовка User-Agent на наличие признаков бота

Заголовок User-Agent позволяет определить тип клиента, сделавшего запрос. Боты часто используют явно указанные идентификаторы или нестандартные строки, которые можно отфильтровать.

- Проверь наличие ключевых слов, характерных для известных ботов:

bot,crawler,spider,scraper,fetch,monitor,scan,headless,python-requests,curl,wget. - Сравни

User-Agentс базой известных агентов ботов. Используй списки от поисковых систем (например, Googlebot, Bingbot) и общеизвестные сканеры. - Проверь длину строки

User-Agent. Боты часто используют либо слишком короткие строки, либо наоборот – перегруженные служебной информацией. - Оцени структуру строки. Отсутствие информации о браузере, системе и версии часто указывает на автоматический скрипт.

- Сравни

User-Agentс заголовкамиAccept,Accept-Language,Referer. Несогласованность между ними может указывать на подделку заголовка.

Пример фильтрации на PHP:

$userAgent = $_SERVER['HTTP_USER_AGENT'] ?? '';

$patterns = [

'/bot/i',

'/crawl/i',

'/spider/i',

'/fetch/i',

'/headless/i',

'/python/i',

'/curl/i',

'/wget/i',

'/httpclient/i'

];

$isBot = false;

foreach ($patterns as $pattern) {

if (preg_match($pattern, $userAgent)) {

$isBot = true;

break;

}

}

Дополнительно логируй подозрительные строки для анализа и обновления фильтра.

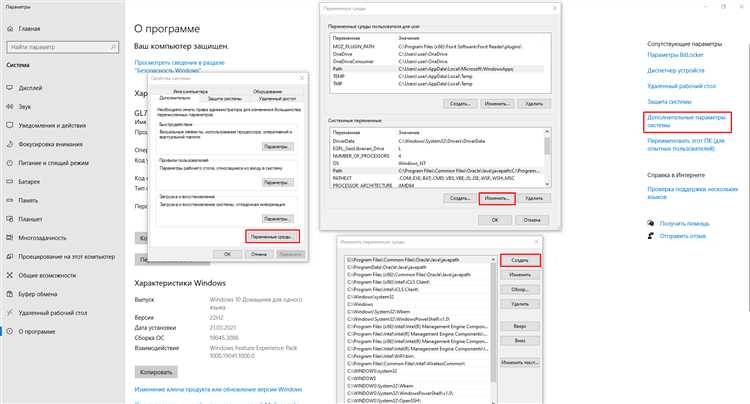

Фильтрация по IP-адресам из известных бот-сетей

Для отсечения трафика от автоматических скриптов стоит использовать списки IP-адресов, ассоциированных с бот-сетями и вредоносной активностью. Один из вариантов – интеграция с сервисами, предоставляющими актуальные блэклисты: AbuseIPDB, Project Honeypot, Spamhaus DROP.

В PHP можно реализовать проверку IP при каждом запросе:

$clientIP = $_SERVER['REMOTE_ADDR'];

$blacklist = file('blacklist.txt', FILE_IGNORE_NEW_LINES | FILE_SKIP_EMPTY_LINES);

if (in_array($clientIP, $blacklist)) {

http_response_code(403);

exit('Access denied');

}

Файл blacklist.txt следует обновлять автоматически через cron, парся данные с надёжных источников. Также можно использовать DNSBL-запросы. Пример запроса к Spamhaus:

function isBlacklisted($ip) {

$reversed = implode('.', array_reverse(explode('.', $ip))) . '.zen.spamhaus.org';

return checkdnsrr($reversed, 'A');

}

Не стоит полагаться только на локальные списки – динамика бот-сетей требует регулярного обновления. Рекомендуется логировать заблокированные IP и проверять, не попали ли реальные пользователи под фильтр. Для снижения нагрузки запросы к внешним сервисам желательно кэшировать в базе или Redis.

Анализ частоты запросов с одного IP за короткий промежуток времени

Для выявления подозрительной активности со стороны ботов на PHP можно использовать фиксацию количества запросов с одного IP-адреса в пределах заданного интервала времени. Например, если один и тот же IP делает более 20 запросов за 10 секунд, это может быть признаком автоматического скрипта.

Хранить данные удобно в Redis, Memcached или хотя бы во временной таблице базы данных. Пример на PHP с использованием Redis:

$ip = $_SERVER['REMOTE_ADDR'];

$key = 'req_count_' . $ip;

$limit = 20;

$interval = 10; // секунд

$count = $redis->get($key);

if ($count === false) {

$redis->setex($key, $interval, 1);

} else {

if ($count >= $limit) {

// Превышение лимита: возможно, бот

http_response_code(429);

exit('Слишком много запросов');

} else {

$redis->incr($key);

}

}

Такой подход позволяет отсеивать агрессивных ботов без задержек на стороне пользователя. Для надёжности рекомендуется также логировать превышения лимита в отдельный журнал и отслеживать частые повторения по времени и IP-адресам.

Важно учитывать, что у некоторых пользователей может быть общий IP, особенно при использовании мобильных сетей или прокси. Поэтому при частых ложных срабатываниях лучше добавить проверку User-Agent и шаблон поведения (например, последовательность посещаемых URL).

Обнаружение отсутствия загрузки JavaScript на клиентской стороне

Для фиксации отсутствия выполнения JavaScript можно использовать метод внедрения скрытого параметра, который должен быть установлен только через скрипт на клиенте. Если значение не передано, это свидетельствует о том, что скрипты не выполнялись – характерное поведение бота.

Пример реализации: при генерации страницы сервер вставляет скрытое поле в форму или элемент <input type="hidden"> с пустым значением. Затем JavaScript на клиенте должен изменить его значение. На сервере при получении запроса проверяется, было ли поле заполнено. Если нет – можно считать запрос подозрительным.

Пример вставки поля:

<input type="hidden" name="js_check" id="js_check" value="">Пример скрипта, который должен выполниться на клиенте:

<script>

document.getElementById('js_check').value = '1';

</script>На стороне PHP-процессора формы проверяется наличие и значение $_POST['js_check']. Если оно отсутствует или пустое, можно считать, что JavaScript не был выполнен:

if (empty($_POST['js_check'])) {

// Подозрительный запрос – возможен бот

}Этот способ не гарантирует защиту от продвинутых ботов с поддержкой JavaScript, но эффективно отсекает простые скрипты и curl-запросы, которые не интерпретируют клиентский код.

Проверка поддержки и использования cookies

Для выявления бота можно использовать проверку на поддержку cookies. Реальные браузеры обрабатывают cookies автоматически, тогда как большинство скриптовых ботов либо игнорируют их, либо не сохраняют между запросами.

На первом шаге сервер генерирует случайный идентификатор и устанавливает cookie:

setcookie("check_cookie", bin2hex(random_bytes(8)), time() + 300, "/");

После этого пользователь перенаправляется на ту же страницу или другую с минимальной задержкой:

if (!isset($_COOKIE['check_cookie'])) {

header("Location: " . $_SERVER['REQUEST_URI']);

exit;

}

Если после перенаправления cookie отсутствует, это может свидетельствовать о работе скрипта без поддержки cookies. Для повышения точности можно сохранить значение cookie в сессии и сравнить его с возвращённым значением:

session_start();

if (!isset($_SESSION['expected_cookie'])) {

$token = bin2hex(random_bytes(8));

$_SESSION['expected_cookie'] = $token;

setcookie("check_cookie", $token, time() + 300, "/");

header("Location: " . $_SERVER['REQUEST_URI']);

exit;

}

if (!isset($_COOKIE['check_cookie']) || $_COOKIE['check_cookie'] !== $_SESSION['expected_cookie']) {

// возможный бот

}

Также полезно анализировать, сколько раз подряд один и тот же IP не возвращает cookie. Повторяющееся поведение без поддержки может говорить о скриптовой активности. Для дополнительной надёжности можно использовать cookie с флагом HttpOnly и проверить, сохраняется ли оно между действиями, требующими JavaScript.

Определение подозрительных шаблонов поведения на сайте

Для выявления ботов на сайте важно отслеживать аномальные действия пользователей. Подозрительные шаблоны поведения включают несколько ключевых факторов:

- Частота запросов. Боты могут отправлять большое количество запросов за короткое время. Это можно определить, если наблюдается аномально высокая активность с одного IP-адреса или пользовательского агента.

- Повторяющиеся действия. Боты часто выполняют однотипные действия (например, клики по определённым элементам или частое обновление страницы). Записывайте повторяющиеся запросы и анализируйте их частоту.

- Отсутствие взаимодействия с элементами страницы. Боты не взаимодействуют с визуальными элементами сайта, такими как кнопки или формы. Отслеживание событий на клиентской стороне помогает выявить ботов, которые пропускают такие действия.

- Странное поведение с cookies. Боты могут игнорировать cookies или использовать нестандартные значения. Проверка наличия cookies и их валидности может помочь в выявлении подозрительных сессий.

- Скорость заполнения форм. Если форма на сайте заполняется быстрее, чем это возможно для человека, это может быть признаком автоматической отправки данных ботом. Важно установить таймауты для форм и отслеживать скорость их заполнения.

- Источник трафика. Проверяйте рефереры и пользовательские агенты. Боты часто приходят с нестандартных источников или используют устаревшие браузеры для маскировки.

- Неверный порядок действий. Некоторые боты могут нарушать ожидаемую последовательность действий пользователя. Например, они могут пропустить шаги в процессе регистрации или оформления заказа, или делать запросы к серверу в неподобающем порядке.

Пример реализации отслеживания частоты запросов:

$max_requests_per_minute) {

// Определение бота

echo "Подозрительная активность!";

}

} else {

$_SESSION['last_request_time'] = $current_time;

$_SESSION['request_count'] = 1;

}

?>

Эти шаблоны можно эффективно выявить с помощью регулярного анализа логов и мониторинга активности. Важно использовать методы, которые не вмешиваются в повседневную работу пользователей, но позволяют быстро обнаружить аномалии.

Сравнение времени отклика пользователя с типичным временем реакции человека

Боты, как правило, демонстрируют стабильность и скорость отклика, которые значительно ниже человеческого уровня. Например, бот может выполнить несколько запросов за доли секунды, что для человека невозможно без ошибок или замедлений. Разработка системы на PHP, которая отслеживает скорость отклика, позволяет выявлять такие аномалии и эффективно отличать ботов от реальных пользователей.

Типичное время отклика пользователя при взаимодействии с веб-страницей составляет 300-600 миллисекунд для одной операции, включая перемещения курсора и время, необходимое для принятия решения (например, выбор ссылки или заполнение формы). В отличие от человека, бот может обработать запросы за 50-100 миллисекунд, что позволяет ему совершать операции с высокой частотой, не допуская ошибок. Это значительное различие является важным индикатором, который можно использовать для анализа подозрительной активности на сайте.

Для эффективного определения бота можно использовать следующую методику: отслеживание задержки между запросами, выявление слишком быстрых или регулярных откликов, а также анализ поведения на странице (например, отсутствие движения курсора или быстрая прокрутка без изменения активности пользователя). Включение этих проверок в код PHP значительно улучшает точность выявления ботов.

Логирование и разбор аномалий в HTTP-заголовках запроса

Для выявления ботов на сайте важно не только анализировать поведение пользователей, но и тщательно отслеживать HTTP-заголовки запросов. Заголовки содержат ценную информацию о клиенте, его действиях и устройстве. Аномалии в этих данных могут служить индикаторами использования автоматизированных инструментов.

Одним из первых шагов в логировании запросов является сохранение всех HTTP-заголовков. В PHP это можно реализовать через функцию getallheaders(), которая возвращает ассоциативный массив всех заголовков запроса. Рекомендуется записывать заголовки в файл или базу данных для дальнейшего анализа.

Примеры аномальных заголовков, которые могут указывать на бота:

- User-Agent с подозрительными значениями, такими как стандартные или пустые строки, которые часто встречаются у ботов.

- Referer, который либо отсутствует, либо указывает на нехарактерные для пользователя сайты.

- Accept-Language, если этот заголовок либо отсутствует, либо его значение не совпадает с типичными настройками для региона пользователя.

- Connection, если присутствует значение

keep-aliveбез явной необходимости.

Для выявления аномальных заголовков можно реализовать регулярные выражения, которые проверяют их формат и содержание. Например, если в заголовке User-Agent присутствуют строки, которые не соответствуют общим браузерным агентам, это может быть признаком бота.

После сбора данных следует анализировать их на наличие повторяющихся запросов с одинаковыми или схожими заголовками, что характерно для ботов, сканирующих сайт или выполняющих однотипные действия. В PHP можно использовать инструменты для логирования, такие как error_log() или сторонние библиотеки, которые позволяют фильтровать и сортировать данные по времени, IP-адресу и другим параметрам.

Для повышения точности диагностики аномальных запросов стоит также учитывать время между запросами. Боты часто делают запросы с фиксированными интервалами, что отличается от поведения обычных пользователей. Это можно отслеживать, сравнивая время запроса с предыдущими записями в логах.

Использование логирования и анализа HTTP-заголовков позволяет точно выявлять поведение, характерное для ботов, и оперативно реагировать на аномалии в запросах.

Вопрос-ответ:

Как можно определить бота на сайте, используя PHP?

Для определения бота на сайте можно использовать несколько методов. Один из них — это проверка пользовательского агента (User-Agent), который браузеры отправляют при каждом запросе. Боты часто используют определенные строки в User-Agent, которые позволяют их идентифицировать. Также можно анализировать поведение на сайте, например, скорость загрузки страниц, количество запросов с одного IP-адреса за короткий промежуток времени, или отсутствие сессии с реальным пользователем.

Какие функции PHP помогают различить ботов от обычных пользователей?

В PHP можно использовать функцию get_browser(), которая возвращает информацию о браузере, операционной системе и устройствах, что может помочь в определении, является ли посетитель ботом. Также полезными могут быть функции для анализа IP-адреса, например, с использованием базы данных для проверки, не является ли этот IP адрес частью известных бот-сетей. Дополнительно, можно установить таймер для отслеживания времени на странице — если пользователь не взаимодействует с ней длительное время, скорее всего, это бот.

Можно ли распознать бота по его активности на сайте с помощью PHP?

Да, это возможно. Один из способов — отслеживание частоты запросов с одного IP-адреса. Если один и тот же адрес делает слишком много запросов за короткий период, это может быть признаком работы бота. Можно установить лимиты на количество запросов в минуту и если пользователь превышает этот лимит, отправлять его запросы на проверку. Также боты часто не выполняют сложные действия, такие как заполнение форм или нажатие кнопок, что можно отслеживать с помощью PHP.

Как отличить бота от обычного пользователя через CAPTCHA на PHP?

Для защиты от ботов можно использовать CAPTCHA (например, Google reCAPTCHA). Когда пользователь заходит на сайт, CAPTCHA требует от него выполнить задачу, которая обычно трудна для ботов, например, распознавание текста на изображении или выбор правильных объектов на фото. На PHP можно интегрировать различные CAPTCHA-сервисы, проверяя правильность ввода перед отправкой формы. Если введенная информация неверна, скорее всего, это бот, так как он не способен правильно решить эти задачи.

Как можно уменьшить вероятность попадания ботов на сайт с помощью PHP?

Для уменьшения вероятности попадания ботов на сайт можно использовать несколько подходов. Во-первых, проверка заголовков HTTP запросов (например, User-Agent) и IP-адресов с использованием списков известных ботов поможет заблокировать их на уровне сервера. Во-вторых, можно использовать сессии или cookies для того, чтобы убедиться, что запросы исходят от реального пользователя, а не от скрипта. Также полезно устанавливать временные ограничения на выполнение некоторых действий (например, период ожидания между отправкой форм), чтобы предотвратить автоматические действия ботов.

Как можно определить бота на PHP с помощью кода?

Для определения бота на PHP можно использовать несколько методов. Один из них — проверка User-Agent. Боты часто используют специфические строки в заголовках HTTP-запросов. Например, в PHP можно использовать функцию `getallheaders()` для получения всех заголовков запроса и фильтрации по строкам, связанным с известными ботами (например, Googlebot или Bingbot). Также можно проверять IP-адреса, сопоставляя их с базами данных известных ботов, либо использовать капчи, чтобы удостовериться, что запрос исходит от человека.

Какие другие способы могут помочь в определении бота на PHP?

Кроме проверки User-Agent и IP-адреса, можно использовать более сложные методы. Например, проверка за счет анализа поведения пользователя: боты часто выполняют запросы с высокой частотой или с неестественными интервалами между ними. В таких случаях можно анализировать логи сервера, чтобы выявить подозрительную активность. Также можно интегрировать JavaScript-тесты, которые боты не могут выполнить, поскольку не поддерживают JavaScript. Кроме того, использование систем, таких как reCAPTCHA, помогает верифицировать реального пользователя и уменьшить количество ботов на сайте.