Построение разделяющей поверхности – ключевая задача в машинном обучении, особенно в методах классификации. Она позволяет определить границу, разделяющую классы в многомерном пространстве признаков. На практике это означает формирование функции, способной различать, например, спам и не спам, положительные и отрицательные отзывы, здоровые и больные клетки. В Python эту задачу эффективно решают с помощью библиотек scikit-learn, NumPy и matplotlib.

При работе с двумерными данными логистическая регрессия, метод опорных векторов (SVM) и деревья решений позволяют строить чётко выраженные границы. Например, SVM с линейным ядром определяет гиперплоскость, максимизирующую отступ между классами, а при использовании RBF-ядра – извлекает нелинейные границы в сложных пространствах.

Для визуализации результатов удобно использовать matplotlib.pyplot с функцией contourf, позволяющей отобразить предсказания модели на сетке координат. Это не только упрощает анализ, но и помогает в отладке – особенно при работе с переобучением или несбалансированными данными. В сочетании с train_test_split и cross_val_score можно получить объективную оценку качества модели и устойчивости построенной поверхности.

Особое внимание стоит уделить масштабированию признаков: функции StandardScaler или MinMaxScaler часто критичны для корректной работы SVM и логистической регрессии. Без предварительной нормализации модель может строить некорректную границу, особенно при разной размерности признаков.

Выбор алгоритма классификации для построения границы

При построении разделяющей поверхности важно учитывать характер данных, количество признаков, наличие шума и линейность границы. На линейно разделимых выборках оптимально применять метод опорных векторов (SVM) с линейным ядром. Он обеспечивает высокую скорость обучения и интерпретируемую гиперплоскость.

Если данные неразделимы линейно, предпочтительнее использовать SVM с радиально-базисным ядром (RBF) или деревья решений. SVM с RBF способен аппроксимировать сложные нелинейные границы, но чувствителен к выбору параметров C и γ. Рекомендуется использовать GridSearchCV для их подбора.

Для многоклассовой классификации с большим количеством пересекающихся классов логистическая регрессия показывает устойчивую производительность, особенно в задачах с плотными признаковыми матрицами. В малых выборках эффективны алгоритмы k-ближайших соседей (k-NN), но они плохо масштабируются и чувствительны к выбросам.

Градиентный бустинг (например, XGBoost или LightGBM) обеспечивает высокую точность и подходит для сложных, шумных данных, где необходимо учитывать взаимодействие признаков. Однако модели бустинга трудно интерпретировать и они требуют настройки гиперпараметров.

Для визуализации разделяющей поверхности важно, чтобы классификатор предоставлял доступ к вероятностным оценкам или градиенту решающей функции. Это исключает использование некоторых стохастических моделей, таких как случайный лес, если требуется гладкая граница.

Подготовка обучающих данных для построения разделяющей поверхности

Для построения эффективной разделяющей поверхности необходима выборка с чёткой границей между классами. Начните с генерации или загрузки данных, содержащих как минимум два признака, определяющих принадлежность к различным классам. В случае двумерного пространства признаков это позволяет визуализировать разделение на плоскости.

Шаг 1: Загрузка и нормализация

Используйте sklearn.datasets.make_classification или make_blobs для генерации данных с заданной дисперсией и центрами. После генерации выполните масштабирование признаков через StandardScaler, чтобы устранить влияние различий в шкалах признаков. Это особенно важно при использовании методов, чувствительных к масштабу, таких как SVM или логистическая регрессия.

Шаг 2: Разметка классов

Проверьте баланс классов с помощью np.bincount(y). Несбалансированная выборка может привести к смещению границы. При необходимости используйте sklearn.utils.resample для выравнивания классов путём oversampling или undersampling.

Шаг 3: Разделение на тренировочную и тестовую выборки

Применяйте train_test_split с параметром stratify=y, чтобы сохранить пропорции классов. Оптимальное соотношение: 70% для обучения и 30% для тестирования. Это позволяет объективно оценить, насколько хорошо построенная поверхность обобщает данные.

Шаг 4: Проверка линейной разделимости

Перед выбором модели визуализируйте данные с помощью matplotlib.pyplot.scatter. Если классы чётко отделяются прямой, имеет смысл использовать линейные методы. При наличии перекрытий – переходите к нелинейным алгоритмам с ядровыми функциями.

Подготовка данных напрямую влияет на точность разделяющей поверхности. Ошибки на этом этапе необратимо искажают результат независимо от выбранного алгоритма.

Обучение модели SVM с использованием библиотеки scikit-learn

Для построения разделяющей поверхности с использованием метода опорных векторов (SVM) в scikit-learn применяется класс sklearn.svm.SVC. Основные параметры, влияющие на качество разделения – C, kernel и gamma.

Перед обучением модель чувствительна к масштабу признаков. Используйте StandardScaler из sklearn.preprocessing для нормализации данных. Без этого ядровые методы SVM могут работать некорректно.

Пример минимального рабочего кода:

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

from sklearn.svm import SVC

X, y = datasets.make_classification(n_samples=300, n_features=2, n_informative=2,

n_redundant=0, class_sep=1.5, random_state=42)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

model = SVC(kernel='rbf', C=1.0, gamma='scale')

model.fit(X_train_scaled, y_train)

Выбор ядра зависит от характера задачи. Для линейно разделимых данных достаточно kernel=’linear’. Для более сложных границ предпочтительно ‘rbf’ или ‘poly’. Значение C управляет компромиссом между шириной разделяющей полосы и количеством ошибок классификации. Большое C уменьшает штраф за ошибку, что может привести к переобучению.

Для поиска оптимальных параметров применяйте GridSearchCV с кросс-валидацией. Не полагайтесь на значения по умолчанию – они подходят не для всех задач.

После обучения модель поддерживает методы predict и decision_function. Последний особенно полезен для визуализации разделяющей поверхности и анализа уверенности классификации.

Построение сетки координат для визуализации границы решений

Для построения разделяющей поверхности необходимо создать координатную сетку, охватывающую пространство признаков. Используйте numpy.meshgrid для генерации двумерной сетки на основе линейных интервалов каждой переменной:

x_min, x_max = X[:, 0].min() — 1, X[:, 0].max() + 1

y_min, y_max = X[:, 1].min() — 1, X[:, 1].max() + 1

xx, yy = np.meshgrid(np.linspace(x_min, x_max, 500),

np.linspace(y_min, y_max, 500))

Размерность 500×500 обеспечивает хорошее разрешение при умеренной нагрузке на память. Значения отступов на 1 единицу от крайних значений гарантируют отображение всей выборки.

Объедините координаты сетки в массив признаков с помощью np.c_:

grid = np.c_[xx.ravel(), yy.ravel()]

Передавайте полученный массив в обученную модель для предсказания классов или вероятностей:

Z = model.predict(grid)

Z = Z.reshape(xx.shape)

После этого используйте matplotlib.pyplot.contourf для отрисовки границы решений, передавая координатные матрицы и значения предсказаний:

plt.contourf(xx, yy, Z, alpha=0.3)

Для классификаторов, возвращающих вероятности, применяйте predict_proba и визуализируйте изолинии с уровнем 0.5 для бинарных задач:

Z = model.predict_proba(grid)[:, 1]

Z = Z.reshape(xx.shape)

plt.contour(xx, yy, Z, levels=[0.5], colors=’k’)

Визуализация должна строиться строго после масштабирования данных, если таковое применялось при обучении модели, иначе координаты сетки будут несовместимы с параметрами классификатора.

Использование функции decision_function для получения значений гиперплоскости

Для получения этих значений используется вызов:

scores = model.decision_function(X)Где X – массив признаков, а scores – массив расстояний до гиперплоскости. Знак результата определяет класс, а модуль – степень уверенности. При бинарной классификации scores будет одномерным, при многоклассовой – двумерным, где каждый элемент – значение для пары классов (в случае стратегии «один против одного»).

Использование decision_function важно при построении визуализации: нулевая изолиния значений соответствует самой гиперплоскости, а положительные и отрицательные области – разным классам. Это позволяет построить точную карту принятия решений:

xx, yy = np.meshgrid(...)

Z = model.decision_function(np.c_[xx.ravel(), yy.ravel()])

Z = Z.reshape(xx.shape)

plt.contour(xx, yy, Z, levels=[0], linewidths=2, colors='black')

Этот подход особенно полезен при анализе границ классов, выявлении выбросов и отладке модели. В отличие от predict_proba, decision_function отражает не вероятность, а геометрию решения, предоставляя более точную информацию о расположении объектов относительно гиперплоскости.

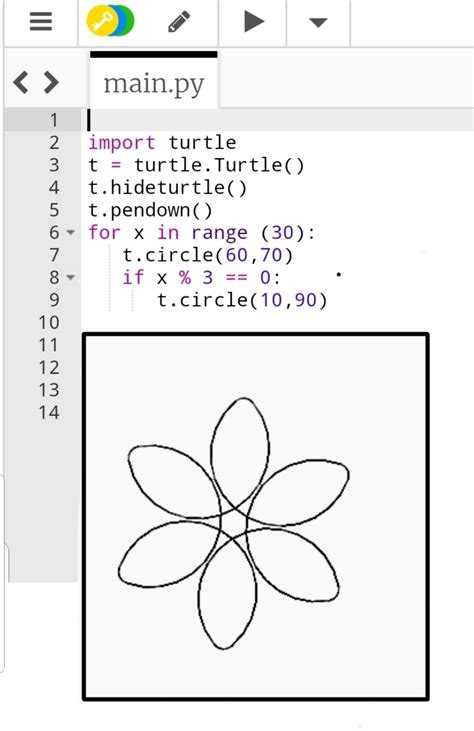

Построение графика с разделяющей поверхностью с помощью matplotlib

Для построения разделяющей поверхности с использованием библиотеки matplotlib в Python необходимо использовать 3D-графику. Этот процесс включает создание данных для поверхностей, их визуализацию с помощью функции plot_surface и настройку отображения, чтобы поверхность наглядно разделяла два класса данных.

Для начала, создадим пример 3D-графика, используя случайно сгенерированные данные и функцию разделяющей поверхности для классификации. Рассмотрим пример, где два класса данных разделены с помощью гиперплоскости.

import numpy as np

import matplotlib.pyplot as plt

from mpl_toolkits.mplot3d import Axes3D

from sklearn.datasets import make_classification

# Генерация случайных данных для классификации

X, y = make_classification(n_samples=100, n_features=3, n_informative=3, n_classes=2, random_state=42)

# Разделение данных по классам

class_0 = X[y == 0]

class_1 = X[y == 1]

# Построение 3D-графика

fig = plt.figure()

ax = fig.add_subplot(111, projection='3d')

# Отображение точек данных для двух классов

ax.scatter(class_0[:, 0], class_0[:, 1], class_0[:, 2], color='r', label='Класс 0')

ax.scatter(class_1[:, 0], class_1[:, 1], class_1[:, 2], color='b', label='Класс 1')

# Создание разделяющей поверхности

x = np.linspace(X[:, 0].min(), X[:, 0].max(), 100)

y = np.linspace(X[:, 1].min(), X[:, 1].max(), 100)

X_grid, Y_grid = np.meshgrid(x, y)

# Применение модели для вычисления значений разделяющей поверхности

Z = model.predict(np.c_[X_grid.ravel(), Y_grid.ravel()]).reshape(X_grid.shape)

# Построение разделяющей поверхности

ax.plot_surface(X_grid, Y_grid, Z, alpha=0.3, cmap='coolwarm')

# Настройки графика

ax.set_xlabel('Признак 1')

ax.set_ylabel('Признак 2')

ax.set_zlabel('Признак 3')

ax.legend()

plt.show()

В данном примере используется классификатор для определения разделяющей поверхности между двумя классами. Важно, чтобы модель, которая применяется для предсказания значений, могла точно разделить данные. Для этого следует использовать алгоритмы, такие как логистическая регрессия или SVM, обученные на предоставленных данных.

При построении графика с разделяющей поверхностью в matplotlib важно учитывать следующие моменты:

- Область определения: график должен охватывать область значений всех признаков. Это можно сделать с помощью функции

np.linspaceдля генерации диапазона значений по осям X и Y. - Модель: необходимо предварительно обучить модель на данных, чтобы правильно определить разделяющую поверхность. Часто для этого используют

sklearnи его классификаторы. - Визуализация: функция

plot_surfaceпозволяет задавать цветовую палитру и прозрачность поверхности, что помогает наглядно выделить разделение между классами.

Для улучшения визуализации можно дополнительно настроить отображение, добавив сетку, метки или изменяя углы поворота графика для лучшего восприятия разделяющей поверхности.

Анализ поведения разделяющей поверхности при изменении параметров модели

Одним из критичных факторов является параметр регуляризации в моделях типа Support Vector Machine (SVM). При увеличении коэффициента регуляризации поверхность становится более жёсткой, пытаясь максимально точно разделить классы, но это может привести к переобучению. Напротив, при уменьшении регуляризации поверхность становится более гладкой и допускает ошибки на обучающих данных, что помогает улучшить обобщающую способность модели.

Функция ядра также играет важную роль. В случае линейного ядра разделяющая поверхность будет прямолинейной, в то время как использование нелинейных ядер, например, радиального базисного (RBF), может привести к сложным, изогнутым поверхностям, которые позволяют лучше разделять данные в случаях, когда линейное разделение невозможно. Это позволяет модели улавливать более сложные зависимости, но требует более тщательной настройки параметров ядра, таких как параметр гамма, который контролирует степень кривизны поверхности.

Размер обучающей выборки также оказывает влияние на форму разделяющей поверхности. Для малых выборок поверхность может быть нестабильной и чувствительной к шуму, что приводит к её подстраиванию под случайные флуктуации в данных. С увеличением объёма выборки модель начинает обобщать, и разделяющая поверхность становится более устойчивой и менее подверженной переобучению.

При работе с многоклассовыми задачами разделяющая поверхность может стать многомерной. В таких случаях важно правильно выбрать стратегию разделения классов, например, One-vs-All или One-vs-One. Стратегия влияет на количество и расположение разделяющих гиперплоскостей, а значит, и на окончательную форму решения.

Наконец, не стоит забывать о важности кросс-валидации для оценки влияния изменения параметров модели на поведение разделяющей поверхности. Этот процесс позволяет минимизировать влияние случайных факторов и выбрать оптимальные настройки для конкретной задачи.

Сравнение разделяющих поверхностей разных алгоритмов на одном наборе данных

Для эффективного сравнения разделяющих поверхностей различных алгоритмов машинного обучения важно использовать одинаковый набор данных, чтобы минимизировать внешние переменные. В этом контексте рассмотрим несколько популярных методов классификации: логистическую регрессию, метод опорных векторов (SVM), дерево решений и k-ближайших соседей (k-NN).

Каждый из этих алгоритмов имеет свои особенности, которые влияют на форму разделяющей поверхности. Сравним их на одном наборе данных, например, на классическом наборе данных Iris, состоящем из четырех признаков и трех классов.

- Логистическая регрессия: алгоритм формирует разделяющую поверхность в виде гиперплоскости. Он предполагает линейную зависимость между признаками, что приводит к разделению классов по прямой или гиперплоскости в многомерном пространстве. Этот метод работает эффективно при линейной separability классов, но плохо справляется с сильно перекрывающимися классами.

- Метод опорных векторов (SVM): SVM с ядром, например, линейным или RBF, может строить как линейные, так и нелинейные разделяющие поверхности. В случае сложной конфигурации данных, SVM с ядром RBF может построить более сложные кривые, эффективно разделяя классы, даже если они сильно перекрываются. Важно учитывать, что выбор параметра C и ядра значительно влияет на результат.

- Дерево решений: алгоритм строит разделяющую поверхность по принципу разбиения пространства на прямоугольные области. Каждое решение зависит от конкретных пороговых значений признаков, что делает разделение классов четким, но не всегда оптимальным. Поверхность в случае дерева решений выглядит как множество прямых и углов.

- k-ближайших соседей (k-NN): этот метод не строит явную разделяющую поверхность, а классифицирует новый экземпляр на основе большинства соседей. Визуально поверхность раздела будет выглядеть как ломанная линия, следуя за плотностью точек в пространстве признаков. Этот метод чувствителен к выбору параметра k и масштабированию данных.

Рассмотрим результаты применения этих алгоритмов к набору данных Iris:

- Для линейно разделимых данных, например, с использованием логистической регрессии или линейного SVM, результаты будут схожи, так как оба алгоритма строят линейную гиперплоскость. Визуально это будет прямая линия, разделяющая классы.

- Когда данные становятся сложнее и классы начинают перекрываться, дерево решений будет разделять данные по прямоугольным регионам, создавая не такие гладкие и визуально привлекательные разделяющие поверхности. Однако для задач с четкими порогами оно может дать хорошие результаты.

- Метод k-NN будет демонстрировать более сложную и в некоторой степени «рваную» поверхность раздела, которая адаптируется к плотности данных, но будет зависеть от выбора гиперпараметра k. Чем меньше k, тем более фрагментированной будет поверхность.

- Для сильно нелинейных данных SVM с ядром RBF может предложить наиболее адаптированное разделение, создавая изгибы и кривые для разделения классов. Однако такая поверхность будет зависеть от выбора параметров ядра и регуляризации.

Каждый алгоритм имеет свои сильные и слабые стороны. Логистическая регрессия хорошо работает для простых линейных задач, в то время как SVM и k-NN более гибки в обработке сложных, нелинейных данных. Дерево решений, хотя и не обеспечивает гладкой поверхности, эффективно разделяет данные, если классы хорошо отделимы по прямым признакам.

Рекомендуется тестировать несколько алгоритмов на одном наборе данных и оценивать не только точность, но и визуализацию разделяющей поверхности для лучшего понимания структуры данных и выбора наиболее подходящего метода для задачи.

Вопрос-ответ:

Что такое разделяющая поверхность и для чего она используется?

Разделяющая поверхность — это геометрическая поверхность, которая используется для разделения объектов на разные категории или группы, в задачах классификации. В машинном обучении она помогает разделить пространство признаков на области, соответствующие различным классам. В задачах классификации с использованием алгоритмов, таких как метод опорных векторов (SVM), разделяющая поверхность играет ключевую роль в построении модели, которая эффективно различает классы.

Какие алгоритмы используют разделяющую поверхность для классификации?

Наиболее известным и часто используемым алгоритмом для построения разделяющей поверхности является метод опорных векторов (SVM). Этот метод находит гиперплоскость, которая наилучшим образом разделяет два класса в многомерном пространстве признаков. Помимо SVM, разделяющие поверхности могут использоваться и в других алгоритмах, таких как логистическая регрессия, линейные классификаторы и нейронные сети. Однако для сложных нелинейных задач часто применяются методы с ядрами (например, гауссовые ядра) или глубокие нейронные сети.

Что такое линейная разделяющая поверхность и как она работает?

Линейная разделяющая поверхность — это гиперплоскость, которая разделяет пространство на две части, где каждая часть соответствует одному из классов. В случае двумерных данных эта поверхность представляет собой прямую, а в более высоких измерениях — гиперплоскость. Алгоритм, который используется для построения линейной разделяющей поверхности, пытается найти такую прямую или гиперплоскость, которая максимально разделяет данные, минимизируя ошибку классификации. Один из популярных алгоритмов для этого — метод опорных векторов с линейным ядром.

Как можно улучшить качество разделяющей поверхности, если данные не линейно разделимы?

Если данные не линейно разделимы, то для улучшения качества разделяющей поверхности можно использовать методы с ядрами. В таких методах пространство признаков преобразуется с помощью математических операций так, чтобы данные стали линейно разделимыми. Одним из популярных методов является использование ядра РБФ (радиально-базисной функции), которое позволяет создавать более сложные нелинейные разделяющие поверхности. В библиотеке scikit-learn для SVM можно использовать параметр kernel=’rbf’, чтобы применить это ядро. Также для улучшения классификации можно увеличить размер обучающего набора данных или использовать более сложные модели, такие как случайные леса или нейронные сети.

Что такое разделяющая поверхность и зачем она нужна в задачах машинного обучения?

Разделяющая поверхность — это математическая гиперплоскость или функция, которая разделяет объекты разных классов в пространстве признаков. В задачах машинного обучения, например, при классификации, разделяющая поверхность помогает определить, к какому классу относится новый объект, основываясь на его признаках. Важно, чтобы разделяющая поверхность максимально точно отделяла объекты разных классов, что способствует точности модели и уменьшению ошибок классификации. Это особенно важно при работе с большими объемами данных, где правильное разделение имеет решающее значение.