Современные IP-камеры с поддержкой потоковой передачи видео по RTSP или HTTP позволяют напрямую интегрировать их с Python-скриптами для задач компьютерного зрения. Используя библиотеки OpenCV, TensorFlow или Ultralytics YOLO, можно настроить систему, способную детектировать и классифицировать объекты в реальном времени без необходимости в дорогостоящем оборудовании.

Ключевым этапом является подключение к потоку с камеры с использованием функции cv2.VideoCapture(), передавая URL-адрес с логином и паролем. После этого каждый кадр обрабатывается моделью детекции объектов, предварительно обученной или дообученной под конкретную задачу – например, распознавание автомобилей, людей или животных.

Для повышения точности рекомендуется использовать модель YOLOv8 в режиме Inference на GPU. Обучение кастомной модели возможно с помощью собственных датасетов в формате YOLO, подготовленных с использованием LabelImg или Roboflow. Эффективное аннотирование и баланс классов критичны: недостаточное разнообразие данных приводит к ложным срабатываниям или пропускам.

Система может быть дополнена логикой уведомлений, записью видео при обнаружении объекта или интеграцией с другими сервисами через REST API. Это открывает возможности для применения в видеонаблюдении, учете транспорта, контроле доступа и других автоматизированных сценариях.

Выбор IP камеры с поддержкой потоковой передачи для захвата видео

Минимальное разрешение камеры должно составлять 1280×720 (HD), но для повышения точности детекции предпочтительно 1920×1080 (Full HD). Частота кадров – не менее 15 fps, оптимально – 25–30 fps. Недостаточная частота приведёт к пропуску движущихся объектов и снижению точности распознавания.

Обратите внимание на возможность отключения встроенной аналитики и наложения информации (таймкодов, логотипов), так как они могут мешать обучению. Также камера должна поддерживать настройку битрейта – это важно для контроля нагрузки на канал и минимизации потерь кадров.

Наличие поддержки ONVIF желательно, особенно если планируется работа с несколькими камерами. ONVIF упрощает получение адресов видеопотоков и автоматизацию конфигурации. Убедитесь, что камера предоставляет прямой доступ к RTSP-потоку без авторизации через web-интерфейс или приложение производителя.

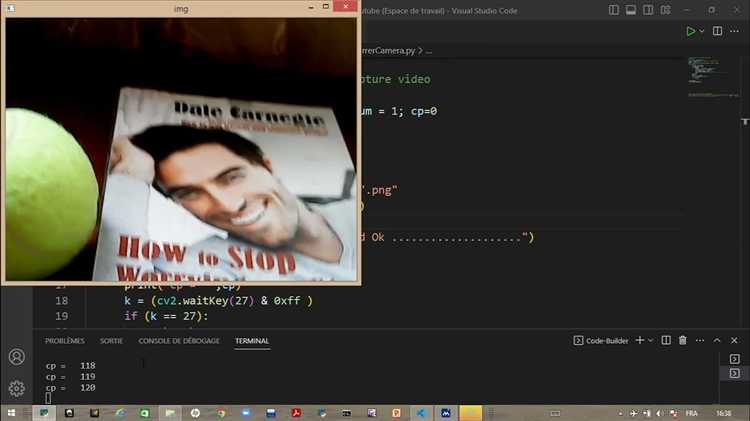

Для подключения к Python необходимо протестировать камеру на совместимость с OpenCV:

import cv2

cap = cv2.VideoCapture("rtsp://username:password@IP:554/stream")

ret, frame = cap.read()

if ret:

print("Поток получен успешно")

else:

print("Ошибка подключения")Рекомендуемые модели: Hikvision DS-2CD2043G2-I, Dahua IPC-HFW2231T-ZS-S2, Reolink RLC-810A. Они поддерживают стабильный RTSP-поток, работу в условиях слабого освещения и настройку параметров кодирования.

Подключение IP камеры к Python с использованием библиотеки OpenCV

Для подключения IP-камеры к Python требуется получить прямой поток по протоколу RTSP или HTTP. Большинство IP-камер предоставляют RTSP-URL вида: rtsp://логин:пароль@ip_адрес:порт/путь. Пример: rtsp://admin:12345@192.168.1.64:554/stream1.

Убедитесь, что камера и компьютер находятся в одной сети и порт RTSP (обычно 554) открыт. Проверьте поток через VLC-плеер, чтобы исключить ошибки на этапе соединения.

В Python необходимо установить OpenCV: pip install opencv-python. Подключение осуществляется через метод cv2.VideoCapture(), передавая в него RTSP-ссылку:

import cv2

stream_url = "rtsp://admin:12345@192.168.1.64:554/stream1"

cap = cv2.VideoCapture(stream_url)

if not cap.isOpened():

raise Exception("Не удалось подключиться к потоку. Проверьте URL и сетевое соединение.")

while True:

ret, frame = cap.read()

if not ret:

break

cv2.imshow("IP-камера", frame)

if cv2.waitKey(1) == 27: # Esc

break

cap.release()

cv2.destroyAllWindows()

Для повышения стабильности соединения используйте флаг cv2.CAP_FFMPEG, если в системе установлен FFMPEG:

cap = cv2.VideoCapture(stream_url, cv2.CAP_FFMPEG)Если камера требует авторизацию или работает с нестандартными параметрами сжатия, убедитесь, что кодек потока поддерживается вашей версией OpenCV и FFMPEG. Для H.264 и H.265 потребуется соответствующая сборка OpenCV с включённой поддержкой кодеков.

Проверяйте загрузку CPU: IP-потоки высокой чёткости (1080p и выше) могут существенно нагружать систему при декодировании. При необходимости уменьшайте разрешение прямо в настройках камеры.

Работу с несколькими камерами реализуйте через отдельные экземпляры VideoCapture или потоковые процессы, чтобы избежать потерь кадров.

Предобработка видеопотока для повышения точности распознавания

Для достижения высокой точности распознавания объектов IP-камерами необходимо проводить систематическую предобработку видеопотока. Этот этап критичен при работе с нестабильным освещением, шумами и артефактами сжатия, характерными для IP-видеонаблюдения.

- Стабилизация изображения: Применение алгоритмов компенсации дрожания (например, на базе оптического потока) снижает искажения при движении камеры. Используйте OpenCV-функции

cv2.estimateAffine2Dиcv2.warpAffine. - Приведение к единому разрешению: Все кадры приводятся к разрешению, на котором обучалась модель. Это снижает влияние масштаба объектов. Оптимальный размер – 416×416 или 640×640, в зависимости от модели (YOLOv5, SSD).

- Устранение шумов: Для камер с высоким уровнем шумов полезны фильтры Гаусса или медианный фильтр. Используйте

cv2.GaussianBlurилиcv2.medianBlurс ядром 3×3 или 5×5. - Коррекция яркости и контраста: Автоматическая коррекция, например CLAHE (

cv2.createCLAHE), повышает детализацию в затемнённых участках и защищённых от пересвета областях. - Цветовая нормализация: Приведение к цветовой модели HSV или LAB позволяет модели лучше различать объекты при изменении условий освещения. HSV предпочтительнее для детекции по оттенкам.

- Фоновая фильтрация: При статичной сцене используйте вычитание фона (MOG2:

cv2.createBackgroundSubtractorMOG2), чтобы исключить неподвижные объекты и повысить точность обработки динамичных целей. - Устранение артефактов сжатия: Применение билинейной интерполяции и лёгкой размытия компенсирует квадратизацию при сильном сжатии видеопотока (особенно H.264 на низком битрейте).

Комплексная предобработка видеопотока перед подачей в модель машинного зрения позволяет значительно сократить количество ложных срабатываний, особенно при реальной эксплуатации IP-камер в уличных условиях или при слабом освещении.

Использование предварительно обученных моделей для распознавания объектов

Для ускорения разработки систем распознавания объектов с IP-камерой на Python целесообразно использовать предварительно обученные модели, такие как YOLOv5, SSD и Faster R-CNN. Эти модели обучены на крупных датасетах, включая COCO и Pascal VOC, и обеспечивают высокую точность без необходимости обучения с нуля.

YOLOv5 – оптимальный выбор для реального времени. Поддерживает запуск на CPU и GPU, легко интегрируется с OpenCV и PyTorch. Установка:

pip install ultralyticsПример использования YOLOv5 для обработки видеопотока с IP-камеры:

from ultralytics import YOLO

import cv2

model = YOLO('yolov5s.pt')

cap = cv2.VideoCapture('rtsp://user:password@ip_address:554/stream')

while cap.isOpened():

ret, frame = cap.read()

if not ret:

break

results = model(frame)

annotated_frame = results[0].plot()

cv2.imshow('Detection', annotated_frame)

if cv2.waitKey(1) == 27:

break

cap.release()

cv2.destroyAllWindows()SSD эффективен на мобильных устройствах, поддерживается TensorFlow и OpenCV DNN. Для запуска требуется предварительная конвертация модели в формат .pb или .onnx.

Faster R-CNN подходит для задач, где приоритет – точность, а не скорость. Требует больше ресурсов и времени на обработку кадра, поэтому применим в офлайн-сценариях или при наличии производительного GPU.

Перед выбором модели учитывайте целевые требования: частота кадров, точность, аппаратные ограничения. Не адаптируйте модель без проверки на реальных данных с камеры – различия в углах обзора, освещении и разрешении влияют на итоговую производительность.

Обучение собственной модели с использованием TensorFlow или PyTorch

Для обучения модели, способной распознавать объекты с IP-камеры, необходимо выбрать один из двух фреймворков: TensorFlow или PyTorch. Оба поддерживают работу с нейронными сетями и имеют готовые решения для задач детекции объектов, таких как SSD, YOLO, Faster R-CNN. Рассмотрим основные этапы обучения модели на собственных данных.

- Сбор и аннотирование датасета: используйте IP-камеру для записи видеопотока. Преобразуйте видео в изображения с шагом 1 кадр/секунду. Для аннотаций применяйте LabelImg или CVAT. Экспорт аннотаций – в формате Pascal VOC или COCO.

- Предобработка данных: приведите изображения к одному размеру (например, 416×416 для YOLOv4), нормализуйте значения пикселей до диапазона [0,1]. Разделите датасет на обучающую и валидационную выборки в пропорции 80/20.

- Выбор модели и фреймворка:

- Для TensorFlow: используйте TensorFlow Object Detection API. Настройте конфигурационный файл с путями к аннотациям, меткам классов, числу шагов и типу модели (например, ssd_mobilenet_v2_fpnlite_320x320_coco17_tpu-8).

- Для PyTorch: используйте torchvision.models (например, FasterRCNN с backbone ResNet50). Замените последний слой на количество классов в вашем датасете.

- Тонкая настройка (fine-tuning): инициализируйте модель предобученными весами (на COCO), замораживайте начальные слои на 5–10 эпох. После этого размораживайте слои постепенно и продолжайте обучение с меньшим learning rate (например, 1e-4).

- Обучение:

- TensorFlow: используйте команду

model_main_tf2.pyс указанием пути к pipeline.config и TFRecord-файлам. - PyTorch: примените

torch.utils.data.DataLoaderдля загрузки батчей,torch.optim.Adamс scheduler для изменения learning rate, функцию потерь –GeneralizedRCNNLoss.

- TensorFlow: используйте команду

- Оценка качества: метрика – mAP@0.5. Используйте встроенные утилиты (например,

coco_evaluator.pyв PyTorch илиmodel_eval.pyв TensorFlow) для расчёта. - Экспорт модели:

- TensorFlow: выполните заморозку графа и экспорт в SavedModel.

- PyTorch: сохраните модель через

torch.save()или экспортируйте в ONNX.

Полученную модель можно интегрировать с RTSP-потоком IP-камеры, используя OpenCV и предварительно обработанные кадры для inference.

Настройка зон детекции и фильтрация по типу объектов

Для эффективного распознавания объектов с использованием IP-камеры важно точно настроить зоны детекции, чтобы ограничить область поиска и минимизировать количество ложных срабатываний. Процесс настройки зон детекции начинается с определения области интереса (ROI). Это позволяет сократить нагрузку на систему и ускорить обработку изображений.

В Python для работы с зонами детекции удобно использовать библиотеки OpenCV или специализированные фреймворки, такие как TensorFlow или PyTorch. С помощью OpenCV можно задавать прямоугольные области с помощью функции cv2.rectangle(), ограничивая пространство, в котором будет проводиться анализ. Также возможно использовать маски для более сложных форм, если требуется учитывать криволинейные или асимметричные зоны.

Фильтрация по типу объектов играет ключевую роль в повышении точности распознавания. Вместо того, чтобы отслеживать все объекты в зоне детекции, можно настроить фильтрацию, чтобы камера реагировала только на объекты определённого типа, например, людей, автомобили или животных. Для этого часто используется метод кластеризации объектов, где каждому типу объекта соответствует определённая метка или класс.

Для реализации фильтрации по типу объектов можно использовать модели глубокого обучения, такие как YOLO (You Only Look Once) или SSD (Single Shot Multibox Detector). Эти модели позволяют классифицировать объекты в реальном времени с высокой точностью. В случае с YOLO, например, при настройке камеры можно указать только те классы, которые должны быть отслеживаемы. Это делается через параметры конфигурации модели, где задаются интересующие классы, а все остальные объекты игнорируются.

Пример фильтрации по типу объекта в OpenCV с использованием предварительно обученной модели YOLO:

import cv2

# Загрузка модели YOLO

net = cv2.dnn.readNet("yolov3.weights", "yolov3.cfg")

layer_names = net.getLayerNames()

output_layers = [layer_names[i-1] for i in net.getUnconnectedOutLayers()]

# Загрузка видео с камеры

cap = cv2.VideoCapture(0)

while True:

_, frame = cap.read()

blob = cv2.dnn.blobFromImage(frame, 0.00392, (416, 416), (0, 0, 0), True, crop=False)

net.setInput(blob)

outs = net.forward(output_layers)

# Обработка детектированных объектов

for out in outs:

for detection in out:

scores = detection[5:]

class_id = np.argmax(scores)

confidence = scores[class_id]

if confidence > 0.5:

if class_id == 0: # Пример фильтрации по типу объекта (люди)

print("Объект: человек")

cap.release()

Для создания более точных фильтров можно использовать различные пороговые значения вероятности или комбинировать несколько моделей для повышения надежности распознавания.

Организация сохранения и логирования распознанных объектов

Для эффективной работы с системой распознавания объектов на IP камере важно грамотно организовать процесс сохранения данных о распознанных объектах и их логирование. Это позволяет не только анализировать результаты работы модели, но и эффективно устранять ошибки и оптимизировать систему.

Первый шаг в организации сохранения данных – это выбор подходящего формата для хранения информации. Один из оптимальных вариантов – использование формата JSON для сохранения метаданных о распознанных объектах. В каждом объекте можно указать координаты его расположения в кадре, уверенность модели в распознавании, а также временную метку.

Пример записи данных о распознанном объекте:

{

"timestamp": "2025-05-08T12:34:56",

"object": "person",

"confidence": 0.92,

"coordinates": {

"x_min": 100,

"y_min": 200,

"x_max": 150,

"y_max": 250

}

}

Для сохранения данных в реальном времени можно использовать базу данных SQLite. Этот выбор оправдан благодаря своей легкости и быстроте. Каждый объект, распознанный камерой, будет сохраняться в таблице с полями для метки времени, типа объекта, уверенности и координат. Это позволяет оперативно извлекать данные для дальнейшего анализа.

Пример кода для записи в базу данных:

import sqlite3

from datetime import datetime

def save_detection(object_type, confidence, coordinates):

conn = sqlite3.connect('detections.db')

cursor = conn.cursor()

pythonEditcursor.execute('''CREATE TABLE IF NOT EXISTS detections

(timestamp TEXT, object TEXT, confidence REAL, x_min INTEGER, y_min INTEGER, x_max INTEGER, y_max INTEGER)''')

timestamp = datetime.now().strftime('%Y-%m-%d %H:%M:%S')

cursor.execute('''INSERT INTO detections (timestamp, object, confidence, x_min, y_min, x_max, y_max)

VALUES (?, ?, ?, ?, ?, ?, ?)''',

(timestamp, object_type, confidence, *coordinates))

conn.commit()

conn.close()

Логирование распознанных объектов необходимо для мониторинга и диагностики системы. Лог-файлы должны содержать информацию о каждом событии распознавания, включая время, тип объекта, уверенность модели и, при необходимости, статус камеры. Для этого можно использовать встроенные механизмы Python, такие как модуль logging.

Пример записи логов:

import logging

logging.basicConfig(filename='detections.log', level=logging.INFO, format='%(asctime)s - %(message)s')

def log_detection(object_type, confidence):

logging.info(f"Detected {object_type} with {confidence*100}% confidence.")

С помощью логирования можно оперативно отслеживать любые сбои или низкую производительность системы, а также собирать статистику для анализа поведения модели. Важно настроить уровень логирования в зависимости от потребностей: DEBUG для подробных сообщений, INFO для стандартных записей о событиях, WARNING для предупреждений, и ERROR для ошибок.

Кроме того, полезно реализовать механизмы уведомлений, например, отправку сообщений на email или в Telegram при детектировании определённых объектов, что может быть полезно для систем безопасности или мониторинга.

Важной частью логирования является регулярное архивирование логов. Это поможет избежать переполнения диска и обеспечит доступ к старым данным для анализа трендов и выявления долгосрочных проблем.

Интеграция результатов распознавания в систему оповещений или веб-интерфейс

Для интеграции результатов распознавания объектов с системой оповещений или веб-интерфейсом важно выбрать подходящий механизм взаимодействия, который обеспечит оперативную обработку данных и их передачу конечным пользователям. Рассмотрим ключевые этапы такой интеграции.

1. Использование REST API для передачи данных

Для взаимодействия между системой распознавания и внешними сервисами можно использовать REST API. С его помощью данные о распознанных объектах, например, типы объектов, время их появления, координаты на изображении, отправляются на сервер, который затем передает информацию в виде уведомлений или отображает в веб-интерфейсе. Важно настроить сервер таким образом, чтобы он поддерживал асинхронные запросы, чтобы минимизировать задержки при обработке больших объемов данных.

2. Подключение к системе оповещений

Для быстрого оповещения пользователя о событиях, таких как появление определенных объектов в кадре, используется система уведомлений. Можно интегрировать такие решения, как Push-уведомления для мобильных устройств или email-рассылки. Для этого сервер, получив информацию о событии, отправляет данные в систему уведомлений. Использование WebSockets для постоянного соединения с сервером позволяет мгновенно отправлять уведомления, не дожидаясь нового запроса от клиента.

3. Веб-интерфейс для отображения результатов

Веб-интерфейс должен быть интуитивно понятным и удобным для пользователя. Для этого можно использовать фреймворки, такие как Flask или Django для Python. Веб-страницы должны обновляться в реальном времени, показывая результаты распознавания (например, в виде меток на видео или статичных изображениях). Использование JavaScript-библиотек, таких как Socket.io, для связи клиента и сервера обеспечит динамическое обновление интерфейса без перезагрузки страницы.

4. Хранение и анализ данных

Рекомендуется сохранять результаты распознавания в базу данных для дальнейшего анализа и отчетности. Важно продумать систему фильтрации и поиска по этим данным, чтобы, например, по запросу пользователя можно было найти все события, связанные с определенным объектом. Это также позволяет создавать аналитические отчеты и тренды, на основе которых можно улучшать алгоритмы распознавания.

5. Безопасность и защита данных

Интеграция с системой оповещений и веб-интерфейсом требует обеспечения безопасности передаваемых данных. Использование HTTPS для защиты данных, передаваемых по сети, а также аутентификация и авторизация пользователей через OAuth или JWT токены обеспечат безопасность взаимодействия между компонентами системы.

Правильная интеграция этих компонентов позволяет создать эффективную и безопасную систему для мониторинга и оповещения, основанную на распознавании объектов с использованием IP-камер.

Вопрос-ответ:

Что такое обучение IP-камеры распознаванию объектов с использованием Python?

Обучение IP-камеры распознаванию объектов на Python — это процесс, в котором используется библиотека Python для обработки изображений с камеры и обучения модели машинного обучения на основе изображений с метками. Это позволяет камере распознавать объекты в реальном времени или анализировать видео, поступающее через сеть. Такие задачи могут включать распознавание лиц, автомобилей, животных или любых других объектов, в зависимости от того, для какой цели используется система.

Какие библиотеки Python чаще всего используются для распознавания объектов на IP-камерах?

Для распознавания объектов на IP-камерах в Python наиболее популярными являются библиотеки OpenCV и TensorFlow. OpenCV помогает в обработке изображений и видео, а также в применении различных фильтров. TensorFlow используется для обучения нейронных сетей, которые могут распознавать объекты в изображениях. Также часто используется библиотека Keras, которая служит для упрощения работы с TensorFlow, и другие специализированные библиотеки, такие как YOLO или Faster R-CNN, которые предлагают готовые решения для детекции объектов.

Какие шаги необходимы для обучения IP-камеры распознаванию объектов?

Обучение IP-камеры распознаванию объектов обычно включает несколько этапов. Сначала необходимо подготовить датасет — коллекцию изображений с метками, которые обозначают объекты, подлежащие распознаванию. Затем выбирается подходящая модель машинного обучения, которая будет обучаться на этих данных. После этого модель тестируется и дорабатывается с целью улучшить точность распознавания. На финальном этапе камера подключается к обученной модели для реального времени анализа и распознавания объектов.

Нужно ли собирать собственный датасет для обучения камеры распознаванию объектов?

Собирать собственный датасет можно, но это не всегда обязательно. Для многих задач существуют уже готовые публичные датасеты, например, для распознавания лиц или автомобилей. Эти датасеты могут быть использованы для обучения модели без необходимости собирать данные вручную. Однако, если ваша задача требует специфичных объектов, которые не включены в общедоступные датасеты, тогда придется создавать свой собственный набор данных, включая фото с нужными метками.

Какие сложности могут возникнуть при использовании IP-камеры для распознавания объектов?

Основной сложностью при использовании IP-камеры для распознавания объектов является качество изображения. Камеры могут не обеспечивать достаточную четкость для точного распознавания, особенно в условиях плохого освещения или при низком разрешении. Также могут возникать проблемы с производительностью — обработка изображений в реальном времени требует высокой вычислительной мощности. Еще одна проблема — это возможность появления ложных срабатываний, когда система ошибочно распознает объекты или не распознает их вообще. Для решения этих проблем необходимо тщательно настроить модель и провести множество тестов.