Парсер – ключевая часть компилятора, который преобразует исходный код в структуру данных, удобную для дальнейшей обработки. В этой статье мы рассмотрим, как на JavaScript создать простой парсер, который будет анализировать текст программы, представленный в виде исходного кода, и преобразовывать его в абстрактное синтаксическое дерево (AST). Этот процесс можно разбить на несколько этапов: лексический анализ, синтаксический анализ и построение AST.

Первым шагом является лексический анализ, который включает в себя разбиение исходного кода на токены. Токенами могут быть ключевые слова, идентификаторы, операторы, числовые значения и другие элементы языка. Для этого можно использовать регулярные выражения, которые будут соответствовать каждой категории токенов. Важно правильно определить границы токенов и учитывать возможные ошибки в исходном коде, такие как лишние пробелы или незакрытые кавычки.

После того как лексический анализ завершён, на очереди синтаксический анализ. На этом этапе нужно проверить, соответствует ли последовательность токенов правилам грамматики языка. Обычно для этого используется метод синтаксического анализа, такой как метод рекурсивного спуска или таблицы переходов. Важно, чтобы синтаксический анализ был не только точным, но и эффективным, особенно при работе с большими объёмами кода.

Наконец, результат работы парсера – это абстрактное синтаксическое дерево (AST). Оно представляет собой структуру данных, которая отражает синтаксическую структуру программы. Каждое узловое значение в AST соответствует какой-либо операции или элементу языка. AST служит основой для дальнейшей обработки кода, например, для оптимизации или генерации машинного кода.

Таким образом, создание парсера для компилятора на JavaScript требует внимательного подхода на каждом этапе, от лексического и синтаксического анализа до построения AST. Каждый этап имеет свои особенности, которые важно учесть для достижения точности и эффективности парсинга.

Выбор подходящей библиотеки для парсинга синтаксиса

Esprima – одна из самых распространенных библиотек. Это легковесный и быстрый парсер для ECMAScript. Он поддерживает синтаксис ES6 и выше. Esprima идеален для задач, где требуется быстрота и надежность при анализе кода JavaScript. Библиотека предоставляет подробное дерево синтаксического анализа (AST), что удобно для дальнейших манипуляций с кодом. Однако она не всегда идеально подходит для сложных кастомных грамматик.

Acorn – еще одна популярная библиотека. Она имеет меньший размер по сравнению с Esprima и является очень быстрой. Acorn поддерживает синтаксис ES6 и ESNext, включая функции типа async/await и dynamic import. Одним из ее преимуществ является возможность легко расширять функциональность через плагины, что делает её удобным выбором для специфичных нужд. Однако для некоторых нестандартных конструкций Acorn может потребоваться дополнительных настроек.

PEG.js отличается от вышеупомянутых библиотек тем, что основана на принципах PEG (Parsing Expression Grammar). Это позволяет создавать парсеры для произвольных языков с высокой гибкостью. PEG.js подойдет, если задача состоит в разработке парсера для специфического языка, который выходит за рамки JavaScript. Но важно помнить, что создание грамматик и отладка могут быть более сложными по сравнению с традиционными парсерами.

Babel Parser является частью экосистемы Babel и отлично подходит для работы с современным JavaScript. Он активно используется для трансформации кода с использованием новых фич ES6 и более поздних версий. Babel Parser поддерживает широкий спектр синтаксических особенностей и является лучшим выбором для проектов, которые тесно связаны с Babel и требуют поддержки последних изменений в языке.

Для того чтобы выбрать подходящую библиотеку, важно учитывать несколько факторов: совместимость с нужной версией JavaScript, производительность, поддержка расширений и возможность работы с кастомными грамматиками. Также важно учитывать наличие документации и активности сообщества, что облегчает решение проблем в процессе разработки.

Создание лексического анализатора (лексера) на JavaScript

Основная задача лексера – разделить строку исходного кода на части, которые будут восприниматься как элементы языка. Например, если код состоит из чисел, идентификаторов, операторов, строковых литералов, лексер должен точно различать их и помечать соответствующими токенами. Каждый токен имеет тип, который определяет, как он будет обработан на следующих этапах компиляции.

Для начала нужно определить регулярные выражения для каждого типа токенов. Например, можно определить следующие типы токенов:

- Числа: /^\d+/

- Идентификаторы: /^[a-zA-Z_][a-zA-Z0-9_]*/

- Операторы: /^[+\-*/=<>!]+/

- Скобки: /^[(){}[\]]/

- Комментарии: /^\/\/.*|\/\*[\s\S]*?\*\//

Каждое регулярное выражение будет захватывать определённый тип символов, которые затем будут конвертированы в соответствующие токены.

Чтобы лексер мог эффективно обрабатывать входной код, создаём функцию, которая будет поочередно проверять строку на наличие токенов. Например, функцию tokenize, которая будет итеративно искать совпадения для каждого из регулярных выражений:

function tokenize(input) {

const tokens = [];

const patterns = [

{ type: 'NUMBER', regex: /^\d+/ },

{ type: 'IDENTIFIER', regex: /^[a-zA-Z_][a-zA-Z0-9_]*/ },

{ type: 'OPERATOR', regex: /^[+\-*/=<>!]+/ },

{ type: 'PAREN', regex: /^[(){}[\]]/ },

type: 'COMMENT', regex: /^\/\/.*

];

let position = 0;

while (position < input.length) {

let matched = false;

for (const pattern of patterns) {

const match = input.slice(position).match(pattern.regex);

if (match) {

tokens.push({ type: pattern.type, value: match[0] });

position += match[0].length;

matched = true;

break;

}

}

if (!matched) {

throw new Error(`Unexpected character: ${input[position]}`);

}

}

return tokens;

}

В данной функции мы проверяем строку на совпадение с каждым из регулярных выражений. Если совпадение найдено, токен добавляется в массив tokens, а позиция в строке сдвигается на длину найденного совпадения. Если ни одно из регулярных выражений не совпало с текущим символом, выбрасывается ошибка.

После того как лексер преобразует строку в токены, можно передать эти токены синтаксическому анализатору для дальнейшей обработки. Важно, чтобы лексер точно и быстро распознавал все типы токенов, поскольку это основа для корректной работы всего компилятора.

При разработке лексера также важно учитывать оптимизацию. В случае с большими исходными кодами важно, чтобы лексер работал с минимальными затратами времени и ресурсов, избегая излишних повторных вычислений. Можно внедрить кеширование или использовать более сложные структуры данных для обработки токенов, чтобы повысить производительность на больших объемах данных.

Определение грамматики языка программирования для парсера

Грамматика языка программирования определяет правила синтаксиса, которые парсер использует для преобразования исходного кода в структуру данных, пригодную для дальнейшей обработки. Важно четко понимать, как грамматика соотносится с конкретным языком и его особенностями.

Основные элементы грамматики включают:

- Токены – минимальные единицы языка, такие как ключевые слова, операторы, идентификаторы, литералы.

- Правила синтаксиса – описания, как составляются валидные конструкции языка, например, операторы, выражения и блоки кода.

- Нетерминальные символы – абстракции, которые могут быть раскрыты через другие правила.

- Терминальные символы – конкретные символы или последовательности, которые непосредственно встречаются в исходном коде.

Для создания парсера на JavaScript необходимо выбрать подходящий формат представления грамматики. Наиболее распространены два варианта:

- БНФ (Бакус-Наура форма) – декларативное описание синтаксиса через набор правил. Пример:

expression ::= term "+" term. - EBNF (Расширенная БНФ) – более компактный и гибкий формат, добавляющий возможность использования опциональных элементов, повторений и альтернатив.

После выбора формата, важно учитывать следующие аспекты:

- Четкость и непротиворечивость – грамматика должна быть логически последовательной, без амфиболий и неопределенностей. Это обеспечит точность работы парсера.

- Реализация рекурсии – многие языки используют рекурсивные конструкции, такие как выражения с операторами. Важно правильно обрабатывать рекурсивные правила в грамматике, чтобы избежать переполнения стека.

- Обработка пробелов и комментариев – нужно точно определить, как парсер будет игнорировать незначительные элементы, такие как пробелы и комментарии, чтобы не мешать разбору.

- Типы данных – грамматика должна ясно определять, как различные типы данных (числа, строки, булевы значения и т. д.) представлены в языке.

Пример грамматики для простого арифметического выражения:

expression ::= term "+" expression | term

term ::= factor "*" term | factor

factor ::= "(" expression ")" | number

number ::= [0-9]+

На основе этой грамматики парсер может разобрать выражения вроде "3 + 5 * (2 + 8)", соблюдая приоритет операций.

Чтобы грамматика была максимально понятной для парсера, рекомендуется:

- Использовать минимально необходимое количество нетерминальных символов.

- Четко разграничивать операторы и выражения.

- Обеспечивать четкие и простые правила для каждой конструкции языка.

Как только грамматика определена, можно перейти к реализации самого парсера, который будет использовать эти правила для построения синтаксического дерева и дальнейшей обработки кода.

Реализация синтаксического анализа с использованием рекурсивного спуска

Основное преимущество этого подхода заключается в его простоте и понятности. Рекурсивный спуск не требует сложных структур данных и может быть реализован с помощью стандартных конструкций языка JavaScript, таких как функции и условные операторы.

Пример простого рекурсивного спуска для грамматики арифметических выражений:

function parseExpression() {

let result = parseTerm();

while (currentToken === '+' || currentToken === '-') {

let operator = currentToken;

consume(); // Потребляем текущий токен

let term = parseTerm();

result = { type: 'BinaryExpression', operator: operator, left: result, right: term };

}

return result;

}

function parseTerm() {

let result = parseFactor();

while (currentToken === '*' || currentToken === '/') {

let operator = currentToken;

consume();

let factor = parseFactor();

result = { type: 'BinaryExpression', operator: operator, left: result, right: factor };

}

return result;

}

function parseFactor() {

if (currentToken === '(') {

consume();

let expr = parseExpression();

if (currentToken === ')') {

consume();

return expr;

}

throw new Error('Expected closing parenthesis');

} else if (isNumber(currentToken)) {

let value = currentToken;

consume();

return { type: 'Literal', value: value };

}

throw new Error('Unexpected token: ' + currentToken);

}

В примере выше функции parseExpression, parseTerm и parseFactor являются рекурсивными. Каждая функция разбирает часть выражения, соответствующую определённому правилу грамматики. Основной алгоритм заключается в последовательной обработке токенов в соответствии с их приоритетом и структурой выражения.

Важно отметить, что при реализации рекурсивного спуска для реальных языков программирования, могут возникать проблемы с рекурсией, особенно в случае глубоких вложенных конструкций. Поэтому для предотвращения ошибок переполнения стека важно ограничить количество вложенных вызовов или использовать итеративные подходы для некоторых аспектов синтаксического анализа.

Рекурсивный спуск хорошо работает с грамматиками, которые можно представить в виде дерева вызовов. Однако, для более сложных грамматик, таких как те, которые включают левую рекурсию, этот метод не подходит без дополнительной обработки или трансформации грамматики.

Для эффективного применения рекурсивного спуска необходимо грамотно управлять состоянием текущего токена. Например, функция consume обновляет токен, что позволяет синтаксическому анализатору двигаться по входным данным и корректно обрабатывать их.

Обработка ошибок в процессе парсинга

При разработке парсера для компилятора важно правильно обрабатывать ошибки, чтобы обеспечить точность и стабильность работы. Ошибки могут возникать на различных этапах парсинга, начиная от синтаксических до логических, и каждая из них требует отдельного подхода.

Для начала важно учитывать, что на этапе лексического анализа ошибки чаще всего связаны с неправильными или неожиданными символами в потоке входных данных. В таких случаях парсер должен сгенерировать подробное сообщение об ошибке, которое укажет на строку и позицию в коде, где произошел сбой. Такие ошибки легко отлавливаются с помощью регулярных выражений или лексеров, которые могут сразу указывать на некорректные символы.

Синтаксические ошибки чаще всего возникают, когда структура входных данных не соответствует ожидаемой грамматике. Например, отсутствие закрывающей скобки или неправильно расположенные операторы могут привести к сбоям на этом уровне. Чтобы обработать такие ошибки, следует внедрить механизм обратной связи, который сообщает точное место ошибки и предлагает возможные исправления. Для этого можно использовать механизм "ошибок восстановления" (error recovery), который позволяет парсеру продолжить работу даже после обнаружения ошибки, пропуская её и пытаясь парсить оставшуюся часть кода.

Если ошибка возникает в процессе анализа синтаксического дерева, важно использовать контекст для диагностики проблемы. Например, парсер может хранить стек вызовов, чтобы точно определить, какой узел дерева вызвал сбой. Важно, чтобы сообщение об ошибке не только указывало на проблему, но и объясняло, что именно не так с данным участком кода, чтобы разработчик мог быстро устранить её.

Для сложных языков программирования полезно внедрить механизм предсказаний на основе анализа контекста. Этот подход позволяет парсеру прогнозировать возможные синтаксические ошибки на ранних стадиях, снижая вероятность возникновения ошибок в последующих этапах обработки.

Еще одним важным аспектом является логирование ошибок. Парсер должен записывать не только факт ошибки, но и подробности, которые помогут в дальнейшем анализе. Это может включать как подробные сообщения об ошибках, так и статистику о частоте их возникновения в различных частях программы.

Наконец, важно учитывать, что парсер должен быть устойчивым к ошибкам, но не терять точности. Идеальная система обработки ошибок сочетает в себе информативность, точность и минимальное вмешательство в процесс анализа, позволяя разработчику эффективно исправлять ошибки без перегрузки информации.

Преобразование исходного кода в абстрактное синтаксическое дерево (AST)

Первым шагом является лексический анализ (лексер), который делит исходный код на токены. Каждый токен представляет собой минимальную единицу синтаксиса, например, ключевое слово, переменную или операнд. Лексер помогает упрощать анализ и синтаксический разбор, выполняя первоначальную обработку текста.

Следующим этапом идет синтаксический анализ (парсер). Парсер использует грамматику языка программирования для построения структуры AST. Он проверяет правильность расположения токенов, соблюдение правил синтаксиса и генерирует дерево, где каждый узел соответствует синтаксическому элементу программы. Например, выражение `a + b * c` будет преобразовано в AST, где один узел будет представлять операцию сложения, а другие – умножения и операнды.

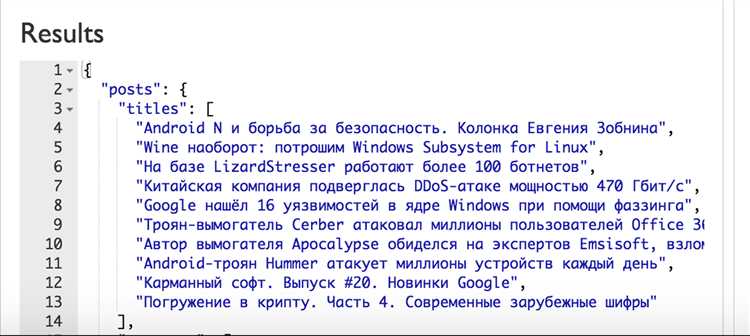

Для создания AST в JavaScript можно использовать библиотеки, такие как Babel или Esprima, которые предоставляют готовые парсеры для различных версий ECMAScript. Эти инструменты позволяют интегрировать процесс парсинга в проекты с минимальными усилиями. Babel, например, может не только генерировать AST, но и преобразовывать его обратно в код через свои плагины.

После получения AST дерево можно анализировать для выполнения различных задач, таких как оптимизация, статический анализ или трансформация кода. Например, можно найти все случаи использования определенной переменной или проверить, правильно ли используется синтаксис конструкции. Также AST позволяет выполнять такие операции, как упрощение выражений, переименование переменных и удаление неиспользуемого кода.

Для работы с AST важно правильно настроить парсер в зависимости от типа анализируемого кода. Например, если проект использует синтаксис ES6 или новее, стоит настроить Babel с нужными пресетами, чтобы гарантировать корректную работу с более новыми языковыми конструкциями. Также необходимо учитывать особенности стандартов JavaScript, поскольку синтаксис может изменяться в зависимости от версии ECMAScript.

Таким образом, процесс преобразования исходного кода в абстрактное синтаксическое дерево – это ключевая часть парсинга, который позволяет понять структуру программы и выполнить дальнейшую обработку кода для различных целей.

Оптимизация парсера для работы с большими объемами данных

При работе с большими объемами данных парсер должен быть максимально эффективным, чтобы избежать затяжных операций и потерь производительности. Рассмотрим несколько подходов, которые помогут улучшить работу парсера на JavaScript.

- Использование потоков данных (streaming): Вместо того чтобы загружать все данные в память сразу, можно обрабатывать их по частям, что значительно снижает потребление памяти. В JavaScript это можно реализовать через потоки, например, с использованием API

ReadableStreamдля асинхронной обработки данных по мере их поступления. - Алгоритм ранней остановки: Если парсер может завершить свою работу после нахождения определенной информации (например, после ошибки или нахождения нужного фрагмента), стоит внедрить механизм ранней остановки. Это позволит избежать ненужных вычислений.

- Предварительная обработка данных: Часто данные имеют повторяющиеся или лишние элементы. Удаление этих элементов до начала парсинга поможет сократить объем данных и ускорить обработку. Например, можно использовать регулярные выражения для удаления ненужных пробелов или комментариев.

- Лексический анализ с использованием буфера: Применение буферизации для хранения части данных, которые еще не были проанализированы, позволяет уменьшить количество обращений к памяти. Это особенно полезно при обработке строковых данных, таких как код или текст.

- Использование бинарных деревьев для структуры данных: Когда данные могут быть представлены в виде дерева (например, при обработке выражений или синтаксических деревьев), использование сбалансированных бинарных деревьев позволяет значительно ускорить операции поиска и вставки.

- Асимптотическая сложность: Понимание и улучшение асимптотической сложности парсера критично при работе с большими объемами данных. Алгоритмы с линейной или логарифмической сложностью (например, алгоритм ЛЛ(1) для парсинга) будут работать значительно быстрее, чем алгоритмы с квадратичной или кубической сложностью.

- Многозадачность и параллельные вычисления: Если обработка данных независима и может быть разделена на несколько частей, можно использовать многозадачность или Web Workers для параллельной обработки данных. Это позволит значительно ускорить парсинг больших объемов данных на многопроцессорных системах.

- Память и кеширование: Хранение промежуточных результатов в кеше позволяет избежать повторных вычислений и ускоряет обработку. Также стоит следить за тем, чтобы парсер не занимал слишком много памяти, используя слабые ссылки и устраняя неиспользуемые объекты.

Оптимизация парсера для работы с большими объемами данных требует тщательного подхода к выбору алгоритмов и архитектуры. Применение вышеуказанных методов значительно улучшит скорость и эффективность работы парсера в условиях реальных задач.

Интеграция парсера в систему компиляции

Парсер должен быть встроен в цепочку обработки исходного кода сразу после этапа лексического анализа. На вход он получает поток токенов, возвращаемый лексером, и возвращает абстрактное синтаксическое дерево (AST), которое затем передаётся в семантический анализ или генератор кода.

В JavaScript парсер удобно реализовать как модуль с функцией parse(tokens: Token[]): AST. Важно обеспечить строгую валидацию входных данных: при получении некорректного токена модуль должен выбрасывать исключение с координатами и типом ошибки.

Встроив парсер в компилятор, обеспечьте его изоляцию от остальной логики через интерфейс. Например, компилятор может использовать контракт:

interface Parser {

parse(tokens: Token[]): AST;

}

Это упрощает замену или тестирование парсера. Используйте строгую типизацию (TypeScript), чтобы избежать конфликтов между структурами AST и их обработчиками.

Для эффективной интеграции добавьте логирование этапов разбора в режиме отладки. Это поможет анализировать конфликты грамматики и находить узкие места. Пример:

if (debug) {

console.log("Parsing function declaration at line", token.line);

}

Не привязывайте парсер к файловой системе. Он должен работать с токенами, а не с файлами. Разделите чтение кода, лексический анализ и парсинг по модулям.

Для связи парсера с последующими фазами компиляции, используйте структуру AST как единую точку передачи. Пример вызова:

const tokens = tokenize(sourceCode);

const ast = parser.parse(tokens);

semanticAnalyzer.analyze(ast);

codeGenerator.generate(ast);

Не храните состояние между вызовами parse(), чтобы избежать побочных эффектов и обеспечить детерминированность.