Задача поиска повторяющихся элементов в массиве – это частая проблема при обработке данных в Python. Несмотря на то, что задача может казаться простой, существуют различные методы для её решения в зависимости от условий задачи и объёма данных. Чтобы эффективно находить дубликаты, важно выбрать оптимальное решение, которое подходит для конкретной ситуации.

Использование коллекций Python – это один из наиболее удобных и быстрых способов. Модуль collections предоставляет структуру данных Counter, которая позволяет не только подсчитать количество вхождений каждого элемента, но и легко выявить повторяющиеся значения. Например, достаточно пройти по массиву и создать счётчик, который сразу укажет на те элементы, что появляются более одного раза.

Другой подход – это использование множества для поиска дубликатов. Множества в Python не допускают повторяющихся элементов, и благодаря этому мы можем за один проход по массиву идентифицировать все дубликаты. Однако этот метод подходит для относительно небольших массивов, поскольку каждый элемент нужно будет проверять на присутствие в множестве, что может быть менее эффективно в случае с большими объёмами данных.

Если нужно найти все повторяющиеся элементы в массиве с минимальными затратами памяти, стоит обратить внимание на алгоритм сортировки массива. После сортировки идентификация дубликатов сводится к простому сравнению соседних элементов. Этот метод имеет свою специфику, так как требует предварительной сортировки, что может замедлить выполнение при больших объёмах данных.

Использование структуры данных set для поиска дубликатов

Для поиска дубликатов в массиве Python можно эффективно использовать структуру данных set, которая автоматически исключает повторяющиеся элементы. Это позволяет минимизировать время выполнения операции, особенно при работе с большими данными.

Принцип работы set заключается в хранении уникальных элементов. Если попытаться добавить в множество уже существующий элемент, он не будет добавлен повторно. Это свойство можно использовать для нахождения дубликатов в массиве.

Процесс поиска дубликатов можно разделить на несколько шагов:

- Инициализация множества: Создайте пустое множество для хранения элементов, которые уже встречались в массиве.

- Итерация по массиву: Пройдитесь по всем элементам массива.

- Проверка на наличие дубликата: Для каждого элемента массива проверьте, есть ли он в множестве. Если да, значит это дубликат.

- Добавление уникальных элементов: Если элемент уникален, добавьте его в множество.

Пример кода:

def find_duplicates(arr):

seen = set()

duplicates = set()

for item in arr:

if item in seen:

duplicates.add(item)

else:

seen.add(item)

return list(duplicates)

Этот код возвращает список дубликатов, найденных в массиве. Множество seen отслеживает уникальные элементы, а множество duplicates собирает те, что встречаются более одного раза.

Преимущества использования set:

- Операции проверки и добавления в set выполняются за O(1): Это делает процесс поиска дубликатов значительно быстрее по сравнению с традиционными методами, например, с использованием списков.

- Простота реализации: Алгоритм с использованием set легко понять и внедрить.

- Минимизация памяти: Множество не хранит дублирующиеся элементы, что снижает потребление памяти при обработке данных.

Если порядок элементов в массиве важен, можно использовать вспомогательные структуры, такие как OrderedDict, но в большинстве случаев set подходит для эффективного поиска дубликатов.

Как найти повторяющиеся элементы с помощью словаря

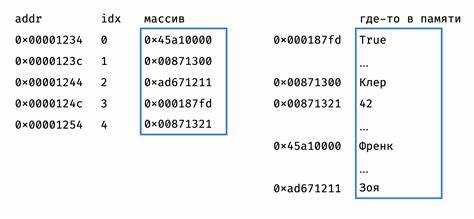

Использование словаря для поиска повторяющихся элементов в массиве – один из самых эффективных способов. Словарь позволяет отслеживать количество вхождений каждого элемента в массив, что делает его идеальным инструментом для решения этой задачи.

Для начала, создаём пустой словарь, где ключами будут элементы массива, а значениями – количество их повторений. Проходим по массиву, проверяя, встречался ли элемент ранее. Если да, увеличиваем значение соответствующего ключа на 1, если нет – добавляем элемент в словарь с начальным значением 1.

Когда массив обработан, достаточно пройти по словарю и выбрать те элементы, чьи значения больше 1 – это и будут повторяющиеся элементы.

Пример кода:

def find_duplicates(arr):

freq = {}

duplicates = []

for item in arr:

if item in freq:

freq[item] += 1

else:

freq[item] = 1

for item, count in freq.items():

if count > 1:

duplicates.append(item)

return duplicates

arr = [1, 2, 3, 2, 4, 5, 1]

print(find_duplicates(arr)) # Выведет: [1, 2]

Этот метод позволяет за один проход по массиву (O(n)) собрать информацию о частоте элементов, а затем за второй проход (O(k), где k – количество уникальных элементов) найти все повторяющиеся элементы. Время выполнения данного подхода значительно ниже, чем у других методов, например, сортировки.

Если требуется найти все повторяющиеся элементы, метод с использованием словаря будет предпочтительнее из-за его линейной сложности и простоты реализации.

Применение метода count() для подсчета элементов

Метод count() в Python позволяет подсчитать количество вхождений определенного элемента в список. Этот метод эффективен при поиске повторяющихся элементов в массиве. Например, если необходимо выяснить, сколько раз в списке встречается конкретное значение, count() становится простым и понятным инструментом.

Синтаксис метода следующий: list.count(x), где x – элемент, для которого требуется подсчитать количество вхождений в список list.

Пример использования:

my_list = [1, 2, 2, 3, 4, 2, 5]

count_2 = my_list.count(2)

print(count_2) # Результат: 3Этот код возвращает количество вхождений числа 2 в список. Метод не изменяет сам список и не выполняет дополнительных операций, что делает его быстрым и удобным для работы с небольшими и средними массивами данных.

Ограничения метода:

Для больших массивов или списков с большим количеством повторяющихся элементов count() может быть неэффективным, так как его сложность составляет O(n), где n – количество элементов в списке. Каждый вызов метода требует полного обхода массива.

Если необходимо подсчитать все повторяющиеся элементы в списке, можно использовать метод count() в сочетании с циклом или функциями высшего порядка. Например, используя словарь или модуль collections.Counter, можно добиться лучшей производительности при анализе больших объемов данных.

Совет: Если задача состоит в подсчете повторяющихся элементов, и порядок элементов не имеет значения, стоит рассмотреть использование collections.Counter, который сразу создает частотный словарь для всех элементов в списке.

Использование библиотеки collections для нахождения дубликатов

Библиотека collections в Python предоставляет несколько инструментов для работы с данными, один из которых – Counter. Этот класс идеально подходит для нахождения повторяющихся элементов в массиве.

Основной принцип работы Counter – подсчет частоты встречаемости каждого элемента в iterable (например, в списке). Результатом является словарь, где ключами являются элементы, а значениями – их количество в массиве.

Пример использования:

from collections import Counter

data = [1, 2, 3, 4, 2, 3, 3, 5]

counter = Counter(data)

print(counter)

Counter({3: 3, 2: 2, 1: 1, 4: 1, 5: 1})

Чтобы найти элементы, которые повторяются, можно фильтровать результат Counter по количеству. Например, для поиска всех элементов, которые встречаются больше одного раза:

duplicates = [item for item, count in counter.items() if count > 1]

print(duplicates)

[2, 3]

Использование Counter позволяет эффективно и быстро находить дубликаты, даже в больших наборах данных, благодаря оптимизированной реализации этого класса. В случае больших массивов такая реализация значительно быстрее, чем ручной обход списка и подсчет встречаемости элементов.

При необходимости, можно отсортировать элементы по количеству их встречаемости. Например, чтобы получить элементы с наибольшим количеством повторений, можно использовать метод most_common():

most_common_elements = counter.most_common()

print(most_common_elements)

[(3, 3), (2, 2), (1, 1), (4, 1), (5, 1)]

Это даст вам список кортежей, где первый элемент – это сам объект, а второй – количество его повторений. Вы можете использовать это для более сложной аналитики данных.

Таким образом, collections.Counter является мощным инструментом для поиска дубликатов в массиве и позволяет легко обрабатывать даже большие объемы данных.

Как найти дубликаты с помощью list comprehension

Для поиска повторяющихся элементов в массиве с использованием list comprehension, можно воспользоваться техниками, которые эффективно обрабатывают массивы и используют минимум ресурсов. В отличие от обычных циклов, list comprehension позволяет написать решение в одну строку, что повышает читаемость кода.

Чтобы найти дубликаты, необходимо пройтись по списку и отфильтровать элементы, которые встречаются более одного раза. Для этого можно использовать вспомогательную структуру данных, например, множество, чтобы отслеживать элементы, которые уже встречались.

Пример кода:

arr = [1, 2, 3, 4, 2, 3, 5, 6, 1]

duplicates = [x for x in arr if arr.count(x) > 1 and arr.index(x) == arr.index(x)]

print(set(duplicates))Этот код использует метод count() для подсчета вхождений каждого элемента в список. Однако, чтобы избежать многократного добавления одинаковых элементов в результат, добавляется условие arr.index(x) == arr.index(x), которое исключает уже учтенные дубликаты.

Другой вариант решения – использовать словарь для подсчета частоты появления элементов, а затем фильтровать элементы с частотой больше единицы. Это решение будет более эффективным с точки зрения времени выполнения, особенно для больших массивов:

arr = [1, 2, 3, 4, 2, 3, 5, 6, 1]

frequency = {x: arr.count(x) for x in arr}

duplicates = [x for x, count in frequency.items() if count > 1]

print(set(duplicates))Этот метод работает быстрее, так как вместо многократных вызовов count() для каждого элемента, создается словарь с подсчетом всех вхождений заранее.

Использование алгоритма сортировки для поиска повторяющихся элементов

Сортировка позволяет упростить обнаружение повторов, поскольку одинаковые элементы после неё располагаются рядом. Это устраняет необходимость вложенных циклов и уменьшает количество сравнений.

Для начала массив сортируется с помощью метода sorted() или list.sort(). Затем выполняется линейный проход по отсортированному массиву. Если текущий элемент совпадает с предыдущим, он считается повторяющимся.

Пример:

arr = [4, 2, 7, 2, 5, 4, 9]

arr.sort()

duplicates = []

for i in range(1, len(arr)):

if arr[i] == arr[i - 1] and (not duplicates or arr[i] != duplicates[-1]):

duplicates.append(arr[i])

print(duplicates)Результат: [2, 4]

Метод работает за O(n log n) за счёт сортировки. Это допустимо, если не требуется сохранять порядок элементов и если не нужно обрабатывать огромные объёмы данных, где сортировка может уступать по скорости использованию хеш-структур.

При необходимости можно использовать другие алгоритмы сортировки (например, heap sort или merge sort), если есть ограничения на использование памяти или требования к стабильности сортировки.

Как обрабатывать большие массивы с дубликатами с минимальной памятью

Для обработки больших массивов с дубликатами при ограничениях по памяти следует избегать хранения всех данных в оперативной памяти. Оптимальное решение – однопроходная обработка с использованием генераторов и структур данных с ограниченным объёмом.

Если данные поступают из файла или потока, используйте итераторы:

def read_in_chunks(file_path):

with open(file_path) as f:

for line in f:

yield line.strip()Для поиска повторяющихся элементов без сохранения всего массива используйте структуру collections.Counter с ограничением по глубине счёта или хеш-таблицу с квотированием:

from collections import defaultdict

def find_duplicates(stream):

seen = set()

duplicates = set()

for item in stream:

if item in seen:

duplicates.add(item)

else:

seen.add(item)

return duplicatesПри обработке числовых массивов объёмом в миллионы элементов, хранение всех значений в set может быть нецелесообразным. В этом случае используется алгоритм Флойд-Ривеста, алгоритм Тортойза и Хаара (для чисел с повторяющимися значениями в ограниченном диапазоне) или фильтры Блума – структуры с вероятностной природой:

from bloom_filter import BloomFilter

def detect_duplicates(stream, capacity=10**6, error_rate=0.01):

bloom = BloomFilter(max_elements=capacity, error_rate=error_rate)

for item in stream:

if item in bloom:

yield item

else:

bloom.add(item)Фильтр Блума даёт ложноположительные срабатывания, но не пропускает дубликаты. Это полезно при предварительной фильтрации или когда важна скорость и экономия памяти.

Если массив отсортирован, можно обойтись без вспомогательных структур:

def duplicates_in_sorted_array(arr):

prev = None

for item in arr:

if item == prev:

yield item

prev = itemХраните только необходимые промежуточные данные. Используйте генераторы и ленивую обработку. Не используйте list без необходимости. Чтение и запись можно объединять по блокам фиксированного размера:

def block_read(stream, block_size=1024):

block = []

for item in stream:

block.append(item)

if len(block) == block_size:

yield block

block.clear()

if block:

yield blockМинимизация использования памяти достигается комбинацией ленивой обработки, использования вероятностных структур и избеганием избыточного хранения промежуточных данных. Выбор конкретного подхода зависит от структуры данных, допустимого уровня потерь и характера дубликатов.