После того как вы освоили основы Python, возникает вопрос: куда двигаться дальше? Следующий этап обучения должен зависеть от ваших целей, будь то углубление в разработку приложений, аналитика данных или работа с искусственным интеллектом. Рассмотрим несколько направлений, которые помогут вам расширить навыки и повысить свою востребованность на рынке труда.

1. Алгоритмы и структуры данных

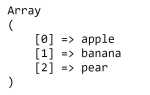

Чтобы стать по-настоящему сильным разработчиком, необходимо углубиться в теоретическую часть программирования. Изучение алгоритмов и структур данных позволит не только улучшить производительность вашего кода, но и глубже понять, как работают различные процессы в компьютере. Начните с простых структур, таких как массивы, стек, очередь, и постепенно переходите к более сложным, например, деревья, графы, хеш-таблицы. Обучение алгоритмам поиска и сортировки будет полезно для написания эффективных решений в реальных проектах.

2. Математика для программистов

Для разработки в области машинного обучения и работы с большими данными важны математические основы. Изучение линейной алгебры, теории вероятностей и статистики значительно улучшит ваше понимание работы с алгоритмами, моделями и прогнозированием. Эти знания являются основой для построения моделей машинного обучения и анализа данных, что востребовано в таких областях как Data Science и AI.

3. Веб-разработка

Для создания полноценных веб-приложений Python можно комбинировать с фреймворками, такими как Flask или Django. Эти инструменты предоставляют готовую структуру для создания серверной логики и взаимодействия с базами данных. Знания HTML, CSS и JavaScript в связке с Python помогут вам стать полноценным Full Stack разработчиком, что открывает широкие перспективы для карьеры.

4. Машинное обучение и искусственный интеллект

Python – один из ведущих языков в сфере машинного обучения и искусственного интеллекта, и после базового освоения языка стоит углубиться в библиотеки, такие как TensorFlow, Keras, Scikit-learn, которые облегчают работу с моделями. Выбор в пользу машинного обучения откроет доступ к высоким технологиям и обеспечит конкурентоспособность на рынке.

Таким образом, путь после Python может быть разнообразным в зависимости от вашего интереса. Выбирайте направление, которое будет не только востребовано, но и интересно для вашего профессионального роста.

Изучение работы с базами данных: SQL и NoSQL

После освоения Python важно понять, как эффективно взаимодействовать с базами данных. Важно различать два основных подхода: SQL и NoSQL, каждый из которых подходит для разных задач.

SQL (Structured Query Language) – это язык, используемый для работы с реляционными базами данных. Основные системы управления базами данных (СУБД), такие как PostgreSQL, MySQL, SQLite и MS SQL Server, используют SQL для создания, изменения и запроса данных. Знание SQL позволяет создавать нормализованные схемы данных, работать с транзакциями и эффективно решать задачи с большими объемами структурированной информации.

Для начала рекомендуется освоить основные операторы SQL: SELECT, INSERT, UPDATE, DELETE, а также разобраться в более сложных концепциях, таких как JOIN, индексы, транзакции, агрегатные функции и подзапросы. Для работы с базами данных через Python можно использовать библиотеки, такие как SQLAlchemy или Psycopg2, которые упрощают взаимодействие с СУБД.

NoSQL базы данных, такие как MongoDB, Redis, Cassandra и CouchDB, не используют фиксированную схему данных, что позволяет работать с более гибкими и масштабируемыми структурами. NoSQL подходит для обработки неструктурированных данных, таких как JSON или XML, а также для высоконагруженных приложений, где требуется высокая доступность и масштабируемость.

Если работа с реляционными данными для вас очевидна, изучение NoSQL будет полезным шагом, особенно для разработки веб-приложений, анализа больших данных или систем с высокими требованиями к скорости обработки запросов. В MongoDB, например, можно научиться работать с коллекциями и документами, а в Redis – с кэшированием и очередями сообщений.

Рекомендуется начать с основ NoSQL, таких как хранение данных в JSON-формате, использование репликации и шардирования для обеспечения отказоустойчивости и масштабируемости. Важно понимать, как различаются модели данных в SQL и NoSQL и когда лучше использовать каждый из подходов.

Изучение баз данных SQL и NoSQL позволяет значительно расширить кругозор и повысить квалификацию разработчика, а также дает возможность выбирать наилучшее решение для конкретной задачи.

Продвинутые темы Python: асинхронное программирование и многозадачность

Основой асинхронного программирования в Python является модуль asyncio, который обеспечивает эффективное управление задачами с асинхронным выполнением. Главная идея заключается в использовании событийного цикла, который позволяет выполнять несколько задач «параллельно» на одном потоке. Это не полноценная многозадачность, как в многопоточности, а скорее конкурентное выполнение с использованием одной нити, что снижает накладные расходы на управление потоками.

Для работы с асинхронным кодом в Python используются ключевые слова async и await. async обозначает асинхронную функцию, а await используется для ожидания выполнения другой асинхронной операции, не блокируя поток. Пример простого асинхронного кода:

import asyncio

async def fetch_data():

print("Начало получения данных")

await asyncio.sleep(2)

print("Данные получены")

async def main():

await asyncio.gather(fetch_data(), fetch_data())

asyncio.run(main())

Этот пример иллюстрирует, как можно запустить несколько асинхронных задач параллельно, ожидая их выполнения без блокировки программы.

Если ваша цель – эффективно использовать многозадачность для обработки вычислений, стоит обратить внимание на многопроцессорность, использующую модуль multiprocessing. Он позволяет использовать несколько процессов, каждый из которых работает в своем собственном интерпретаторе Python, обходя ограничения GIL. Пример использования многопроцессорности:

from multiprocessing import Pool

def square(x):

return x * x

if __name__ == "__main__":

with Pool(4) as pool:

result = pool.map(square, range(10))

print(result)

Кроме того, важно изучить возможности использования очередей и синхронизации между потоками и процессами с помощью queue и threading.Lock. Эти инструменты полезны, когда нужно обмениваться данными между потоками или процессами, предотвращая при этом возможные гонки данных.

Асинхронное программирование и многозадачность в Python открывают возможности для создания высокопроизводительных приложений, но для эффективного использования этих технологий важно правильно понимать их особенности и ограничения. Совмещение асинхронности и многозадачности в рамках одного проекта может значительно повысить его масштабируемость и производительность.

Алгоритмы и структуры данных для оптимизации программ

Для разработки эффективных и масштабируемых программ необходимо понимать, как алгоритмы и структуры данных влияют на производительность. Оптимизация часто сводится к выбору правильных структур данных и алгоритмов в зависимости от задачи, что позволяет существенно улучшить время работы и память приложения.

Алгоритмы сортировки являются основой многих задач. Для небольших объемов данных можно использовать алгоритм пузырьковой сортировки, но для крупных наборов данных предпочтительнее использовать более эффективные алгоритмы, такие как быстрая сортировка (QuickSort) или сортировка слиянием (MergeSort). Эти алгоритмы имеют сложность O(n log n), что значительно быстрее по сравнению с O(n²) для пузырьковой сортировки.

Поиск и хеширование играют ключевую роль в оптимизации. Использование хеш-таблиц для хранения данных позволяет получить доступ к элементу за время O(1) в случае идеального хеширования. Это значительно быстрее, чем линейный поиск в списке (O(n)). Структуры данных, такие как деревья поиска (например, красно-черные деревья), могут обеспечить балансировку данных и позволяют выполнять операции поиска, вставки и удаления за O(log n).

Графы – это важная структура для решения задач маршрутизации, планирования и многих других. Для поиска кратчайшего пути в графе оптимально использовать алгоритм Дейкстры или алгоритм Флойда-Уоршелла, в зависимости от ситуации. Алгоритм Дейкстры имеет сложность O(V²) для несложных графов, но при использовании очереди с приоритетом можно снизить сложность до O((V + E) log V).

Динамическое программирование помогает решать задачи оптимизации, разбивая их на подзадачи. Это эффективно для таких задач, как нахождение наибольшей общей подпоследовательности, задачи о рюкзаке и многие другие. Использование динамического программирования позволяет уменьшить экспоненциальную сложность задач до полиномиальной.

Для эффективного использования памяти следует учитывать такие структуры данных, как стек, очередь, двусвязный список и массивы. Каждая из этих структур имеет свои особенности, например, стек хорош для обработки рекурсивных задач, в то время как очередь лучше подходит для моделирования процессов с очередностью выполнения.

Заключение: Выбор подходящих алгоритмов и структур данных – это не просто теоретическая задача, а ключевая часть процесса разработки. Правильный выбор зависит от типа задачи, объема данных и требований к производительности. Развитие этих навыков существенно повысит эффективность программ и оптимизирует их работу.

Разработка веб-приложений с использованием фреймворков Django и Flask

После освоения Python логичным шагом будет изучение фреймворков для веб-разработки. Django и Flask – два популярных инструмента для создания веб-приложений, каждый из которых имеет свои особенности и области применения.

Django – это мощный, полнофункциональный фреймворк, предоставляющий готовые решения для большинства задач, связанных с веб-разработкой. Он включает систему маршрутизации, ORM для работы с базами данных, встроенную админ-панель и поддержку аутентификации пользователей. Это идеальный выбор для крупных проектов, где важна скорость разработки и надежность. С помощью Django можно быстро создать API, блоги, социальные сети или интернет-магазины, поскольку фреймворк уже включает многие компоненты, которые в Flask нужно будет настраивать вручную.

Flask – это минималистичный фреймворк, предоставляющий большую гибкость и контроль за проектом. Он не навязывает архитектуру, и разработчик сам решает, какие компоненты ему подключить. Flask хорош для малых и средних проектов, а также для тех случаев, когда необходимо создать кастомизированное решение. Flask позволит использовать сторонние библиотеки для реализации определённых функций, таких как аутентификация, работа с базами данных и другие. Также он удобен для разработки RESTful API.

При выборе между Django и Flask следует учитывать размер и сложность проекта. Для сложных, многослойных веб-приложений с готовыми компонентами лучше подойдет Django, так как он позволяет быстро настроить все необходимые части проекта. Flask будет полезен для небольших стартапов или когда требуется полная свобода в реализации архитектуры. Важно также помнить, что обе платформы активно поддерживаются и имеют большое сообщество разработчиков, что облегчает поиск решений при возникновении проблем.

Обе технологии активно используются в промышленности, и знание обеих увеличит возможности для карьерного роста. Сначала можно изучить Django для понимания основ разработки сложных веб-приложений, а затем перейти к Flask для углубленного изучения тонкостей архитектуры и работы с API.

Машинное обучение: как начать с библиотеками TensorFlow и scikit-learn

TensorFlow – это библиотека, ориентированная на глубокое обучение, поддерживающая нейронные сети и сложные модели. В то время как scikit-learn подходит для более классических алгоритмов машинного обучения, таких как регрессия, классификация и кластеризация.

TensorFlow: Начало работы

TensorFlow идеально подходит для задач, связанных с глубоким обучением и нейронными сетями. Чтобы начать с TensorFlow:

- Установите TensorFlow: Используйте команду

pip install tensorflow. - Основы TensorFlow: Начните с понимания его структуры. TensorFlow работает с графами вычислений, которые могут быть выполнены на различных устройствах, включая GPU. Ознакомьтесь с объектами

tf.Tensorиtf.Variable. - Создание модели: Начните с простой нейронной сети, используя API

tf.keras, которое позволяет легко строить слои, функции активации и компиляцию модели. - Обучение модели: После создания модели обучайте её с помощью метода

fit(), подавая тренировочные данные и определяя параметры обучения, такие как скорость обучения.

Для более сложных проектов изучите оптимизацию, регуляризацию и работу с большими данными с помощью TensorFlow Datasets.

scikit-learn: Основы машинного обучения

scikit-learn – это библиотека для решения стандартных задач машинного обучения. С её помощью можно реализовать такие алгоритмы, как линейная регрессия, деревья решений, случайный лес и кластеризация.

- Установите scikit-learn: Используйте команду

pip install scikit-learn. - Подготовка данных: Начните с подготовки данных. Используйте

sklearn.model_selection.train_test_splitдля разделения данных на обучающую и тестовую выборки. - Выбор модели: Выберите модель для задачи. Например, для классификации можно использовать

sklearn.ensemble.RandomForestClassifierили для регрессииsklearn.linear_model.LinearRegression. - Обучение модели: Обучите модель с помощью метода

fit()и оцените её точность на тестовых данных черезscore()или другие метрики, такие какaccuracy_score.

scikit-learn также предоставляет возможность настройки гиперпараметров моделей с помощью GridSearchCV, что позволит вам найти оптимальные значения для различных параметров.

Параллельное использование TensorFlow и scikit-learn

В некоторых случаях TensorFlow и scikit-learn можно использовать вместе. Например, для предобработки данных можно применить функции из scikit-learn (например, нормализация или выделение признаков), а для построения сложных нейронных сетей – использовать TensorFlow. Важно понимать, что scikit-learn подходит для стандартных алгоритмов машинного обучения, а TensorFlow – для сложных задач, где требуются нейронные сети и обработка больших данных.

Рекомендации по обучению

- Часто начинайте с простых примеров и постепенно переходите к более сложным моделям.

- Регулярно используйте документацию, так как она полноценно описывает функции и параметры каждой библиотеки.

- Используйте открытые датасеты, такие как из Kaggle, для практики.

- Обратите внимание на параметры моделей и на то, как они влияют на результаты, используя методы кросс-валидации.

Машинное обучение – это область, в которой нужно много экспериментировать и анализировать результаты. TensorFlow и scikit-learn – это инструменты, которые помогут вам работать с реальными данными и решать разнообразные задачи, от прогнозирования до кластеризации.

Контейнеризация и оркестрация: Docker и Kubernetes для разработчиков Python

Docker позволяет изолировать приложение в контейнере, что упрощает настройку и деплой на разных системах. С Docker можно создать точную копию окружения, в котором приложение будет работать, исключив конфликты зависимостей. Для Python это особенно важно, так как часто бывает сложно гарантировать совместимость версий библиотек и интерпретатора между различными окружениями. Для начала работы с Docker достаточно создать Dockerfile, в котором прописываются все необходимые зависимости и настройки для Python-приложения. В качестве примера, базовый Dockerfile для Flask-приложения может выглядеть так:

FROM python:3.9-slim WORKDIR /app COPY requirements.txt . RUN pip install -r requirements.txt COPY . . CMD ["python", "app.py"]

В этом примере используется официальный образ Python, устанавливаются все зависимости из файла requirements.txt и копируются исходные файлы. После этого приложение можно запустить в контейнере командой `docker run`.

Однако, с ростом сложности проектов возникает потребность в автоматизации управления контейнерами. Именно здесь в игру вступает Kubernetes. Kubernetes позволяет не только управлять контейнерами, но и масштабировать их, обеспечивать высокую доступность и автоматическое восстановление при сбоях. Для разработчика Python это означает возможность легко развернуть микросервисное приложение, состоящее из множества сервисов, каждый из которых работает в своем контейнере. Например, для простого приложения с несколькими компонентами (база данных, API-сервис, веб-сервис) Kubernetes поможет обеспечить их правильную координацию и управление состоянием.

Настройка Kubernetes требует знания таких сущностей, как поды, деплойменты, сервисы и конфиги. Каждый компонент приложения можно развернуть в отдельном поде, который является минимальной единицей развертывания в Kubernetes. Например, для API-сервиса на Python можно создать деплоймент, который будет управлять количеством реплик и автоматически восстанавливать поды при сбоях. Конфигурация для деплоймента может выглядеть так:

apiVersion: apps/v1 kind: Deployment metadata: name: python-api spec: replicas: 3 selector: matchLabels: app: python-api template: metadata: labels: app: python-api spec: containers: - name: python-api image: my-python-api:latest ports: - containerPort: 5000

В этом примере создается деплоймент с тремя репликами API-сервиса, который будет автоматически масштабироваться в зависимости от нагрузки и восстанавливаться в случае сбоя одного из контейнеров.

Для полноценного взаимодействия между сервисами можно использовать Kubernetes Service, который обеспечивает стабильный доступ к сервисам внутри кластера. Это позволяет, например, внутреннему сервису базы данных быть доступным только для API-сервисов, но не для внешнего мира.

Использование Docker и Kubernetes в связке дает возможность автоматизировать весь процесс разработки, тестирования и продакшн-деплоя. Разработчики Python, освоив эти инструменты, могут значительно повысить производительность и надежность своих приложений. Знание этих технологий является не только конкурентным преимуществом, но и необходимым шагом в сторону современных стандартов разработки и эксплуатации программного обеспечения.

Вопрос-ответ:

Что можно изучать после Python, чтобы улучшить свои навыки в программировании?

После освоения Python, стоит обратить внимание на изучение других языков программирования, таких как JavaScript для веб-разработки, C++ для работы с системами или Java для создания корпоративных приложений. Кроме того, полезно изучить основы работы с базами данных, например, с SQL, а также познакомиться с фреймворками для Python, такими как Django или Flask, которые помогут разрабатывать более сложные проекты. На этом этапе полезно также узнать о тестировании программного обеспечения и принципах объектно-ориентированного программирования.

Какие технологии стоит изучать после Python, чтобы работать в области машинного обучения?

Если вам интересен машинный интеллект, после Python стоит изучить библиотеки и фреймворки, такие как TensorFlow, Keras, PyTorch и Scikit-learn. Эти инструменты позволят вам создавать нейронные сети и работать с данными. Также важно изучить основы работы с большими данными и технологии, такие как Hadoop и Spark, которые используются для обработки больших объемов информации. Не забудьте про алгоритмы и теорию машинного обучения, включая обучение с учителем, без учителя и обучение с подкреплением, что позволит углубить ваши знания и навыки в этой области.

Какой следующий шаг после Python для изучения веб-разработки?

Для расширения знаний в веб-разработке после изучения Python полезно освоить JavaScript, так как это основной язык для создания динамических веб-страниц. Изучив JavaScript, можно переходить к популярным библиотекам, таким как React, Vue.js или Angular. На серверной стороне можно углубиться в работу с фреймворками для Python, например, Django или Flask, которые облегчают создание веб-приложений. Также будет полезно изучить основы работы с REST API, а также освоить основы DevOps, чтобы понимать процессы деплоя и автоматизации веб-приложений.

Что стоит изучить после Python для работы в области данных и аналитики?

Если вы хотите развиваться в области аналитики данных, после Python важно изучить работу с большими объемами данных и облачными платформами, такими как AWS, Google Cloud или Azure. Также стоит освоить библиотеки Python для работы с данными, например, Pandas, NumPy и Matplotlib, а также инструменты для визуализации, такие как Power BI или Tableau. Знания статистики и теории вероятностей тоже будут полезны, чтобы эффективно анализировать данные и строить модели прогнозирования. Не забудьте про работу с SQL для извлечения и обработки данных из баз данных.