Работа с текстовыми файлами в Python часто требует правильной интерпретации их кодировки. Неверная кодировка может привести к искажению данных или ошибкам при чтении. Один из ключевых вопросов, с которым сталкиваются разработчики, – это как правильно определить кодировку файла. В Python существует несколько подходов, которые позволяют сделать это эффективно, без необходимости вручную пробовать каждую возможную кодировку.

Основной инструмент для определения кодировки – это библиотека chardet. Этот модуль реализует алгоритм, который позволяет с высокой вероятностью определить кодировку файла на основе анализа его содержимого. Чтобы использовать chardet, достаточно установить его через pip install chardet, а затем использовать функцию chardet.detect() для получения предположений о кодировке.

Однако стоит учитывать, что автоматические инструменты не всегда могут точно определить кодировку, особенно если файл содержит мало текста или используется редкая кодировка. В таких случаях полезно сочетать несколько методов, таких как анализ первых байтов файла или попытка открыть файл с различными кодировками, что может быть полезно в случае нестандартных форматов.

Кроме того, если необходимо обрабатывать большие объемы данных, стоит учитывать производительность выбранных методов. Например, при использовании библиотеки chardet важно понимать, что она может занимать дополнительные ресурсы для анализа содержимого файла, особенно если он имеет большой размер. Поэтому для больших файлов стоит использовать более легковесные подходы, такие как пробный режим с open() и проверка ошибок.

Использование библиотеки chardet для определения кодировки

Библиотека chardet предоставляет удобный способ для определения кодировки текста в файле. Она использует алгоритмы статистического анализа, чтобы с высокой вероятностью угадать кодировку. Этот инструмент особенно полезен, когда работаем с текстовыми данными, источники которых могут использовать различные кодировки.

Для начала нужно установить библиотеку с помощью pip:

pip install chardetПосле установки можно использовать chardet для определения кодировки файла. Рассмотрим основные шаги.

- Импортирование библиотеки: Для работы с

chardetдостаточно импортировать саму библиотеку и функциюdetect. - Чтение файла: Для корректной работы библиотеки важно правильно открыть файл. Лучше читать файл в бинарном режиме, так как

chardetне работает с текстовыми данными напрямую. - Определение кодировки: После того как данные прочитаны, можно передать их в функцию

chardet.detect(), которая возвращает словарь с результатами анализа. - Интерпретация результата: Функция

detectвозвращает словарь с ключами:- encoding – предполагаемая кодировка.

- confidence – степень уверенности в правильности определения кодировки (от 0 до 1).

- language – предполагаемый язык текста (если возможно определить).

{'encoding': 'utf-8', 'confidence': 0.99, 'language': 'English'}

import chardetwith open('file.txt', 'rb') as f:

data = f.read()result = chardet.detect(data)

print(result)Рекомендуется использовать значение confidence для фильтрации ненадежных результатов. Например, если уверенность менее 0.5, возможно, имеет смысл попробовать другую кодировку или выполнить дополнительные шаги для проверки.

Особенности использования chardet:

- Алгоритм не всегда гарантирует 100% точность, особенно для коротких или сильно искаженных файлов.

- Библиотека подходит для работы с текстовыми данными, но может не справляться с бинарными файлами, которые не содержат текстовой информации.

- Для работы с большими файлами следует быть осторожным, так как чтение всего файла в память может быть неэффективным. Можно читать файл частями.

Как применить встроенный модуль codecs для чтения файлов с неизвестной кодировкой

Модуль codecs в Python предоставляет удобные средства для работы с текстовыми файлами, включая чтение файлов с неизвестной кодировкой. Для этого достаточно использовать функцию codecs.open(), которая автоматически обрабатывает кодировку файла и позволяет безопасно работать с данными.

Основная цель – корректно определить кодировку файла и прочитать его содержимое без ошибок. Модуль codecs полезен в случаях, когда кодировка файла не известна заранее или она может варьироваться. Один из эффективных способов – указание кодировки через параметр encoding при открытии файла.

Пример открытия файла с неизвестной кодировкой:

import codecs

# Открытие файла с попыткой автоопределения кодировки

with codecs.open('file.txt', 'r', encoding='utf-8', errors='ignore') as f:

content = f.read()

Параметр encoding можно настроить в зависимости от предполагаемой кодировки, но если точная кодировка неизвестна, стоит указать 'utf-8' как наиболее распространённую. Параметр errors с значением 'ignore' позволяет игнорировать символы, которые не удаётся корректно интерпретировать, предотвращая возникновение исключений.

Если файл содержит данные в разных кодировках, то можно попробовать несколько вариантов кодировок в цикле:

encodings = ['utf-8', 'latin-1', 'windows-1251']

for enc in encodings:

try:

with codecs.open('file.txt', 'r', encoding=enc) as f:

content = f.read()

print(f"Файл открыт с кодировкой: {enc}")

break

except UnicodeDecodeError:

print(f"Не удалось открыть файл с кодировкой: {enc}")

Этот подход помогает автоматически попытаться открыть файл с несколькими кодировками и выбрать подходящую, если одна из них не сработала.

Кроме того, важно помнить, что при работе с кодировками всегда существует риск потери данных или их искажения. Поэтому, если файл содержит важную информацию, следует удостовериться, что выбрана правильная кодировка. В случае сомнений всегда можно обратиться к экспертам, которые смогут предложить более точные рекомендации для вашего конкретного случая.

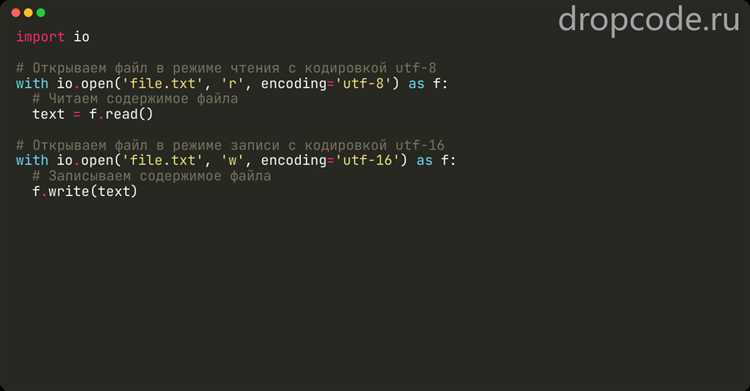

Работа с открытием файлов в Python через аргумент encoding

При работе с файлами в Python важно правильно указать кодировку при их открытии, особенно если файл содержит текст, который может использовать символы, отличные от стандартной ASCII. Аргумент encoding в функции open() позволяет явно указать кодировку, что предотвращает проблемы с неправильным отображением символов.

Когда кодировка не указана, Python по умолчанию использует кодировку системы (обычно это UTF-8 на современных платформах). Однако при работе с файлами в других кодировках (например, Windows-1251 для русского текста) указание кодировки становится необходимым. Для этого можно передать в аргумент encoding строку с именем нужной кодировки, например, encoding='utf-8' или encoding='windows-1251'.

Не всегда кодировка файла очевидна. Для автоматического определения кодировки можно использовать сторонние библиотеки, такие как chardet, которая анализирует байты файла и предполагает наиболее подходящую кодировку. Однако на практике важно заранее знать кодировку, чтобы избежать ошибок.

Пример открытия файла с указанием кодировки:

with open('example.txt', 'r', encoding='utf-8') as file:

content = file.read()

Если при чтении файла возникла ошибка, такая как UnicodeDecodeError, это может означать, что выбранная кодировка не соответствует фактической кодировке файла. В таких случаях можно попробовать другие кодировки или использовать методы для обработки ошибок, такие как errors='ignore' или errors='replace', чтобы пропускать или заменять некорректные символы.

Если нужно записать текст в файл с определенной кодировкой, также следует использовать аргумент encoding в методе open(). Это гарантирует, что данные будут сохранены в нужной кодировке, и предотвратит проблемы с открытием файлов в будущем.

Пример записи текста в файл с указанием кодировки:

with open('output.txt', 'w', encoding='utf-8') as file:

file.write('Текст в кодировке UTF-8')

Выбор правильной кодировки играет важную роль в корректной работе с файлами, особенно при их обмене между различными операционными системами и приложениями, использующими разные стандарты кодировок.

Как проверить кодировку с помощью метода `str.encode()` и `bytes.decode()`

Методы `str.encode()` и `bytes.decode()` в Python позволяют манипулировать строками и байтами, что важно при работе с кодировками. Эти методы могут помочь проверить, корректно ли работает кодировка при преобразовании данных.

Метод `str.encode()` используется для преобразования строки в байты с указанной кодировкой. Например, если строка не может быть закодирована в выбранной кодировке, будет поднято исключение `UnicodeEncodeError`. Этот метод позволяет проверить, поддерживает ли выбранная кодировка все символы строки. Пример:

text = "Привет"

encoded_text = text.encode('utf-8')Здесь строка "Привет" успешно кодируется в UTF-8. Если бы кодировка была некорректной или не поддерживала какие-либо символы, Python сообщил бы о ошибке.

Метод `bytes.decode()` выполняет обратную операцию: преобразует байты в строку. При этом важно, чтобы байты соответствовали выбранной кодировке. Если байты не могут быть корректно декодированы в строку, будет поднято исключение `UnicodeDecodeError`. Это позволяет проверить, корректно ли байты интерпретируются в конкретной кодировке:

byte_data = b'\xd0\x9f\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82'

decoded_text = byte_data.decode('utf-8')В этом примере байты успешно декодируются в строку "Привет". Если попытаться использовать неправильную кодировку, например 'latin1', будет вызвана ошибка.

Проверка кодировки с помощью этих методов полезна для диагностики ошибок в обработке текста, особенно при работе с файлы или сетевыми данными, где точная кодировка имеет значение для корректного отображения информации.

Обработка ошибок при неудачной попытке определить кодировку файла

При чтении файла с неизвестной кодировкой могут возникать исключения, особенно если файл открыт с неправильной кодировкой. Чтобы избежать сбоев, обрабатывайте ошибки с использованием конструкции try-except и дополнительных проверок.

Рекомендации по безопасной обработке:

- Используйте модуль

chardetилиcharset-normalizerдля предварительного анализа содержимого. - Проверяйте вероятность результата, если используете

chardet.detect():

import chardet

with open("файл", "rb") as f:

raw_data = f.read()

result = chardet.detect(raw_data)

if result["confidence"] < 0.8:

raise ValueError("Низкая уверенность в определении кодировки")

encoding = result["encoding"]

- Открывайте файл в блоке

tryи учитывайтеUnicodeDecodeError:

try:

with open("файл", encoding=encoding) as f:

data = f.read()

except UnicodeDecodeError:

print("Ошибка декодирования. Попробуйте другую кодировку, например 'windows-1251' или 'utf-8-sig'.")

except Exception as e:

print(f"Непредвиденная ошибка: {e}")

Сравнение популярных инструментов для определения кодировки в Python

Для точного определения кодировки текстовых файлов в Python чаще всего используют библиотеки chardet, charset-normalizer, cchardet и uchardet. Каждая из них обладает различной скоростью, точностью и совместимостью.

| Библиотека | Преимущества | Недостатки |

|---|---|---|

chardet |

Хорошо документирована, широко используется, совместима с Python 2 и 3 | Медленная на больших файлах, иногда ошибается с кириллицей |

charset-normalizer |

Активно развивается, выше точность на кириллических текстах, полностью на Python | Низкая производительность на больших объёмах данных |

cchardet |

Значительно быстрее chardet благодаря C++ реализации |

Устарела, больше не поддерживается, несовместима с последними версиями Python |

uchardet |

Надёжная работа с азиатскими кодировками, быстрый анализ | Нестабильные результаты на русскоязычных файлах, ограниченная документация |

Для анализа небольших текстов с преимущественно латиницей подойдёт chardet. При работе с кириллицей предпочтительнее использовать charset-normalizer, особенно в современных проектах. Если приоритет – скорость, можно попробовать cchardet, но стоит учитывать отсутствие поддержки. uchardet имеет смысл использовать при работе с многоязычными азиатскими наборами символов, но требует дополнительного тестирования под конкретные данные.

Практические советы по выбору кодировки для чтения и записи файлов

Если файл создан в среде Windows и предназначен для чтения в русскоязычной системе, скорее всего используется кодировка cp1251. Для корректного чтения указывайте encoding='cp1251' в функции open(). Игнорирование этого может привести к ошибкам UnicodeDecodeError.

Для файлов, полученных из Unix-систем, чаще используется utf-8. При работе с кроссплатформенными данными используйте utf-8 по умолчанию – она универсальна, поддерживает все символы Unicode и снижает риск искажения текста.

Если данные содержат BOM (Byte Order Mark), применяйте utf-8-sig – это позволит сохранить совместимость с программами, которые требуют BOM, например, Microsoft Excel. При записи файла с BOM: open('file.txt', 'w', encoding='utf-8-sig').

Для чтения неизвестной кодировки избегайте угадываний. Используйте библиотеку chardet или charset-normalizer для автоматического определения. Например:

from chardet import detect

with open('file.txt', 'rb') as f:

raw = f.read()

encoding = detect(raw)['encoding']

with open('file.txt', 'r', encoding=encoding) as f:

content = f.read()

Избегайте кодировок latin-1 и ascii при записи файлов, содержащих символы вне английского алфавита. Они не выдают ошибок, но искажают текст без предупреждений.

Для работы с XML и HTML файлами читайте заголовки или теги <meta charset>, чтобы использовать кодировку, указанную в документе. Несовпадение может привести к поломке структуры документа при сохранении.

При создании новых текстовых файлов всегда указывайте кодировку явно. Это делает код предсказуемым и устойчивым к ошибкам при переносе между системами. Рекомендуемый вариант – open(..., encoding='utf-8').

Вопрос-ответ:

Почему нельзя просто открыть файл с кодировкой UTF-8, если не уверен в его содержимом?

Если файл имеет другую кодировку (например, Windows-1251 или ISO-8859-1), попытка открыть его как UTF-8 может привести к ошибке `UnicodeDecodeError`. Это особенно актуально для текстов на языках с нелатинской письменностью, где байтовые представления символов в разных кодировках значительно отличаются. Поэтому перед чтением файла безопаснее сначала определить кодировку автоматически и только потом открывать его с нужной кодировкой.

Как повлияет короткий или однотипный текст в файле на точность определения кодировки?

Если файл содержит только латинские буквы, цифры или символы ASCII, определить его кодировку становится затруднительно. Многие кодировки интерпретируют такие данные одинаково, поэтому автоматические библиотеки вроде `chardet` или `charset-normalizer` могут сделать неверное предположение. Для повышения точности желательно использовать файлы с достаточным количеством текста и разнообразными символами.

Можно ли определить кодировку файла по его метаданным или расширению?

В большинстве случаев — нет. Метаданные текстовых файлов обычно не содержат информацию о кодировке. Расширение файла (например, `.txt`, `.csv`) также не даёт никакой гарантии, так как один и тот же тип файла может использовать разные кодировки. Единственным исключением могут быть форматы, в которых предусмотрено указание кодировки (например, XML или HTML-файлы с соответствующими тегами), но даже в таких случаях лучше не полагаться исключительно на эти данные.