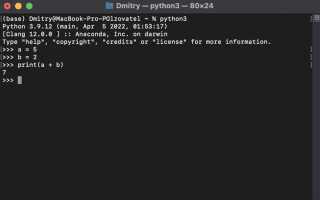

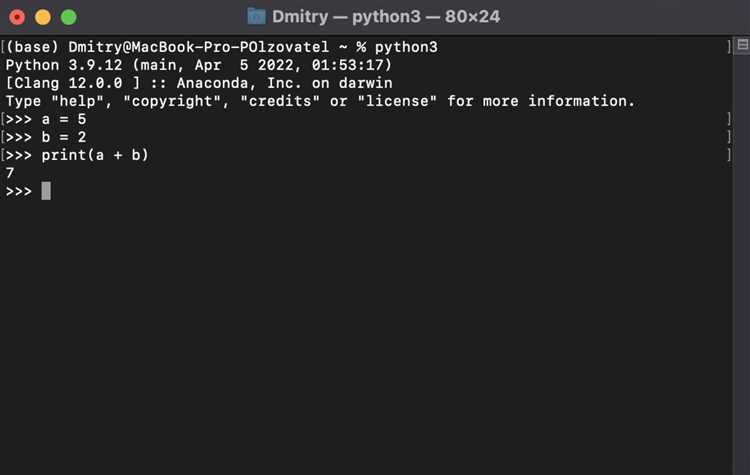

В Python предусмотрено несколько подходов к загрузке данных, различающихся по скорости, удобству и поддержке форматов. Прямое чтение с помощью встроенной функции open() подходит для простых текстовых файлов, таких как .txt или .csv без заголовков. Пример: with open(«data.txt») as f: lines = f.readlines(). Этот способ минимален по накладным расходам, но требует ручной обработки строк и преобразования типов.

Модуль csv предоставляет интерфейс для построчного чтения файлов с разделителями. Он удобен, если требуется высокая совместимость с различными CSV-реализациями. Например, csv.DictReader позволяет сразу работать со словарями, что упрощает доступ к столбцам по именам. Однако при больших объёмах данных он проигрывает по производительности специализированным библиотекам.

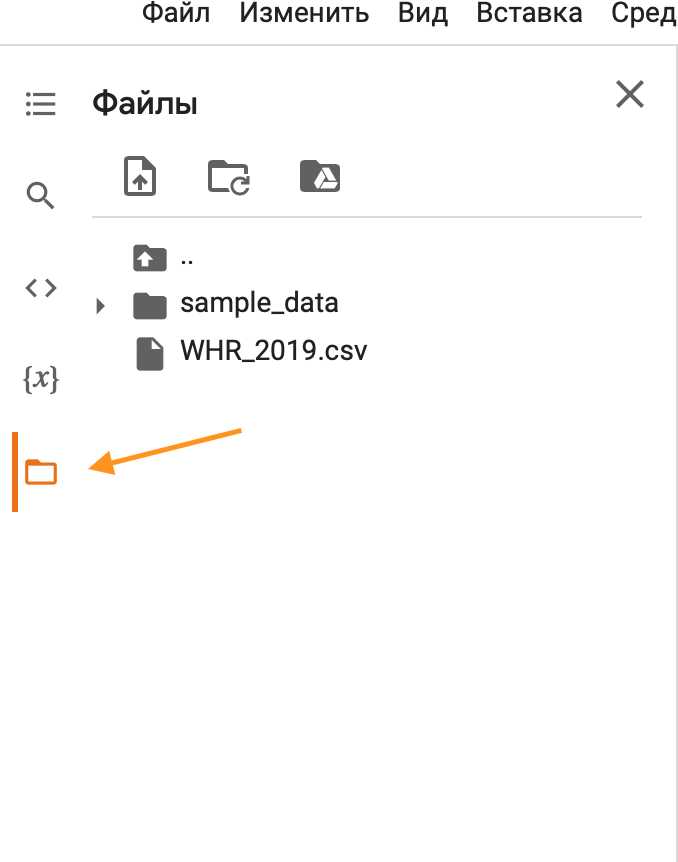

Библиотека pandas – основной инструмент для загрузки структурированных данных. Функция pandas.read_csv() автоматически определяет типы данных, поддерживает чтение из URL и позволяет обрабатывать файлы размером в сотни мегабайт. Для ускорения загрузки при работе с большими файлами рекомендуется указывать аргументы dtype и usecols. Например: pd.read_csv(«data.csv», usecols=[«id», «value»], dtype={«id»: int}).

Для чтения бинарных форматов данных, таких как Excel, HDF5 или Parquet, pandas предлагает функции read_excel(), read_hdf(), read_parquet(). Формат Parquet особенно эффективен для хранения больших датафреймов: он сжимает данные и ускоряет выборки по столбцам. Установка библиотеки pyarrow или fastparquet обязательна для работы с этим форматом.

Чтение данных из JSON удобно через json или pandas.read_json(). Первый вариант даёт полный контроль над структурой, но требует ручной обработки вложенных объектов. read_json() быстрее при работе с массивами объектов и может читать данные напрямую из API-ответов. Для сложных структур рекомендуется сначала использовать json.load() и затем трансформировать данные в DataFrame вручную.

Чтение CSV-файлов с помощью pandas: параметры, проблемы и решения

Для загрузки CSV-файлов в pandas используется функция read_csv(). Минимальный вызов: pd.read_csv('файл.csv'), но в реальности требуется точная настройка параметров.

sep – разделитель. По умолчанию запятая. Для файлов с табуляцией используйте sep='\t'. Если символ-разделитель – точка с запятой, как часто бывает в выгрузках из Excel, укажите sep=';'.

encoding – кодировка. Для файлов в Windows часто требуется encoding='cp1251'. Проблемы с кириллицей при чтении – признак неверной кодировки. Универсальный способ: chardet или charset-normalizer для определения кодировки до загрузки.

decimal – символ десятичного разделителя. Для чисел вида 1,23 вместо 1.23 укажите decimal=','. Иначе данные интерпретируются как строки.

na_values – список обозначений пропущенных значений. Например, na_values=['-', 'NA', 'null'] позволяет корректно преобразовать их в NaN.

dtype – явное указание типов столбцов. Ускоряет загрузку и предотвращает ошибки. Например: dtype={'id': 'int64', 'дата': 'string'}. Без этого pandas может неверно интерпретировать числовые коды как строки из-за пропусков.

parse_dates – парсинг дат. Передавайте список столбцов с датами или словарь с форматом: parse_dates=['дата'] или date_parser=lambda x: pd.to_datetime(x, format='%d.%m.%Y'). Без явного указания формата pandas может ошибиться с порядком дня и месяца.

usecols – ограничение набора столбцов. Полезно при работе с большими файлами: usecols=['id', 'дата'].

nrows – чтение первых n строк. Удобно для предварительного анализа структуры файла: nrows=100.

Распространённые ошибки: несовпадение кодировки, неоднородные типы данных, некорректный формат дат, наличие скрытых символов в заголовках (например, неразрывный пробел). Для диагностики используйте df.columns.tolist(), df.dtypes и df.info().

Файлы с большим объёмом (сотни МБ) лучше загружать построчно с параметром chunksize: pd.read_csv('файл.csv', chunksize=10000). Это позволяет обрабатывать данные порциями и экономить память.

Если файл повреждён или содержит лишние символы, используйте error_bad_lines=False (до pandas 1.3) или on_bad_lines='skip' (в новых версиях).

При работе с нестандартной структурой полезен предварительный просмотр первых строк файла через open или head -n в командной строке. Это позволяет заранее определить нужные параметры read_csv.

Загрузка Excel-файлов: поддержка форматов, выбор листа, обработка пропусков

Для чтения Excel-файлов в Python используется pandas.read_excel(). Поддерживаются форматы .xls (BIFF8) и .xlsx (Office Open XML). Для чтения .xls требуется xlrd версии ≤1.2.0, для .xlsx – openpyxl.

Для явного указания листа используйте параметр sheet_name. Возможны следующие значения:

| Значение | Поведение |

|---|---|

| имя строки | загрузка листа по названию |

| целое число | загрузка по индексу (0 – первый лист) |

| список | загрузка нескольких листов |

| None | загрузка всех листов (словарь) |

Пропуски значений обрабатываются с помощью параметров na_values, keep_default_na, dtype и converters. Например, для явной интерпретации строки «n/a» как пропуска используйте na_values="n/a". Чтобы отключить автоматическое преобразование строк вроде «NA», укажите keep_default_na=False.

Для удаления строк с пропусками применяйте dropna(). Чтобы заменить пропуски на значения по умолчанию – fillna(). Явное указание типов через dtype позволяет избежать ошибочного приведения к float при наличии пропусков в числовых столбцах.

Пример чтения второго листа файла data.xlsx с обработкой пропусков:

import pandas as pd

df = pd.read_excel(

"data.xlsx",

sheet_name=1,

na_values=["n/a", "--"],

keep_default_na=False,

dtype={"Код": str}

)

df = df.fillna({"Цена": 0})

Чтение текстовых файлов построчно и целиком: open(), pathlib, codecs

Функция open() – базовый способ чтения текстовых файлов. Для чтения всего содержимого используют: with open('file.txt', 'r', encoding='utf-8') as f: data = f.read(). Для построчного чтения: for line in f: или f.readlines(), если нужен список строк. Метод readline() подходит для последовательной обработки, но медленнее при большом количестве строк.

Модуль pathlib предоставляет объектно-ориентированный интерфейс. Получение всех строк: from pathlib import Path и lines = Path('file.txt').read_text(encoding='utf-8').splitlines(). Для ленивого чтения строк: with Path('file.txt').open('r', encoding='utf-8') as f: и далее итерация по f. Такой подход эффективнее при больших объёмах данных.

Модуль codecs нужен при работе с нестандартными кодировками. Чтение всего файла: import codecs и data = codecs.open('file.txt', 'r', 'cp1251').read(). Построчно: for line in codecs.open('file.txt', 'r', 'cp1251'):. codecs сохраняет совместимость с Python 2 и обеспечивает более точный контроль над декодированием.

Для работы с большими файлами предпочтительно использовать построчное чтение в конструкции with, избегая read(), так как он загружает всё содержимое в память. При работе с файлами в разных кодировках не полагаться на autodetect – задавать encoding явно.

Работа с JSON: парсинг, вложенность, сохранение структуры

Для работы с JSON-файлами в Python используется встроенный модуль json. Он поддерживает сериализацию и десериализацию данных, соответствующих стандарту JSON.

Чтение JSON из файла:

import json

with open('data.json', 'r', encoding='utf-8') as f:

data = json.load(f)

Если JSON представлен строкой, применяется json.loads():

json_string = '{"user": {"id": 1, "name": "Анна"}}'

data = json.loads(json_string)

Для доступа к вложенным структурам используется последовательность ключей:

user_id = data['user']['id']

При чтении сложных и глубоко вложенных JSON-объектов рекомендуется использовать рекурсивный обход или модуль jsonpath-ng:

from jsonpath_ng import parse

jsonpath_expr = parse('$.store.book[*].author')

authors = [match.value for match in jsonpath_expr.find(data)]

Для сохранения структуры JSON при записи важно указать параметры ensure_ascii=False и indent:

with open('output.json', 'w', encoding='utf-8') as f:

json.dump(data, f, ensure_ascii=False, indent=4)

Если необходимо сохранить порядок ключей, используется object_pairs_hook=collections.OrderedDict при загрузке:

from collections import OrderedDict

with open('data.json', 'r', encoding='utf-8') as f:

data = json.load(f, object_pairs_hook=OrderedDict)

Для сериализации нестандартных объектов (например, datetime) нужно определить свою функцию преобразования:

import datetime

def encoder(obj):

if isinstance(obj, datetime.datetime):

return obj.isoformat()

raise TypeError(f'Type {type(obj)} not serializable')

json.dumps({'time': datetime.datetime.now()}, default=encoder)

Получение данных из API: requests, обработка ответа, разбор JSON

Для обращения к REST API используется библиотека requests. Установка: pip install requests.

Пример GET-запроса к API с параметрами:

import requests

url = "https://api.exchangerate.host/latest"

params = {"base": "USD", "symbols": "EUR,RUB"}

response = requests.get(url, params=params)

После выполнения запроса необходимо проверить статус ответа:

if response.status_code != 200:

raise Exception(f"Ошибка запроса: {response.status_code}")

Метод .json() автоматически преобразует JSON-ответ в словарь Python. Обработка данных:

data = response.json()

eur_rate = data["rates"]["EUR"]

rub_rate = data["rates"]["RUB"]

Для устойчивости рекомендуется обрабатывать исключения:

try:

response = requests.get(url, params=params, timeout=5)

response.raise_for_status()

data = response.json()

except requests.exceptions.RequestException as e:

print(f"Сетевая ошибка: {e}")

except ValueError:

print("Ошибка разбора JSON")

Если API требует авторизацию, добавляют заголовки:

headers = {"Authorization": "Bearer <your_token>"}

response = requests.get("https://api.example.com/data", headers=headers)

Использование response.text оправдано, если требуется ручной разбор JSON, например с помощью json.loads():

import json

raw = response.text

parsed = json.loads(raw)

Для анализа вложенных структур рекомендуется использовать оператор .get() с дефолтным значением:

user_info = data.get("user", {})

email = user_info.get("email", "не указано")

Чтение из базы данных: подключение через sqlite3 и SQLAlchemy

Для работы с базами данных в Python часто используются библиотеки sqlite3 и SQLAlchemy. Обе эти библиотеки предоставляют разные способы подключения и взаимодействия с базой данных. Рассмотрим их особенности и применение при чтении данных.

sqlite3 является встроенной библиотекой для работы с базами данных SQLite. Она обеспечивает прямой доступ к базе данных без необходимости установки дополнительных зависимостей. Для подключения используется функция sqlite3.connect, после чего можно создавать курсор для выполнения SQL-запросов.

Пример подключения и чтения данных из таблицы:

import sqlite3

# Подключение к базе данных

conn = sqlite3.connect('example.db')

# Создание курсора

cursor = conn.cursor()

# Выполнение запроса

cursor.execute("SELECT * FROM users")

# Извлечение всех результатов

rows = cursor.fetchall()

# Обработка данных

for row in rows:

print(row)

# Закрытие соединения

conn.close()

SQLAlchemy представляет собой более мощный инструмент для работы с базами данных, предоставляющий ORM (Object-Relational Mapping), а также поддержку множества разных СУБД. Для чтения данных с использованием SQLAlchemy необходимо сначала создать сессию и запросить данные через ORM-модели или SQL-запросы.

Пример подключения через SQLAlchemy:

from sqlalchemy import create_engine

from sqlalchemy.orm import sessionmaker

from models import User

# Подключение к базе данных

engine = create_engine('sqlite:///example.db')

Session = sessionmaker(bind=engine)

session = Session()

# Запрос данных

users = session.query(User).all()

# Обработка данных

for user in users:

print(user.name, user.age)

# Закрытие сессии

session.close()

В этом примере создается подключение через create_engine, с использованием URL-строки для SQLite базы данных. Session позволяет взаимодействовать с таблицей через модель User, где каждый объект представляет строку в таблице. Вызывая session.query(User).all(), мы получаем все записи из таблицы, определенной в модели.

Для более сложных запросов SQLAlchemy также поддерживает выполнение чистых SQL-запросов, что позволяет гибко комбинировать ORM и традиционные SQL-запросы в одном приложении.

Обе библиотеки подходят для разных целей: sqlite3 идеально подходит для простых и легких приложений с небольшими базами данных, в то время как SQLAlchemy предоставляет более гибкие возможности для масштабируемых и сложных проектов с поддержкой различных СУБД и мощной ORM-системой.

Загрузка данных из интернета: работа с URL, потоковая загрузка, временные файлы

Для начала, загрузим данные с помощью библиотеки requests.

import requests

url = "https://example.com/data.csv"

response = requests.get(url)

response.raise_for_status() # Проверка успешности запроса

data = response.text

В данном примере мы получаем данные по URL и сохраняем их в переменную data. Функция raise_for_status() гарантирует, что в случае ошибки (например, 404 или 500) будет поднято исключение.

Для работы с потоковыми данными, например, при загрузке больших файлов, используется параметр stream=True. Это позволяет избегать перегрузки памяти при скачивании больших объемов информации.

url = "https://example.com/largefile.zip"

with requests.get(url, stream=True) as response:

response.raise_for_status()

with open("largefile.zip", "wb") as file:

for chunk in response.iter_content(chunk_size=8192):

file.write(chunk)

Здесь данные загружаются по частям (вместо загрузки всего файла в память). Каждый фрагмент сохраняется в файл, что позволяет работать с большими файлами без излишней нагрузки на память.

Еще один полезный метод – использование временных файлов. В случае, если необходимо обрабатывать данные без их сохранения на диск, можно использовать модуль tempfile.

import tempfile

with tempfile.NamedTemporaryFile(delete=False) as temp_file:

url = "https://example.com/data.csv"

response = requests.get(url)

temp_file.write(response.content)

print(f"Данные записаны во временный файл: {temp_file.name}")

В данном примере файл создается в операционной системе, но при этом его можно использовать только в рамках текущего сеанса программы. После завершения работы с ним, файл будет автоматически удален, если delete=True.

Для более сложных задач, например, для многократного скачивания данных с URL или обработки данных с различных источников, можно комбинировать использование временных файлов и потоковой загрузки. Это обеспечит минимальную нагрузку на систему при работе с большими объемами данных.

Вопрос-ответ:

Какие существуют способы чтения данных в Python?

В Python для чтения данных можно использовать несколько методов, в зависимости от типа данных и источника. Один из наиболее распространенных способов — использование стандартных функций, таких как `open()` для чтения текстовых файлов. Также часто применяются библиотеки, такие как `pandas` для работы с табличными данными (например, CSV или Excel), `json` для обработки данных в формате JSON и `csv` для работы с CSV-файлами. Все эти способы позволяют загружать данные с диска или из интернета и работать с ними внутри программы.

Как загрузить данные из CSV файла в Python?

Для чтения данных из CSV файла удобно использовать библиотеку `pandas`. Для этого достаточно воспользоваться функцией `pd.read_csv()`, указав путь к файлу. Например: `df = pd.read_csv(‘data.csv’)`. Этот метод автоматически обрабатывает разделители и может распознать различные форматы дат и чисел. Если необходимо, можно настроить дополнительные параметры, такие как выбор столбцов или обработка пропущенных значений.

Что делать, если данные, которые я пытаюсь прочитать, имеют нестандартный формат?

Если данные имеют нестандартный формат, можно использовать различные подходы для их обработки. Например, если данные разделены не запятой, а другим символом (например, табуляцией или точкой с запятой), можно указать соответствующий разделитель в методах, таких как `pd.read_csv()` (параметр `sep`). В случае с JSON можно использовать методы библиотеки `json` для корректной загрузки данных, если структура данных отличается от обычной. Иногда также бывает полезно предварительно обработать файл с помощью регулярных выражений или других инструментов для очистки данных перед их загрузкой.

Какие способы чтения данных в Python наиболее популярны и как они различаются по эффективности?

В Python существует несколько популярных методов чтения данных, каждый из которых подходит для разных типов файлов. Например, для текстовых файлов часто используют стандартные функции open() и методы работы с файловыми объектами, такими как read(), readlines(). Для более сложных форматов, таких как CSV, JSON или Excel, часто применяют библиотеки csv, json и pandas, которые упрощают работу с данными, автоматически преобразуя их в удобные структуры данных, например, списки или DataFrame. Если данные хранятся в больших объемах, например, в формате HDF5 или Parquet, то чаще всего для их загрузки используется библиотека h5py или pyarrow. Важное различие между этими способами заключается в скорости работы и памяти: для небольших файлов достаточно стандартных функций, а для больших наборов данных лучше использовать специализированные библиотеки, которые оптимизированы для обработки больших объемов данных.