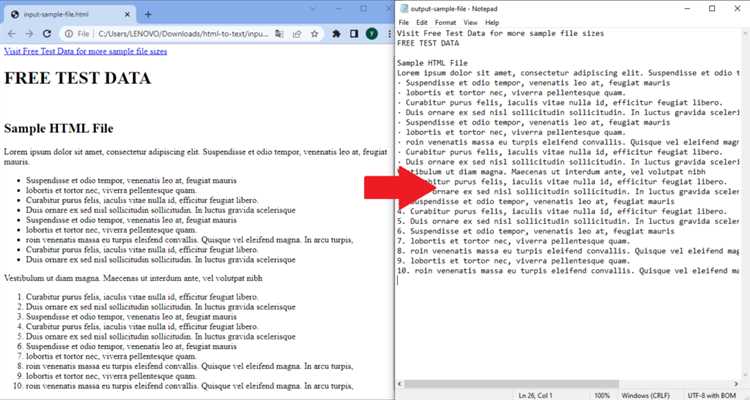

При работе с HTML-страницами на Python, одной из частых задач является извлечение текста из HTML-элементов. Это полезно при парсинге данных, например, для сбора информации с сайтов. Для этих целей существует несколько мощных инструментов, среди которых выделяются библиотеки BeautifulSoup и lxml. Эти инструменты позволяют легко обрабатывать и извлекать текст, сохраняя структуру HTML-документа.

BeautifulSoup предоставляет удобный интерфейс для поиска элементов на странице, что делает его идеальным для работы с текстовыми данными. Чтобы извлечь текст из конкретного тега, достаточно использовать метод get_text(), который возвращает содержимое без HTML-меток. Например, если нужно получить текст из тега <div>, код будет выглядеть так:

from bs4 import BeautifulSoup

html_content = '<div>Пример текста</div>'

soup = BeautifulSoup(html_content, 'html.parser')

text = soup.div.get_text()

print(text)

Для более сложных задач, таких как извлечение текста из нескольких тегов одновременно, можно использовать методы поиска элементов по атрибутам или CSS-классам. Например, чтобы извлечь текст из всех <p> тегов с классом content, можно воспользоваться методом find_all():

paragraphs = soup.find_all('p', class_='content')

for p in paragraphs:

print(p.get_text())

Таким образом, использование BeautifulSoup позволяет быстро и эффективно извлекать текст из HTML-документов, значительно упрощая задачу парсинга.

Установка библиотеки BeautifulSoup для парсинга HTML

Для начала установим необходимые пакеты через менеджер пакетов pip. Откройте терминал и выполните следующую команду:

pip install beautifulsoup4

Кроме самой библиотеки BeautifulSoup, для корректной работы также нужно установить парсер, который будет использоваться для анализа HTML. В Python доступны несколько парсеров, но одним из самых популярных является lxml. Чтобы установить его, выполните команду:

pip install lxml

Если по каким-то причинам вы хотите использовать стандартный парсер Python – html.parser, то дополнительных установок не потребуется. Однако lxml или html5lib могут предложить более стабильную работу с некорректно оформленными HTML-документами.

После успешной установки библиотеки BeautifulSoup, вы можете импортировать её в свой код с помощью следующей строки:

from bs4 import BeautifulSoup

Теперь можно начинать работу с HTML-документами, используя функционал библиотеки для извлечения текста, атрибутов или работы с элементами DOM.

Поиск тега в HTML-документе с помощью BeautifulSoup

Для поиска тега в HTML-документе с использованием библиотеки BeautifulSoup необходимо выполнить несколько простых шагов. Библиотека предоставляет удобные методы для навигации по HTML-структуре и извлечения информации.

Сначала нужно импортировать библиотеку и создать объект BeautifulSoup из HTML-кода. Например:

from bs4 import BeautifulSoup

Текст параграфа

soup = BeautifulSoup(html_doc, 'html.parser')После создания объекта soup можно использовать различные методы для поиска тегов:

- find() – находит первый элемент, удовлетворяющий указанному фильтру. Возвращает объект тега или None, если элемент не найден.

- find_all() – находит все элементы, соответствующие фильтру, и возвращает список тегов.

- select() – позволяет использовать CSS-селекторы для поиска элементов.

Для поиска первого тега <p> можно использовать метод find():

p_tag = soup.find('p')

print(p_tag.text) # Выведет: Текст параграфаМетод find_all() вернёт все теги <p>:

p_tags = soup.find_all('p')

for tag in p_tags:

print(tag.text)Если требуется найти тег с определённым атрибутом, можно использовать аргумент attrs. Например, для поиска тега <a> с атрибутом href:

a_tag = soup.find('a', attrs={'href': 'http://example.com'})

print(a_tag) # Выведет тег с указанным атрибутомМетод select() работает с CSS-селекторами. Например, для поиска всех элементов с классом header можно использовать:

header_tags = soup.select('.header')

for tag in header_tags:

print(tag.text)Эти методы дают гибкость в поиске элементов и извлечении данных из HTML-документов. Выбор метода зависит от задачи и структуры документа.

Извлечение текста с помощью метода .get_text()

Метод .get_text() в библиотеке BeautifulSoup позволяет извлечь весь текст, содержащийся в HTML-элементе, включая вложенные теги. Это основной инструмент для работы с текстом внутри тега без учета HTML-разметки. Применяется к объекту типа BeautifulSoup или Tag, предоставляя удобный способ получения чистого текста.

Пример использования:

from bs4 import BeautifulSoup

html = "<html><body><p>Привет, мир!</p></body></html>"

soup = BeautifulSoup(html, 'html.parser')

text = soup.p.get_text()

print(text)

Этот код извлечет текст «Привет, мир!» из тега <p>. Метод .get_text() удаляет все HTML-теги, оставляя только текстовое содержимое. При этом, если в теге содержатся другие теги, их текст тоже будет извлечен.

Метод .get_text() имеет параметр separator, который позволяет задать разделитель между извлеченными частями текста. Например, если элемент содержит несколько параграфов, можно вставить разделитель между ними:

html = "<html><body><p>Первый параграф</p><p>Второй параграф</p></body></html>"

soup = BeautifulSoup(html, 'html.parser')

text = soup.get_text(separator=' | ')

print(text)

Результат: «Первый параграф | Второй параграф». Этот параметр полезен, когда необходимо контролировать форматирование текста при извлечении.

Метод .get_text() не учитывает вложенные теги и возвращает только текст. Однако, если нужно извлечь текст только из определенной части страницы или конкретного элемента, можно комбинировать его с другими методами BeautifulSoup, например, find() или find_all().

Использование .get_text() удобно в задачах, где нужно быстро получить информацию из структурированных HTML-страниц, не заботясь о сохранении оригинальных тегов. Однако для обработки сложных страниц с мультимедийным содержимым или сложной разметкой рекомендуется использовать дополнительные методы для более точного извлечения данных.

Работа с вложенными тегами и их текстом

Чтобы извлечь текст из вложенных тегов, нужно правильно адресовать каждый уровень вложенности. Рассмотрим пример HTML-структуры:

Первый абзац

Текст внутри spanВторой абзац

Для извлечения текста, включая вложенные элементы, применяются методы, такие как find_all() и text. Пример извлечения текста:

from bs4 import BeautifulSoup html = '''''' soup = BeautifulSoup(html, 'html.parser') text = soup.get_text() print(text)Первый абзац

Текст внутри spanВторой абзац

Результат будет следующим:

Первый абзац Текст внутри span Второй абзац

Для более точного извлечения можно работать с конкретными тегами. Например, чтобы извлечь текст только из тегов <p>, используем метод find_all():

paragraphs = soup.find_all('p')

for p in paragraphs:

print(p.get_text())

Первый абзац Второй абзац

Если необходимо учитывать вложенные теги в определённом контексте, например, извлечь текст из <span> внутри <div>, можно воспользоваться дополнительными фильтрами:

div = soup.find('div')

span_text = div.find('span').get_text()

print(span_text)

Результат: Текст внутри span

Для получения всего текста без разделения на отдельные элементы можно использовать метод stripped_strings, который возвращает текст, удаляя лишние пробелы:

for text in soup.stripped_strings: print(text)

Этот подход позволяет извлекать текст более чисто и удобно для дальнейшей обработки.

Важно помнить, что работа с вложенными тегами требует понимания структуры документа. Использование методов фильтрации и поиска по тегам помогает извлечь только нужный текст, не затрудняя обработку. Также стоит помнить о возможных скрытых тегах, таких как <script> или <style>, которые могут быть нежелательными для извлечения текста.

Как извлечь текст из тега с атрибутами

Основные шаги для извлечения текста:

from bs4 import BeautifulSoup

html = 'Текст внутри div'

soup = BeautifulSoup(html, 'html.parser')

tag = soup.find('div', {'class': 'content', 'id': 'main'})

text = tag.get_text()

print(text)

Здесь мы ищем тег <div>, который содержит два атрибута: class и id. Метод find() возвращает первый найденный элемент, соответствующий условиям, а get_text() извлекает текст внутри тега.

Если необходимо извлечь текст из множества тегов с определёнными атрибутами, можно использовать find_all():

tags = soup.find_all('div', {'class': 'content'})

for tag in tags:

print(tag.get_text())

Этот код извлекает текст из всех тегов <div>, имеющих атрибут class="content".

Когда требуется извлечь текст из более сложных структур, например, с вложенными тегами, можно комбинировать поиск по атрибутам с методами навигации по дереву элементов, например, children или descendants.

Важно помнить, что использование find() и find_all() позволяет эффективно работать с тегами, имеющими атрибуты, но в случае наличия динамического контента (например, через JavaScript) потребуется использование библиотеки Selenium для полноценной обработки таких страниц.

Обработка ошибок при парсинге HTML-документов

При работе с HTML-документами в Python возникает множество ошибок, которые могут затруднить парсинг. Основные причины – некорректная структура документа, отсутствие необходимых тегов или проблемы с кодировкой. Для их эффективной обработки следует использовать несколько методов.

Первым шагом является использование библиотеки BeautifulSoup. Она автоматически исправляет некоторые распространённые ошибки, например, недостающие закрывающие теги. Однако для выявления более сложных проблем полезно обработать исключения с помощью конструкции try-except. В случае ошибки парсинга важно логировать информацию о проблеме для дальнейшего анализа.

Пример обработки ошибок с использованием BeautifulSoup:

from bs4 import BeautifulSoup

try:

soup = BeautifulSoup(html_content, 'html.parser')

except Exception as e:

print(f"Ошибка при парсинге: {e}")

Если HTML-документ имеет проблемы с кодировкой, например, содержит символы, которые не могут быть корректно интерпретированы, необходимо указать правильную кодировку при чтении файла или передать её в метод BeautifulSoup. Для этого можно использовать параметр encoding или модуль chardet для автоопределения кодировки.

Пример указания кодировки:

with open('file.html', encoding='utf-8') as f:

soup = BeautifulSoup(f, 'html.parser')

В случае парсинга веб-страниц, иногда сервер может вернуть неполный или повреждённый HTML. В таких ситуациях полезно проверять статус HTTP-ответа с помощью библиотеки requests, чтобы убедиться, что документ был получен корректно. Ошибки можно ловить через статусные коды, такие как 404 (не найдено) или 500 (ошибка сервера).

Пример обработки HTTP-ошибок:

import requests

response = requests.get('http://example.com')

if response.status_code == 200:

soup = BeautifulSoup(response.content, 'html.parser')

else:

print(f"Ошибка при запросе: {response.status_code}")

При парсинге большого количества HTML-страниц стоит учитывать возможные сетевые сбои. Для этого следует использовать исключение requests.exceptions.RequestException и повторные попытки с использованием time.sleep или библиотеки tenacity для автоматического восстановления попытки подключения.

Кроме того, при извлечении текста из тега важно проверять наличие самого тега, чтобы избежать ошибок типа AttributeError, если элемент не существует в документе.

Пример обработки отсутствующего тега:

tag = soup.find('p')

if tag:

print(tag.text)

else:

print("Тег не найден")

Таким образом, ключевыми аспектами при обработке ошибок являются правильная настройка кодировки, обработка исключений для различных типов ошибок и проверка наличия элементов перед их использованием. Это позволит значительно повысить стабильность парсинга HTML-документов.