Формат JSON активно используется для хранения и обмена структурированными данными. В Python работа с такими файлами реализована через модуль json, входящий в стандартную библиотеку. Он предоставляет простые и эффективные средства для загрузки данных из JSON-файлов в виде словарей и списков.

Для открытия JSON-файла необходимо использовать встроенную функцию open() в режиме чтения, а затем передать файловый объект в функцию json.load(). Этот подход позволяет избежать лишнего выделения памяти и обеспечивает прямой доступ к структуре данных. Пример: with open('data.json', 'r') as f: data = json.load(f).

Следует учитывать, что JSON поддерживает ограниченный набор типов: строки, числа, булевы значения, списки, словари и null. При чтении файла Python автоматически преобразует их в соответствующие типы: строки в str, числа в int или float, true/false в True/False, null в None.

Если структура JSON-файла может быть некорректной или неизвестной заранее, рекомендуется обрабатывать исключения с помощью конструкции try-except, перехватывая json.JSONDecodeError. Это позволит избежать аварийного завершения программы и даст возможность обработать ошибку.

При работе с большими JSON-файлами полезно использовать модуль jsonlines или разбирать файл построчно, чтобы избежать загрузки всего содержимого в память. Такой подход особенно актуален при анализе логов или потоков данных.

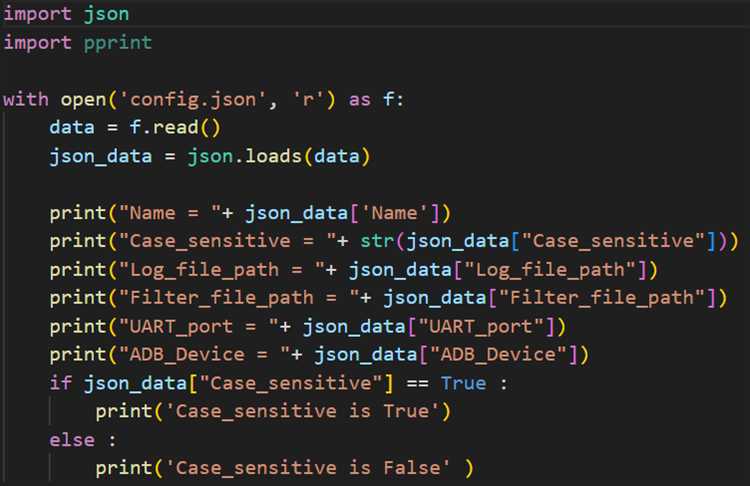

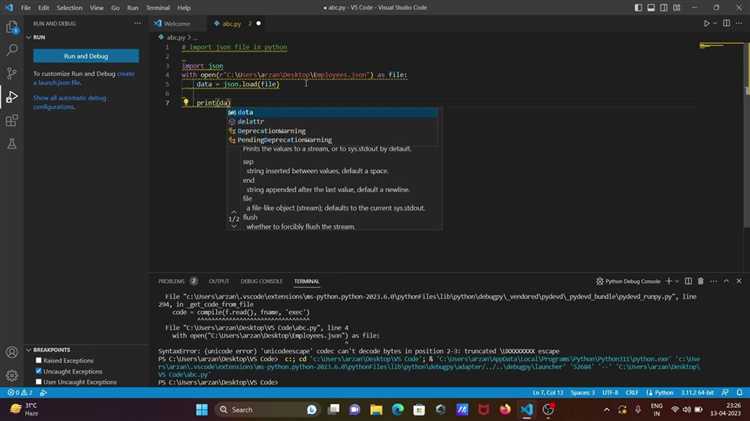

Как открыть JSON файл и загрузить его содержимое в переменную

Для загрузки данных из JSON файла в Python используется встроенный модуль json. Сначала открывается файл с помощью функции open(), затем его содержимое преобразуется в Python-объект с помощью json.load().

Пример корректного открытия файла и загрузки содержимого:

import json

with open('data.json', 'r', encoding='utf-8') as file:

data = json.load(file)

Файл должен быть в формате UTF-8, иначе возможны ошибки при декодировании. Использование конструкции with гарантирует автоматическое закрытие файла. Переменная data может содержать словарь, список или вложенные структуры, в зависимости от структуры JSON.

Если файл содержит ошибки формата, json.load() вызовет json.JSONDecodeError. Для защиты от сбоев рекомендуется использовать блок try-except:

try:

with open('data.json', 'r', encoding='utf-8') as file:

data = json.load(file)

except (FileNotFoundError, json.JSONDecodeError) as e:

print(f"Ошибка: {e}")

Имена файлов и пути к ним следует указывать явно или использовать модуль os для кроссплатформенной совместимости.

Чтение JSON файла с кодировкой UTF-8 и другими вариантами

По умолчанию большинство JSON файлов сохраняются в кодировке UTF-8. Для корректного чтения таких файлов в Python необходимо явно указать кодировку при открытии:

with open("data.json", "r", encoding="utf-8") as f:

data = json.load(f)

Если не указать encoding, на системах Windows возможны ошибки при наличии символов за пределами ASCII.

Для чтения файлов в других кодировках, таких как utf-16 или cp1251, используйте соответствующий параметр:

with open("data_ru.json", "r", encoding="cp1251") as f:

data = json.load(f)

Перед чтением неизвестного файла желательно определить кодировку с помощью библиотеки chardet:

import chardet

with open("data.json", "rb") as f:

raw = f.read()

result = chardet.detect(raw)

encoding = result["encoding"]

data = json.loads(raw.decode(encoding))

Для работы с большими JSON файлами используйте построчное чтение и парсинг с помощью библиотеки ijson, чтобы избежать перегрузки памяти:

import ijson

with open("large.json", "r", encoding="utf-8") as f:

for item in ijson.items(f, "items.item"):

process(item)

Чтение с правильной кодировкой критично при работе с данными на разных языках. Ошибки декодирования не всегда очевидны и могут повредить структуру JSON при загрузке.

Обработка ошибок при чтении повреждённого или некорректного JSON

Для безопасной загрузки данных используйте конструкцию try...except. Это позволяет перехватывать ошибку и предоставлять диагностическое сообщение с указанием позиции ошибки:

import json

try:

with open("data.json", "r", encoding="utf-8") as file:

data = json.load(file)

except json.JSONDecodeError as e:

print(f"Ошибка декодирования JSON: {e.msg} (строка {e.lineno}, столбец {e.colno})")

except FileNotFoundError:

print("Файл не найден.")

except Exception as e:

print(f"Непредвиденная ошибка: {e}")

Для отладки удобно использовать e.doc[e.pos - 20:e.pos + 20] – это фрагмент, где произошёл сбой. Он помогает локализовать проблему без ручного поиска по файлу.

Если файл поступает из ненадёжного источника, предварительно проверяйте его содержимое через валидаторы или простую регулярную проверку на наличие JSON-структур. Не пытайтесь автоматически «починить» файл без логики – это приведёт к потере данных.

При массовой обработке файлов критично вести лог ошибок. Используйте модуль logging вместо print, чтобы сохранить сообщения в журнал:

import logging

logging.basicConfig(filename="errors.log", level=logging.ERROR)

try:

with open("data.json", "r", encoding="utf-8") as file:

data = json.load(file)

except json.JSONDecodeError as e:

logging.error(f"JSONDecodeError: {e.msg} (строка {e.lineno}, столбец {e.colno})")

Никогда не игнорируйте исключения. Умышленное подавление ошибок (pass в except) может привести к непредсказуемому поведению и повреждению данных на последующих этапах обработки.

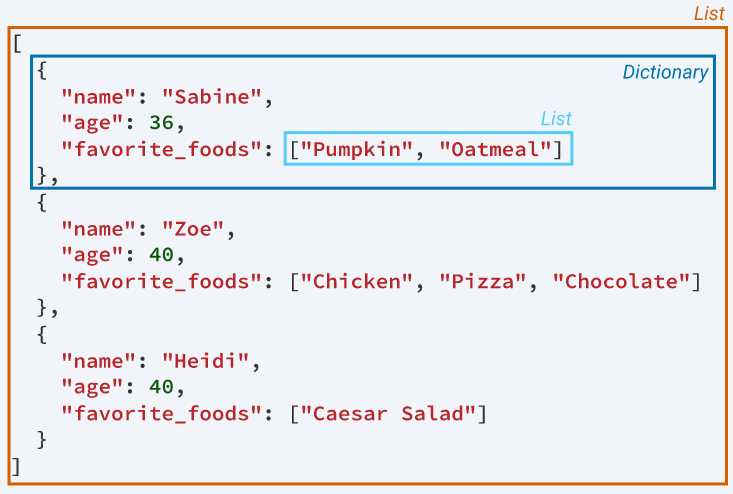

Работа с JSON-файлом, содержащим вложенные структуры

Вложенные структуры в JSON-файле представляют собой объекты, включающие в себя другие объекты или массивы. Для корректной обработки таких данных в Python используется модуль json и рекурсивные подходы к разбору содержимого.

Пример структуры файла:

{

"user": {

"id": 123,

"name": "Иван",

"contacts": {

"email": "ivan@example.com",

"phones": ["+79001234567", "+79007654321"]

}

},

"orders": [

{

"order_id": 1,

"items": [

{"name": "Книга", "qty": 2},

{"name": "Ручка", "qty": 5}

]

}

]

}

Для доступа к вложенным данным:

- Загрузите JSON-файл с помощью

json.load() - Используйте цепочку ключей для навигации по структуре

- Применяйте циклы для обхода списков

import json

with open('data.json', 'r', encoding='utf-8') as f:

data = json.load(f)

# Доступ к email

email = data['user']['contacts']['email']

# Обработка списка телефонов

for phone in data['user']['contacts']['phones']:

print(phone)

# Извлечение названий товаров из первого заказа

for item in data['orders'][0]['items']:

print(item['name'])

Для сложных вложенностей удобно использовать вспомогательные функции:

def extract_keys(d, path=[]):

if isinstance(d, dict):

for k, v in d.items():

yield from extract_keys(v, path + [k])

elif isinstance(d, list):

for i, item in enumerate(d):

yield from extract_keys(item, path + [i])

else:

print(" -> ".join(map(str, path)), ":", d)

Такой подход позволяет автоматически обходить все уровни вложенности и собирать значения без явного указания путей.

- Избегайте жёстко закодированных индексов и ключей

- Используйте проверку через

inиget()для устойчивости к отсутствующим данным - Для сериализации после изменений используйте

json.dump()с параметромindentдля читаемого формата

Чтение JSON построчно для обработки больших файлов

При работе с большими JSON-файлами, которые не помещаются в память, необходимо использовать построчное чтение. Это особенно актуально для файлов, содержащих множество JSON-объектов, записанных через перенос строки (формат JSON Lines или NDJSON).

Для построчной обработки используйте встроенную функцию open() с параметром 'r' и итерацию по файлу. Каждая строка должна быть разобрана с помощью json.loads():

import json

with open('large_file.json', 'r', encoding='utf-8') as f:

for line in f:

if line.strip():

data = json.loads(line)

# Обработка data

При наличии вложенных структур избегайте загрузки всех строк в память. Обрабатывайте каждую строку отдельно, очищая временные переменные после использования. Это минимизирует потребление памяти и снижает вероятность утечек.

Если строки содержат ошибки сериализации, используйте try-except внутри цикла, чтобы не прерывать чтение всего файла:

with open('large_file.json', 'r', encoding='utf-8') as f:

for line in f:

try:

data = json.loads(line)

# Обработка data

except json.JSONDecodeError:

continue # или логирование ошибки

Для ускорения обработки используйте модуль ujson или orjson, которые работают быстрее стандартного json, но требуют дополнительной установки. При чтении gz-сжатых файлов применяйте модуль gzip:

import gzip

with gzip.open('large_file.json.gz', 'rt', encoding='utf-8') as f:

for line in f:

data = json.loads(line)

# Обработка data

Построчное чтение – предпочтительный способ обработки больших JSON-файлов, когда данные представлены как отдельные JSON-объекты по строкам. Формат вложенного массива JSON требует другой стратегии, такой как потоковый парсинг с использованием ijson.

Использование pathlib для работы с путями к JSON файлам

Модуль pathlib в Python предоставляет удобный и гибкий способ работы с файловыми путями. Он позволяет эффективно управлять путями к файлам, включая JSON файлы, без необходимости ручного обработки строковых путей. В отличие от старого модуля os.path, pathlib работает с объектами, что делает код более читаемым и менее подверженным ошибкам.

При работе с JSON файлами важно учитывать правильность пути к файлу, особенно при использовании относительных путей или работе в различных операционных системах. pathlib помогает минимизировать проблемы с различиями в путях между Windows и Unix-подобными системами.

Для начала, создадим объект пути, используя Path из pathlib. Это позволяет легко работать с файловыми путями:

from pathlib import Path

# Абсолютный путь к файлу

json_path = Path('/home/user/data/file.json')

# Относительный путь

json_path_relative = Path('data/file.json')Использование объекта Path позволяет выполнять операции с путями, такие как проверка существования файла, создание директорий или изменение имени файла, без необходимости ручной работы с строками пути.

Для чтения JSON файла с использованием pathlib, сначала нужно проверить, существует ли файл по указанному пути, с помощью метода exists(). Если файл существует, можно открыть его, используя стандартную библиотеку json:

import json

# Проверка существования файла

if json_path.exists():

with json_path.open('r') as f:

data = json.load(f)

print(data)

else:

print("Файл не найден.") Метод open() из pathlib возвращает файловый объект, который можно использовать для работы с данными. Это упрощает код и делает его более понятным.

Когда работа с файлом завершена, не забудьте закрыть его. Для этого можно использовать контекстный менеджер with, как показано в примере выше. Этот подход обеспечивает автоматическое закрытие файла, даже если в процессе работы возникнут ошибки.

Если необходимо создать директорию перед сохранением JSON файла, pathlib предоставляет удобный метод mkdir(), который можно использовать с параметром parents=True, чтобы создать родительские директории, если их еще нет:

# Создание директории, если она не существует

json_dir = Path('data')

json_dir.mkdir(parents=True, exist_ok=True)Метод mkdir() также позволяет избежать ошибок, если директория уже существует, благодаря параметру exist_ok=True.

Таким образом, pathlib упрощает работу с путями и позволяет легко интегрировать обработку файлов JSON в вашем проекте. Использование этой библиотеки позволяет сделать код более читаемым и надежным, минимизируя количество ошибок при работе с файловыми путями.

Как читать JSON файл из архива или по сети

Чтение JSON файлов может быть не таким простым, если данные находятся в архивах или передаются по сети. Для таких случаев существуют специализированные библиотеки и подходы, которые позволяют эффективно работать с такими источниками.

Рассмотрим два основных сценария: чтение JSON файлов из архивов (например, ZIP) и получение данных по сети.

Чтение JSON файла из архива

Для работы с архивами в Python удобно использовать библиотеку zipfile. Этот модуль позволяет извлекать файлы из ZIP архивов и сразу читать их содержимое. Для чтения JSON файла внутри архива можно использовать следующие шаги:

- Открыть архив с помощью

zipfile.ZipFile. - Извлечь нужный JSON файл в память с помощью метода

open. - Прочитать данные как JSON с использованием модуля

json.

Пример кода:

import zipfile

import json

Открытие архива

with zipfile.ZipFile('archive.zip', 'r') as archive:

# Чтение JSON файла внутри архива

with archive.open('data.json') as json_file:

data = json.load(json_file)

print(data)

В этом примере архив archive.zip содержит файл data.json. Мы извлекаем его содержимое и сразу преобразуем в Python объект с помощью json.load.

Чтение JSON файла по сети

Для чтения JSON данных по сети обычно используется библиотека requests, которая позволяет легко отправлять HTTP-запросы и работать с ответами. Чтобы получить JSON файл через HTTP или HTTPS, нужно сделать GET запрос и обработать его ответ как JSON.

- Отправить GET запрос с помощью

requests.get. - Получить содержимое ответа с помощью метода

json.

Пример кода:

import requests

Отправка GET запроса

response = requests.get('https://example.com/data.json')

Проверка успешности запроса

if response.status_code == 200:

# Чтение JSON данных из ответа

data = response.json()

print(data)

else:

print('Ошибка загрузки данных', response.status_code)

В этом примере мы отправляем запрос на URL https://example.com/data.json и получаем JSON данные через метод json() объекта ответа. Важно всегда проверять код состояния ответа, чтобы удостовериться, что запрос был успешным.

Рекомендации

- При работе с большими архивами или файлами по сети учитывайте скорость чтения и возможности использования многозадачности.

- Если файл внутри архива или по сети слишком большой, можно использовать поточное чтение данных, чтобы избежать перегрузки памяти.

- Для сетевых запросов рекомендуется обрабатывать возможные ошибки (например, проблемы с подключением), чтобы сделать ваш код более устойчивым.

Преобразование данных из JSON в структуры Python для последующей обработки

После открытия JSON файла в Python, данные представляют собой строку, которую необходимо преобразовать в соответствующие структуры данных, такие как списки или словари. Для этого Python предлагает стандартную библиотеку json, которая предоставляет два основных метода: json.load() и json.loads().

Метод json.load() используется, когда данные JSON считываются непосредственно из файла. Он принимает объект файла как аргумент и преобразует его содержимое в структуру данных Python. Например:

import json

with open('data.json', 'r') as file:

data = json.load(file)

Здесь переменная data будет представлять собой словарь или список, в зависимости от структуры JSON. Если JSON-файл начинается с объекта (например, {}), результатом будет словарь, если с массива ([]) – список.

Метод json.loads() используется для преобразования JSON-строки в объект Python. Это полезно, если данные JSON получены, например, через API или из строки, а не из файла. Пример:

import json

json_string = '{"name": "Alice", "age": 30}'

data = json.loads(json_string)

После выполнения кода в переменной data будет храниться словарь {'name': 'Alice', 'age': 30}.

При работе с JSON часто встречаются различные типы данных, которые могут быть в нем представлены: строки, числа, булевы значения, массивы и объекты. После преобразования JSON в структуру данных Python важно корректно интерпретировать каждый элемент. Например, строки в JSON автоматически преобразуются в строки Python, числа – в int или float, а массивы – в списки.

При обработке данных после преобразования стоит учитывать возможные ошибки в структуре JSON. Например, могут быть пропущены ключи, или данные могут быть неполными. Поэтому полезно использовать методы проверки, такие как get() для извлечения значений по ключам, чтобы избежать ошибок, если ключ отсутствует:

name = data.get('name', 'Unknown')

Если необходимо преобразовать сложные данные JSON в более удобный для обработки формат, например, вложенные структуры, их можно обработать рекурсивно, или с помощью библиотеки pandas для удобного преобразования в DataFrame. Это полезно при работе с большими объемами данных, так как DataFrame позволяет выполнять фильтрацию, агрегацию и другие операции с данными более эффективно.