Парсинг поисковой выдачи Яндекса – это процесс извлечения данных из результатов поиска для анализа, мониторинга позиций или сбора информации о конкурентных страницах. Яндекс, как один из ведущих поисковиков в России, предоставляет ценную информацию, которую можно использовать для различных целей: от SEO-анализа до изучения трендов. В этой статье мы рассмотрим, как эффективно парсить поисковую выдачу Яндекса с помощью Python, используя популярные библиотеки, такие как requests и BeautifulSoup.

Для начала важно понять, что Яндекс предоставляет данные о результатах поиска через HTML-страницы. Эти страницы содержат не только текстовую информацию, но и разнообразные метаданные, такие как теги, ссылки, аннотации, рейтинги. Простой HTTP-запрос к странице выдачи и последующий анализ HTML-кода с помощью парсинга позволяет извлекать необходимую информацию. Однако важно учитывать, что Яндекс активно защищает свои ресурсы от автоматического сбора данных, поэтому в процессе парсинга необходимо соблюдать правила использования API и уважать ограничения, установленные поисковой системой.

Чтобы начать парсинг, необходимо сделать запрос к поисковой странице Яндекса, обработать полученный HTML-код и извлечь нужные элементы. Для этого достаточно установить несколько библиотек. requests отвечает за отправку HTTP-запросов, а BeautifulSoup поможет нам анализировать и извлекать данные из HTML. Важно учитывать возможные проблемы, такие как динамическая загрузка контента через JavaScript, ограничение на количество запросов или блокировка IP-адреса.

Простой пример кода для парсинга поисковой выдачи Яндекса может выглядеть так:

import requests

from bs4 import BeautifulSoup

url = "https://yandex.ru/search/?text=python%20парсинг"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

results = soup.find_all('li', class_='serp-item')

for result in results:

title = result.find('h2').text

link = result.find('a')['href']

print(f"Title: {title}\nLink: {link}\n")

Этот код позволяет получить список заголовков и ссылок на страницы, представленные в результатах поиска. Однако следует помнить, что Яндекс может изменять структуру страниц, поэтому важно следить за актуальностью парсинга и обновлять код в случае изменений.

Настройка окружения для парсинга поисковой выдачи Яндекса

Для начала работы с парсингом поисковой выдачи Яндекса необходимо подготовить рабочее окружение. Это включает установку необходимых библиотек, настройку прокси-сервера и подготовку к эффективному обходу системы защиты от ботов.

Для парсинга Яндекса потребуется следующие компоненты:

- Python 3.8 и выше

- Библиотеки для HTTP-запросов и парсинга HTML

- Инструменты для работы с прокси-серверами

Перейдем к настройке окружения поэтапно:

1. Установка Python

Убедитесь, что на вашем компьютере установлен Python версии 3.8 или выше. Для этого выполните команду в терминале:

python --version

Если Python не установлен, его можно скачать с официального сайта python.org и следовать инструкциям для вашей операционной системы.

2. Установка необходимых библиотек

Для работы с Яндексом используем библиотеки requests для отправки запросов и BeautifulSoup из пакета bs4 для парсинга HTML. Установим их через pip:

pip install requests beautifulsoup4

Дополнительно может потребоваться библиотека для работы с прокси-серверами, например, requests поддерживает работу с прокси через параметр proxies.

3. Работа с прокси

Яндекс применяет различные меры защиты от ботов, включая ограничение на количество запросов с одного IP-адреса. Для обхода этого ограничения рекомендуется использовать прокси-серверы. Прокси можно как покупать, так и использовать бесплатные, но они могут быть менее стабильными.

Для использования прокси с библиотекой requests можно передавать параметр proxies в запрос:

proxies = {

'http': 'http://user:password@proxy_address:port',

'https': 'http://user:password@proxy_address:port'

}

response = requests.get(url, proxies=proxies)

Если у вас нет прокси, можно воспользоваться сервисами, предоставляющими их в аренду.

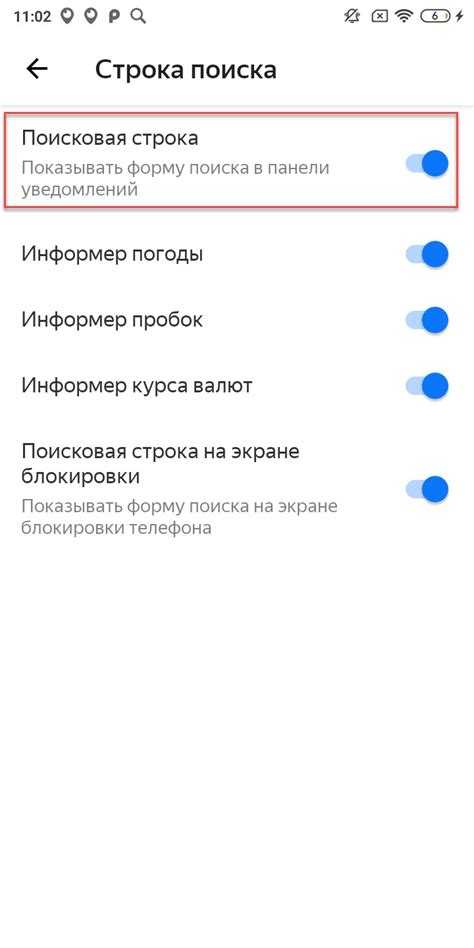

4. Настройка User-Agent

Для имитации действий настоящего пользователя необходимо изменить заголовок User-Agent, так как Яндекс может заблокировать запросы с подозрительным или пустым User-Agent. В запросе к Яндексу нужно указать свой User-Agent:

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

response = requests.get(url, headers=headers)

Вы можете использовать любой актуальный User-Agent, который применяется в современных браузерах. Например, можно взять строку из инструментов разработчика вашего браузера.

5. Обработка Captcha

Если Яндекс определит, что запросы отправляются ботом, он может попросить пройти Captcha. В таких случаях можно применить сервисы для автоматического распознавания Captcha или использовать механизмы обхода, например, через API анти-Captcha сервисов.

Настройка окружения для парсинга поисковой выдачи Яндекса требует внимательности к деталям, поскольку Яндекс активно защищает свои страницы от автоматизированных запросов. Правильная настройка библиотеки для отправки запросов, использование прокси и создание уникальных User-Agent заголовков значительно повышает шансы на успешный парсинг.

Использование библиотеки BeautifulSoup для парсинга HTML-кода

BeautifulSoup – одна из самых популярных библиотек Python для парсинга HTML и XML документов. Она предоставляет удобные методы для поиска и извлечения данных из HTML-страниц, что делает её незаменимой при работе с веб-скрапингом, включая парсинг поисковой выдачи Яндекса.

Основное преимущество BeautifulSoup – это простота работы с веб-страницами, даже если их HTML-код имеет ошибки. Библиотека автоматически пытается исправить некорректный код, обеспечивая стабильную работу с большинством страниц.

Для начала работы необходимо установить библиотеку с помощью команды:

pip install beautifulsoup4После установки библиотека подключается в проект следующим образом:

from bs4 import BeautifulSoupДля парсинга HTML-страницы сначала нужно получить её содержимое. Это можно сделать с помощью библиотеки requests:

import requests

response = requests.get('https://example.com')

html_content = response.textЗатем создаём объект BeautifulSoup, который позволяет работать с HTML-кодом страницы:

soup = BeautifulSoup(html_content, 'html.parser')Теперь можно использовать различные методы для извлечения данных. Например, для поиска всех ссылок на странице используем метод find_all:

links = soup.find_all('a')

for link in links:

print(link.get('href'))Для извлечения данных по CSS-классу можно использовать атрибут class_. Например, чтобы получить все заголовки с классом «title»:

titles = soup.find_all('h2', class_='title')

for title in titles:

print(title.text)Если нужно найти один элемент, например, первый заголовок с классом «headline», используем метод find:

headline = soup.find('h1', class_='headline')

print(headline.text)Для работы с атрибутами HTML-элементов используем метод get. Например, чтобы получить значение атрибута href у первой ссылки:

first_link = soup.find('a')

href_value = first_link.get('href')

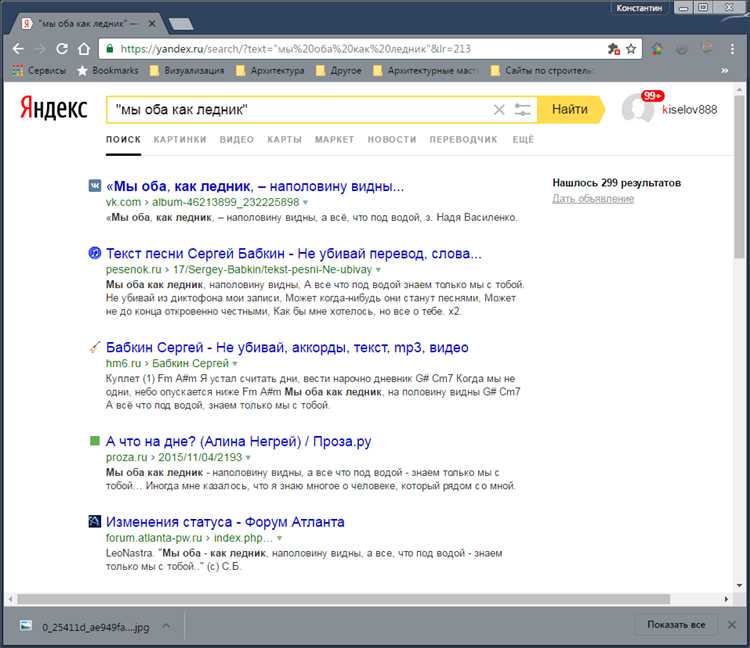

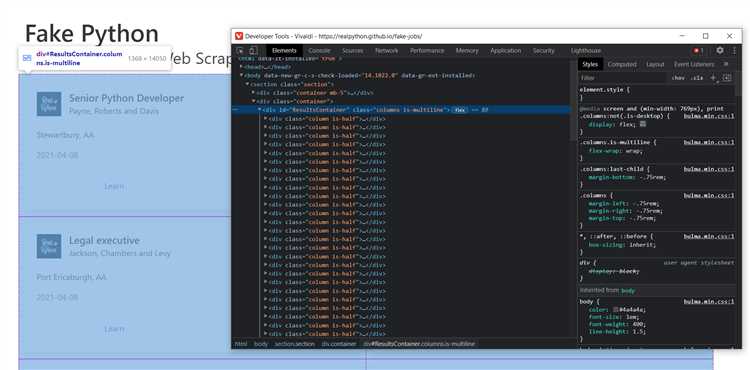

print(href_value)Особенности работы с поисковой выдачей Яндекса заключаются в том, что HTML-код на этих страницах часто содержит динамически загружаемые данные. В таких случаях может потребоваться дополнительная настройка с использованием Selenium для эмуляции браузера или анализ JS-ответов через API.

Также, для упрощения поиска, можно использовать CSS-селекторы через метод select. Например, чтобы выбрать все элементы с классом «serp-item»:

serp_items = soup.select('.serp-item')

for item in serp_items:

print(item.text)Для парсинга данных с Яндекса важно учитывать особенности HTML-структуры страниц, такие как изменение структуры в зависимости от региона или наличия рекламы. Рекомендуется тестировать код на нескольких страницах, чтобы минимизировать вероятность ошибок при изменении структуры.

Извлечение результатов поиска с использованием XPath и регулярных выражений

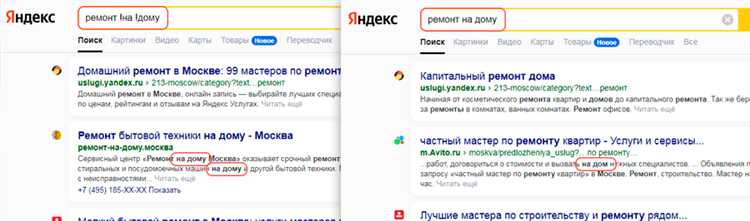

Для точного парсинга поисковой выдачи Яндекса необходимо комбинировать XPath и регулярные выражения, поскольку структура HTML может меняться, а атрибуты классов – быть динамически сгенерированы.

XPath позволяет находить элементы по иерархии. Пример выражения для извлечения заголовков результатов: //a[contains(@href, '/search/') and @target='_blank']/text(). Оно выбирает ссылки на страницы из выдачи, игнорируя рекламу и навигационные блоки.

Чтобы получить URL результата, используйте: //a[contains(@href, '/search/') and @target='_blank']/@href. Для обхода редиректов используйте urllib.parse для разбора параметров ссылок, содержащих промежуточный трекер.

Регулярные выражения применяются для извлечения ID документов, фильтрации по ключевым словам и устранения шумов. Например, для выделения домена из URL: re.search(r'https?://([^/]+)', url).group(1).

Если структура блока результатов меняется, используйте относительный XPath с привязкой к текстовым признакам: //div[contains(., 'Найдено')]/following::a[1]. Это увеличивает устойчивость к изменению классов.

Совмещая XPath и регулярные выражения, можно обрабатывать даже нестабильные участки разметки. Сначала локализуйте фрагмент с помощью XPath, затем применяйте re к текстовому содержимому или атрибутам.

Для устойчивости парсинга обязательно используйте заголовки User-Agent и ограничение частоты запросов. Без соблюдения этих условий возможны блокировки и выдача капчи вместо HTML-документа.

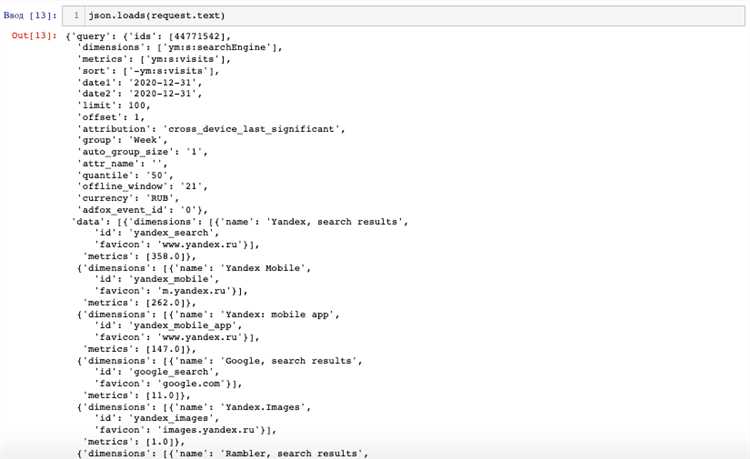

Работа с API Яндекса для получения данных о поисковой выдаче

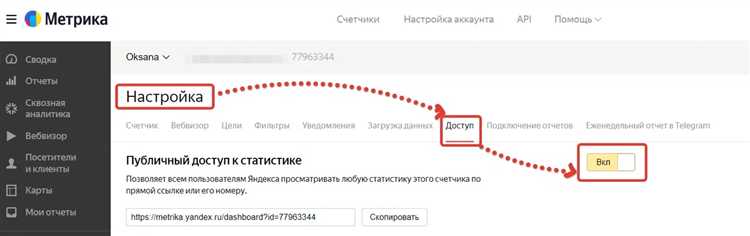

Для получения поисковой выдачи Яндекса через официальные средства используется API Яндекс.XML. Этот интерфейс позволяет выполнять поисковые запросы и получать структурированный XML-ответ, пригодный для дальнейшей обработки на Python.

Чтобы начать работу:

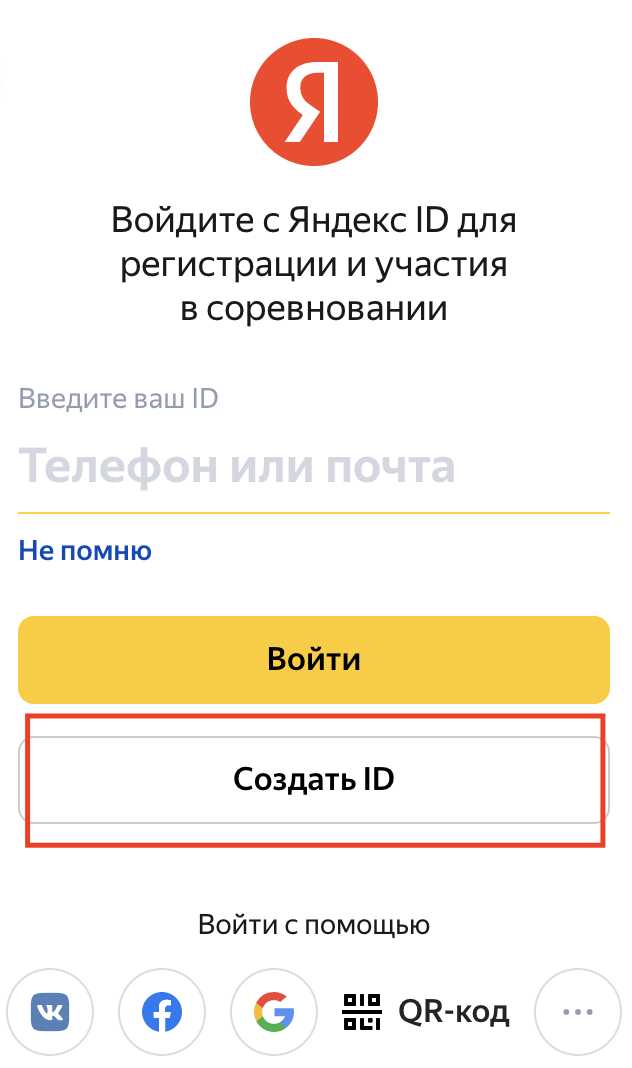

- Зарегистрируйтесь на xml.yandex.ru и получите уникальный ключ доступа (user и key).

- Настройте лимиты: по умолчанию доступно 10 000 запросов в сутки, но можно подать заявку на расширение.

Пример базового запроса:

https://yandex.ru/search/xml?user=ВАШ_ЮЗЕР&key=ВАШ_КЛЮЧ&query=python+парсинг&l10n=ru&sortby=rlv&filter=none

Рекомендуется использовать параметры:

- l10n – локализация, указывайте

ruдля русскоязычной выдачи; - sortby – сортировка,

rlvозначает релевантность,tm– по времени; - filter – можно отключить фильтрацию результатов, передав

none.

Пример обработки ответа на Python с использованием библиотеки xml.etree.ElementTree:

import requests

import xml.etree.ElementTree as ET

url = "https://yandex.ru/search/xml"

params = {

"user": "ВАШ_ЮЗЕР",

"key": "ВАШ_КЛЮЧ",

"query": "python парсинг",

"l10n": "ru",

"sortby": "rlv",

"filter": "none"

}

response = requests.get(url, params=params)

root = ET.fromstring(response.text)

for doc in root.findall(".//doc"):

title = doc.findtext("title")

url = doc.findtext("url")

print(f"{title} - {url}")

Практические рекомендации:

- Учитывайте ограничения по частоте запросов – не более одного запроса в секунду.

- Следите за кодами ошибок: 403 означает превышение лимита, 502 – временные проблемы на стороне сервера.

- Кэшируйте результаты – это снизит нагрузку на API и ускорит обработку.

- Для масштабируемости используйте очередь запросов и ротацию аккаунтов, если лимитов одного недостаточно.

API Яндекс.XML – единственный официально разрешённый способ автоматического получения поисковой выдачи. Парсинг HTML-страниц выдачи нарушает условия использования и может привести к блокировке IP.

Обработка и фильтрация данных из поисковой выдачи Яндекса

Для парсинга поисковой выдачи Яндекса важно не только извлечь нужные данные, но и правильно их обработать и отфильтровать. На этом этапе решается, какие именно результаты будут полезны для дальнейшей работы, а какие можно отбросить.

1. Структурирование данных – первым шагом после извлечения данных с веб-страницы является их структурирование. Результаты поиска могут быть представлены в виде списка ссылок, заголовков, описаний и дополнительных меток, таких как рейтинги, рекламные блоки и прочее. Для этого следует использовать парсеры, такие как BeautifulSoup или lxml, которые позволяют извлекать нужные элементы по их CSS-классам или id.

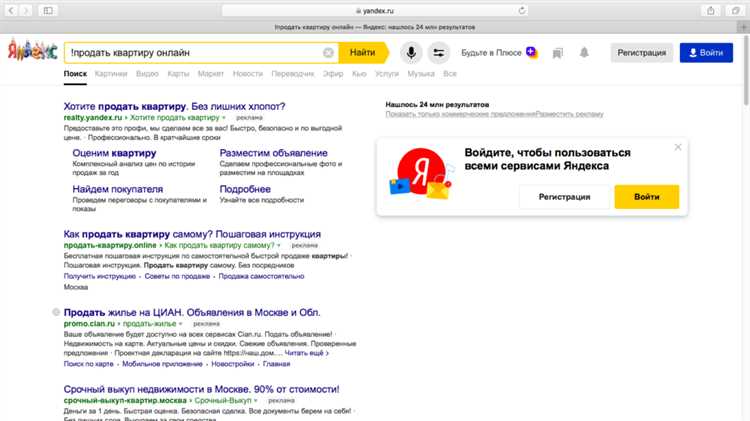

2. Фильтрация по типам результатов – часто поисковая выдача Яндекса включает как органические результаты, так и рекламные ссылки. Для отсеивания ненужных элементов можно фильтровать страницы по наличию определённых классов или тегов. Например, блоки с рекламой обычно имеют класс ads или содержат атрибуты типа noindex, что позволяет быстро исключить их из обработки.

3. Очистка от неактуальной информации – важно учитывать, что поисковая выдача может содержать старые, устаревшие или нерелевантные ссылки. Для этого можно использовать фильтрацию по дате публикации или обновления страницы, если такие данные имеются. Также стоит проверять мета-теги и заголовки страниц на наличие ключевых слов, чтобы убедиться, что они соответствуют запросу.

4. Удаление дублей – иногда Яндекс может возвращать одинаковые или схожие результаты с разных источников. Для удаления дублирующихся ссылок стоит использовать алгоритмы сравнения строк, например, Levenshtein distance, или простое сравнение URL. Это позволяет очистить результаты и оставить только уникальные страницы.

5. Работа с частичными данными – не всегда возможно получить полную информацию о сайте сразу. Некоторые данные могут быть доступны лишь на следующей странице или в других частях веб-страницы. Для этого можно использовать динамический парсинг с помощью библиотек, таких как Selenium или Playwright, которые позволяют работать с JavaScript-контентом и загружать элементы по мере необходимости.

6. Использование регулярных выражений – для извлечения специфических данных, например, цен, дат или других числовых значений, можно применять регулярные выражения. Это особенно полезно, когда необходимо вычленить только числовые данные или структурированные данные, такие как адреса, телефоны или email-адреса.

Эти методы помогут организовать эффективную обработку и фильтрацию данных из поисковой выдачи Яндекса, обеспечивая точность и релевантность информации, которую вы получаете для дальнейшего анализа или использования в проектах.

Решение проблемы с блокировками при парсинге поисковой выдачи

При парсинге поисковой выдачи Яндекса часто возникает проблема с блокировками, направленными на предотвращение автоматизированного доступа к данным. Чтобы избежать этих блокировок, важно учитывать несколько факторов, влияющихся на обнаружение и ограничение работы бота.

Основная причина блокировок – это высокая частота запросов с одного IP-адреса, что вызывает подозрения у системы безопасности Яндекса. Один из способов решения проблемы – использование прокси-серверов. Прокси меняют IP-адрес, что позволяет распределить нагрузку на несколько источников и избежать срабатывания механизмов защиты. Для эффективного использования прокси важно подключать их из разных географических локаций, чтобы минимизировать риски для всех запросов.

Кроме того, стоит обратить внимание на использование HTTP-заголовков. Яндекс анализирует такие параметры, как «User-Agent», «Referer» и «Accept-Language». Рекомендуется подбирать случайные значения для этих заголовков или использовать те, которые соответствуют обычным запросам пользователей. Это поможет обмануть систему защиты и снизить вероятность блокировки.

Одним из полезных методов является использование «обратных задержек» между запросами. Вместо того чтобы отправлять запросы подряд, можно внедрить случайные задержки между ними. Например, задержки в диапазоне от 1 до 5 секунд создают видимость человеческой активности, что снижает вероятность блокировки.

Также следует учитывать возможность парсинга через API Яндекса, если цель – получить конкретные данные, такие как позиции сайтов или метаинформация. В отличие от стандартного парсинга, использование API предполагает меньший риск блокировки, так как оно осуществляется в рамках официальных инструментов Яндекса, а также предоставляет структуру данных в удобном формате.

Важный момент – необходимость обрабатывать ошибки и лимиты. Яндекс может ограничивать количество запросов с одного источника за определенный промежуток времени. Для этого можно использовать стратегию повторных попыток с увеличением интервала между запросами, что помогает избежать срабатывания ограничений.

В случае более серьезных блокировок или CAPTCH, следует использовать автоматические решения для распознавания таких изображений или внедрять алгоритмы обхода CAPTCHA с помощью сервисов третьих сторон, например, 2Captcha.

Сохранение и анализ данных: создание отчётов и графиков на Python

После того как данные поисковой выдачи Яндекса собраны, важно грамотно их сохранить и провести анализ. Для этого на Python доступны мощные инструменты для обработки и визуализации данных. Рассмотрим ключевые этапы этого процесса.

1. Сохранение данных

Наиболее удобным форматом для хранения результатов парсинга является JSON или CSV. JSON идеально подходит для структурированных данных, таких как результаты поиска, где каждый элемент может содержать вложенные данные. В то время как CSV удобен для таблиц с упорядоченными данными. Для сохранения данных можно использовать стандартные библиотеки Python: json и csv.

import json

data = [{"title": "Пример заголовка", "url": "https://example.com"}, {"title": "Другой заголовок", "url": "https://another.com"}]

with open('output.json', 'w', encoding='utf-8') as f:

json.dump(data, f, ensure_ascii=False, indent=4)

2. Подготовка данных для анализа

Для анализа важно предварительно обработать данные: очистить от лишней информации, устранить дубликаты и преобразовать типы данных. Для этих задач удобно использовать библиотеку pandas. Она позволяет работать с данными в виде DataFrame, что значительно ускоряет их обработку и анализ.

import pandas as pd

# Загрузка данных из JSON

df = pd.read_json('output.json')

# Удаление дубликатов

df = df.drop_duplicates(subset='url')

# Преобразование в нужный формат

df['date'] = pd.to_datetime(df['date'])

3. Визуализация данных с помощью Matplotlib

Для создания графиков и диаграмм, на Python часто используется библиотека Matplotlib. Она позволяет легко создавать линейные графики, гистограммы и круговые диаграммы. Например, для отображения частоты появления определённых ключевых слов в результатах поиска можно построить гистограмму.

import matplotlib.pyplot as plt

# Пример данных

keywords = ['Python', 'Java', 'JavaScript', 'Ruby', 'PHP']

frequencies = [10, 7, 15, 5, 3]

# Построение графика

plt.bar(keywords, frequencies)

plt.xlabel('Языки программирования')

plt.ylabel('Частота')

plt.title('Частота упоминания языков программирования в поисковой выдаче')

plt.show()

4. Генерация отчётов с использованием Jupyter

5. Автоматизация создания отчётов

Для автоматизации генерации отчетов можно использовать библиотеку ReportLab для создания PDF-документов. В сочетании с аналитикой и графиками Python, можно составлять отчёты о результатах парсинга, которые будут удобно структурированы и предоставлены в профессиональном виде.

from reportlab.lib.pagesizes import letter from reportlab.pdfgen import canvas pdf_file = "report.pdf" c = canvas.Canvas(pdf_file, pagesize=letter) c.drawString(100, 750, "Отчёт о парсинге поисковой выдачи Яндекса") c.save()

Такая автоматизация позволяет не только собирать и анализировать данные, но и создавать структурированные отчёты без необходимости вручную форматировать результаты. Всё это делает процесс обработки и анализа данных поисковой выдачи эффективным и масштабируемым.

Вопрос-ответ:

Как можно использовать Python для парсинга поисковой выдачи Яндекса?

Для парсинга поисковой выдачи Яндекса на Python можно использовать библиотеки, такие как `requests` для отправки HTTP-запросов и `BeautifulSoup` для обработки HTML-страниц. Необходимо отправить запрос к поисковой системе Яндекс, а затем с помощью BeautifulSoup извлечь нужные данные, такие как ссылки, заголовки или описания результатов поиска. Важно учитывать, что Яндекс имеет защиту от ботов, поэтому для получения стабильных результатов может понадобиться использование прокси-серверов или установка задержек между запросами.

Нужно ли использовать прокси при парсинге Яндекса с помощью Python?

Да, использование прокси-серверов может быть полезным, так как Яндекс активно защищается от массовых автоматических запросов. Без прокси или использования других методов обхода блокировок Яндекс может заблокировать IP-адрес, с которого поступает слишком много запросов. Прокси позволяют избежать таких блокировок, особенно если нужно сделать много запросов за короткий период времени.

Какие библиотеки Python лучше всего подходят для парсинга данных с поисковой выдачи Яндекса?

Для парсинга поисковой выдачи Яндекса чаще всего используются следующие библиотеки: `requests` — для отправки HTTP-запросов, `BeautifulSoup` или `lxml` — для парсинга HTML-страниц, а также `Selenium`, если нужно работать с динамическими элементами, которые загружаются JavaScript. Selenium полезен, когда результаты поиска подгружаются после выполнения JavaScript-кода, что делает их недоступными для стандартного парсинга через `BeautifulSoup`.

Как избежать блокировки при парсинге поисковой выдачи Яндекса?

Для предотвращения блокировки при парсинге поисковой выдачи Яндекса можно использовать несколько методов. Во-первых, можно установить задержку между запросами, чтобы не перегружать сервер Яндекса и не вызывать подозрения. Во-вторых, можно использовать прокси-серверы, чтобы распределить запросы по разным IP-адресам. Третий способ — использование ротации User-Agent, чтобы каждый запрос выглядел как запрос от разных пользователей. Также стоит внимательно следить за частотой запросов, чтобы не превышать разумные лимиты.

Можно ли парсить Яндекс без использования API?

Да, можно парсить поисковую выдачу Яндекса без использования API, обращаясь напрямую к HTML-странице поисковых результатов. Однако, стоит помнить, что это может нарушать правила использования Яндекса, и система может заблокировать доступ или ограничить количество запросов с одного IP-адреса. Для парсинга нужно будет правильно обрабатывать HTML-код страницы, извлекая необходимые элементы с помощью таких библиотек, как `BeautifulSoup` или `lxml`.

Что такое парсинг поисковой выдачи Яндекса и зачем его использовать?

Парсинг поисковой выдачи Яндекса — это процесс извлечения данных с поисковой страницы Яндекса с использованием программных средств. С помощью парсинга можно собирать информацию о результатах поиска по определённым запросам, таких как ссылки на сайты, их описание, метаданные и другие элементы. Это полезно для анализа позиций сайтов в поисковой выдаче, изучения конкурентов, мониторинга изменений в результатах поиска и сбора статистики для SEO-оптимизации.