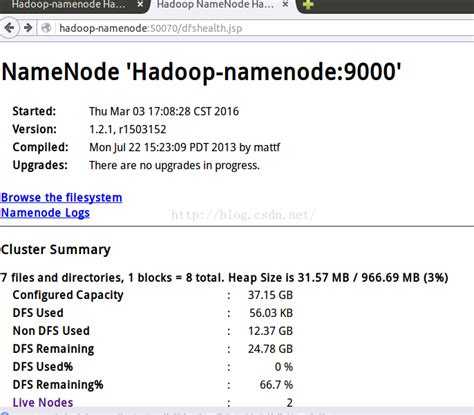

Работа с Hadoop предполагает предварительное размещение данных в распределённой файловой системе HDFS. На практике часто возникает задача автоматизировать этот процесс с помощью Python. Библиотека hdfs из пакета hdfs3 или pyarrow позволяет взаимодействовать с HDFS через WebHDFS или libhdfs. Подключение к кластеру обычно выполняется через указание URI NameNode и, при необходимости, Kerberos-аутентификацию.

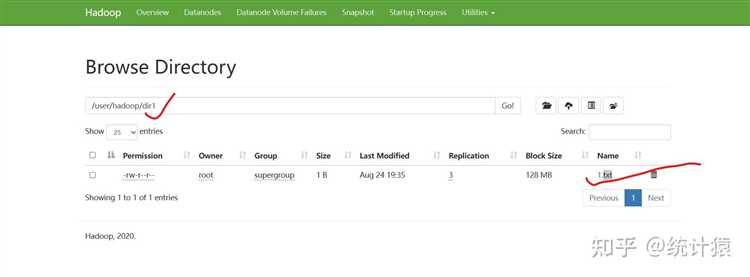

Для загрузки файлов из локальной файловой системы в HDFS можно использовать метод upload() из клиента InsecureClient библиотеки hdfs. Он поддерживает как передачу одиночных файлов, так и загрузку целых директорий с рекурсией. Важно заранее убедиться в наличии прав на запись в целевую директорию HDFS и достаточном количестве свободного места в блоках кластера.

Если объём данных превышает несколько гигабайт, стоит рассмотреть построчную или блочную передачу с помощью потоков. Это снижает нагрузку на оперативную память и позволяет обрабатывать данные «на лету», применяя фильтрацию или преобразования прямо в момент загрузки. Такой подход особенно полезен при работе с логами или CSV-файлами большого размера.

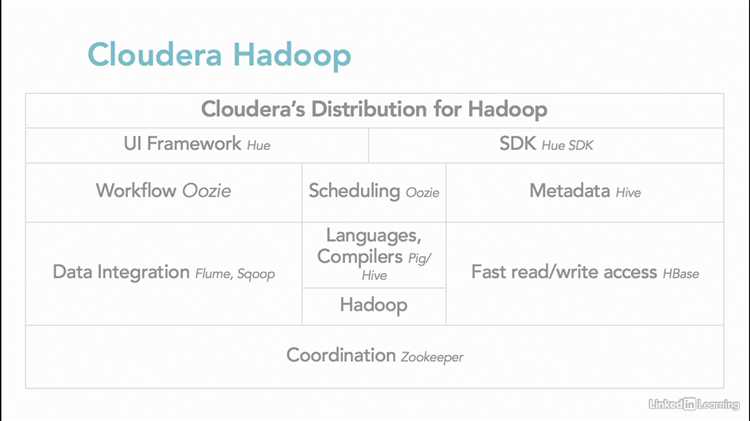

Python также позволяет интегрировать загрузку данных в более широкий ETL-процесс. Например, с помощью библиотек pandas и pyarrow можно сначала обработать данные, сериализовать их в формат Parquet, а затем загрузить в HDFS. Это даёт выигрыш в скорости последующего анализа с использованием Apache Hive или Spark.

При работе в защищённой среде с Kerberos требуется конфигурация окружения и явный вызов kinit до запуска Python-скрипта. Также необходимо установить переменные среды HADOOP_CONF_DIR и JAVA_HOME, чтобы клиент мог найти конфигурацию HDFS и подключиться через libhdfs.

Подготовка входных данных для загрузки в HDFS

Перед загрузкой данных в HDFS необходимо убедиться, что файлы соответствуют требованиям файловой системы Hadoop. HDFS оптимизирован для работы с крупными файлами, поэтому мелкие файлы следует агрегировать. Используйте архивирование или объединение через скрипты Python с использованием стандартных модулей, таких как os и shutil.

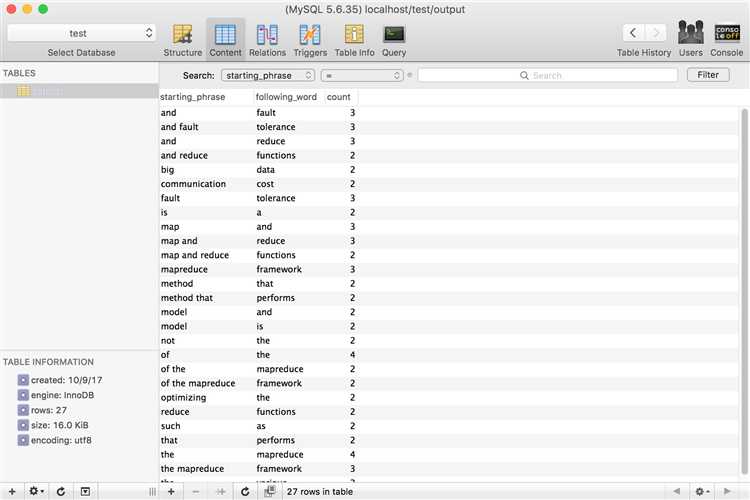

Формат данных должен быть согласован с предполагаемым способом обработки. Для последующей работы с Apache Hive, предпочтительнее использовать CSV или Parquet. Файлы CSV должны быть без BOM, с однородной кодировкой (UTF-8) и единым разделителем. Недопустимы пустые строки и пропущенные заголовки. Для формата Parquet можно использовать библиотеку pyarrow или pandas с to_parquet().

Имена файлов не должны содержать пробелов и специальных символов. Рекомендуется использовать нижний регистр и подчёркивания. Убедитесь, что структура каталогов согласована с логикой последующей обработки. Например, данные по дате можно размещать в папках /data/yyyy/mm/dd/.

Удалите временные или частично сформированные файлы. Автоматизируйте проверку структуры данных и форматов через Python. Пример: для CSV проверьте количество столбцов и соответствие типов с ожидаемыми схемами, используя csv.reader и type().

Если данные получены из внешних источников, нормализуйте их перед сохранением. Удалите лишние пробелы, приведение к нижнему регистру, единый формат даты. Для логов применяйте регулярные выражения с модулем re для выделения нужных полей и построения структурированных записей.

После подготовки загрузите данные в локальный каталог, с которого будет производиться копирование в HDFS через hdfs dfs -put или Python-библиотеки, такие как hdfs или pyarrow.fs.HadoopFileSystem.

Настройка окружения Python для работы с Hadoop

Установите Hadoop локально или подключитесь к удалённому кластеру. Убедитесь, что переменные среды HADOOP_HOME и PATH корректно настроены: export HADOOP_HOME=/opt/hadoop и export PATH=$PATH:$HADOOP_HOME/bin.

Проверьте наличие установленного Java, так как Hadoop требует Java Runtime Environment. Используйте java -version для проверки. Если требуется, установите OpenJDK: sudo apt install openjdk-11-jdk.

Создайте изолированное виртуальное окружение Python: python3 -m venv hadoop-env. Активируйте его: source hadoop-env/bin/activate. Это исключит конфликт версий библиотек.

Установите PyArrow и Hadoop-Bin, если планируется работа с HDFS напрямую: pip install pyarrow hdfs. Для взаимодействия с WebHDFS – pip install requests.

Если используется Snakebite (клиент HDFS на Python), убедитесь, что версия Hadoop не выше 2.x. Установка: pip install snakebite. Для новых версий Hadoop предпочтительнее использовать библиотеку hdfs.

Проверьте доступ к HDFS с помощью Python-кода. Пример подключения с использованием библиотеки hdfs:

from hdfs import InsecureClient

client = InsecureClient('http://namenode-host:50070', user='hadoopuser')

client.list('/')

Если используется PySpark для интеграции с Hadoop, установите его через pip install pyspark и настройте переменные SPARK_HOME и PYSPARK_PYTHON.

Тестируйте соединение с HDFS до написания логики загрузки данных. Ошибки на этом этапе обычно связаны с неверным указанием хоста NameNode или портов (50070 для WebHDFS, 8020 для RPC).

Использование библиотеки hdfs для записи файлов в HDFS

Библиотека hdfs предоставляет простой интерфейс для взаимодействия с Hadoop Distributed File System через WebHDFS. Установка выполняется через pip:

pip install hdfsПодключение к HDFS осуществляется через объект InsecureClient. Пример инициализации:

from hdfs import InsecureClient

client = InsecureClient('http://namenode-host:50070', user='hdfs')

Для записи локального файла в HDFS используется метод upload:

client.upload('/user/hdfs/target_dir', '/local/path/file.csv', overwrite=True)Если необходимо записать данные напрямую из Python, можно использовать контекстный менеджер с методом write:

with client.write('/user/hdfs/data.txt', encoding='utf-8', overwrite=True) as writer:

writer.write('строка данных\n')

Рекомендации:

- Указывайте

overwrite=True, если важна перезапись без ошибок. - Проверяйте наличие целевой директории в HDFS до загрузки – библиотека не создаёт её автоматически.

- Для больших файлов предпочтительнее использовать

upload, так как он оптимизирован для потоковой передачи. - Убедитесь, что WebHDFS активирован и порт 50070 (или соответствующий) доступен.

Для чтения файлов используется метод read с поддержкой декодирования:

with client.read('/user/hdfs/data.txt', encoding='utf-8') as reader:

content = reader.read()

Прямое взаимодействие с WebHDFS через requests

Для отправки файлов в HDFS через WebHDFS используется протокол HTTP с пошаговым выполнением операций. Библиотека requests в Python позволяет реализовать это без дополнительных обёрток.

Сначала необходимо получить redirect-ссылку для загрузки файла. Пример запроса:

import requests

namenode_host = "http://namenode.example.com:50070"

hdfs_path = "/user/hadoop/example.txt"

params = {

"op": "CREATE",

"overwrite": "true"

}

url = f"{namenode_host}/webhdfs/v1{hdfs_path}"

response = requests.put(url, params=params, allow_redirects=False)

redirect_url = response.headers["Location"]

Затем выполняется фактическая передача содержимого:

with open("example.txt", "rb") as f:

upload_response = requests.put(redirect_url, data=f)

Для чтения данных из HDFS используется операция OPEN:

params = {"op": "OPEN"}

response = requests.get(f"{namenode_host}/webhdfs/v1{hdfs_path}", params=params, stream=True)

with open("downloaded_example.txt", "wb") as f:

for chunk in response.iter_content(chunk_size=8192):

f.write(chunk)

Для удаления файла используется операция DELETE:

params = {"op": "DELETE"}

response = requests.delete(f"{namenode_host}/webhdfs/v1{hdfs_path}", params=params)

Аутентификация может потребовать указания пользователя в параметре user.name. Пример:

params = {

"op": "LISTSTATUS",

"user.name": "hadoop"

}

response = requests.get(f"{namenode_host}/webhdfs/v1/user/hadoop/", params=params)

WebHDFS не поддерживает автоматическую сериализацию данных, поэтому контроль кодировок и структуры ложится на клиента. Для JSON или CSV перед загрузкой необходимо привести данные к байтовому представлению.

Автоматизация загрузки с помощью Python-скриптов

Для автоматизированной загрузки данных в Hadoop чаще всего используется комбинация Python и утилит Hadoop, таких как `hdfs dfs` или REST-интерфейсы WebHDFS и HttpFS. Один из подходов – использовать библиотеку `subprocess` для вызова системных команд, обеспечивающих копирование данных в HDFS.

Пример скрипта, копирующего локальный файл в HDFS:

import subprocess

local_path = "/data/input.csv"

hdfs_path = "/user/hadoop/input/input.csv"

cmd = ["hdfs", "dfs", "-put", "-f", local_path, hdfs_path]

result = subprocess.run(cmd, capture_output=True, text=True)

if result.returncode != 0:

raise RuntimeError(f"Ошибка загрузки: {result.stderr}")

Для работы с WebHDFS можно использовать библиотеку `requests`. Пример загрузки файла по HTTP PUT-запросу:

import requests

namenode = "http://namenode.example.com:50070"

path = "/user/hadoop/input/input.csv"

local_file = "/data/input.csv"

init_url = f"{namenode}/webhdfs/v1{path}?op=CREATE&overwrite=true"

res = requests.put(init_url, allow_redirects=False)

if "Location" not in res.headers:

raise RuntimeError("Не получен redirect на загрузку")

upload_url = res.headers["Location"]

with open(local_file, "rb") as f:

res = requests.put(upload_url, data=f)

if res.status_code != 201:

raise RuntimeError(f"Ошибка при загрузке: {res.content}")

Рекомендуется интегрировать логирование (`logging`), обрабатывать исключения и использовать параметры командной строки (`argparse`) для повышения гибкости скриптов. Планировщики, такие как cron или Apache Airflow, позволяют запускать загрузку по расписанию или при наступлении определённых событий.

Для массовой загрузки данных стоит предусмотреть проверку контрольных сумм (например, через `hashlib`) до и после передачи, чтобы убедиться в целостности. Также полезно реализовать переименование или перемещение исходных файлов после успешной загрузки, чтобы избежать повторной обработки.

Загрузка больших объёмов данных по частям

При работе с большими объёмами данных в Hadoop часто возникает необходимость загрузки информации по частям для уменьшения нагрузки на систему и предотвращения сбоев. Один из подходов заключается в использовании библиотеки PyArrow для эффективной работы с большими данными. Этот метод позволяет разделить данные на небольшие порции и загружать их поочередно в HDFS (Hadoop Distributed File System), что улучшает производительность и снижает вероятность ошибок при перегрузке.

Для начала стоит убедиться, что данные в исходном формате разбиты на части, которые могут быть загружены поэтапно. Один из способов – это разделение данных на файлы определённого размера (например, по 100 МБ). В Python для этого удобно использовать функции генераторов, которые позволяют обрабатывать данные построчно или порционно, без загрузки всего объёма в память.

Для загрузки данных можно воспользоваться модулем PySpark. Пример кода для загрузки данных по частям через PySpark с использованием разделения на блоки:

from pyspark import SparkContext, SparkConf

conf = SparkConf().setAppName("DataLoading")

sc = SparkContext(conf=conf)

# Разделение данных на блоки

rdd = sc.textFile("path_to_large_data.txt")

# Функция для обработки данных по частям

def process_chunk(chunk):

# Здесь можно выполнить обработку данных перед загрузкой в Hadoop

return chunk

# Обработка данных по частям и загрузка в HDFS

rdd.mapPartitions(process_chunk).saveAsTextFile("hdfs://path_to_save_data")

Этот код делит исходный файл на части и обрабатывает каждую партицию отдельно, что позволяет эффективно работать с большими файлами. Для управления размером каждой части можно варьировать количество данных, обрабатываемых в каждой итерации, используя методы настройки параметров Spark, такие как «spark.default.parallelism».

Важно также учитывать тип данных, которые загружаются. Например, для числовых данных, текстов или CSV-файлов процесс загрузки может отличаться в зависимости от способа их предварительной обработки. Для оптимизации можно использовать компрессию данных в форматах, поддерживающих хранение и передачу больших объёмов информации (например, Parquet или ORC), что сократит время загрузки и уменьшит использование дискового пространства.

Кроме того, загрузка по частям помогает управлять ошибками. Если в процессе загрузки одной части возникает сбой, можно перезапустить только ту часть, не затрагивая остальные данные. Это минимизирует потери времени и ресурсов.

Обработка ошибок при передаче файлов в Hadoop

При передаче файлов в Hadoop с использованием Python важно учитывать потенциальные ошибки, которые могут возникнуть на разных этапах. Это включает как проблемы на стороне клиента, так и на стороне Hadoop-сервера. Приведены основные ошибки и способы их обработки.

1. Ошибки соединения с HDFS

Если соединение с HDFS не удается установить, возможны следующие причины:

- Неправильные параметры подключения: URI, порты, адреса.

- Недоступность HDFS из-за проблем в кластере или сетевых настройках.

Для их устранения:

- Проверьте правильность URI и параметры порта.

- Используйте библиотеку `hdfs` или `pyarrow` для диагностики соединения.

- Проверьте лог-файлы и статусы службы Hadoop на наличие ошибок.

2. Ошибки записи файлов

Основные проблемы при записи файлов в HDFS:

- Файл уже существует в целевой директории.

- Недостаточно прав на запись в указанную директорию.

- Невозможность выделить достаточно памяти для операции.

Как избежать:

- Перед записью используйте функцию проверки существования файла.

- Убедитесь, что у вас есть нужные права на запись.

- Используйте методы для частичной записи или распределенной записи больших файлов.

3. Проблемы с форматом данных

Не все форматы файлов могут быть корректно обработаны Hadoop. Например, при использовании Parquet или Avro важно, чтобы данные соответствовали их схемам.

Решения:

- Проверяйте соответствие данных формату перед загрузкой.

- Используйте методы в библиотеке `pyarrow` или `fastavro` для конвертации данных в нужный формат.

- Обрабатывайте исключения, которые могут возникать при чтении или записи в нестандартные форматы.

4. Ошибки при обработке больших файлов

При передаче больших файлов могут возникнуть следующие сложности:

- Превышение лимита памяти.

- Прерывание сетевого соединения.

Как решать:

- Используйте потоковую передачу данных, чтобы не загружать весь файл в память.

- Используйте механизм резильентности данных Hadoop, который позволяет восстановить передачу после сбоя.

- Рассмотрите возможность разделения больших файлов на части для параллельной загрузки.

5. Логирование и отладка

Правильная настройка логирования помогает быстро выявить причину сбоя при передаче файлов в Hadoop:

- Используйте библиотеки для ведения логов, такие как `logging` в Python, для отслеживания ошибок и исключений.

- Регулярно проверяйте системные журналы Hadoop для получения подробной информации о процессе загрузки.

- При возникновении ошибки всегда фиксируйте контекст, чтобы в будущем исключить повторение проблемы.

Проверка наличия и целостности данных в HDFS после загрузки

После завершения загрузки данных в HDFS важно проверить их наличие и целостность для предотвращения потерь или повреждений. Это можно сделать с помощью стандартных инструментов Hadoop и Python.

Для проверки наличия файлов в HDFS используйте команду hadoop fs -ls. Она позволит убедиться, что загруженные файлы действительно присутствуют в нужной директории. Пример:

hadoop fs -ls /user/hadoop/dataДля проверки целостности данных после загрузки важно использовать механизм контрольных сумм. Каждому файлу в HDFS автоматически присваивается контрольная сумма при его загрузке. Вы можете использовать команду hadoop fs -checksum, чтобы сравнить контрольные суммы на исходных и загруженных файлах. Пример:

hadoop fs -checksum /user/hadoop/data/file.txtЕсли контрольная сумма на исходном файле отличается от контрольной суммы загруженного файла, это свидетельствует о повреждении данных в процессе передачи.

Для автоматизации проверки в Python можно использовать библиотеку pyhdfs, которая предоставляет API для работы с HDFS. Пример кода для проверки наличия файла:

import pyhdfs

fs = pyhdfs.HdfsClient(hosts='namenode_host:port')

if fs.exists('/user/hadoop/data/file.txt'):

print("Файл найден")

else:

print("Файл не найден")

Для проверки целостности можно использовать механизм сравнения контрольных сумм, создав скрипт, который получит контрольные суммы файла до и после загрузки:

import pyhdfs

import hashlib

def calculate_checksum(file_path):

hash_md5 = hashlib.md5()

with open(file_path, "rb") as f:

for chunk in iter(lambda: f.read(4096), b""):

hash_md5.update(chunk)

return hash_md5.hexdigest()

local_checksum = calculate_checksum("file.txt")

fs = pyhdfs.HdfsClient(hosts='namenode_host:port')

hdfs_checksum = fs.checksum('/user/hadoop/data/file.txt')

if local_checksum == hdfs_checksum:

print("Целостность данных подтверждена")

else:

print("Ошибка в целостности данных")

При обнаружении несоответствий, следует провести повторную загрузку данных, учитывая возможные проблемы в сети или на стороне Hadoop.

Вопрос-ответ:

Какие способы загрузки данных в Hadoop существуют с использованием Python?

Существует несколько методов загрузки данных в Hadoop с помощью Python. Один из самых распространенных — это использование библиотеки PyArrow, которая предоставляет интерфейс для взаимодействия с HDFS (Hadoop Distributed File System). Также можно использовать библиотеку `hdfs` для работы с файлами в HDFS, отправляя данные через Python. Кроме того, широко применяются такие инструменты, как Apache Sqoop (для импорта и экспорта данных из реляционных баз данных) и PySpark для обработки больших объемов данных и их передачи в HDFS.