Для сохранения веб-страницы на локальный диск достаточно получить её исходный HTML-код. Это позволяет работать с содержимым офлайн, анализировать структуру сайта или использовать данные в других проектах. Простое нажатие Ctrl+S в браузере сохраняет не только HTML, но и ресурсы, что не всегда удобно для последующего анализа.

Оптимальный способ – использовать инструменты командной строки. В curl достаточно ввести команду curl https://example.com -o index.html, чтобы сохранить страницу без лишних файлов. Альтернатива – wget, который поддерживает рекурсивную загрузку и позволяет сохранять сайт с зависимостями с помощью параметра —mirror.

Для разработчиков полезно использовать встроенные средства браузеров. В Chrome можно открыть DevTools (F12), перейти на вкладку Network, обновить страницу и кликнуть по первому запросу типа document, чтобы скопировать или экспортировать HTML.

Если необходимо извлечь только текст или специфические теги, применяются парсеры. Например, BeautifulSoup для Python позволяет загрузить страницу и вытащить нужные элементы через понятный API. Это актуально, когда интересует не весь HTML, а его отдельные части.

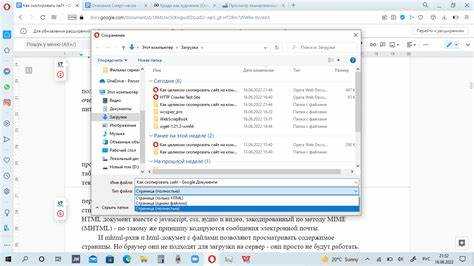

Как сохранить HTML страницу через браузер

Для сохранения HTML-страницы используйте встроенные функции браузера. В Google Chrome, Mozilla Firefox, Microsoft Edge и других современных браузерах процесс схож.

Алгоритм действий:

- Откройте нужную веб-страницу.

- Нажмите Ctrl + S (на macOS – Cmd + S).

- В появившемся окне выберите папку для сохранения.

- В поле «Тип файла» выберите один из двух вариантов:

- Веб-страница, полностью – сохраняется HTML-файл и папка со всеми ресурсами (изображения, стили, скрипты).

- Веб-страница, только HTML – сохраняется только структура страницы без внешних файлов.

- Нажмите «Сохранить».

Для офлайн-доступа рекомендуется вариант «полностью», так как он сохраняет все необходимые элементы для корректного отображения.

Особенности:

- Файлы ресурсов сохраняются в отдельной папке с тем же именем, что и HTML-файл.

- Если страница построена на JavaScript, не все элементы могут сохраниться корректно.

- Динамически подгружаемые данные (через AJAX) не сохраняются – необходимы инструменты типа WebScraper или расширения с поддержкой JavaScript-захвата.

Если требуется сохранить страницу в неизменном виде для документации, рассмотрите экспорт в PDF через диалог печати (Ctrl + P → «Сохранить как PDF»).

Использование функции «Сохранить как» в Google Chrome

Откройте нужную веб-страницу в Google Chrome. Нажмите правой кнопкой мыши по свободной области страницы и выберите пункт «Сохранить как…» или используйте сочетание клавиш Ctrl+S (Cmd+S на macOS).

В открывшемся окне укажите место на компьютере для сохранения и выберите формат: «Веб-страница, полностью» или «Веб-страница, только HTML». Первый вариант сохранит HTML-файл и папку с ресурсами (изображения, скрипты, стили). Второй – только HTML-файл без сопутствующих файлов.

Для сохранения всех элементов интерфейса и отображения страницы офлайн предпочтителен вариант «Веб-страница, полностью». Однако он может не сохранить динамические элементы, загружаемые через JavaScript. Для таких страниц используйте инструменты разработчика или специальные расширения.

Избегайте переименования папки с ресурсами и самого HTML-файла вручную, чтобы сохранить корректные пути к элементам. Храните оба файла в одной директории – это гарантирует отображение страницы без ошибок.

Функция не сохраняет интерактивные элементы, пользовательские сессии, формы и видео с потоковой загрузкой. Для точного копирования таких страниц применяйте альтернативные методы: загрузку через wget или создание PDF-версии страницы.

Скачивание HTML с помощью расширений для браузеров

Расширения браузеров позволяют сохранять HTML-страницы без обращения к инструментам разработчика или сторонним приложениям. Это особенно полезно при необходимости массового или регулярного сохранения страниц.

- SingleFile (для Chrome, Firefox, Edge): сохраняет текущую страницу в один .html-файл, включая изображения, стили и скрипты. Поддерживает автосохранение по расписанию. Установка доступна через официальные магазины расширений.

- WebScrapBook: предлагает продвинутые возможности сохранения, включая структуру сайта, вложенные ссылки, и выборочную загрузку элементов. Работает с дополнительным серверным компонентом PyWebScrapBook для архивации сайтов целиком.

- Save Page WE (Firefox, Chrome): сохраняет страницу в виде одного .html-файла. Удобен для сохранения документов с большим количеством встроенного контента. Поддерживает автоматическую очистку ненужных скриптов перед сохранением.

Перед использованием расширения проверьте его разрешения: надежные инструменты не требуют доступа к сторонним сайтам без явной необходимости. Для автоматизации массового сохранения удобно использовать сочетание WebScrapBook с настроенным фильтром URL.

При работе с интерактивными страницами (SPA, AJAX) расширения могут не сохранять динамически загружаемый контент. В таких случаях предпочтительно использовать инструменты, способные «просматривать» страницу как браузер, например Puppeteer или Wget в headless-режиме.

Применение инструмента «Просмотр кода страницы»

Инструмент «Просмотр кода страницы» позволяет получить доступ к исходному HTML-коду сайта без дополнительных расширений и загрузок. Это полезно для извлечения структуры документа, анализа содержимого и ручного сохранения нужных элементов.

- Откройте страницу в браузере (например, Google Chrome или Firefox).

- Щёлкните правой кнопкой мыши в любой области и выберите пункт «Просмотр кода страницы» или нажмите Ctrl+U (Windows) / Cmd+Option+U (Mac).

Откроется новая вкладка с полным HTML-документом. Здесь можно:

- Скопировать весь код (Ctrl+A, затем Ctrl+C) и вставить его в текстовый редактор, например Notepad++ или VS Code.

- Найти нужные теги или фрагменты с помощью поиска (Ctrl+F), указав ключевые слова (например,

<div class="content">). - Изучить структуру DOM и определить ссылки на внешние ресурсы – CSS, JavaScript, изображения.

- Сохранить только интересующий участок HTML вместо всей страницы.

Если цель – получить «чистый» HTML без выполнения JavaScript, инструмент подходит лучше, чем «Сохранить как», так как отображает исходный код, полученный от сервера до обработки скриптами.

При необходимости последующей автоматизации этот подход удобен для ручного анализа структуры перед написанием скрипта для парсинга.

Загрузка HTML страницы с помощью curl в командной строке

Для загрузки HTML-кода страницы сайта используйте команду:

curl https://example.com -o page.html

Ключ -o указывает имя файла, в который сохраняется ответ сервера. Если указать только URL без параметров, содержимое выведется в консоль:

curl https://example.com

Чтобы эмулировать поведение браузера, добавьте пользовательский агент:

curl -A "Mozilla/5.0" https://example.com -o page.html

Для обхода редиректов используйте опцию -L:

curl -L https://example.com -o page.html

Если требуется указать тайм-аут ожидания ответа:

curl --max-time 10 https://example.com -o page.html

Для скачивания страницы через прокси-сервер:

curl -x 127.0.0.1:8080 https://example.com -o page.html

При использовании HTTPS может понадобиться отключить проверку SSL-сертификата:

curl -k https://example.com -o page.html

Загрузка с HTTP-авторизацией:

curl -u username:password https://example.com -o page.html

Для пакетной загрузки из списка URL сохраните их в файл urls.txt и выполните:

while read url; do curl -O "$url"; done < urls.txt

Скачивание HTML через Python с использованием библиотеки requests

Для скачивания HTML-страниц через Python широко используется библиотека requests, которая предоставляет простой и удобный интерфейс для работы с HTTP-запросами. Для начала необходимо установить библиотеку:

pip install requestsДалее, для загрузки HTML-контента, достаточно выполнить GET-запрос к нужному URL. Рассмотрим пример:

import requests

url = "https://example.com"

response = requests.get(url)

if response.status_code == 200:

html_content = response.text

with open("page.html", "w", encoding="utf-8") as file:

file.write(html_content)

else:

print(f"Ошибка при загрузке страницы: {response.status_code}")В данном примере выполняется запрос к сайту, а полученный HTML-код сохраняется в файл page.html. Важно проверять статус-код ответа с помощью атрибута status_code, чтобы убедиться, что страница была успешно загружена (200 – OK).

Для работы с кодировками, важно указать правильную кодировку при записи в файл. В случае с UTF-8 можно использовать параметр encoding=»utf-8″ при открытии файла для записи.

Библиотека requests также поддерживает дополнительные возможности, такие как обработка ошибок и управление сессиями. Если необходимо выполнить несколько запросов, лучше использовать объект сессии:

with requests.Session() as session:

session.get("https://example.com")

# Выполняются дополнительные запросы с использованием сессииТакой подход позволяет уменьшить накладные расходы на установление соединения для каждого нового запроса.

Если сервер требует дополнительных заголовков (например, для имитации запроса от браузера), их можно передать через параметр headers:

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36"

}

response = requests.get(url, headers=headers)Это позволит избежать блокировки запросов, которые выглядят как автоматические, а не как запросы от реальных пользователей.

Особенности скачивания динамически загружаемых страниц

Динамически загружаемые страницы основаны на JavaScript и AJAX-технологиях, которые позволяют обновлять содержимое без перезагрузки страницы. Такие страницы часто содержат данные, загружаемые после начальной загрузки HTML, что затрудняет их скачивание с помощью стандартных методов.

Для скачивания таких страниц необходимо учитывать, что браузер выполняет дополнительные запросы для получения данных, которые затем вставляются в DOM. Эти запросы, как правило, скрыты от пользователя и не видны в исходном коде страницы. Чтобы скачать всю информацию, нужно имитировать действия браузера или использовать инструменты, которые способны выполнить JavaScript.

Одним из таких инструментов является библиотека Selenium. Она позволяет запускать браузер с поддержкой JavaScript и получать полную страницу, включая динамически загруженные элементы. Для автоматизации скачивания можно написать скрипт, который выполнит все необходимые запросы и сохранит результат.

Для менее сложных случаев, когда загрузка данных осуществляется через API-запросы, можно воспользоваться инструментами, такими как cURL или Postman. Они позволяют отследить запросы, отправляемые браузером, и вручную воспроизвести их, получив необходимую информацию в формате JSON или XML.

Кроме того, важно учитывать, что современные сайты используют техники защиты от ботов, такие как CAPTCHA и JavaScript-обфускация. Это может потребовать дополнительных усилий для обхода защиты, таких как использование прокси-серверов, изменение заголовков HTTP или использование сервисов, которые предлагают решения для распознавания CAPTCHA.

Также стоит помнить, что для скачивания динамически загружаемых страниц важно соблюдать законы об авторских правах и правила использования контента. Неавторизованный доступ к данным сайта может привести к юридическим последствиям.

Как сохранить связанные ресурсы: CSS, изображения, скрипты

При скачивании HTML-страницы важно учесть не только саму страницу, но и все её связанные ресурсы – CSS, изображения и скрипты. Эти элементы обеспечивают корректное отображение и функциональность сайта. Рассмотрим, как сохранить их для работы страницы в офлайн-режиме.

1. CSS

Для корректного отображения страницы необходимо сохранить все стили, которые она использует. Это можно сделать, скачав все файлы CSS, указанные в теге <link> или <style>. Для этого нужно:

- Посмотреть в исходном коде страницы все ссылки на внешние файлы CSS. Обычно они находятся в

<link rel="stylesheet">. - Скачать указанные файлы, сохранив их в том же порядке, в котором они подключены в HTML.

- Обновить ссылки в HTML-файле, указав локальный путь к сохранённым CSS-файлам.

2. Изображения

Изображения можно скачать вручную или с помощью программ, которые автоматически загружают все ресурсы. Для этого необходимо:

- Проверить все теги

<img>, а также фоны в CSS, для которых используются изображения, указывая их URL. - Скачать все изображения и сохранить их в соответствующих папках (например,

/images), соблюдая структуру каталогов. - После этого нужно обновить пути к изображениям в HTML или CSS-файлах, указав локальные пути, если это необходимо.

3. Скрипты

Для корректной работы динамических элементов страницы нужно сохранить все внешние JavaScript-файлы, подключенные через теги <script src="...">. Чтобы сохранить скрипты:

- Идентифицируйте все ссылки на внешние скрипты, указанные в

<script src="...">. - Скачайте эти файлы и сохраните их локально.

- Проверьте порядок подключения скриптов в HTML и обновите пути к ним, если это нужно.

4. Использование инструментов для скачивания ресурсов

Для автоматического скачивания всех связанных ресурсов можно использовать специальные инструменты, такие как:

- Wget – позволяет скачать всю страницу с её зависимыми ресурсами с помощью команды

wget -p. - HTTrack – программа, которая позволяет клонировать сайт, сохраняя структуру и все файлы.

Используя эти инструменты, можно автоматически сохранить все ресурсы страницы в нужной структуре и с правильными путями.

Вопрос-ответ:

Можно ли скачать только код HTML страницы без дополнительных файлов?

Да, можно скачать только HTML-код страницы без дополнительных ресурсов, таких как изображения или стили. Для этого при сохранении страницы в браузере следует выбрать опцию, которая сохраняет только сам код (обычно «Только HTML» или «Только текст»). Этот метод подходит, если вам нужно просто получить структуру страницы без медиафайлов и прочих элементов.

Как сохранить HTML-страницу с картинками и стилями?

Если нужно сохранить HTML-страницу с картинками, стилями и другими элементами, то при сохранении через браузер выберите опцию «Полностью» или «Все файлы». Эта опция сохраняет не только HTML-код, но и все связанные с ним ресурсы — изображения, стили CSS и скрипты. После этого, при открытии сохраненной страницы, она будет выглядеть так же, как и на сайте.