В асинхронных и распределённых системах на Python часто используется модель worker-ов для выполнения задач в фоновом режиме. Однако результат их работы не сохраняется автоматически – за это отвечает конкретный компонент системы. Понимание, где и как происходит сохранение, критично для устойчивости и производительности приложений.

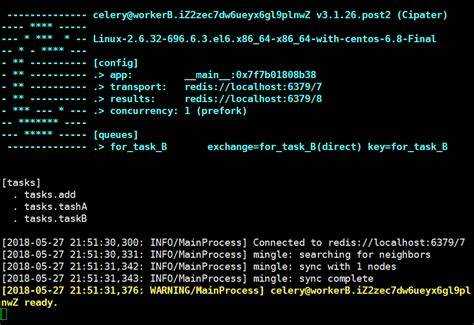

Если используется Celery, результаты задач по умолчанию сохраняются через бэкенд, указанный в конфигурации: Redis, RabbitMQ, PostgreSQL или другой. Установка параметра result_backend необходима. Без него результат не сохраняется вовсе. Например: result_backend = 'redis://localhost:6379/0'.

В случае применения multiprocessing, возвращаемые значения нужно сохранять вручную, чаще всего через очереди (Queue), менеджеры (Manager) или в базы данных. Процесс завершается – и результат исчезает, если заранее не предусмотрено сохранение в общий доступный ресурс.

При работе с asyncio результат каждой корутины обычно обрабатывается в коде, где вызывается await. Но если запускаются фоновые таски через asyncio.create_task(), сохранением результата должен заниматься вызывающий код – в переменной, базе данных или другом внешнем хранилище.

В серверных приложениях на FastAPI или Django с асинхронными задачами важно явно интегрировать механизм сохранения результатов: использовать базу данных, сторонние очереди задач или кеши. Иначе данные, возвращаемые worker’ами, будут утеряны после выполнения.

Сохранение результата – это ответственность разработчика и архитектуры системы. Worker исполняет код, но не отвечает за то, где и как результат будет зафиксирован. Это должно быть чётко определено: что сохраняется, когда и кем.

Как возвращается результат из процесса при использовании multiprocessing

Модуль multiprocessing в Python предоставляет несколько способов получения результатов от дочерних процессов. Ключевые инструменты для этого – Queue, Pipe, Pool и объект Manager.

- Queue: Безопасна для использования между процессами. Каждый воркер записывает результат в очередь, из которой основной процесс извлекает данные с помощью метода

get(). Очередь должна быть передана процессу как аргумент при запуске. - Pipe: Создаёт двусторонний канал связи. Метод

recv()используется в главном процессе для получения результата. Подходит для простой и двусторонней передачи, но не масштабируется на множество процессов. - Pool: Предназначен для управления группой процессов. Методы

apply(),map(),apply_async()иmap_async()возвращают результат либо напрямую, либо через объектAsyncResult. Методget()вызывается для получения данных изAsyncResult. - Manager: Позволяет создать объекты, разделяемые между процессами, например список или словарь. Процессы могут напрямую изменять эти структуры, и изменения будут доступны в главном процессе.

- Создайте функцию-воркер, принимающую разделяемый объект (очередь, список и т.д.).

- Передайте этот объект процессу при создании через

Process(..., args=(...)). - Внутри воркера сохраните результат в переданный объект.

- После завершения всех процессов получите данные в главном процессе.

Рекомендация: при большом количестве задач используйте Pool.map() для синхронного выполнения с возвратом списка результатов или Pool.map_async() с последующим вызовом get(). Это упрощает синхронизацию и освобождает от необходимости вручную управлять очередями.

Передача результатов через очередь Queue и Pipe

Queue реализует очередь FIFO с внутренней блокировкой, обеспечивая потокобезопасный доступ. Worker помещает результат через метод put(), а основной процесс извлекает его с помощью get(). Рекомендуется использовать Queue при работе с несколькими worker’ами, так как она масштабируется без дополнительной синхронизации. Для избежания блокировок следует использовать get(timeout=...) или get_nowait().

Pipe создает двусторонний канал связи. После вызова Pipe() возвращаются два конца: один используется worker’ом для отправки (send()), второй – основным процессом для чтения (recv()). Pipe подходит для парной коммуникации и имеет меньше накладных расходов по сравнению с Queue, но не масштабируется при увеличении числа процессов.

Для сериализации данных в обоих случаях используется pickle, что допускает передачу сложных объектов. Следует избегать передачи больших объемов данных – производительность падает из-за межпроцессного копирования.

Queue предпочтительна в задачах с множеством параллельных worker’ов. Pipe уместна при точечной связке двух процессов, особенно если важна минимальная задержка.

Использование Manager для совместного доступа к результатам

Модуль multiprocessing предоставляет объект Manager, позволяющий создавать структуры данных, доступные из нескольких процессов. Это особенно важно при использовании worker-процессов, результат работы которых должен быть собран в одном месте.

Для сохранения результатов обычно применяют Manager().list() или Manager().dict(). Эти объекты оборачиваются прокси-объектами, синхронизированными между процессами. Например:

from multiprocessing import Process, Manager

def worker(shared_list, value):

shared_list.append(value * value)

if __name__ == "__main__":

with Manager() as manager:

result_list = manager.list()

processes = [Process(target=worker, args=(result_list, i)) for i in range(5)]

for p in processes: p.start()

for p in processes: p.join()

print(list(result_list))

Использование Manager удобно, когда требуется собрать данные от каждого worker-а в реальном времени. Однако важно учитывать: передача объектов через прокси ведет к накладным расходам, особенно при частом доступе или больших объемах данных. В таких случаях предпочтительнее использовать очереди (Queue) или разделяемую память (multiprocessing.shared_memory), если приоритет – производительность.

Manager подходит для ситуаций, где важнее простота синхронизации, чем скорость. Это полезно при отладке, тестировании и неинтенсивной параллельной обработке.

Роль callback-функций в сохранении результатов работы

Callback-функции позволяют немедленно обработать результат работы workera без необходимости опрашивать очередь или блокировать основной поток. В многопроцессных и асинхронных приложениях на Python они обеспечивают эффективную маршрутизацию данных к месту хранения – в базу данных, файл или стороннюю систему.

В контексте использования модуля multiprocessing, параметр callback метода apply_async позволяет передать функцию, которая будет вызвана с результатом завершённой задачи. Это исключает необходимость явного вызова get() у объекта AsyncResult и предотвращает блокировку потока.

Пример использования:

from multiprocessing import Pool

def task(x):

return x * x

def save_result(result):

with open("results.txt", "a") as f:

f.write(f"{result}\n")

with Pool(processes=4) as pool:

for i in range(10):

pool.apply_async(task, args=(i,), callback=save_result)

pool.close()

pool.join()

Callback-функция save_result вызывается автоматически по завершении каждой задачи, и результат сохраняется без дополнительных синхронизаций. Это позволяет масштабировать систему за счёт минимизации точек ожидания.

При использовании asyncio, аналогичного эффекта можно достичь с помощью методов add_done_callback у объектов Future или Task. Рекомендуется всегда передавать в callback только чистые функции без побочных эффектов или предусматривать обработку исключений внутри них, чтобы не нарушать поток выполнения.

Чёткое разделение функций вычисления и сохранения результатов повышает читаемость кода и упрощает тестирование. Callback-функции – ключевой инструмент для устойчивой и масштабируемой архитектуры в системах, активно использующих worker-процессы.

Особенности хранения данных при использовании concurrent.futures

Модуль concurrent.futures предоставляет высокоуровневый интерфейс для параллельного выполнения задач через ThreadPoolExecutor и ProcessPoolExecutor. Хранение результатов зависит от типа исполнителя и способа организации кода.

При использовании ThreadPoolExecutor можно безопасно сохранять данные в общих структурах, таких как списки или словари, при условии синхронизации доступа с помощью threading.Lock или других механизмов. Потоки работают в общей памяти, что упрощает обмен данными, но требует защиты от гонок.

В случае ProcessPoolExecutor каждая задача исполняется в отдельном процессе, и прямая передача данных между задачами невозможна без использования менеджеров из multiprocessing или возврата значений через Future. Общие структуры данных здесь недоступны без явной сериализации.

Для хранения результатов целесообразно использовать сбор всех Future-объектов и вызов future.result() после завершения выполнения:

with concurrent.futures.ProcessPoolExecutor() as executor:

futures = [executor.submit(task, arg) for arg in args]

results = [f.result() for f in concurrent.futures.as_completed(futures)]

Если необходимо сохранить промежуточные результаты в процессе выполнения, используйте multiprocessing.Manager для создания разделяемых структур:

from multiprocessing import Manager

def worker(shared_dict, key, value):

shared_dict[key] = value

with Manager() as manager:

d = manager.dict()

with concurrent.futures.ProcessPoolExecutor() as executor:

executor.submit(worker, d, 'a', 1).result()

Для исключения конфликтов в многопоточной среде используйте атомарные операции или блокировки при изменении общих объектов. В многопроцессной среде это недоступно без специализированных объектов.

Не рекомендуется использовать глобальные переменные для хранения результатов: в случае с ProcessPoolExecutor они не сохраняют изменений, так как процессы не разделяют память.

Как избежать потери результатов при завершении процессов

Чтобы гарантировать сохранность результатов, используйте очередь задач с хранилищем, устойчивым к сбоям. Например, Celery с брокером RabbitMQ или Redis и backend’ом результатов в виде PostgreSQL или Redis обеспечивает доставку и сохранение данных даже при аварийной остановке процесса.

Применяйте атомарные операции записи. При сохранении результатов в базу данных, используйте транзакции с уровнем изоляции REPEATABLE READ или SERIALIZABLE. Это исключает частичную запись и повреждение данных при внезапном завершении работы процесса.

Настраивайте worker’ы на автоматическое подтверждение выполнения задач только после успешного завершения обработки. В Celery параметр acks_late=True гарантирует, что задача будет возвращена в очередь, если процесс был завершён до завершения обработки.

Используйте механизм checkpoint’ов. При работе с большими объёмами данных (например, парсинг, обучение модели) периодически сохраняйте промежуточные результаты на диск с помощью pickle или joblib. При перезапуске процесс может продолжить с последней сохранённой точки.

Настройте мониторинг завершения процессов. Интеграция с системой supervisor или systemd позволяет автоматически перезапускать worker’ы при сбоях. Также отслеживайте метрики успешности выполнения задач через Prometheus или Sentry.

Для критически важных вычислений используйте файловые блокировки или флаги выполнения. Это предотвращает повторную обработку уже завершённых задач при повторном запуске процессов и снижает риск потери данных при одновременном доступе к ресурсу.

Вопрос-ответ:

Кто отвечает за сохранение результата работы worker-процесса в Python?

Сохранением результата занимается управляющий процесс, например, диспетчер задач или основной процесс в случае использования таких библиотек, как `multiprocessing` или `concurrent.futures`. Он получает данные от worker’ов через очереди, каналы или другие механизмы межпроцессного взаимодействия. Именно управляющий процесс решает, что делать с полученными результатами — сохранить в файл, отправить в базу данных или вернуть в вызывающий код.

Можно ли сохранить результат работы worker’а напрямую в файл из самого worker’а?

Да, worker может самостоятельно записать результат своей работы в файл, если у него есть на это права и доступ к файловой системе. Однако это не всегда лучший подход, особенно если работает несколько worker’ов одновременно — возможно возникновение конфликтов при записи. В таких случаях лучше передавать данные управляющему процессу, который будет координировать сохранение.

Какие способы передачи результатов от worker’ов к основному процессу наиболее надёжны?

Наиболее устойчивыми считаются очереди (`Queue`) из модуля `multiprocessing`, так как они специально предназначены для обмена данными между процессами. Также можно использовать пайпы (`Pipe`) или менеджеры (`Manager`) для создания разделяемых объектов, таких как списки или словари. Выбор зависит от сложности задачи и объема передаваемых данных.

Что произойдёт с результатом, если worker завершится с ошибкой?

Если worker аварийно завершится, результат не будет автоматически передан. Чтобы обрабатывать такие случаи, стоит предусмотреть обработку исключений и логгирование. Например, при использовании пула worker’ов через `multiprocessing.Pool`, можно использовать методы `apply_async` с аргументом `error_callback`, чтобы фиксировать ошибки отдельно от успешных результатов.

Как сохранить результаты из нескольких worker’ов, чтобы они не перезаписывали друг друга?

Один из подходов — использовать уникальные имена файлов для каждого worker’а, например, добавляя к имени файла идентификатор процесса (`os.getpid()`) или порядковый номер задачи. Другой способ — использовать общий файл с синхронизацией через блокировки, чтобы избежать одновременной записи. Также можно собрать все результаты в основном процессе и сохранить их централизованно, что упрощает контроль и предотвращает конфликты.