Для извлечения HTML-кода веб-страницы с помощью Java можно воспользоваться библиотеками, которые позволяют делать HTTP-запросы и обрабатывать ответы. Одной из самых популярных является Jsoup, которая позволяет легко получать содержимое страниц и работать с ним.

Основной процесс состоит из двух этапов: отправка HTTP-запроса и извлечение данных из ответа. Библиотека Jsoup предоставляет простой API для работы с HTML, поддерживая как парсинг, так и загрузку страниц через URL. Для этого необходимо использовать метод connect() для выполнения запроса, а затем вызвать метод get() для получения содержимого страницы.

Пример кода на Java с использованием Jsoup выглядит так:

Document doc = Jsoup.connect("http://example.com").get();

String html = doc.html();

Этот код позволяет получить весь HTML-код страницы в виде строки. Jsoup автоматически загружает страницу, извлекает ее содержимое и возвращает его в удобном формате. Помимо этого, Jsoup позволяет работать с конкретными элементами страницы, такими как теги, атрибуты и текст.

Для выполнения HTTP-запросов можно также использовать стандартную библиотеку Java HttpURLConnection, которая дает больше контроля над параметрами запроса, однако она требует больше кода для обработки ответов и обработки ошибок.

Подход с использованием Jsoup проще и быстрее для большинства случаев, поскольку библиотека уже включает все необходимые методы для работы с HTML, что делает её идеальным выбором для извлечения кода страницы в Java-программах.

Настройка проекта для работы с HTTP-запросами

Для начала работы с HTTP-запросами в Java необходимо подключить соответствующие библиотеки. В большинстве случаев используется стандартная библиотека Java, которая включает в себя класс HttpURLConnection. Однако для удобства можно воспользоваться сторонними библиотеками, такими как Apache HttpClient или OkHttp, которые предлагают более гибкие возможности для работы с запросами.

Для работы с HttpURLConnection настройка проекта сводится к импорту нужных классов и созданию объекта подключения. Если вы хотите использовать Apache HttpClient, то сначала добавьте зависимость в файл pom.xml, если проект использует Maven:

<dependency>

<groupId>org.apache.httpcomponents</groupId>

<artifactId>httpclient</artifactId>

<version>4.5.13</version>

</dependency>

Если вы используете Gradle, добавьте следующую строку в файл build.gradle:

implementation 'org.apache.httpcomponents:httpclient:4.5.13'

При использовании OkHttp добавьте зависимость в build.gradle:

implementation 'com.squareup.okhttp3:okhttp:4.9.1'

После добавления зависимости можно приступить к созданию HTTP-запросов. Для работы с HttpURLConnection создайте объект подключения и укажите необходимые параметры запроса:

URL url = new URL("https://example.com");

HttpURLConnection connection = (HttpURLConnection) url.openConnection();

connection.setRequestMethod("GET");

connection.setConnectTimeout(5000);

connection.setReadTimeout(5000);

Для удобства можно использовать сторонние библиотеки. Например, с Apache HttpClient создание запроса будет выглядеть так:

HttpClient client = HttpClients.createDefault();

HttpGet request = new HttpGet("https://example.com");

HttpResponse response = client.execute(request);

Для работы с запросами в OkHttp код будет следующим:

OkHttpClient client = new OkHttpClient();

Request request = new Request.Builder()

.url("https://example.com")

.build();

Response response = client.newCall(request).execute();

После этого можно приступить к обработке ответа сервера. Важно помнить, что при работе с сетью необходимо учитывать ошибки подключения, тайм-ауты и другие аспекты взаимодействия с сетью.

Использование библиотеки HttpURLConnection для запроса HTML-страницы

import java.io.*;

import java.net.*;

public class HttpExample {

public static void main(String[] args) throws IOException {

// Указываем URL

String urlString = "https://example.com";

URL url = new URL(urlString);

// Открываем соединение

HttpURLConnection connection = (HttpURLConnection) url.openConnection();

// Устанавливаем метод запроса

connection.setRequestMethod("GET");

// Получаем ответный код

int responseCode = connection.getResponseCode();

System.out.println("Response Code: " + responseCode);

// Чтение HTML-страницы

if (responseCode == HttpURLConnection.HTTP_OK) {

BufferedReader in = new BufferedReader(new InputStreamReader(connection.getInputStream()));

String inputLine;

StringBuffer response = new StringBuffer();

while ((inputLine = in.readLine()) != null) {

response.append(inputLine);

}

in.close();

System.out.println(response.toString());

} else {

System.out.println("Error: " + responseCode);

}

// Закрытие соединения

connection.disconnect();

}

}

Важно помнить, что HttpURLConnection не предоставляет автоматического парсинга HTML-кода, поэтому его необходимо обрабатывать вручную или использовать дополнительные библиотеки для анализа структуры документа, например, Jsoup.

Рекомендуется также устанавливать тайм-ауты для соединений, чтобы избежать зависания программы в случае проблем с сетью. Это можно сделать с помощью методов setConnectTimeout() и setReadTimeout(). Пример:

connection.setConnectTimeout(5000); // Тайм-аут на подключение 5 секунд

connection.setReadTimeout(5000); // Тайм-аут на чтение 5 секунд

Таким образом, HttpURLConnection является удобным и эффективным инструментом для получения HTML-страниц в Java. Этот подход идеально подходит для небольших проектов и задач, где не требуется сложная настройка или использование сторонних библиотек.

Парсинг HTML-кода с помощью библиотеки Jsoup

Для парсинга HTML-кода в Java используется библиотека Jsoup. Она позволяет эффективно извлекать данные из HTML-страниц, манипулировать ими и анализировать структуру документа. Jsoup поддерживает как извлечение данных, так и обработку различных элементов страницы, таких как теги, атрибуты и текст.

Основная задача библиотеки – это преобразование HTML в структуру, которая легко читаема и удобна для работы. После того как HTML-документ загружен, Jsoup предоставляет методы для навигации по его элементам, их модификации и извлечения нужной информации.

Чтобы начать работу с Jsoup, необходимо добавить зависимость в проект. Для Maven это будет выглядеть так:

org.jsoup jsoup 1.14.3

После добавления библиотеки можно начинать парсинг. Например, для загрузки HTML-страницы с URL и извлечения всех заголовков h2:

Document doc = Jsoup.connect("https://example.com").get();

Elements headings = doc.select("h2");

for (Element heading : headings) {

System.out.println(heading.text());

}

Метод connect загружает HTML-страницу по URL, а select используется для выборки элементов по CSS-селекторам. Это позволяет извлекать конкретные части страницы, такие как теги, атрибуты или текст.

Для извлечения атрибутов HTML-элементов можно использовать метод attr. Например, чтобы получить ссылку из тега a:

Elements links = doc.select("a");

for (Element link : links) {

String href = link.attr("href");

System.out.println(href);

}

Jsoup также поддерживает работу с HTML-контентом в строковом виде. Для этого можно использовать метод parse:

String html = "<html><body><h1>Hello</h1></body></html>"; Document doc = Jsoup.parse(html); System.out.println(doc.title());

Для более сложных операций, таких как удаление элементов или изменение контента, Jsoup предоставляет методы remove и html, позволяя модифицировать HTML-страницу:

Element body = doc.body();

body.select("h1").remove();

System.out.println(doc.html());

Использование Jsoup для парсинга HTML в Java позволяет быстро и точно извлекать необходимую информацию, минимизируя необходимость в сложных алгоритмах обработки текста. Библиотека эффективна для работы с небольшими и большими страницами, поддерживает асинхронную загрузку и позволяет обрабатывать страницы с различными кодировками.

Обработка ошибок при загрузке HTML-страницы в Java

При загрузке HTML-страницы в Java важно правильно обрабатывать возможные ошибки, чтобы обеспечить стабильную работу приложения. Основные ошибки, с которыми можно столкнуться, связаны с неправильными URL, недоступностью сервера, ошибками в сети и проблемами с парсингом HTML.

- Ошибки при подключении к URL: Ошибки типа

java.net.MalformedURLExceptionилиjava.net.UnknownHostExceptionмогут возникнуть, если URL указан неверно или доменное имя не существует. Важно проверять правильность URL до отправки запроса. - Неудачные попытки соединения:

java.net.ConnectExceptionвозникает, когда не удается установить соединение с сервером. Возможные причины – сервер не работает или проблемы с сетью. Для отладки можно использовать тайм-ауты, чтобы избежать зависания запроса на неопределенное время. - Ошибки HTTP: Ответ от сервера может содержать код ошибки, например, 404 (страница не найдена) или 500 (внутренняя ошибка сервера). Для их обработки используйте метод

HttpURLConnection.getResponseCode()для получения кода статуса ответа. - Ошибки при чтении данных: Если возникла ошибка при чтении HTML-данных, например, из-за поврежденных данных или проблем с кодировкой, это может вызвать

IOException. Рекомендуется обрабатывать исключения чтения и следить за правильной кодировкой при обработке текста.

Рекомендации по обработке ошибок:

- Используйте конструкцию

try-catchдля перехвата исключений. Например, перехватитеMalformedURLExceptionи выведите понятное сообщение для пользователя. - Для устойчивости к временным сбоям используйте перезапуск подключения через определенные интервалы времени с максимальным количеством попыток.

- Реализуйте проверку статуса ответа от сервера с помощью метода

HttpURLConnection.getResponseCode()иgetResponseMessage()для дальнейшей обработки ошибок HTTP. - Для обработки

IOExceptionможно использовать логирование и повторные попытки подключения с увеличением задержки. - Обработайте ошибки парсинга HTML-страницы с помощью блоков

try-catchпри использовании библиотеки, например,jsoup, для избежания сбоев при некорректном HTML-коде.

Пример обработки ошибок при загрузке страницы:

try {

URL url = new URL("https://example.com");

HttpURLConnection connection = (HttpURLConnection) url.openConnection();

connection.setRequestMethod("GET");

int responseCode = connection.getResponseCode();

if (responseCode != HttpURLConnection.HTTP_OK) {

throw new IOException("Ошибка HTTP: " + responseCode);

}

// Дальнейшая обработка данных...

} catch (MalformedURLException e) {

System.out.println("Неверный URL: " + e.getMessage());

} catch (ConnectException e) {

System.out.println("Не удается подключиться к серверу: " + e.getMessage());

} catch (IOException e) {

} catch (Exception e) {

System.out.println("Неизвестная ошибка: " + e.getMessage());

}

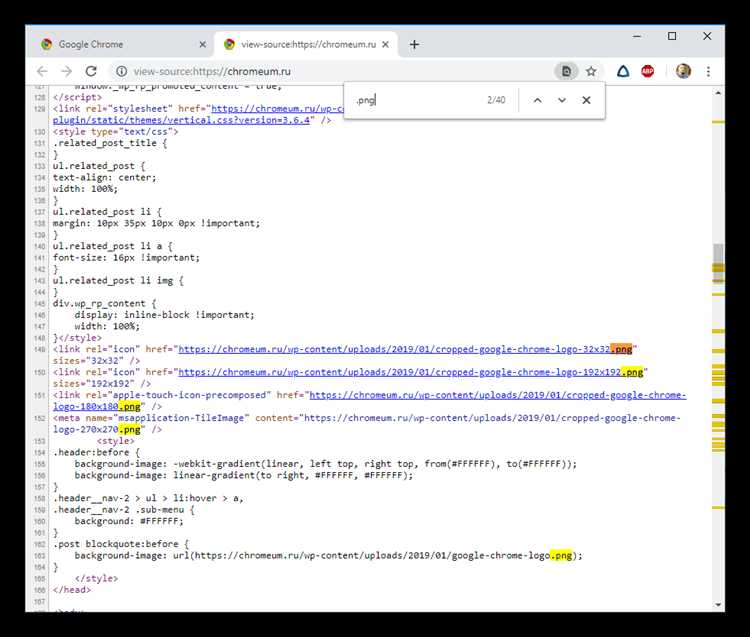

Получение HTML с учетом редиректов и заголовков

Для получения HTML-кода страницы в Java важно учитывать редиректы и заголовки ответа, так как они могут существенно повлиять на результат. Когда сервер отправляет код ответа с редиректом (например, 301 или 302), браузер или клиентская программа должны следовать этому редиректу для получения актуального контента.

Для работы с редиректами в Java можно использовать класс HttpURLConnection. Этот класс по умолчанию выполняет автоматическое перенаправление на новый URL. Однако важно контролировать этот процесс, если требуется обрабатывать редиректы вручную, например, для проверки промежуточных этапов.

Чтобы отключить автоматическое следование за редиректами, нужно использовать метод setInstanceFollowRedirects(false) перед выполнением запроса. В этом случае, получив код ответа 3xx, можно извлечь новый URL из заголовка Location и вручную выполнить новый запрос.

Кроме того, важно работать с заголовками ответа, так как они содержат ключевую информацию о контенте, который будет возвращен. Например, заголовок Content-Type указывает тип данных, что важно для правильной обработки ответа. Для получения заголовков в Java используется метод getHeaderField.

Пример получения заголовков:

URL url = new URL("http://example.com");

HttpURLConnection connection = (HttpURLConnection) url.openConnection();

connection.setRequestMethod("GET");

connection.connect();

String contentType = connection.getHeaderField("Content-Type");

System.out.println("Content-Type: " + contentType);

Также важно учитывать, что на некоторых страницах могут быть установлены дополнительные заголовки, такие как Cache-Control, ETag и другие, которые могут влиять на кэширование или модификацию контента.

Для более точной настройки запроса можно добавить пользовательские заголовки с помощью метода setRequestProperty. Это полезно, например, для указания типа содержимого или для аутентификации, если сайт требует соответствующих заголовков, как Authorization.

Пример добавления пользовательского заголовка:

connection.setRequestProperty("User-Agent", "Mozilla/5.0");

Таким образом, для правильного получения HTML-страницы важно не только обработать редиректы, но и учитывать заголовки ответа для эффективной работы с контентом.

Как извлечь динамически загружаемый контент с использованием Java

Для извлечения динамически загружаемого контента с веб-страницы с использованием Java необходимо работать с браузерной автоматизацией или инструментами, поддерживающими выполнение JavaScript. Это необходимо, потому что стандартный HTTP-запрос может не захватывать контент, загружаемый с помощью JavaScript после первоначальной загрузки страницы.

1. Использование библиотеки Selenium

Selenium – это популярный инструмент для автоматизации браузера, который позволяет управлять браузером, выполнять JavaScript и извлекать элементы, загруженные динамически. Основной подход – запускать браузер, как это делает пользователь, и извлекать необходимые данные.

Для начала необходимо настроить Selenium WebDriver. Пример кода для получения динамически загружаемого контента с помощью Chrome WebDriver:

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.chrome.ChromeDriver;

import org.openqa.selenium.By;

public class DynamicContentExtractor {

public static void main(String[] args) {

System.setProperty("webdriver.chrome.driver", "path/to/chromedriver");

WebDriver driver = new ChromeDriver();

driver.get("URL страницы");

// Ожидаем загрузки динамического контента

WebElement dynamicElement = driver.findElement(By.id("dynamicElementId"));

System.out.println(dynamicElement.getText());

driver.quit();

}

}

2. Использование библиотеки Jsoup для парсинга после выполнения JavaScript

Если вы хотите извлечь данные с сайта, но вам не нужно взаимодействовать с интерфейсом браузера, можно использовать инструменты, такие как Jsoup, но в этом случае вам понадобится внешняя помощь для выполнения JavaScript.

Одним из вариантов является использование PhantomJS или HtmlUnit. Эти браузеры без интерфейса могут выполнить JavaScript и предоставить HTML-код страницы после его выполнения. Для этого нужно настроить соответствующие библиотеки в проекте и подключить их к Jsoup для последующего парсинга:

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.openqa.selenium.htmlunit.HtmlUnitDriver;

public class DynamicContentExtractorWithJsoup {

public static void main(String[] args) {

HtmlUnitDriver driver = new HtmlUnitDriver();

driver.get("URL страницы");

String pageSource = driver.getPageSource();

Document document = Jsoup.parse(pageSource);

String content = document.select("div#dynamicContent").text();

System.out.println(content);

}

}

Этот подход позволяет получить HTML-код страницы после выполнения JavaScript и использовать Jsoup для извлечения нужных данных.

3. Использование браузерных расширений для захвата запросов

Другим вариантом является мониторинг сетевых запросов браузера. С помощью таких инструментов, как BrowserMob Proxy, можно перехватывать запросы, которые выполняются при загрузке страницы. Это особенно полезно, если динамически загружаемый контент приходит в виде данных через API-запросы, а не через изменение DOM на странице.

Пример настройки BrowserMob Proxy для перехвата запросов и получения данных:

import org.openqa.selenium.Proxy;

import org.openqa.selenium.chrome.ChromeOptions;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.chrome.ChromeDriver;

import net.lightbody.bmp.client.ClientUtil;

import org.browsermob.proxy.ProxyServer;

public class ProxyExample {

public static void main(String[] args) {

ProxyServer server = new ProxyServer(0);

server.start();

Proxy proxy = ClientUtil.createSeleniumProxy(server);

ChromeOptions options = new ChromeOptions();

options.setProxy(proxy);

WebDriver driver = new ChromeDriver(options);

driver.get("URL страницы");

// Получаем перехваченные запросы

System.out.println(server.getHar());

driver.quit();

server.stop();

}

}

Этот подход позволяет получить информацию о запросах и ответах от сервера, что важно для извлечения данных, которые не загружаются напрямую в HTML, а подгружаются через AJAX-запросы.

4. Использование API сервиса

Если на сайте имеется публичное API для получения данных, проще всего будет запросить данные напрямую через API. Это позволит избежать сложности работы с браузером или дополнительными инструментами для имитации действий пользователя. Пример простого GET-запроса с использованием библиотеки HttpClient:

import org.apache.http.HttpEntity;

import org.apache.http.client.methods.HttpGet;

import org.apache.http.impl.client.HttpClients;

import org.apache.http.impl.client.CloseableHttpClient;

import org.apache.http.client.methods.CloseableHttpResponse;

public class ApiRequestExample {

public static void main(String[] args) throws IOException {

CloseableHttpClient client = HttpClients.createDefault();

HttpGet request = new HttpGet("API endpoint URL");

try (CloseableHttpResponse response = client.execute(request)) {

HttpEntity entity = response.getEntity();

String content = EntityUtils.toString(entity);

System.out.println(content);

}

}

}

Используя API, можно получить чистые данные без лишней обработки, что делает этот способ одним из самых эффективных и быстрых.

Выбор метода зависит от сложности страницы, количества данных и предпочтений в инструментировании. Важно учитывать, что использование автоматизации браузера может быть ресурсоемким, поэтому если API доступно, это будет оптимальным решением.