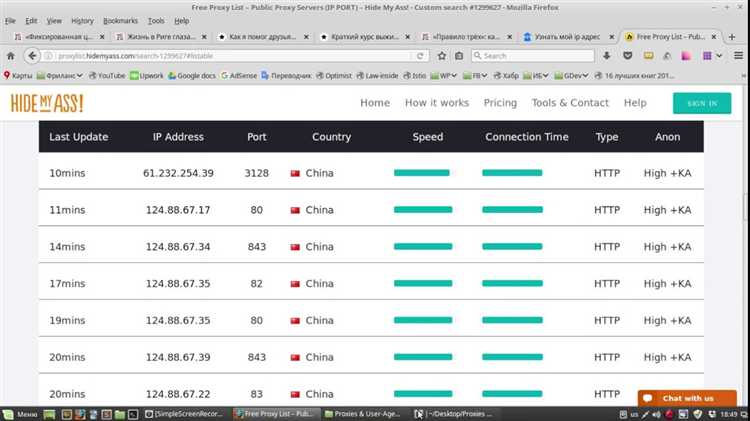

Прокси-серверы позволяют скрыть реальный IP-адрес, обойти блокировки и распределить сетевую нагрузку. При работе с HTTP-запросами через Python важно не только указать параметры прокси, но и убедиться в его доступности и корректной маршрутизации трафика. Ошибки на этом этапе могут привести к потере данных или блокировке аккаунтов на целевых ресурсах.

Для начальной проверки чаще всего используют стандартную библиотеку requests с передачей параметра proxies. Если прокси требует авторизации, необходимо задать логин и пароль в формате http://user:pass@ip:port. Типичные ошибки – неправильный формат адреса, отсутствие соединения, таймаут или ответ с кодом 403, указывающим на отказ в доступе.

Базовая проверка через requests.get() с заголовком User-Agent и запросом к сервису вроде httpbin.org/ip позволяет определить, прошёл ли трафик через заданный прокси. Однако этого недостаточно при использовании ротации IP или при работе с защищёнными API. В таких случаях стоит добавить проверку DNS-резолвинга, задержек и стабильности соединения.

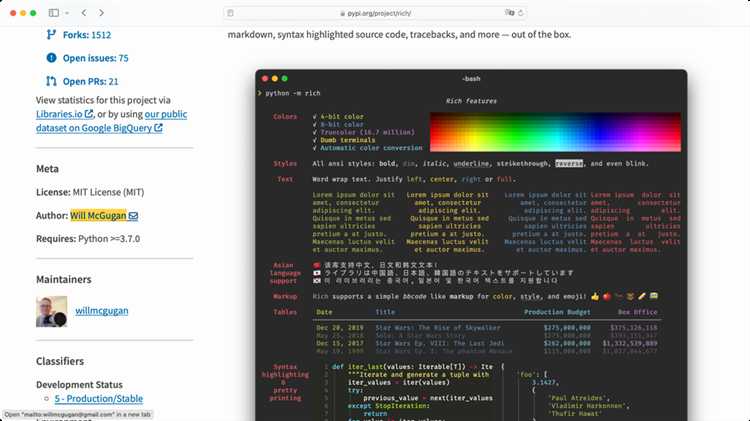

Для более точного контроля можно использовать библиотеку httpx, которая поддерживает асинхронные запросы. Это особенно полезно при проверке большого списка прокси. Дополнительно рекомендуется замерять время отклика и анализировать коды ответа, чтобы отсеять нестабильные или заблокированные адреса.

Как отправить запрос через прокси с использованием библиотеки requests

Для отправки HTTP-запроса через прокси в библиотеке requests необходимо передать словарь с параметрами прокси в аргумент proxies. Формат словаря: {"http": "схема://IP:порт", "https": "схема://IP:порт"}.

Пример подключения к прокси-серверу:

import requests

proxies = {

"http": "http://127.0.0.1:8080",

"https": "http://127.0.0.1:8080"

}

response = requests.get("http://httpbin.org/ip", proxies=proxies, timeout=5)

print(response.text)

Если прокси требует авторизацию, формат строки меняется: http://пользователь:пароль@IP:порт.

proxies = {

"http": "http://user:pass@127.0.0.1:8080",

"https": "http://user:pass@127.0.0.1:8080"

}

Для SOCKS-прокси требуется установка дополнительного пакета: pip install requests[socks]. Пример с SOCKS5:

proxies = {

"http": "socks5h://127.0.0.1:9050",

"https": "socks5h://127.0.0.1:9050"

}

Рекомендуется указывать таймаут через аргумент timeout, чтобы избежать зависаний при недоступности прокси.

При ошибке подключения к прокси (ProxyError, ConnectTimeout) следует обрабатывать исключения:

from requests.exceptions import ProxyError, ConnectTimeout

try:

response = requests.get("http://example.com", proxies=proxies, timeout=5)

print(response.status_code)

except (ProxyError, ConnectTimeout) as e:

print("Ошибка прокси:", e)

Как обрабатывать ошибки при недоступности прокси-сервера

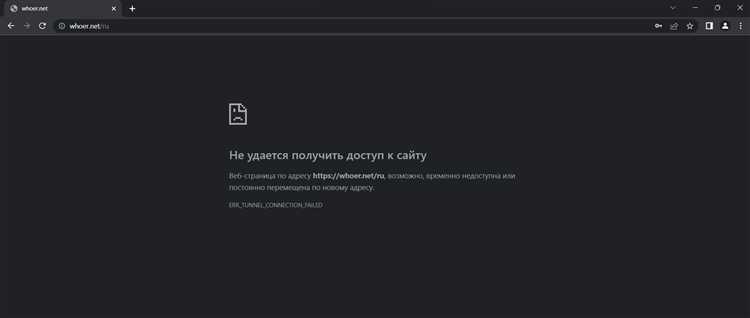

При работе с прокси в Python чаще всего возникают ошибки ProxyError, ConnectTimeout и SSLError. Их следует перехватывать с использованием конструкции try-except, чтобы не прерывать выполнение скрипта.

Для библиотеки requests важно задать тайм-аут через параметр timeout, например: requests.get(url, proxies=proxy, timeout=5). Это исключает зависание при неотвечающем прокси.

Для изоляции проблемных прокси рекомендуется использовать список и исключать из него адреса, вызвавшие ошибку. После перехвата исключения стоит логировать IP, код ошибки и время попытки, чтобы избежать повторного использования нерабочих адресов.

Полезна интеграция с библиотекой backoff или реализация собственной логики повторных попыток с ограничением по количеству. Интервалы между запросами следует увеличивать экспоненциально при повторных неудачах.

Если используется aiohttp, обработку ошибок нужно выполнять в рамках корутин через async with и отлавливать aiohttp.ClientProxyConnectionError и asyncio.TimeoutError.

Для стабильности важно контролировать частоту запросов, использовать пул прокси и автоматическое переключение на следующий адрес при ошибке. Проверка статуса прокси до начала основной работы уменьшает вероятность сбоев.

Как определить анонимность прокси по HTTP-заголовкам

Для определения уровня анонимности прокси используется анализ HTTP-заголовков, передаваемых серверу. Основное внимание уделяется наличию заголовков, указывающих на присутствие промежуточного узла.

Прямое подключение к серверу (без прокси) не добавляет дополнительных заголовков, указывающих на клиента. Использование прокси может изменить это поведение.

При проверке следует отправить HTTP-запрос через прокси на сервер, который отображает заголовки запроса. Подойдёт любой сервис echo-запросов, например httpbin.org.

Ключевые заголовки, по которым определяется уровень анонимности:

- X-Forwarded-For – указывает реальный IP-адрес клиента. Если этот заголовок присутствует и содержит внешний IP, прокси считается прозрачным.

- Via – указывает на использование прокси. Наличие заголовка сигнализирует, что соединение проходило через промежуточный сервер.

- Forwarded – может содержать IP клиента, информацию об используемом протоколе и узле. Присутствие IP клиента делает прокси неанонимным.

- Client-IP и True-Client-IP – часто используются CDN или балансировщиками, но в случае их передачи прокси может утекать исходный IP.

Если в ответе нет ни одного из указанных заголовков, и IP клиента скрыт, прокси можно считать анонимным или элитным.

Пример на Python с использованием библиотеки requests:

import requests

proxies = {

'http': 'http://user:pass@proxy_ip:port',

'https': 'http://user:pass@proxy_ip:port'

}

response = requests.get('https://httpbin.org/headers', proxies=proxies)

print(response.text)

Как измерить скорость отклика прокси-сервера

Для измерения скорости отклика прокси-сервера можно использовать модуль time и библиотеку requests с указанием параметра proxies. Время измеряется от начала запроса до получения ответа. Ниже приведён пошаговый подход.

- Установите зависимости:

pip install requests. - Подготовьте тестовый URL – предпочтительно простой и стабильный ресурс, например,

https://httpbin.org/get. - Создайте словарь прокси в формате:

{ "http": "http://IP:PORT", "https": "http://IP:PORT" } - Вызовите

requests.getс замером времени:import requests import time proxies = { "http": "http://123.123.123.123:8080", "https": "http://123.123.123.123:8080" } url = "https://httpbin.org/get" start = time.monotonic() try: response = requests.get(url, proxies=proxies, timeout=10) latency = time.monotonic() - start print(f"Время отклика: {latency:.3f} секунд") except requests.exceptions.RequestException as e: print(f"Ошибка: {e}")

- Тест желательно повторить несколько раз и усреднить результат.

- Время отклика более 2 секунд – повод исключить прокси из пула.

- Результат зависит от расположения сервера, скорости соединения и стабильности прокси.

Как проверять список прокси на валидность в многопоточном режиме

Для проверки валидности прокси-серверов в многопоточном режиме можно использовать стандартные библиотеки Python, такие как `requests` и `concurrent.futures`. Это позволяет эффективно обрабатывать большое количество прокси-серверов, минимизируя время ожидания ответа и увеличивая скорость обработки списка.

Прежде всего, важно понимать, как работать с прокси-серверами в Python. Для отправки запросов через прокси используется параметр `proxies` в библиотеке `requests`. Основная цель проверки – удостовериться, что прокси действительно доступен, отвечает на запросы и не блокирует их.

Рассмотрим пример кода, который позволяет проверять несколько прокси-серверов одновременно, используя библиотеку `concurrent.futures`. Этот подход обеспечит асинхронную работу и повысит производительность проверки.

Пример кода:

import requests

from concurrent.futures import ThreadPoolExecutor

def check_proxy(proxy):

url = "http://httpbin.org/ip"

proxies = {"http": f"http://{proxy}", "https": f"http://{proxy}"}

try:

response = requests.get(url, proxies=proxies, timeout=5)

if response.status_code == 200:

return proxy, True

except requests.RequestException:

pass

return proxy, False

def check_proxies(proxy_list):

with ThreadPoolExecutor(max_workers=10) as executor:

results = executor.map(check_proxy, proxy_list)

valid_proxies = [proxy for proxy, is_valid in results if is_valid]

return valid_proxies

proxy_list = ['proxy1.example.com:8080', 'proxy2.example.com:8080', 'proxy3.example.com:8080']

valid_proxies = check_proxies(proxy_list)

print(f"Рабочие прокси: {valid_proxies}")

В этом коде создается функция check_proxy, которая проверяет каждый прокси на доступность, отправляя запрос на сервер http://httpbin.org/ip. Это простое API возвращает информацию о текущем IP-адресе, который был использован для запроса, что позволяет проверить, работает ли прокси.

Использование ThreadPoolExecutor позволяет выполнить проверку нескольких прокси одновременно. Параметр max_workers контролирует количество потоков, которые будут работать одновременно. Это можно настроить в зависимости от мощности системы и числа проверяемых прокси.

Важно учитывать, что прокси-серверы могут быть настроены с разной производительностью. Поэтому не всегда нужно проверять каждый прокси с одним и тем же URL. Некоторые прокси могут работать быстрее с другими API или портами. Рекомендуется адаптировать проверку в зависимости от типа прокси.

Для уменьшения нагрузки на серверы и предотвращения блокировок можно добавить небольшие задержки между запросами с помощью параметра time.sleep(). Это будет полезно, если вы работаете с большим количеством прокси, чтобы не перегружать сервера проверки.

Такой подход позволяет быстро фильтровать нерабочие прокси и собирать рабочие серверы для дальнейшего использования, при этом минимизируя время обработки и увеличивая производительность за счет многопоточности.

Как использовать разные прокси для разных запросов в одном скрипте

Для работы с разными прокси в одном скрипте можно использовать библиотеку requests в Python. Чтобы задать разные прокси для различных запросов, нужно динамически изменять настройки прокси для каждого запроса.

Основной способ реализации – использование параметра proxies в каждом запросе. Каждый запрос может использовать отдельный прокси, передаваемый в словаре. Например, для одного запроса можно задать прокси для HTTP, а для другого – для HTTPS.

Пример кода:

import requests

# Прокси для первого запроса (HTTP)

proxy_1 = {

"http": "http://proxy1.example.com:8080",

"https": "http://proxy1.example.com:8080"

}

# Прокси для второго запроса (HTTPS)

proxy_2 = {

"http": "http://proxy2.example.com:8080",

"https": "http://proxy2.example.com:8080"

}

# Первый запрос

response_1 = requests.get("http://example.com", proxies=proxy_1)

print(response_1.status_code)

# Второй запрос

response_2 = requests.get("https://example.com", proxies=proxy_2)

print(response_2.status_code)

Важно помнить, что для каждого запроса может быть настроен отдельный прокси. Это полезно, если требуется распределить нагрузку между различными прокси-серверами или использовать разные IP-адреса для различных типов запросов.

Чтобы повысить безопасность и анонимность, можно также интегрировать использование прокси с цикличной сменой прокси, особенно если работаете с большим количеством запросов. Для этого можно создавать список прокси и случайным образом выбирать прокси для каждого запроса.

Пример с цикличной сменой прокси:

import random

proxies_list = [

{"http": "http://proxy1.example.com:8080", "https": "http://proxy1.example.com:8080"},

{"http": "http://proxy2.example.com:8080", "https": "http://proxy2.example.com:8080"},

{"http": "http://proxy3.example.com:8080", "https": "http://proxy3.example.com:8080"}

]

# Выбор случайного прокси для каждого запроса

proxy = random.choice(proxies_list)

response = requests.get("http://example.com", proxies=proxy)

print(response.status_code)

Такой подход эффективно распределяет запросы и может улучшить производительность при работе с большим количеством данных. Следует также учитывать ограничения прокси-серверов, такие как лимиты на количество запросов или скорость передачи данных.