Индексация сайта поисковыми системами – процесс автоматический. Если WordPress-сайт не готов к публичному показу или содержит технический контент, важно ограничить доступ к его страницам для поисковых роботов. Без этого ваш черновик, тестовая сборка или дублирующий домен могут появиться в выдаче, что повлечёт за собой проблемы с SEO и репутацией ресурса.

Для начала проверьте, не включена ли опция запрета индексации в настройках WordPress: «Настройки» → «Чтение» → «Запретить поисковым системам индексировать сайт». Этот метод прост, но полагается на добросовестность поисковых ботов, игнорирующих инструкции в robots.txt. Надёжнее использовать комплексный подход.

Файл robots.txt позволяет задать конкретные директивы: User-agent: *

Disallow: / – полный запрет индексации. Этот файл должен находиться в корне сайта. Однако стоит учитывать, что файл открыт для просмотра и не защищает данные, а лишь даёт рекомендации поисковикам.

Для критичных случаев стоит использовать защиту на уровне сервера. Добавьте HTTP-авторизацию через файл .htaccess или настройку хостинга. Это исключит возможность сканирования страниц даже при прямом обращении.

Если сайт уже проиндексирован, просто закрыть его от роботов недостаточно. Следует удалить URL из индекса через панели вебмастеров – Google Search Console или Яндекс.Вебмастер. Иначе старые страницы останутся в результатах поиска, пусть даже и без содержимого.

Надёжное закрытие WordPress-сайта от индексации – это не один чекбокс, а системный подход: настройки WordPress, правила в robots.txt, серверные ограничения и работа с вебмастерами. Игнорирование хотя бы одного из шагов может привести к утечке нежелательной информации в индекс поисковых систем.

Отключение индексации через настройки WordPress

WordPress предоставляет встроенную возможность запретить индексацию сайта без установки дополнительных плагинов. Это особенно полезно на этапе разработки или при работе с приватными проектами.

- Перейдите в административную панель WordPress.

- Откройте раздел Настройки → Чтение.

- Найдите опцию «Просить поисковые системы не индексировать сайт».

- Установите флажок напротив этого пункта.

- Нажмите кнопку «Сохранить изменения».

Эта настройка добавляет в код сайта метатег:

<meta name="robots" content="noindex, nofollow">

Также обновляется файл robots.txt с директивой:

User-agent: * Disallow: /

Важно: выполнение этого запрета зависит от добросовестности поисковых роботов. Некоторые боты игнорируют директивы и продолжают сканирование. Для полной уверенности используйте серверные методы ограничения доступа (например, HTTP-аутентификацию).

Использование файла robots.txt для ограничения доступа

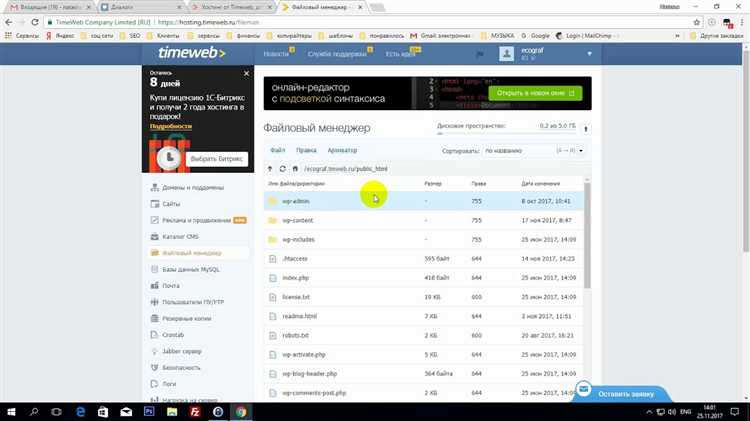

Файл robots.txt размещается в корневом каталоге сайта и управляет поведением поисковых роботов. Для WordPress целесообразно заблокировать технические директории и страницы, не предназначенные для индексации.

Минимальный пример для блокировки большинства ненужных разделов:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-includes/ Disallow: /wp-content/plugins/ Disallow: /?s= Disallow: /readme.html Disallow: /xmlrpc.php

Для избежания блокировки доступа к медиафайлам и стилям, не добавляйте запрет на /wp-content/uploads/ и /wp-content/themes/.

Проверяйте корректность настроек через Google Robots Testing Tool. Ошибки в robots.txt могут привести к частичной или полной деиндексации сайта.

Файл должен быть доступен по адресу https://ваш-домен/robots.txt. После изменений рекомендуется отправить его повторную проверку в Google Search Console.

Добавление мета-тега noindex в шаблон темы

Найдите место между тегами <head> и </head>, предпочтительно сразу после тега <meta charset. Добавьте следующий код:

<?php if (is_front_page() || is_page('контакты') || is_category()) : ?>

<meta name="robots" content="noindex, nofollow">

<?php endif; ?>

В условии is_front_page() можно указать нужные типы страниц или конкретные URL, для которых требуется запрет на индексацию. Используйте is_page('slug') или is_single() для более точного таргетинга.

Изменения вступят в силу сразу после сохранения файла. Убедитесь, что шаблон не кэшируется и не перезаписывается при обновлении темы. Рекомендуется использовать дочернюю тему для сохранения изменений.

Настройка плагина Yoast SEO для запрета индексации

Для запрета индексации сайта через Yoast SEO выполните следующие действия:

- Перейдите в административную панель WordPress.

- Откройте меню SEO → Внешний вид поиска.

- На вкладке Общие отключите индексацию следующих элементов:

- Записи: Установите «Нет» в опции «Показывать записи в результатах поиска?»

- Страницы: Аналогично, выберите «Нет».

- Медиа: Выберите «Нет», если не используете отдельные страницы вложений.

- Перейдите на вкладку Таксономии и для каждой категории и метки установите «Нет» в параметре отображения в результатах поиска.

- На вкладке Архивы отключите авторские и архивы по дате, установив «Нет» для соответствующих опций.

После этого включите опцию «Добавлять meta robots noindex» в разделе SEO → Настройки → Общие, если доступна.

Для полной уверенности в том, что страницы не индексируются, выполните:

- Откройте любую страницу сайта.

- Проверьте в коде наличие мета-тега:

<meta name="robots" content="noindex, follow">

Изменения вступают в силу сразу, однако для удаления уже проиндексированных страниц потребуется вручную запросить удаление через Google Search Console.

Блокировка доступа через .htaccess по User-Agent

Для ограничения индексации сайта WordPress на уровне сервера Apache можно использовать файл .htaccess с директивами, блокирующими доступ по определённым User-Agent.

Добавьте следующий код в корневой .htaccess вашего сайта:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} ^.*(Googlebot|Bingbot|YandexBot|Baiduspider).*$ [NC]

RewriteRule .* - [F,L]

</IfModule>

Объяснение: директива RewriteCond проверяет строку User-Agent каждого запроса. Если она содержит указанных ботов, применяется правило RewriteRule, возвращающее ошибку 403 (доступ запрещён).

Для полной изоляции можно расширить список, добавив другие роботы: AhrefsBot, SemrushBot, MJ12bot. Учитывайте, что часть менее известных ботов может менять идентификаторы или маскироваться под браузеры.

После внесения изменений убедитесь, что модуль mod_rewrite активен на сервере. Проверьте работоспособность, отправив HTTP-запрос с нужным User-Agent с помощью curl:

curl -A "Googlebot" https://example.com

Ожидаемый результат – код ответа 403 Forbidden.

Этот способ эффективен для грубой фильтрации, но не защищает от ручного обхода. Рекомендуется использовать в комплексе с другими методами: robots.txt, noindex-мета и HTTP-заголовками.

Создание страницы-заглушки с кодом ответа 503

Код ответа HTTP 503 указывает на временную недоступность сервера и эффективно сигнализирует поисковым системам не индексировать содержимое. Для реализации страницы-заглушки с этим кодом следует настроить сервер или WordPress так, чтобы при обращении к сайту отдавался именно этот статус.

В WordPress можно добавить следующий PHP-код в файл functions.php активной темы или в отдельный плагин, чтобы на время отключить сайт:

add_action('template_redirect', function() {

if (!current_user_can('administrator')) {

status_header(503);

header('Retry-After: 3600'); // время в секундах до повторной проверки

wp_die('Сайт временно недоступен. Попробуйте позже.', '503 Service Unavailable', ['response' => 503]);

exit;

}

});Для серверов Apache можно создать или изменить файл .htaccess, добавив:

RewriteEngine On

RewriteCond %{REQUEST_URI} !^/maintenance.html$

RewriteCond %{REMOTE_ADDR} !^123\.456\.789\.000$ # IP администратора

RewriteRule .* /maintenance.html [R=503,L]Страница maintenance.html должна содержать понятное сообщение о временной недоступности. Важно, чтобы сервер отправлял именно HTTP 503, что можно проверить через инструменты разработчика браузера или curl.

Использование кода 503 предпочтительнее обычного 404 или 200, так как поисковики не будут воспринимать сайт как навсегда удалённый, а лишь временно закрытый. Это предотвращает потерю позиций в выдаче после восстановления работы ресурса.

Ограничение индексации на уровне хостинга

Для эффективного исключения сайта WordPress из поисковой выдачи можно настроить запрет индексации напрямую на сервере. Один из способов – использование файла .htaccess (для Apache) или конфигурации Nginx.

В .htaccess достаточно добавить следующие строки, запрещающие доступ для поисковых ботов:

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} (Googlebot|Bingbot|Yandex) [NC]

RewriteRule .* - [F,L]

Этот код блокирует доступ основным поисковым роботам, возвращая ошибку 403. Для полного запрета индексации полезно также закрыть весь сайт паролем через .htpasswd, если требуется ограничение для всех пользователей, включая ботов.

Для Nginx аналогичная настройка делается в конфигурационном файле сайта:

if ($http_user_agent ~* (Googlebot|Bingbot|Yandex)) {

return 403;

}

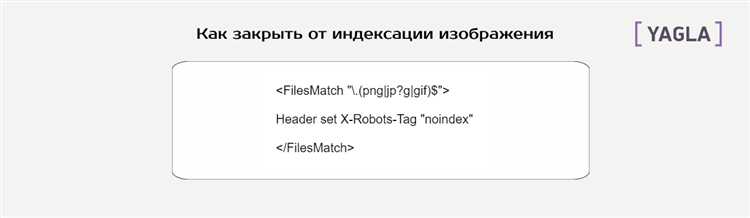

Рекомендуется дополнительно использовать директивы X-Robots-Tag в ответах сервера, например:

add_header X-Robots-Tag "noindex, nofollow";

Это гарантирует, что даже при обходе запретов поисковики не проиндексируют содержимое.

При использовании CDN или прокси-серверов проверяйте, что ограничения применяются до передачи запроса к WordPress.

Проверка закрытия сайта с помощью инструментов вебмастера

После настройки блокировки индексации необходимо подтвердить корректность изменений через специализированные сервисы. Основные инструменты – Google Search Console и Яндекс.Вебмастер.

В Google Search Console следует проверить раздел Покрытие. Если сайт или отдельные страницы закрыты от индексации, там отобразится статус Отказано в индексации или Discovered — currently not indexed. Также важен отчет Тестирование robots.txt: он покажет, блокирует ли файл конкретные URL.

В Яндекс.Вебмастере в разделе Индексация проверяйте статистику сканирования и состояние страниц. Если сайт закрыт, в отчете появятся ошибки типа Запрещено robots.txt или Страница запрещена к индексации. Рекомендуется использовать инструмент Проверка robots.txt для анализа правил и проверки отдельных адресов.

Дополнительно стоит протестировать наличие метатега noindex через инструмент Проверка страниц. Его отсутствие или неправильное применение может привести к ошибкам индексации.

Регулярно анализируйте логи сканирования, чтобы убедиться, что роботы не получают доступ к закрытым разделам. Совместное использование Google Search Console и Яндекс.Вебмастера позволяет быстро выявлять и исправлять ошибки блокировки.

Вопрос-ответ:

Как полностью закрыть сайт на WordPress от появления в результатах поисковых систем?

Чтобы исключить сайт из поиска, нужно запретить его индексирование поисковыми роботами. Для этого можно воспользоваться стандартной функцией WordPress, которая отключает индексирование сайта через настройки приватности. Также можно настроить файл robots.txt, добавив туда правило «Disallow: /», чтобы запретить доступ для всех роботов. Дополнительно стоит проверить наличие мета-тегов noindex в заголовках страниц, чтобы поисковые системы не добавляли их в базу данных.

Какие ошибки чаще всего приводят к тому, что сайт на WordPress всё равно индексируется после попытки закрыть его?

Часто пользователи забывают очистить кэш после внесения изменений, поэтому старые настройки остаются активными. Ещё распространённая причина — неправильно настроенный файл robots.txt, где правило запрещения доступа написано с ошибками. Иногда плагины SEO или кэширования перезаписывают мета-теги, из-за чего поисковики продолжают индексировать страницы. Также бывает, что сайт уже был проиндексирован ранее, и его страницы ещё отображаются в поиске некоторое время, пока не обновится индекс.

Можно ли закрыть только отдельные разделы сайта WordPress от индексации, а остальное оставить доступным для поисковиков?

Да, это вполне реально. Для этого в файл robots.txt добавляют конкретные директивы, например, запрещают сканирование определённых папок или страниц. Также можно использовать плагины для SEO, которые позволяют задать правила noindex для выбранных записей или категорий. Важно при этом не закрывать главную страницу и другие ключевые разделы, если вы хотите, чтобы они продолжали отображаться в результатах поиска.

Нужно ли дополнительно защищать сайт паролем, если он закрыт от индексирования поисковиками?

Закрытие сайта от индексации не ограничивает доступ к нему для пользователей и роботов, которые заходят напрямую по ссылкам. Если нужна полная защита и скрытие содержимого от посторонних, стоит рассмотреть установку пароля на сайт или отдельные его разделы. Это значительно повысит уровень приватности и исключит возможность случайного просмотра контента. В некоторых случаях это может быть особенно полезно для тестовых или временных сайтов.