Создание собственной нейросети с нуля – не академический эксперимент, а практический способ понять, как работает машинное обучение. В этой статье мы построим простую полносвязную нейросеть на Python, используя только библиотеку NumPy. Никаких фреймворков вроде TensorFlow или PyTorch – только голая логика и линейная алгебра.

Нейросеть будет состоять из одного скрытого слоя и сможет решать задачу бинарной классификации. В качестве примера возьмём синтетический датасет с двумя классами, генерируемый с помощью make_classification из sklearn.datasets. Модель будет обучаться методом градиентного спуска с функцией потерь binary cross-entropy.

В процессе мы реализуем прямое распространение сигнала, обратное распространение ошибки (backpropagation) и обновление весов. Особое внимание уделим инициализации параметров, выбору размера шага градиентного спуска и активационной функции sigmoid, так как эти аспекты критически влияют на стабильность обучения.

После обучения нейросети проведём тестирование на отложенной выборке, визуализируем границу принятия решений и рассмотрим метрики качества – точность, precision, recall. Такой подход даст не просто код, а глубокое понимание механики обучения модели.

Выбор библиотеки для создания нейросети и её установка

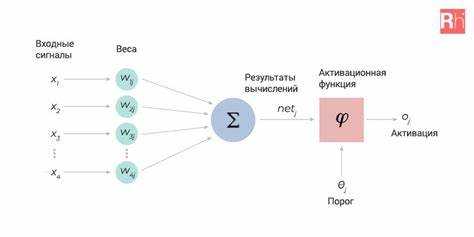

Для создания простой нейросети на Python оптимальным выбором будет библиотека TensorFlow или PyTorch. Если задача – быстрое прототипирование с минимальным количеством кода, предпочтительнее использовать Keras – высокоуровневую обёртку над TensorFlow.

TensorFlow стабилен, активно развивается и предлагает широкий набор инструментов, включая TensorBoard для визуализации. PyTorch удобен для динамических графов вычислений, что облегчает отладку и обучение. В учебных проектах проще начать с Keras, встроенного в TensorFlow начиная с версии 2.0.

Для установки TensorFlow выполните:

pip install tensorflowДля PyTorch необходимо выбрать конфигурацию под вашу систему и CUDA-версию на официальном сайте pytorch.org, затем скопировать предложенную команду, например:

pip install torch torchvision torchaudioУбедитесь, что используется Python версии 3.8–3.11 и установлен менеджер пакетов pip версии не ниже 21.3. Установка внутри виртуального окружения (venv) обязательна, чтобы избежать конфликтов между зависимостями.

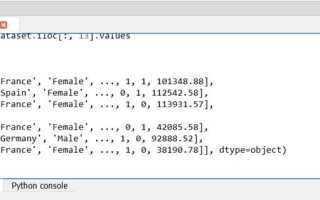

Подготовка обучающих данных в формате NumPy

Для эффективного обучения нейросети требуется строго структурированный набор данных. Библиотека NumPy предоставляет оптимальный формат для хранения и обработки числовых массивов. Рассмотрим, как подготовить входные и выходные данные для простейшей нейросети.

- Импортируйте библиотеку NumPy:

import numpy as np - Определите входные данные (фичи). Пример: обучающая выборка с двумя признаками:

X = np.array([ [0, 0], [0, 1], [1, 0], [1, 1] ]) - Задайте целевые значения (лейблы), соответствующие каждой строке:

y = np.array([ [0], [1], [1], [0] ]) - Убедитесь, что размеры совпадают:

X.shape = (n_samples, n_features),y.shape = (n_samples, 1). - Проверьте тип данных:

X.dtypeиy.dtypeдолжны бытьfloat32илиfloat64для обеспечения совместимости с весами нейросети:X = X.astype(np.float32) y = y.astype(np.float32) - При необходимости нормализуйте входные значения:

X = X / np.max(X) - Для случайной подачи данных в процессе обучения перемешайте выборку:

indices = np.random.permutation(len(X)) X = X[indices] y = y[indices]

Подготовленные массивы X и y готовы к подаче в модель. NumPy обеспечивает высокую производительность при пакетной обработке данных и упрощает реализацию градиентного спуска.

Создание структуры нейросети вручную без готовых моделей

Для ручного построения нейросети потребуется реализовать базовые компоненты: инициализацию весов, функцию активации, прямое распространение сигнала (forward pass) и обратное распространение ошибки (backpropagation).

1. Инициализация параметров:

Весовые коэффициенты и смещения нужно задать вручную. Для стабильной сходимости используют инициализацию по методу Хе или Ксавье. Пример инициализации для одного скрытого слоя:

import numpy as np

input_size = 3

hidden_size = 4

output_size = 1

W1 = np.random.randn(hidden_size, input_size) * np.sqrt(2. / input_size)

b1 = np.zeros((hidden_size, 1))

W2 = np.random.randn(output_size, hidden_size) * np.sqrt(2. / hidden_size)

b2 = np.zeros((output_size, 1))

2. Функция активации:

Рекомендуется использовать ReLU для скрытых слоёв и сигмоиду для последнего слоя при бинарной классификации.

def relu(z):

return np.maximum(0, z)

def sigmoid(z):

return 1 / (1 + np.exp(-z))

3. Прямое распространение:

def forward(X):

Z1 = np.dot(W1, X) + b1

A1 = relu(Z1)

Z2 = np.dot(W2, A1) + b2

A2 = sigmoid(Z2)

return Z1, A1, Z2, A2

4. Обратное распространение:

Вычисляем градиенты вручную на основе производных функций активации. Пример для одного скрытого слоя:

def relu_derivative(z):

return (z > 0).astype(float)

def backward(X, Y, Z1, A1, Z2, A2):

m = X.shape[1]

dZ2 = A2 - Y

dW2 = (1/m) * np.dot(dZ2, A1.T)

db2 = (1/m) * np.sum(dZ2, axis=1, keepdims=True)

dA1 = np.dot(W2.T, dZ2)

dZ1 = dA1 * relu_derivative(Z1)

dW1 = (1/m) * np.dot(dZ1, X.T)

db1 = (1/m) * np.sum(dZ1, axis=1, keepdims=True)

return dW1, db1, dW2, db2

5. Обновление параметров:

def update_parameters(learning_rate, dW1, db1, dW2, db2):

global W1, b1, W2, b2

W1 -= learning_rate * dW1

b1 -= learning_rate * db1

W2 -= learning_rate * dW2

b2 -= learning_rate * db2

Так реализуется базовая нейросеть с одним скрытым слоем. Для расширения достаточно добавить слои и повторить шаги для каждого.

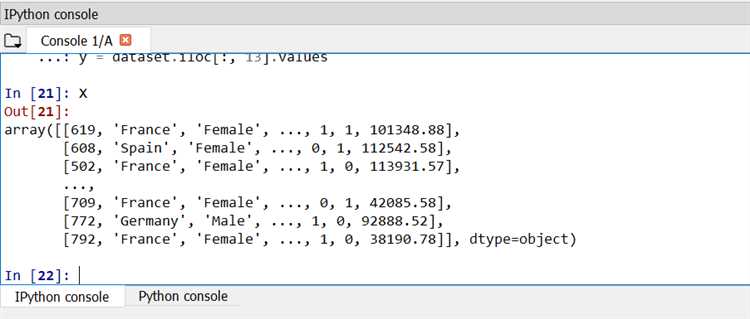

Реализация функции активации и её применение

Функция активации определяет выход нейрона и позволяет сети моделировать нелинейные зависимости. Наиболее популярна ReLU (Rectified Linear Unit), так как она проста и эффективна при обучении глубоких сетей.

Для реализации ReLU на Python используется функция:

def relu(x):

return max(0, x)

Для применения ReLU к вектору входов используют list comprehension:

inputs = [0.5, -0.3, 2.1, -1.5]

activated = [relu(x) for x in inputs]

Для обучения с обратным распространением также необходима производная функции. Для ReLU она равна 1 при x > 0 и 0 иначе:

def relu_derivative(x):

return 1 if x > 0 else 0

В более сложных случаях функции применяются к массивам NumPy для повышения производительности:

import numpy as np

def relu(x):

return np.maximum(0, x)

def relu_derivative(x):

return (x > 0).astype(float)

Функция активации добавляется на этапе прямого прохода после взвешенной суммы входов:

z = np.dot(weights, inputs) + bias

a = relu(z)

На этапе обратного прохода используется производная для коррекции градиентов:

delta = error * relu_derivative(z)

Правильный выбор и реализация функции активации критичны для сходимости модели. ReLU предпочтительна в скрытых слоях, но для выходного слоя задачи классификации применяется softmax или sigmoid.

Обучение нейросети с помощью градиентного спуска

Алгоритм начинается с случайных значений весов нейросети. Затем на каждом шаге вычисляется градиент функции потерь по отношению к весам, и веса обновляются с учетом этого градиента. Для этого используется следующая формула:

w = w - η * ∇L(w)

где w – веса, η – скорость обучения, ∇L(w) – градиент функции потерь по весам.

Скорость обучения η определяет, насколько сильно будут изменяться веса на каждом шаге. Если значение слишком большое, алгоритм может «перепрыгнуть» минимум, если слишком маленькое – процесс обучения будет слишком медленным. Рекомендуется начинать с малых значений скорости обучения, например, 0.01, и корректировать в процессе обучения.

Для эффективного обучения часто используют вариации градиентного спуска. Один из самых популярных методов – стохастический градиентный спуск (SGD). В отличие от стандартного метода, который использует всю выборку для вычисления градиента, стохастический метод обновляет веса после каждого примера, что ускоряет процесс, особенно для больших наборов данных.

Существует также мини-батч градиентный спуск, который сочетает оба подхода. Здесь данные делятся на небольшие группы (мини-батчи), и веса обновляются после обработки каждого батча. Это позволяет сбалансировать скорость и точность обучения.

Важно учитывать, что градиентный спуск может застревать в локальных минимумах, особенно в сложных многослойных нейросетях. Для решения этой проблемы могут использоваться различные методы, такие как использование методов улучшенной инициализации весов или применение функций активации, которые способствуют лучшему распространению градиента.

Дополнительно рекомендуется использовать методы регуляризации, такие как L2-регуляризация, для предотвращения переобучения. Эти методы помогают уменьшить влияние сильно изменяющихся весов, что делает модель более обобщенной и стабильной.

Таким образом, градиентный спуск является основным инструментом для обучения нейросетей, однако для достижения наилучших результатов важно правильно настроить параметры, такие как скорость обучения, размер мини-батча и методы регуляризации.

Проверка точности модели на новых данных

После того как нейросеть обучена на тренировочных данных, важно проверить, как она будет работать на новых, не виденных ранее данных. Это позволяет оценить её обобщающую способность, то есть способность применять полученные знания к задачам, которые не были представлены в процессе обучения.

Для этой цели обычно используется отдельный набор данных – тестовая выборка. В идеале тестовые данные должны быть независимы от тренировочных, чтобы исключить возможное переобучение модели.

Проверка точности модели на новых данных начинается с предсказания модели на тестовых данных. Важно, чтобы эти данные были в том же формате, что и тренировочные, иначе результаты могут быть искажены. Для этого нужно подготовить тестовые данные таким образом, чтобы они соответствовали тем же признакам и категориям, что и исходные данные.

После того как модель сделает предсказания, можно сравнить их с реальными метками тестовых данных. Одним из наиболее популярных методов оценки точности является вычисление точности (accuracy), которая определяется как доля правильных предсказаний от общего числа. Формула для точности выглядит так:

Accuracy = (Количество правильных предсказаний) / (Общее количество примеров)

Однако точность – не всегда лучший показатель, особенно если данные сильно несбалансированы. Например, если один класс встречается гораздо реже, чем другие, модель может показывать высокий процент точных предсказаний, просто предсказывая наиболее частый класс. В таких случаях полезно использовать дополнительные метрики: F1-меру, точность и полноту (precision и recall).

F1-меру можно рассчитать по формуле:

F1 = 2 * (precision * recall) / (precision + recall)

Где точность (precision) – это доля правильных положительных предсказаний среди всех предсказанных положительных, а полнота (recall) – это доля правильных положительных предсказаний среди всех реальных положительных примеров.

Кроме того, полезно использовать кривую ROC (Receiver Operating Characteristic) и вычисление AUC (Area Under Curve). Эта метрика помогает понять, насколько модель способна различать положительные и отрицательные примеры, независимо от порога классификации.

Для оценки работы модели можно воспользоваться инструментами, такими как sklearn в Python. Библиотека предоставляет удобные функции для вычисления всех перечисленных метрик, что значительно упрощает процесс оценки.

Наконец, не забывайте, что тестирование модели на новых данных должно быть частью цикла непрерывной проверки и улучшения. Если точность модели на тестовых данных значительно ниже, чем на тренировочных, это может свидетельствовать о переобучении. В таком случае стоит рассмотреть изменение гиперпараметров или использование более сложных методов регуляризации.

Вопрос-ответ:

Что такое простая нейросеть и как она работает?

Простая нейросеть – это математическая модель, которая имитирует работу человеческого мозга и может обучаться на данных. Она состоит из нейронов, объединённых в слои. Входные данные проходят через слои, где каждый нейрон выполняет определённые вычисления и передаёт результат на следующий слой. На выходе нейросеть даёт предсказания или решения, которые могут быть использованы в различных задачах, например, для классификации или регрессии. Алгоритмы обучения нейросети помогают оптимизировать её параметры для достижения наилучших результатов.

Какие шаги нужно выполнить, чтобы создать простую нейросеть на Python?

Для создания нейросети на Python нужно выполнить несколько шагов. Во-первых, установить библиотеки, такие как TensorFlow или PyTorch. Затем необходимо подготовить данные: их нужно разделить на обучающую и тестовую выборки. После этого создаём модель нейросети, определяя количество слоёв и нейронов в каждом слое. Далее, настраиваем функцию потерь и оптимизатор, чтобы нейросеть могла обучаться. Важным шагом является обучение модели на обучающих данных, после чего модель проверяется на тестовых данных для оценки её качества.

Какие библиотеки Python лучше всего подходят для создания нейросетей?

Для создания нейросетей в Python популярными библиотеками являются TensorFlow и Keras, которые часто используются для глубокого обучения. TensorFlow предоставляет мощные инструменты для построения и обучения нейросетей, а Keras упрощает создание моделей, делая процесс более удобным и быстрым. Также стоит упомянуть PyTorch, который активно используется в научных исследованиях и имеет более гибкий подход к созданию моделей. Другими важными библиотеками для работы с нейросетями являются NumPy для работы с массивами данных и Matplotlib для визуализации результатов.

Что такое обучение нейросети и какие бывают его типы?

Обучение нейросети – это процесс оптимизации её параметров (весов и смещений), чтобы она могла делать точные предсказания. Существует несколько типов обучения нейросети: обучение с учителем, обучение без учителя и обучение с подкреплением. В обучении с учителем нейросеть обучается на размеченных данных, то есть каждое входное значение сопровождается правильным ответом. В обучении без учителя данные не размечены, и задача нейросети заключается в поиске скрытых структур в данных, например, кластеризации. Обучение с подкреплением включает в себя процесс обучения агента, который принимает решения и получает обратную связь в виде награды или наказания.

Как оценить качество работы нейросети?

Качество работы нейросети обычно оценивается с помощью различных метрик, которые зависят от типа задачи. Например, для задач классификации часто используют точность, полноту, F-меру и матрицу ошибок, чтобы оценить, насколько правильно модель классифицирует данные. Для задач регрессии применяют среднеквадратичную ошибку (MSE) или среднюю абсолютную ошибку (MAE), чтобы измерить отклонение предсказанных значений от реальных. Также важным этапом является использование тестовой выборки, которая не использовалась в процессе обучения, для оценки того, как хорошо модель будет работать на новых данных.