Парсинг веб-страниц на PHP остаётся востребованной задачей при интеграции с внешними сервисами, мониторинге цен, агрегации контента и автоматизации. Вместо использования универсальных решений важно понимать, как вручную обрабатывать HTML-структуру и работать с сетью средствами самого языка.

Простейший способ получить содержимое страницы – функция file_get_contents(). Однако она не подходит для сложных сценариев: не поддерживает cookies, редиректы, авторизацию и прокси. В таких случаях лучше использовать cURL, предоставляющий полный контроль над HTTP-запросами. Пример инициализации запроса с передачей заголовков и user-agent:

$ch = curl_init(‘https://example.com’);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

curl_setopt($ch, CURLOPT_HTTPHEADER, [‘User-Agent: Mozilla/5.0’]);

$html = curl_exec($ch);

curl_close($ch);

После получения HTML-разметки её нужно разобрать. Для этого подходит библиотека DOMDocument, встроенная в PHP. В отличие от регулярных выражений, она сохраняет структуру и позволяет обращаться к элементам по тегам, классам и id. Для XPath-запросов к DOM-дереву можно подключить DOMXPath, что значительно упрощает выборку данных.

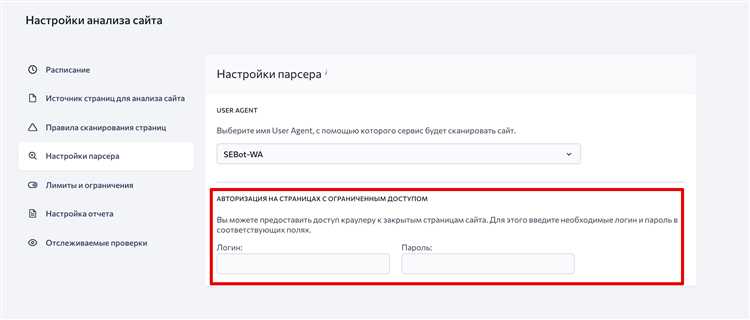

Также стоит учитывать защиту от парсинга: многие сайты используют JavaScript-рендеринг, проверку заголовков, капчи. Решения: использовать headless-браузеры через API, подключать прокси-сервера, реализовать задержки между запросами. Без соблюдения этих мер сервер может заблокировать IP или подать фальшивый контент.

Ниже будут представлены рабочие примеры парсинга с использованием базовых и сторонних инструментов, включая Goutte и Symfony DomCrawler. Эти библиотеки ускоряют разработку и делают код более читаемым.

Выбор и установка библиотеки для HTTP-запросов в PHP

- Guzzle – это HTTP-клиент, который поддерживает синхронные и асинхронные запросы, автоматически обрабатывает редиректы, заголовки, куки, таймауты и прокси. Полностью совместим с PSR-7 и широко используется в экосистеме PHP.

Установка Guzzle выполняется через Composer:

composer require guzzlehttp/guzzleПосле установки можно подключить автозагрузку и использовать клиент:

require 'vendor/autoload.php';

use GuzzleHttp\Client;

$client = new Client();

$response = $client->request('GET', 'https://example.com');

$html = $response->getBody()->getContents();

Дополнительные рекомендации:

- Убедитесь, что в системе установлен Composer. Если нет – скачайте с getcomposer.org.

- При работе с HTTPS-сайтами используйте опцию

verifyдля контроля SSL-сертификатов. - Не отключайте SSL-проверку в боевых проектах:

'verify' => falseдопустимо только для отладки. - Для имитации браузерного поведения указывайте заголовки

User-AgentиReferer.

Использование Guzzle позволяет контролировать каждый этап запроса и легко обрабатывать ошибки, что критично при парсинге нестабильных или защищённых сайтов.

Обработка HTML-кода с помощью DOMDocument и DOMXPath

Для извлечения данных из HTML-страниц в PHP часто используется класс DOMDocument, который предоставляет мощные средства для работы с HTML и XML. Вместе с DOMXPath этот инструмент позволяет эффективно и гибко искать элементы на странице, используя запросы, подобные SQL. Рассмотрим, как можно использовать эти инструменты для парсинга HTML-кода.

Первым шагом является создание объекта DOMDocument и загрузка в него HTML-кода. Это можно сделать с помощью метода loadHTML. Однако перед этим стоит убедиться, что HTML-код корректен, так как DOMDocument не всегда правильно обрабатывает некорректно закрытые теги или невалидный код. Для этого можно использовать флаг libxml_use_internal_errors(true) для подавления предупреждений.

$dom = new DOMDocument();

libxml_use_internal_errors(true);

$dom->loadHTML($html);

После загрузки HTML-кода можно использовать DOMXPath для выполнения запросов к DOM-дереву. Это позволяет выбирать элементы по тегам, классам, id или аттрибутам, используя удобный синтаксис XPath.

Пример поиска всех ссылок на странице:

$xpath = new DOMXPath($dom);

$nodes = $xpath->query('//a[@href]');

foreach ($nodes as $node) {

echo $node->getAttribute('href') . "\n";

}

Этот запрос вернет все элементы <a>, у которых есть атрибут href. Метод query позволяет использовать XPath-выражения для выборки элементов, что значительно упрощает задачу по обработке HTML.

Для более сложных операций, таких как фильтрация элементов по нескольким условиям, можно комбинировать условия в запросах. Например, для поиска ссылок с определенным классом:

$nodes = $xpath->query('//a[contains(@class, "example-class")]');

foreach ($nodes as $node) {

echo $node->getAttribute('href') . "\n";

}

Этот запрос найдет все ссылки с классом, содержащим строку «example-class». Функция contains полезна, когда класс может быть частью более длинного списка классов.

Важно помнить, что DOMXPath работает с уже загруженным DOM-деревом, и каждый запрос к нему требует перебора элементов, что может быть ресурсозатратно для больших страниц. Для повышения производительности стоит выбирать только те элементы, которые необходимы, и избегать излишних запросов к DOM-дереву.

Если требуется манипулировать содержимым элементов, а не только извлекать их, можно использовать методы DOMDocument для изменения структуры документа. Например, для изменения текста внутри элемента:

$element = $xpath->query('//h1')->item(0);

$element->nodeValue = 'Новый заголовок';

Этот код изменяет текст внутри первого найденного элемента <h1>.

С помощью DOMDocument и DOMXPath можно создавать мощные парсеры для извлечения, обработки и модификации данных на веб-страницах. Эти инструменты предоставляют гибкость и точность, необходимые для работы с различными структурами HTML-кода, обеспечивая эффективную обработку и манипуляцию с контентом.

Получение данных со страниц с помощью cURL

Для получения данных с веб-страниц в PHP часто используется библиотека cURL. Этот инструмент позволяет отправлять HTTP-запросы, получать ответы и обрабатывать их. Важно понимать, как настроить cURL для работы с различными типами запросов и корректно обрабатывать результаты.

Основной функцией для работы с cURL в PHP является curl_init(), которая инициализирует сессию. После этого нужно настроить параметры запроса с помощью curl_setopt(), а затем выполнить запрос с помощью curl_exec().

Пример простого запроса GET:

Для обработки ошибок важно использовать функцию curl_error(), которая возвращает описание ошибки, если она возникла во время выполнения запроса:

Для работы с другими типами HTTP-запросов, например, POST, необходимо использовать параметр CURLOPT_POST:

'value1', 'key2' => 'value2');

// Настройка параметров запроса

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

curl_setopt($ch, CURLOPT_POST, true);

curl_setopt($ch, CURLOPT_POSTFIELDS, http_build_query($data));

// Выполнение запроса

$response = curl_exec($ch);

// Закрытие сессии

curl_close($ch);

echo $response;

?>

При отправке POST-запроса важно правильно формировать тело запроса. В примере используется http_build_query(), чтобы преобразовать массив данных в строку, подходящую для отправки через HTTP POST.

Дополнительно, для работы с заголовками HTTP можно настроить параметр CURLOPT_HTTPHEADER, чтобы отправить нужные заголовки:

Для обработки страниц с аутентификацией можно добавить параметр CURLOPT_USERPWD для передачи имени пользователя и пароля:

Для повышения безопасности запросов следует использовать CURLOPT_SSL_VERIFYPEER для проверки подлинности SSL-сертификатов, особенно при работе с HTTPS-сайтами:

Таким образом, cURL в PHP предоставляет мощный и гибкий инструмент для работы с веб-страницами, позволяя не только получать данные, но и взаимодействовать с веб-сайтами через различные методы HTTP-запросов, а также обрабатывать ответы и ошибки.

Извлечение текста, ссылок и изображений из HTML-структуры

Для извлечения текста из HTML-страницы, нужно использовать метод getElementsByTagName. С его помощью можно обратиться к любому тегу, например, к p для абзацев, или h1 для заголовков. Каждый найденный элемент можно обрабатывать через метод nodeValue, который возвращает текстовое содержимое тега.

Пример кода для извлечения текста из всех абзацев:

$dom = new DOMDocument;

@$dom->loadHTML($html);

$paragraphs = $dom->getElementsByTagName('p');

foreach ($paragraphs as $paragraph) {

echo $paragraph->nodeValue . "

";

}

Для извлечения ссылок, нужно искать все элементы с тегом a. Атрибут href в каждом таком элементе содержит URL ссылки. Чтобы получить все ссылки на странице, можно использовать следующий код:

$links = $dom->getElementsByTagName('a');

foreach ($links as $link) {

echo $link->getAttribute('href') . "

";

}

Для получения изображений из страницы, необходимо извлекать элементы с тегом img и атрибут src, который указывает на источник изображения. Пример кода для извлечения всех изображений:

$images = $dom->getElementsByTagName('img');

foreach ($images as $image) {

echo $image->getAttribute('src') . "

";

}

Для более сложных случаев можно комбинировать методы для фильтрации и обработки данных. Например, можно извлекать изображения только из определённых частей страницы или фильтровать ссылки по домену.

Использование DOMDocument эффективно для обработки небольших и средних по размеру страниц. Для работы с большими объёмами данных или страницами, содержащими сложную JavaScript-логику, могут потребоваться более продвинутые инструменты, такие как Goutte или Symfony Panther, которые предоставляют больше возможностей для парсинга динамического контента.

Работа с пагинацией при парсинге многосекционных сайтов

Пагинация на сайтах позволяет разбивать контент на несколько страниц, что особенно важно при парсинге больших объемов данных. При работе с многосекционными сайтами важно грамотно обрабатывать пагинацию, чтобы парсер мог эффективно обходить все разделы и страницы.

Основные шаги при реализации пагинации:

- Анализ структуры URL. На большинстве сайтов пагинация реализована через изменение параметров в URL (например, &page=2 или §ion=3). Важно изучить, как строятся ссылки для последующих страниц, чтобы правильно сгенерировать запросы.

- Извлечение ссылок на следующие страницы. Используйте регулярные выражения или парсеры для извлечения ссылок с метками страниц, например, «Следующая страница» или номер страницы в URL.

- Обработка переходов по страницам. После извлечения ссылки для следующей страницы, необходимо отправить HTTP-запрос и обработать ответ. Важно учитывать, что при переходе на новую страницу структура контента может измениться, поэтому нужно динамически адаптировать парсер.

- Прекращение парсинга. Пагинация должна завершаться, когда на странице больше не будет ссылок на следующую страницу или когда номер текущей страницы превышает максимальный доступный. Это можно определить по последнему числу в номере страницы или по отсутствию активных ссылок.

Рекомендации:

- Использование библиотеки cURL для работы с HTTP-запросами и получения данных с каждой страницы.

- Оптимизация запросов. Убедитесь, что парсер не отправляет запросы слишком часто, чтобы избежать блокировки или перегрузки сайта.

- Обработка ошибок. Для каждого запроса необходимо проверять статус ответа, чтобы избежать парсинга пустых или ошибочных страниц.

- Обработка различных форматов контента. На одной странице может быть представлено несколько разделов с разной структурой (например, товары, новости, статьи). Важно правильно извлечь нужные данные с каждой страницы.

Пример кода для обработки пагинации:

Таким образом, при парсинге многосекционных сайтов важно правильно организовать обход всех страниц и учесть возможные особенности пагинации. Это позволяет собрать весь необходимый контент без пропусков и ошибок.

Обработка ошибок при недоступности сайта или изменении структуры

При разработке парсера важно предусмотреть способы обработки ошибок, связанных с недоступностью сайта или изменениями в его структуре. Необходимо правильно реагировать на различные проблемы, чтобы обеспечить стабильность работы программы.

Недоступность сайта может быть вызвана различными причинами: сервер временно не работает, изменен IP-адрес или сайт заблокирован. Для корректной обработки ошибок важно использовать механизмы проверки доступности сайта. Пример простого подхода на PHP:

$site_url = 'https://example.com';

$response = @file_get_contents($site_url);

if ($response === FALSE) {

echo 'Ошибка: сайт недоступен';

} else {

echo 'Сайт доступен';

}

Этот код использует оператор @ для подавления предупреждений и проверяет, вернулась ли корректная информация с сайта. В случае ошибки можно вывести сообщение или заняться дополнительными действиями (например, отправить уведомление).

Изменение структуры сайта также требует внимательной настройки парсера. Структура HTML может изменяться, и парсер, который полагается на фиксированные теги или классы, может перестать работать. Чтобы избежать этого, можно использовать несколько стратегий:

1. Использование регулярных выражений для поиска данных, не зависящих от точной структуры. Например, если нужно извлечь цены с сайта, можно искать шаблон, соответствующий числовым значениям, а не конкретные теги.

2. Реализация логики на основе XPath или CSS-селекторов, что позволяет гибко адаптироваться к изменениям структуры. Пример с использованием библиотеки simplehtmldom:

$html = file_get_html('https://example.com');

$price = $html->find('.product-price', 0);

if ($price) {

echo 'Цена: ' . $price->plaintext;

} else {

echo 'Ошибка: не найден элемент с ценой';

}

3. Проверка наличия обязательных элементов на странице перед их обработкой. Например, если парсер ожидает загрузки списка товаров, важно сначала проверить наличие самого списка:

$items = $html->find('.product-list');

if (count($items) > 0) {

foreach ($items as $item) {

// Обработка данных товара

}

} else {

echo 'Ошибка: список товаров не найден';

}

Кроме того, полезно добавить в код механизмы логирования ошибок, чтобы можно было быстро понять, что произошло и устранить проблему. Запись ошибок в файл или базу данных поможет в будущем быстрее выявлять и исправлять неполадки.

Обработка исключений с помощью try-catch позволяет гибко реагировать на сбои и ошибки. Например, при загрузке страницы:

try {

$html = file_get_html('https://example.com');

if (!$html) {

throw new Exception('Не удалось загрузить страницу');

}

} catch (Exception $e) {

echo 'Ошибка: ' . $e->getMessage();

}

Такой подход позволяет не только ловить стандартные ошибки, но и самостоятельно определять, что именно пошло не так в процессе работы парсера.

Сохранение результатов парсинга в файл или базу данных

После того как парсер извлек данные с веб-страниц, важно правильно их сохранить для дальнейшей обработки или анализа. В зависимости от задачи, можно использовать два основных способа: сохранение данных в файл или в базу данных. Каждый из этих методов имеет свои особенности.

Сохранение в файл: Это один из самых простых и быстрых методов. Для этого часто используют форматы CSV, JSON или XML, которые легко обрабатываются и читаются. В PHP для работы с файлами можно использовать функции fopen(), fwrite() и fclose(). Например, если нужно сохранить данные в CSV, можно записывать их построчно:

Важный момент: при записи в файл следует проверять наличие и права доступа к нему, чтобы избежать ошибок. Если файл существует, можно использовать file_exists() для его проверки.

Сохранение в базу данных: Этот метод предпочтительнее для обработки больших объемов данных или когда требуется последующий анализ и манипуляции с ними. Для работы с базой данных в PHP чаще всего используют расширение PDO или mysqli.

Пример сохранения данных в базу данных с использованием PDO:

setAttribute(PDO::ATTR_ERRMODE, PDO::ERRMODE_EXCEPTION);

$stmt = $pdo->prepare("INSERT INTO table_name (column1, column2) VALUES (?, ?)");

foreach ($data as $row) {

$stmt->execute([$row['value1'], $row['value2']]);

}

} catch (PDOException $e) {

echo 'Ошибка: ' . $e->getMessage();

}

?>

При работе с базой данных важно учитывать оптимизацию запросов и использование подготовленных выражений для предотвращения SQL-инъекций.

Что выбрать? Если данные нужны для быстрого просмотра или анализа, и их объем не слишком велик, сохранение в файл будет оптимальным выбором. Для более сложных задач, где необходимо выполнять поиск, фильтрацию или связку данных, лучше использовать базу данных. Базы данных обеспечивают большую гибкость и масштабируемость в долгосрочной перспективе.

Вопрос-ответ:

Что такое парсер сайта на PHP и для чего он нужен?

Парсер сайта на PHP — это скрипт или программа, предназначенная для извлечения данных с веб-страниц. Он может быть полезен для сбора информации с сайтов, например, ценовых предложений, новостей, контактов или любых других данных, которые обновляются на веб-страницах. Основная задача парсера — автоматизировать процесс получения информации без необходимости вручную просматривать страницы.

Как можно начать создавать парсер для сайта на PHP?

Для начала создания парсера на PHP, нужно определиться с инструментами. Наиболее популярным методом является использование библиотеки cURL для загрузки страниц и библиотек для парсинга HTML, таких как Simple HTML DOM или Symfony DomCrawler. Первым шагом будет написание кода для получения содержимого веб-страницы с использованием cURL, затем нужно распарсить полученный HTML-код с помощью одной из библиотек.

Какие проблемы могут возникнуть при написании парсера на PHP?

При создании парсера могут возникнуть несколько проблем. Во-первых, не все сайты разрешают автоматический сбор данных, и за это можно получить блокировку IP-адреса или другие ограничения. Во-вторых, структура HTML-кода на сайте может изменяться, что приведет к сбоям в работе парсера. Также важна скорость работы: если парсер слишком часто отправляет запросы на сервер, это может привести к его перегрузке или блокировке. Нужно учитывать такие моменты, как обработка ошибок и логирование.

Какие существуют способы обработки данных, полученных с помощью парсера на PHP?

После того как парсер собрал данные, их можно обработать несколькими способами. Во-первых, можно сохранить данные в базу данных для дальнейшей обработки и использования. Во-вторых, можно экспортировать информацию в файл (например, CSV или JSON). Кроме того, данные могут быть использованы для формирования отчетов, обновления контента на других веб-страницах или для анализа трендов и статистики.

Можно ли использовать парсер на PHP для парсинга сложных сайтов с динамическим контентом?

Для парсинга сложных сайтов, где контент загружается через JavaScript, стандартные парсеры, использующие cURL или Simple HTML DOM, не подойдут. В таких случаях можно использовать инструменты, которые способны имитировать работу браузера, такие как библиотека Goutte или интеграция с Selenium. Эти инструменты позволяют «просматривать» страницу и загружать контент, как это делает настоящий браузер, что дает возможность работать с динамическими сайтами.