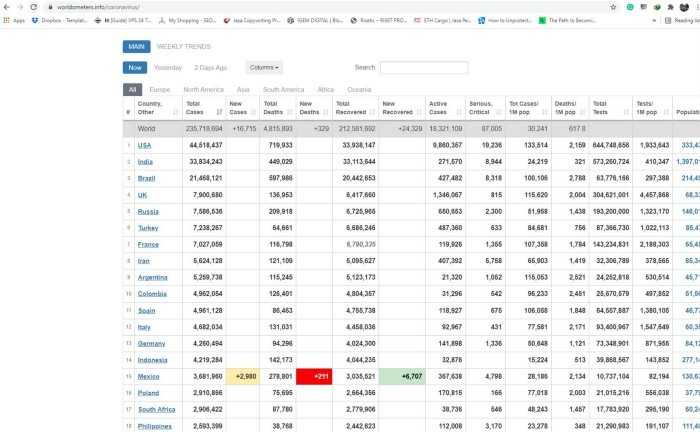

В Python существует несколько эффективных способов загрузить таблицы данных с веб-страниц. Обычно для этого используют библиотеки pandas, requests и BeautifulSoup, каждая из которых имеет свои особенности. В этой статье мы подробно рассмотрим, как получить доступ к таблицам, размещённым на сайте, и сохранить их в удобном для анализа формате.

Для начала важно понять, что существует два основных подхода: получение данных с веб-страниц в формате CSV, Excel или их эквиваленты, а также парсинг HTML-таблиц с помощью Python. Если вы работаете с таблицей, доступной через прямую ссылку на файл, то будет достаточно загрузить файл с использованием requests и обработать его с помощью pandas. В случае HTML-страниц, где данные в таблице динамически загружаются или не представлены в виде файлов, потребуется использовать парсинг с помощью BeautifulSoup.

Одним из наиболее простых способов является использование метода read_html из библиотеки pandas, который позволяет автоматически извлекать таблицы в формате HTML с веб-страницы и конвертировать их в DataFrame. Однако для работы с динамическими данными или сложными структурами таблиц может потребоваться более глубокий подход с использованием инструментов для парсинга HTML и взаимодействия с JavaScript, таких как selenium.

Установка необходимых библиотек для работы с таблицами

Для начала установим pandas – библиотеку для обработки и анализа данных, которая поддерживает работу с таблицами, представленными в формате CSV, Excel, SQL и других. Установить её можно через pip командой:

pip install pandas

Библиотека requests позволяет загружать данные из интернета. Она будет полезна, если таблица находится на веб-странице, а не в файле. Установите её с помощью команды:

pip install requests

Если необходимо работать с Excel-файлами, то вам пригодится библиотека openpyxl, которая позволяет читать и записывать данные в формате .xlsx. Установите её через pip:

pip install openpyxl

Если же таблицы представлены в формате HTML на веб-странице, то для их извлечения удобнее использовать библиотеку beautifulsoup4, которая облегчает парсинг HTML-структуры. Установить её можно командой:

pip install beautifulsoup4

После установки этих библиотек, вы сможете эффективно работать с таблицами, загружать данные с веб-страниц и обрабатывать их в Python.

Использование библиотеки pandas для загрузки таблицы

Библиотека pandas предоставляет удобные инструменты для работы с данными, включая функцию read_html, которая позволяет загружать таблицы напрямую с веб-страниц. Для этого необходимо просто передать URL, где расположена таблица, в эту функцию. pandas автоматически определит все таблицы на странице и загрузит их в виде объектов DataFrame.

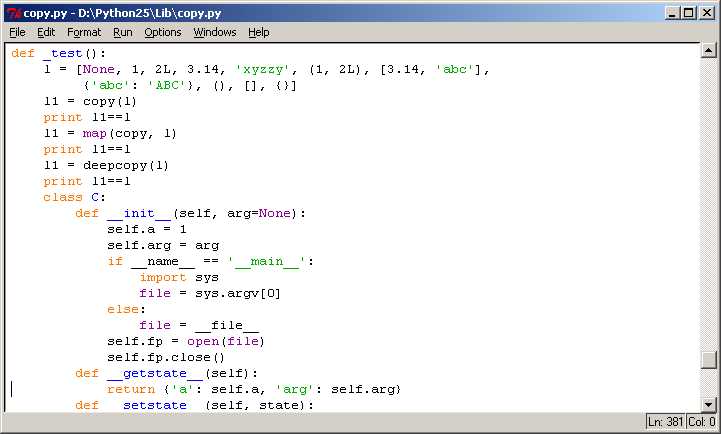

Для начала работы с pandas потребуется установить её через pip install pandas, если она ещё не установлена. После этого можно использовать следующий код для загрузки таблицы:

import pandas as pd

url = 'https://example.com/data'

tables = pd.read_html(url)

df = tables[0] # Выбираем первую таблицу на странице

print(df.head())Функция read_html возвращает список всех найденных таблиц. Вы можете работать с конкретной таблицей, выбрав её по индексу, как показано в примере выше. Если на странице несколько таблиц, важно указать, какую именно из них нужно загрузить.

Важно учитывать, что pandas использует BeautifulSoup для парсинга HTML, поэтому на некоторых сайтах могут возникать проблемы с корректным извлечением данных, особенно если страница использует сложную структуру или JavaScript для динамической загрузки контента.

Если требуется работать с таблицей в более специфичном формате (например, указать параметры разбиения строк или работу с заголовками), рекомендуется заранее проверять, как именно pandas интерпретирует таблицу с помощью print(tables), чтобы убедиться, что данные загружаются корректно.

Для дополнительных настроек можно использовать параметры read_html, такие как:

- attrs – для указания атрибутов, которые помогут выделить нужную таблицу;

- header – для задания строки, содержащей заголовки столбцов;

- index_col – для задания столбца, который будет использоваться в качестве индекса DataFrame.

Пример с параметрами:

df = pd.read_html(url, header=0, index_col=0)[0]

print(df.head())В этом примере первая строка страницы используется как заголовок столбцов, а первый столбец – как индекс. Такой подход помогает организовать данные более удобно для дальнейшей работы.

Как работать с таблицами в формате CSV и Excel

Формат CSV (Comma Separated Values) представляет собой текстовый формат для представления табличных данных. В Python для работы с такими файлами чаще всего используют библиотеку pandas. Для работы с Excel-файлами применяют ту же библиотеку, но с дополнительными зависимостями, такими как openpyxl или xlrd.

Для загрузки CSV-файла достаточно использовать функцию pandas.read_csv(). Она автоматически обрабатывает разделители, такие как запятая или точка с запятой, а также позволяет указывать кодировку и типы данных столбцов. Вот пример чтения CSV-файла:

import pandas as pd

data = pd.read_csv('file.csv')Для работы с Excel файлами нужно использовать функцию pandas.read_excel(), указав путь к файлу и, при необходимости, название листа. Если файл содержит несколько листов, можно передать параметр sheet_name:

data = pd.read_excel('file.xlsx', sheet_name='Sheet1')После загрузки данных из таблицы можно обращаться к строкам и столбцам. Для выбора столбца используется синтаксис data['column_name'], а для строк можно использовать индексацию или методы iloc (по индексу) или loc (по метке). Например, чтобы выбрать первые 5 строк:

data.head()Когда данные загружены, можно выполнить различные операции. Например, можно отфильтровать строки, изменить типы данных, обработать пропуски или даже преобразовать значения столбцов с помощью функций, таких как apply().

Для сохранения изменений в таблице в формате CSV можно использовать метод to_csv(). Он позволяет указать разделитель, кодировку и другие параметры. Пример сохранения изменений в CSV:

data.to_csv('new_file.csv', index=False)Для сохранения в Excel используется метод to_excel(). Важно, что для записи в Excel-файл требуется указать библиотеку, такую как openpyxl, если она не установлена по умолчанию.

data.to_excel('new_file.xlsx', index=False, engine='openpyxl')Важным аспектом работы с Excel является правильная обработка форматов данных в ячейках. Excel поддерживает такие типы, как даты, числа и строки, которые могут требовать дополнительной обработки при импорте в pandas. Например, для чтения дат можно указать параметр parse_dates:

data = pd.read_excel('file.xlsx', parse_dates=['date_column'])При работе с большими файлами рекомендуется использовать опцию chunksize, которая позволяет загружать файл частями, что уменьшает использование памяти.

Чтение таблиц с сайта с помощью библиотеки requests

Для извлечения данных из таблиц на веб-странице с помощью Python часто используют библиотеку requests. Она позволяет скачивать HTML-страницы, с которых можно извлекать таблицы. Однако важно помнить, что сама библиотека не предоставляет прямых инструментов для работы с HTML-разметкой, поэтому для извлечения данных из таблиц обычно используется дополнительный инструмент, например, BeautifulSoup.

Первоначально с помощью requests можно получить HTML-страницу с сайта. Для этого достаточно отправить GET-запрос:

import requests

url = "https://example.com"

response = requests.get(url)

html_content = response.textПосле получения HTML-страницы можно приступить к поиску таблиц. Для этого удобно использовать библиотеку BeautifulSoup, которая помогает парсить HTML-разметку и извлекать нужные данные. Но на данном этапе важно убедиться, что страница загружается корректно и доступна для запросов.

Если сайт требует авторизации или использование специальных заголовков, то requests позволяет добавлять их в запросы. Например:

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36"

}

response = requests.get(url, headers=headers)При успешном ответе можно извлечь HTML-контент и передать его в BeautifulSoup для поиска нужных элементов.

Для поиска таблиц в HTML-разметке можно использовать метод find_all, чтобы извлечь все теги <table>. Например:

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, "html.parser")

tables = soup.find_all("table")Каждая таблица представлена в виде объекта, и для дальнейшего анализа нужно работать с каждой строкой внутри этой таблицы. Важно помнить, что структура таблиц на разных сайтах может быть разной, поэтому перед извлечением данных стоит изучить разметку.

После нахождения таблицы можно извлечь данные, например, в виде списка строк и ячеек:

for table in tables:

rows = table.find_all("tr")

for row in rows:

cells = row.find_all("td")

row_data = [cell.get_text() for cell in cells]

print(row_data)Таким образом, библиотека requests помогает скачать страницу, а BeautifulSoup используется для парсинга и извлечения данных. Этот подход позволяет эффективно работать с таблицами, находящимися в HTML-разметке сайтов.

Разбор HTML-страницы с таблицей с использованием BeautifulSoup

Для начала необходимо установить необходимые библиотеки. Для этого в командной строке выполните команду:

pip install beautifulsoup4 requests

Затем, нужно получить HTML-код страницы, которая содержит таблицу. Для этого используем библиотеку requests.

import requests from bs4 import BeautifulSoup url = 'https://example.com' # URL страницы с таблицей response = requests.get(url) html_content = response.content

Теперь, имея HTML-код страницы, можно перейти к разбору таблицы. Первым шагом будет создание объекта BeautifulSoup для парсинга HTML.

soup = BeautifulSoup(html_content, 'html.parser')

После этого нужно найти таблицу на странице. Обычно таблица представлена элементом <table>, но для точности, лучше уточнить селектор, который соответствует нужной таблице. Чтобы извлечь таблицу, используем метод find или find_all для получения всех таблиц на странице.

table = soup.find('table') # Находит первую таблицу

Если на странице несколько таблиц, можно выбрать нужную по атрибутам или классам, например:

table = soup.find('table', {'class': 'data'}) # Поиск таблицы с классом 'data'

Теперь, когда таблица найдена, следующим шагом будет извлечение строк таблицы. Каждая строка таблицы представлена элементом <tr>, а ячейки – элементами <td> или <th> для заголовков столбцов. Получим все строки:

rows = table.find_all('tr')

Для каждой строки можно извлечь ячейки и сохранить их в список. Это делается с помощью метода find_all, который находит все элементы в строке:

data = []

for row in rows:

cells = row.find_all('td')

row_data = [cell.get_text(strip=True) for cell in cells]

data.append(row_data)

В результате, переменная data будет содержать все строки таблицы в виде списка списков. Важно отметить, что могут быть строки с заголовками, которые следует обработать отдельно.

Если таблица имеет заголовки, их можно извлечь отдельно и использовать для упорядочивания данных:

headers = [header.get_text(strip=True) for header in table.find_all('th')]

После этого можно объединить заголовки с данными, например, так:

table_data = [headers] + data

Наконец, если нужно обработать полученные данные, например, записать их в файл CSV или использовать для дальнейшего анализа, можно использовать библиотеку csv или другие инструменты для работы с данными.

import csv

with open('output.csv', 'w', newline='') as f:

writer = csv.writer(f)

writer.writerows(table_data)

Такой подход позволяет легко парсить таблицы с веб-страниц и извлекать нужную информацию для анализа или сохранения.

Обработка данных после загрузки таблицы в Python

После загрузки таблицы в Python, основная задача заключается в ее обработке, чтобы извлечь нужную информацию или преобразовать данные в формат, удобный для анализа. Это включает в себя проверку качества данных, очистку, преобразование типов и фильтрацию ненужных значений. Рассмотрим ключевые этапы обработки данных.

Для начала важно убедиться в корректности структуры загруженной таблицы. Применение библиотеки pandas для загрузки данных из файлов, таких как CSV или Excel, позволяет легко провести предварительную проверку:

df.head()– просмотр первых строк таблицы для оценки корректности данных.df.info()– получение информации о типах данных в каждом столбце и наличии пропусков.

После базового анализа, следующим шагом является очистка данных.

- Удаление дубликатов: дублирующиеся строки могут исказить результаты анализа. Для их удаления используется метод

df.drop_duplicates(). - Заполнение пропусков: пропуски в данных можно заполнить средним значением (для числовых данных) или наиболее частым значением (для категориальных). Это делается с помощью

df.fillna(). - Удаление ненужных столбцов: если некоторые столбцы не содержат полезной информации, их можно удалить с помощью

df.drop(columns=['column_name']).

Важным этапом является преобразование данных. В зависимости от потребностей, типы данных могут быть изменены:

- Конвертация типов: если столбец должен быть числовым, но хранит данные в виде строк, его можно преобразовать с помощью

pd.to_numeric(). - Преобразование дат: если один из столбцов содержит даты в строковом формате, его следует преобразовать в тип

datetimeс помощьюpd.to_datetime().

Для более сложных манипуляций с данными можно использовать методы фильтрации и группировки:

- Фильтрация данных: для выбора строк, удовлетворяющих определенным условиям, применяется фильтрация, например:

df[df['column'] > value]. - Группировка: метод

df.groupby()позволяет агрегировать данные по категориям, что полезно для вычисления статистик, таких как средние значения или суммы по группам.

Кроме того, стоит учитывать важность эффективного сохранения обработанных данных:

df.to_csv('filename.csv')– сохранение в формате CSV.df.to_excel('filename.xlsx')– сохранение в формате Excel.

Эти этапы позволяют эффективно подготовить данные для дальнейшего анализа или использования в модели машинного обучения. Важно, чтобы обработка данных была гибкой и соответствовала специфике задачи, с которой вы работаете.

Преобразование и сохранение данных в нужном формате

После того как таблица из интернета загружена в Python, данные необходимо преобразовать в формат, который будет удобен для дальнейшей работы или анализа. Это особенно важно, когда структура данных отличается от ожидаемой, либо требуется сохранение в специфическом формате для использования в других приложениях.

Для преобразования данных в Python можно использовать библиотеку Pandas, которая предоставляет удобные методы для работы с таблицами. Например, для преобразования датафрейма в CSV файл применяется метод to_csv(). Этот метод позволяет указать разделитель, кодировку и другие параметры, влияющие на конечный результат. Например:

df.to_csv('data.csv', index=False, encoding='utf-8')Если данные требуют преобразования в другие форматы, такие как Excel, JSON или SQL, то Pandas предлагает соответствующие методы, такие как to_excel(), to_json(), и to_sql(). Для сохранения в Excel важно указать имя листа, а для JSON – можно выбрать формат записи (например, строковый или в виде словаря).

Особое внимание стоит уделить типам данных в таблице. Если данные необходимо сохранить в числовом или временном формате, важно убедиться, что они правильно конвертированы, чтобы избежать ошибок при дальнейшем анализе. Например, использование метода pd.to_datetime() позволяет гарантировать правильное преобразование строк в формат даты и времени, что важно для временных рядов или аналитики по времени.

Когда необходимо сохранить таблицу в базу данных, стоит позаботиться о корректной настройке типов данных для соответствующих полей в SQL. Это обеспечит более быстрые запросы и сохранение целостности данных. Применение метода to_sql() с параметром if_exists помогает избежать дублирования данных при вставке в уже существующие таблицы.

Для сохранения в JSON важно выбирать подходящий способ сериализации данных. Например, если таблица имеет вложенные структуры, такие как списки или словари, можно использовать параметр orient='records', чтобы каждый объект записывался как отдельная запись в массиве JSON.