Сбор данных о текущем HTML-коде веб-страницы в браузере может быть полезен для различных целей, таких как анализ содержания, тестирование или автоматизация. В данном контексте Python предоставляет удобные инструменты для взаимодействия с веб-страницами, включая возможности работы с HTML-кодом, что позволяет получать актуальные данные о структуре страницы.

Для реализации задачи получения HTML-кода можно использовать библиотеки, такие как selenium, которая позволяет запускать браузеры и взаимодействовать с веб-страницами на уровне пользователя. Эта библиотека поддерживает работу с реальными браузерами, такими как Chrome или Firefox, что дает возможность получить HTML-код, генерируемый динамически с помощью JavaScript.

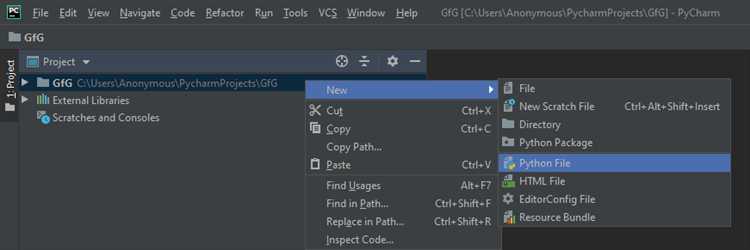

Чтобы собрать HTML с помощью Python, необходимо настроить правильную среду и выполнить несколько ключевых шагов. Прежде всего, требуется установить selenium и соответствующий веб-драйвер для выбранного браузера. Например, для Google Chrome нужно скачать ChromeDriver, который позволит взаимодействовать с браузером. Затем, с помощью скрипта на Python, можно запустить браузер, загрузить нужную страницу и извлечь её исходный HTML-код с помощью метода page_source.

При работе с динамическим контентом важно учитывать, что HTML-код может изменяться в зависимости от взаимодействий на странице. В таких случаях, использование ожиданий с помощью WebDriverWait в selenium помогает корректно дождаться загрузки всех элементов, прежде чем начинать сбор данных.

Как получить доступ к содержимому текущей страницы через Python?

Основные шаги для получения содержимого страницы с использованием Selenium:

- Установить необходимые библиотеки:

pip install selenium pip install webdriver-manager

Следующий шаг – загрузка и настройка WebDriver, который позволяет взаимодействовать с браузером:

- Создание экземпляра браузера через Selenium:

from selenium import webdriver

from webdriver_manager.chrome import ChromeDriverManager

driver = webdriver.Chrome(ChromeDriverManager().install())

driver.get('https://example.com')

Теперь вы можете получить HTML-содержимое текущей страницы:

html_content = driver.page_source print(html_content)

Этот код откроет веб-страницу и выведет её HTML-разметку в консоль. Однако для динамических страниц, которые загружаются через JavaScript, HTML будет доступен только после полной загрузки контента. В таких случаях можно использовать методы ожидания, чтобы удостовериться, что страница загружена:

- Ожидание загрузки страницы:

from selenium.webdriver.common.by import By from selenium.webdriver.support.ui import WebDriverWait from selenium.webdriver.support import expected_conditions as EC wait = WebDriverWait(driver, 10) element = wait.until(EC.presence_of_element_located((By.ID, 'specific-element'))) html_content = driver.page_source

Используя этот подход, можно ожидать появления определенного элемента на странице перед извлечением данных.

Альтернативой Selenium может быть использование библиотеки Playwright, которая также предоставляет возможность автоматизировать браузер, но с более высокой скоростью работы и поддержкой современных веб-страниц.

Пример работы с Playwright:

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

browser = p.chromium.launch()

page = browser.new_page()

page.goto('https://example.com')

html_content = page.content()

print(html_content)

browser.close()

В обоих случаях, после получения HTML-кода страницы, вы можете применять библиотеки, такие как BeautifulSoup, для дальнейшего анализа и извлечения данных.

- Пример использования BeautifulSoup для извлечения информации:

from bs4 import BeautifulSoup soup = BeautifulSoup(html_content, 'html.parser') title = soup.title.string print(title)

Это позволяет легко анализировать HTML и извлекать нужные данные, такие как текст, ссылки или другие элементы страницы.

Использование библиотеки Selenium для извлечения HTML-кода

Selenium – мощный инструмент для автоматизации взаимодействия с веб-страницами, включая извлечение HTML-кода. Он позволяет управлять браузерами, симулировать действия пользователя и извлекать текущий HTML, что особенно полезно для парсинга динамически генерируемых страниц.

Для использования Selenium в Python необходимо установить саму библиотеку и драйвер для браузера. Пример установки:

pip install seleniumДалее следует скачать соответствующий драйвер, например, для Chrome это будет ChromeDriver.

Основные шаги для извлечения HTML-кода с помощью Selenium:

-

Создание экземпляра веб-драйвера. Это позволяет открыть браузер и взаимодействовать с ним:

from selenium import webdriver driver = webdriver.Chrome(executable_path="path_to_chromedriver") -

Открытие целевой страницы:

driver.get("https://example.com") -

Ожидание загрузки контента. Важно убедиться, что динамически загружаемые элементы успели отобразиться. Для этого можно использовать явные или неявные ожидания:

from selenium.webdriver.common.by import By from selenium.webdriver.support.ui import WebDriverWait from selenium.webdriver.support import expected_conditions as EC WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.ID, "element_id"))) -

Извлечение HTML-кода страницы:

html_content = driver.page_source -

После завершения работы с браузером следует закрыть его:

driver.quit()

Этот процесс позволяет получить полный HTML-код страницы, включая динамически подгружаемый контент, который не доступен при использовании простого запроса через библиотеку requests.

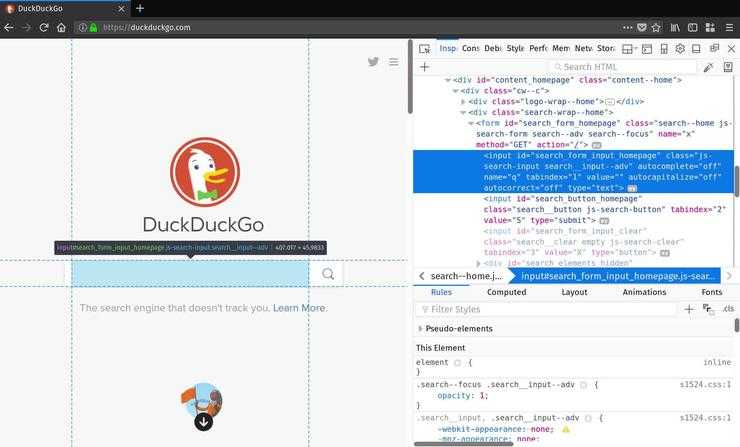

Для извлечения конкретных элементов страницы можно использовать методы поиска, такие как find_element_by_id, find_element_by_name, или find_elements_by_xpath. Например, чтобы получить текст с определенного элемента:

element = driver.find_element_by_id("element_id")

print(element.text)С помощью Selenium можно извлекать не только HTML-код, но и взаимодействовать с элементами страницы, что полезно для тестирования и парсинга сложных сайтов.

Как настроить WebDriver для работы с браузером?

Для работы с WebDriver необходимо установить подходящий драйвер для конкретного браузера. WebDriver взаимодействует с браузером через API, управляя его действиями на уровне клиента. Для начала нужно установить Selenium, библиотеку, которая предоставляет интерфейс для управления браузером через WebDriver.

1. Установите Selenium с помощью команды:

pip install selenium

2. Скачайте соответствующий драйвер для вашего браузера. Например, для Chrome это ChromeDriver, для Firefox – GeckoDriver. Драйвер должен соответствовать версии браузера. Убедитесь, что версия драйвера совпадает с версией вашего браузера. Скачать драйверы можно с официальных сайтов:

- ChromeDriver: https://sites.google.com/chromium.org/driver/

- GeckoDriver: https://github.com/mozilla/geckodriver/releases

3. Разместите драйвер в каталоге, доступном для вашего скрипта. Можно указать путь к драйверу в коде, но предпочтительнее добавить путь к драйверу в системные переменные PATH.

4. После установки драйвера настройте WebDriver в вашем Python-скрипте. Пример для Chrome:

from selenium import webdriver

options = webdriver.ChromeOptions()

driver = webdriver.Chrome(executable_path='/path/to/chromedriver', options=options)

driver.get('https://example.com')

Для других браузеров настройка аналогична. Важно учитывать, что для Firefox потребуется использовать другие параметры, а для Safari можно настроить WebDriver через команду:

driver = webdriver.Safari()

5. Важно: поддержка headless-режима (без графического интерфейса) позволяет запускать браузер без открытия окна. Это полезно для автоматизации, когда интерфейс не нужен. Для этого добавьте соответствующую опцию:

options.add_argument('--headless')

6. Проверьте корректность работы WebDriver, открыв страницу браузера с помощью команды driver.get('https://example.com'). Если все настроено правильно, браузер откроется, и указанный сайт будет загружен.

С помощью настроенного WebDriver можно автоматизировать множество задач: от сбора данных с сайтов до тестирования веб-приложений. Не забывайте следить за обновлениями браузеров и драйверов, чтобы избежать проблем с несовместимостью.

Как избежать блокировки доступа при сборе HTML с сайтов?

Для предотвращения блокировки при сборе HTML с сайтов необходимо следовать нескольким важным рекомендациям. Одна из главных причин блокировки – подозрение на автоматическую активность. Чтобы снизить риски, важно имитировать поведение реального пользователя.

Первое, что следует учесть, – это частота запросов. Чрезмерная активность (например, отправка запросов в течение короткого времени) может вызвать подозрения у серверов. Чтобы избежать этого, используйте механизмы задержек между запросами, такие как случайные интервалы. Например, можно реализовать таймер с задержками от 1 до 5 секунд.

Второй момент – использование реальных User-Agent заголовков. По умолчанию библиотеки, такие как requests или Selenium, могут отправлять стандартные User-Agent строки, которые легко распознаются как от роботов. Рекомендуется подменять их на строки, соответствующие популярным браузерам, чтобы сервер не смог определить, что запрос исходит от автоматизированной программы.

Для более сложных мер защиты от блокировки можно использовать прокси-серверы. Прокси помогают скрыть реальный IP-адрес и распределять нагрузку между несколькими адресами. Это особенно важно при сборе данных с крупных сайтов, где один IP-адрес может быть заблокирован за слишком большое количество запросов. Можно использовать как бесплатные, так и платные прокси для лучшей надежности.

Использование методов обхода защиты, таких как CAPTCHA, также имеет значение. Некоторые сайты могут требовать выполнения CAPTCHA для подтверждения, что запрос исходит от человека. В таких случаях можно интегрировать автоматические решения для CAPTCHA или воспользоваться сервисами, которые решают эту задачу за вас.

Не стоит забывать и о соблюдении правил сайта. Некоторые ресурсы предоставляют доступ к данным через API, что гораздо безопаснее и эффективнее, чем прямое парсинг HTML. Изучите документацию сайта и, если есть возможность, используйте API для получения нужных данных.

Наконец, важно следить за реакцией сайта на ваши запросы. Если вы заметили, что ваши IP-адреса начали блокироваться или замедляться, уменьшите скорость запросов, используйте другие прокси или сделайте паузу в сборе данных на некоторое время, чтобы снизить вероятность дальнейших блокировок.

Обработка динамического контента на странице с помощью Python

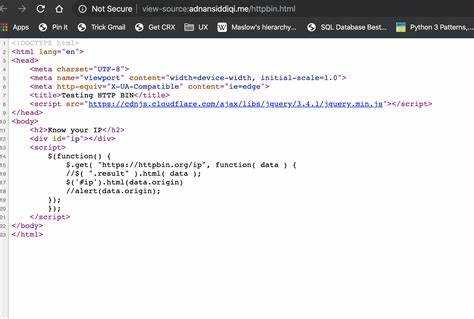

requests-html – это библиотека, которая поддерживает рендеринг JavaScript и позволяет получать HTML-страницы, сгенерированные динамически. Для её использования достаточно выполнить следующие шаги:

1. Установите библиотеку командой pip install requests-html.

2. Создайте объект сессии и используйте метод render для загрузки всех динамических элементов страницы:

from requests_html import HTMLSession

session = HTMLSession()

response = session.get('URL_страницы')

response.html.render() # выполняет рендеринг JavaScript

Этот метод подходит для большинства случаев, но если страница использует сложные взаимодействия с JavaScript или требует пользовательского ввода, стоит рассмотреть использование Selenium.

Selenium предоставляет возможность взаимодействовать с браузером, как это делает обычный пользователь. Он может эмулировать клики, прокрутку, ввод текста и другие действия. Чтобы начать работу с Selenium, выполните следующие шаги:

1. Установите библиотеку: pip install selenium.

2. Установите WebDriver для выбранного браузера (например, ChromeDriver для Google Chrome).

3. Используйте Selenium для открытия страницы и ожидания полной загрузки динамического контента:

from selenium import webdriver

from selenium.webdriver.common.by import By

driver = webdriver.Chrome(executable_path='путь_к_ChromeDriver')

driver.get('URL_страницы')

# Ожидание загрузки контента (например, элемента с определенным классом)

element = driver.find_element(By.CLASS_NAME, 'класс_элемента')

# Получение HTML-кода страницы после рендеринга

html_content = driver.page_source

print(html_content)

driver.quit()

В отличие от requests-html, Selenium позволяет полноценно взаимодействовать с веб-страницей, что полезно при работе с сайтами, которые требуют сложной анимации или динамических переходов.

Когда дело касается интеграции с другими системами, такими как API или обработка сложных взаимодействий, можно использовать такие инструменты, как BeautifulSoup в связке с Selenium для парсинга и дальнейшей работы с данными, полученными с динамически генерируемых страниц.

Как сохранять собранные данные в файл или базу данных?

Для сохранения данных, собранных с помощью Python-скрипта, можно использовать несколько подходов в зависимости от объема данных и требований к их обработке.

Если необходимо просто сохранить данные для дальнейшего анализа, можно записать их в текстовый файл. Это делается с помощью стандартных средств Python. Пример записи данных в файл:

with open('data.txt', 'w', encoding='utf-8') as file:

file.write("Собранные данные: \n")

for item in data:

file.write(f"{item}\n")

Для более структурированного хранения данных можно использовать формат CSV, который подходит для хранения таблиц. Пример записи данных в CSV-файл:

import csv

data = [['Имя', 'Возраст'], ['Алексей', 30], ['Марина', 25]]

with open('data.csv', mode='w', newline='', encoding='utf-8') as file:

writer = csv.writer(file)

writer.writerows(data)

Для более сложных случаев, когда требуется выполнение запросов и хранение данных в структурированном виде, стоит использовать базы данных. Для работы с базами данных Python предоставляет библиотеку SQLite, которая является встроенной и не требует дополнительной настройки.

Пример сохранения данных в базу данных SQLite:

import sqlite3

# Подключение к базе данных (если базы данных нет, она будет создана)

conn = sqlite3.connect('data.db')

cursor = conn.cursor()

# Создание таблицы, если она не существует

cursor.execute('''

CREATE TABLE IF NOT EXISTS users (

id INTEGER PRIMARY KEY,

name TEXT,

age INTEGER

)

''')

# Вставка данных

cursor.execute('''

INSERT INTO users (name, age) VALUES (?, ?)

''', ('Алексей', 30))

# Сохранение изменений и закрытие соединения

conn.commit()

conn.close()

При использовании баз данных важно следить за корректностью запросов и обработкой исключений. В случае необходимости можно использовать более сложные системы, такие как PostgreSQL или MySQL, для масштабируемых решений.

Для упрощения работы с базами данных можно использовать ORM-библиотеки, такие как SQLAlchemy, которые позволяют работать с базами данных на более высоком уровне, абстрагируя запросы SQL.

Сохранение данных в файл или базу данных зависит от ваших требований: если нужно быстро зафиксировать информацию для дальнейшей обработки, проще использовать файлы; если планируется работа с большим объемом данных или выполнение сложных запросов, предпочтительнее использовать базу данных.

Как обрабатывать ошибки при парсинге HTML с помощью Python?

Парсинг HTML с использованием Python требует внимательности при обработке возможных ошибок. Основные проблемы возникают при несовпадении структуры документа, наличии невалидного HTML или неправильном использовании инструментов парсинга. Для эффективной обработки ошибок важно понимать их типы и способы устранения.

При работе с библиотеками, такими как BeautifulSoup или lxml, основной проблемой является некорректный HTML. Для предотвращения ошибок необходимо использовать правильную настройку парсера. Например, при использовании BeautifulSoup с параметром "html.parser" можно столкнуться с ошибками, если HTML не соответствует стандарту. В таких случаях рекомендуется использовать параметр "lxml", который имеет более широкие возможности для работы с невалидным HTML.

При получении ошибки "UnicodeDecodeError" важно убедиться, что HTML-документ имеет правильную кодировку. Часто ошибки возникают из-за несовпадений между кодировкой файла и декодировщиком Python. Для решения проблемы стоит использовать "requests" с параметром `response.encoding` для явного указания кодировки перед парсингом документа.

Одной из частых ошибок является отсутствие нужных элементов в HTML, что может привести к исключению при попытке найти или извлечь данные. Для предотвращения таких сбоев стоит использовать конструкцию `try-except`, чтобы отловить и обработать возможные исключения, например, `AttributeError` или `IndexError`.

Также важно проверять типы данных при извлечении контента. Если извлекаемый элемент имеет неожиданный тип (например, строка вместо списка), это может привести к ошибкам дальнейшей обработки. Использование проверок типов и условий, таких как `if` или `isinstance()`, поможет избежать неожиданных сбоев при парсинге.

Для улучшения устойчивости парсинга стоит использовать тайм-ауты и повторные попытки при работе с запросами. Например, при получении ошибки подключения можно настроить автоматический повтор запроса с использованием библиотеки `requests` или `urllib`. В случае проблем с доступом к странице стоит добавить в код обработку ошибок, например, `requests.exceptions.RequestException`, чтобы адекватно реагировать на сетевые сбои.

Кроме того, важно логировать ошибки и исключения для последующего анализа. Использование стандартной библиотеки `logging` помогает отслеживать не только ошибки, но и этапы выполнения парсинга, что упрощает диагностику и отладку.

Вопрос-ответ:

Что такое сбор HTML текущего браузера с помощью Python?

Сбор HTML текущего браузера с помощью Python подразумевает использование скриптов, которые извлекают структуру HTML-страницы, отображаемую в браузере. Это может быть полезно для парсинга динамически загружаемых данных, например, для анализа контента, который не доступен сразу через исходный код страницы. Для этого обычно используют библиотеки, такие как Selenium или Playwright, которые взаимодействуют с браузером и позволяют получить доступ к его содержимому.

Какие библиотеки Python подходят для сбора HTML из браузера?

Для сбора HTML из браузера можно использовать несколько популярных библиотек. Наиболее часто используются Selenium и Playwright. Selenium позволяет управлять браузером, имитируя действия пользователя, и собирать данные с динамических сайтов. Playwright тоже предоставляет возможности автоматизации браузера, но при этом поддерживает современные браузеры, такие как Chromium, Firefox и WebKit. Обе библиотеки позволяют не только собирать HTML, но и работать с элементами страницы, нажимать кнопки и заполнять формы.

Можно ли собрать HTML с сайта без открытия браузера?

Да, HTML с сайта можно собрать без открытия браузера, используя библиотеки, такие как Requests или aiohttp. Эти инструменты делают HTTP-запросы к серверу и возвращают исходный код страницы. Однако, такой метод не подходит для сайтов, которые используют JavaScript для динамической подгрузки контента. В этом случае, чтобы получить актуальное содержимое страницы, потребуется использовать Selenium или Playwright, которые работают с рендерингом JavaScript в реальном времени.

Как получить HTML страницы, которая загружается с помощью JavaScript?

Для получения HTML страницы, которая использует JavaScript для динамической загрузки контента, необходимо использовать браузер, который может рендерить JavaScript. Для этого идеально подходят такие инструменты, как Selenium или Playwright. Эти библиотеки позволяют взаимодействовать с браузером на уровне пользователя, выполняя JavaScript и предоставляя доступ к полностью загруженному HTML. После того как страница загружена, можно извлечь HTML с помощью методов соответствующих библиотек.