Извлечение данных с веб-страниц – ключевая задача в автоматизации сбора информации. В Python для этого чаще всего применяются библиотеки requests, BeautifulSoup и lxml. Каждая из них оптимизирована под определённые типы задач: requests – для отправки HTTP-запросов, BeautifulSoup и lxml – для парсинга HTML и XML.

Например, для получения контента страницы с HTTP-заголовками, имитирующими браузер, применяется следующий подход: формируется GET-запрос с параметрами headers, включающими User-Agent, Accept и другие поля, часто требуемые для обхода блокировок. Это особенно важно при взаимодействии с сайтами, защищёнными от ботов.

После получения HTML-документа важна правильная стратегия извлечения нужных элементов. Если структура страницы стабильна, эффективно использовать CSS-селекторы или XPath. В случае динамически генерируемого контента (через JavaScript) – потребуется применение Selenium или асинхронных библиотек, таких как aiohttp в связке с pyppeteer.

Перед началом парсинга следует удостовериться в наличии разрешения на сбор данных. Проверяется это через файл robots.txt сайта. Также имеет смысл установить интервалы между запросами и использовать рандомизацию таймингов, чтобы снизить нагрузку на сервер и избежать временной блокировки IP.

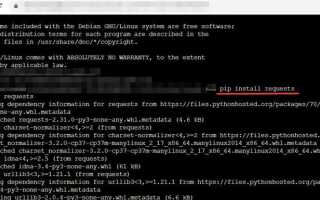

Выбор и установка библиотеки для HTTP-запросов

Для работы с HTTP-запросами в Python чаще всего используют библиотеки requests, httpx и встроенный модуль urllib. Выбор зависит от задач и требований к производительности.

Requests – стабильная и простая в использовании библиотека. Поддерживает методы GET, POST, PUT, DELETE, отправку заголовков, куки, работу с JSON. Устанавливается через pip:

pip install requestsОднако она не поддерживает асинхронность, что делает её неудобной при большом количестве параллельных запросов.

Httpx – современная альтернатива с поддержкой как синхронного, так и асинхронного режима. Подходит для интеграции с asyncio и FastAPI. Установка:

pip install httpxПри написании высоконагруженных парсеров и клиентов API лучше использовать httpx, особенно если требуется конкурентная обработка.

Urllib входит в стандартную библиотеку, но требует больше кода для выполнения тех же задач. Он не рекомендован, если есть возможность использовать сторонние библиотеки.

Оптимальный выбор для большинства случаев – requests. Для асинхронных задач – httpx.

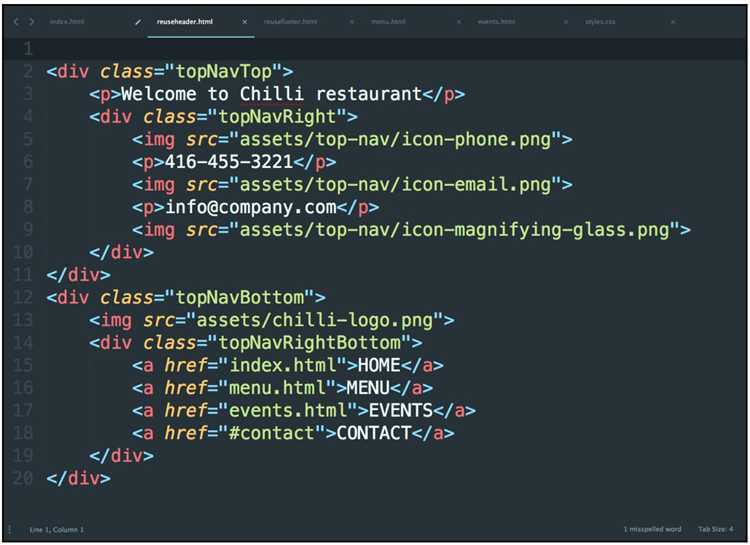

Определение структуры HTML-страницы через инструменты браузера

Для анализа структуры страницы откройте нужный сайт в браузере Google Chrome или Mozilla Firefox. Нажмите F12 или используйте контекстное меню: Правой кнопкой мыши → Просмотреть код. Откроется панель разработчика, где отображается DOM-дерево текущей страницы.

Выделите интересующий элемент на сайте и используйте иконку стрелки в левом верхнем углу панели инструментов (Select an element). Это позволяет точно определить, где в коде расположен нужный блок, кнопку или ссылку. Атрибуты id, class, data-* часто используются для создания селекторов в коде на Python.

Обратите внимание на вложенность элементов. При парсинге важно учитывать иерархию: родительские теги могут быть необходимы для получения нужного контекста. Например, текст статьи может быть внутри нескольких <div>, <section> и <p>.

Используйте вкладку Elements для статических элементов и Network → XHR для динамически подгружаемых данных. Если нужный контент не отображается в DOM, возможно, он загружается через JavaScript – в этом случае анализируйте сетевые запросы, чтобы определить API-эндпоинты.

Для точного извлечения используйте уникальные CSS-селекторы. Клик правой кнопкой на элементе в Elements и выберите Copy → Copy selector или Copy → Copy XPath. Эти значения можно использовать с библиотеками BeautifulSoup или lxml.

Изучите также атрибуты aria-label, role и скрытые поля: они могут быть полезны при работе с интерактивными или доступными интерфейсами. Проверяйте, не изменяется ли DOM динамически – это важно для корректного сбора данных.

Извлечение данных с помощью BeautifulSoup

Основной принцип работы с BeautifulSoup заключается в том, чтобы загрузить страницу, преобразовать её в объект, с которым легко работать, и затем извлекать нужную информацию, используя различные методы поиска.

Основные шаги для извлечения данных

- Установите необходимые библиотеки:

pip install requests beautifulsoup4- Получите HTML-контент страницы с помощью библиотеки requests:

import requests

url = 'https://example.com'

response = requests.get(url)

html_content = response.textПолученные данные в формате текста можно передать в BeautifulSoup для дальнейшей обработки.

- Создайте объект BeautifulSoup для парсинга HTML-кода:

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, 'html.parser')Теперь вы можете использовать методы BeautifulSoup для поиска нужных элементов на странице.

Методы поиска элементов

BeautifulSoup предоставляет несколько методов для поиска элементов в HTML-документе:

- find() – находит первый элемент, соответствующий заданному фильтру.

- find_all() – возвращает все элементы, соответствующие фильтру.

- select() – позволяет использовать CSS-селекторы для поиска элементов.

Пример поиска заголовков на странице:

headers = soup.find_all('h1') # Получить все элементы Пример получения текста ссылки:

link = soup.find('a', href=True) # Находим первую ссылку с атрибутом href

Поиск по атрибутам

Для извлечения элементов по атрибутам можно использовать параметры метода find() или find_all(). Например, для получения элементов с определённым классом:

divs = soup.find_all('div', class_='example-class')

Если нужно найти элементы по идентификатору, используйте параметр id:

element = soup.find(id='unique-id')

Использование CSS-селекторов

Метод select() даёт возможность более гибко искать элементы с использованием CSS-селекторов:

items = soup.select('.item .name') # Все элементы с классом "name", находящиеся внутри элемента с классом "item"

Обработка данных

После того как вы нашли нужные элементы, можно извлечь их текстовое содержимое или атрибуты. Например, чтобы получить текст из тега:

text = item.get_text()

Для извлечения атрибутов, например, ссылки, используйте:

link = item['href']

Ограничения и рекомендации

- Не все страницы можно парсить без согласия владельца. Убедитесь, что действия не нарушают правила использования сайта.

- Будьте осторожны с использованием метода select(), так как неправильный селектор может привести к отсутствию результата.

- Для работы с динамически загружаемым контентом используйте дополнительные инструменты, такие как Selenium или Scrapy.

Обработка JavaScript-контента с использованием Selenium

JavaScript на веб-страницах часто используется для динамической загрузки контента, что затрудняет извлечение данных с помощью стандартных методов парсинга, таких как BeautifulSoup. Selenium – один из самых эффективных инструментов для решения этой задачи. Он позволяет эмулировать действия пользователя в браузере, обеспечивая доступ к элементам, которые загружаются с помощью JavaScript.

Для работы с Selenium необходимо установить драйвер, который будет взаимодействовать с браузером. Например, для Chrome используется ChromeDriver. Установив его и подключив Selenium, можно начать автоматизацию взаимодействия с веб-страницей. Основное преимущество Selenium перед другими инструментами – возможность загрузки и взаимодействия с динамическим контентом, который загружается в результате выполнения JavaScript-кода на странице.

Пример базовой настройки Selenium для работы с Chrome:

from selenium import webdriver

from selenium.webdriver.common.by import By

driver = webdriver.Chrome(executable_path='/path/to/chromedriver')

driver.get("https://example.com")

После того как страница загружена, необходимо подождать, чтобы JavaScript-контент успел полностью загрузиться. Для этого можно использовать метод WebDriverWait, который ожидает появления элемента на странице. Это особенно полезно при динамической загрузке данных через асинхронные запросы (AJAX).

Пример ожидания элемента:

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

element = WebDriverWait(driver, 10).until(

EC.presence_of_element_located((By.ID, "dynamic-element"))

)

Важно помнить, что Selenium работает через интерфейс браузера, что делает его медленнее по сравнению с другими методами парсинга. Однако, для страниц с динамическим контентом, где данные загружаются через JavaScript, это единственный способ получить нужную информацию.

Кроме того, Selenium предоставляет возможности для выполнения JavaScript-кода непосредственно через метод execute_script. Это может быть полезно, если необходимо выполнить определенные действия на странице, например, прокрутить её до нужного места для загрузки дополнительных данных.

Пример выполнения JavaScript через Selenium:

driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

Таким образом, Selenium позволяет эффективно обрабатывать динамический контент, загруженный с помощью JavaScript. При этом важно учитывать производительность и оптимизацию работы с инструментом, так как частые обновления контента могут значительно замедлить процесс парсинга.

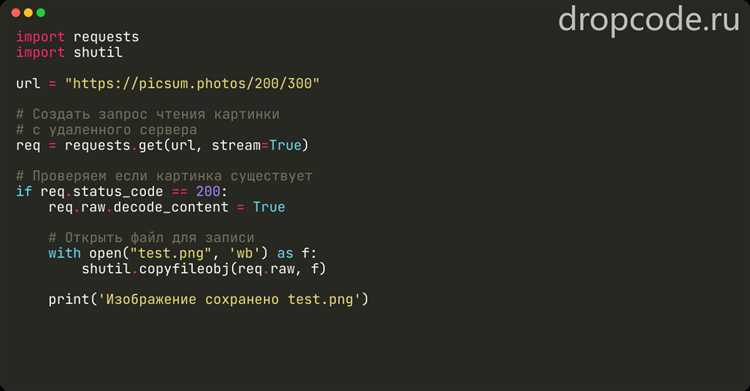

Работа с API сайтов: получение и анализ JSON-ответов

Для начала необходимо отправить запрос к API. Пример использования библиотеки `requests`:

import requests

url = 'https://api.example.com/data'

response = requests.get(url)

Если запрос успешен (статус 200), можно перейти к обработке данных. Ответ от API обычно приходит в формате JSON, который можно извлечь с помощью метода `.json()`:

data = response.json()

Теперь данные находятся в виде Python-словаря, и их можно использовать для дальнейшей работы. Основные шаги обработки данных:

- Проверка структуры данных: Важно понимать структуру полученного JSON. Это позволит правильно извлечь нужные элементы. Например, если ответ имеет вид:

{

"status": "success",

"data": {

"items": [

{"id": 1, "name": "Item 1"},

{"id": 2, "name": "Item 2"}

]

}

}

- Извлечение данных: Для доступа к данным используйте стандартную индексацию словарей и списков:

items = data['data']['items']

for item in items:

print(item['name'])

Если API возвращает ошибку или некорректные данные, необходимо обработать исключения. Например, если структура данных может измениться, используйте конструкцию try-except:

try:

items = data['data']['items']

except KeyError:

print("Ошибка: Невозможно найти ключ 'items'")

Фильтрация и анализ данных: После извлечения данных можно приступить к их анализу. Например, если необходимо найти все элементы с определённым условием:

filtered_items = [item for item in items if item['id'] > 1]

Работа с параметрами API: Многие API требуют передачи параметров в запросах, например, для фильтрации данных или для авторизации. Параметры можно передать через словарь в аргумент `params` при отправке GET-запроса:

params = {'category': 'electronics', 'limit': 10}

response = requests.get(url, params=params)

В случае работы с API, требующими авторизации, например, через токены, используйте заголовки (headers):

headers = {'Authorization': 'Bearer YOUR_TOKEN'}

response = requests.get(url, headers=headers, params=params)

Если API поддерживает работу с POST-запросами, можно отправить данные с помощью аргумента `data`:

payload = {'key1': 'value1', 'key2': 'value2'}

response = requests.post(url, json=payload)

Обработка ошибок: API может возвращать ошибки в ответах, например, статус 404 (не найдено) или 500 (внутренняя ошибка сервера). Проверку статуса ответа можно выполнить с помощью:

if response.status_code == 200:

data = response.json()

else:

print(f"Ошибка: {response.status_code}")

Обработка таких ошибок помогает избежать сбоев в программе и сделать работу с API более надёжной. Важно учитывать, что некоторые ошибки могут требовать повторных запросов, особенно если API использует лимиты на количество запросов.

Ограничения API: Прежде чем использовать API, важно ознакомиться с его документацией, чтобы понимать ограничения: лимиты запросов, доступные методы, а также возможные параметры и их формат. Некоторые API могут ограничивать количество запросов за определённый промежуток времени (rate limiting), поэтому стоит предусмотреть обработку таких ситуаций.

Таким образом, получение и анализ JSON-ответов API сайтов в Python требует внимательности к структуре данных, обработке ошибок и правильной настройке запросов. Это ключевые шаги для эффективного взаимодействия с внешними сервисами и извлечения нужной информации.

Сохранение полученных данных в файл CSV или JSON

После того как данные с сайта успешно получены, их нужно сохранить в удобном формате для дальнейшего использования. CSV и JSON – два популярных формата для хранения данных, и выбор между ними зависит от структуры данных и целей работы с ними.

Для сохранения данных в формате CSV можно воспользоваться стандартной библиотекой Python – csv. Этот формат идеально подходит для табличных данных, где каждая строка представляет собой отдельный объект, а столбцы – его характеристики. Пример сохранения данных в CSV:

import csv

data = [

{"name": "Иван", "age": 30, "city": "Москва"},

{"name": "Мария", "age": 25, "city": "Санкт-Петербург"}

]

with open('data.csv', mode='w', newline='', encoding='utf-8') as file:

writer = csv.DictWriter(file, fieldnames=["name", "age", "city"])

writer.writeheader()

writer.writerows(data)

В этом примере создается файл data.csv, в котором будет сохранена информация о пользователях. Метод DictWriter позволяет записывать словари, указав имена полей (столбцов). Этот способ удобен для хранения данных, организованных по признакам.

Если же данные сложнее или имеют вложенные структуры, лучше использовать формат JSON, который более гибок и удобен для работы с объектами и массивами. Для записи в JSON используется библиотека json. Пример записи данных в JSON:

import json

data = [

{"name": "Иван", "age": 30, "city": "Москва"},

{"name": "Мария", "age": 25, "city": "Санкт-Петербург"}

]

with open('data.json', 'w', encoding='utf-8') as file:

json.dump(data, file, ensure_ascii=False, indent=4)

Здесь используется метод json.dump, который сериализует объект Python в строку JSON и записывает её в файл. Параметр ensure_ascii=False позволяет сохранить русские символы, а indent=4 делает форматирование более читабельным.

Важно учитывать, что при выборе формата стоит опираться на характер данных. CSV удобен для табличных данных, а JSON подходит для вложенных или иерархических структур. В обоих случаях Python предоставляет простые и эффективные способы для записи и чтения данных, что делает работу с файлами максимально удобной и быстрой.

Обход защиты от парсинга: User-Agent, паузы и прокси

User-Agent – это строка, которую браузеры отправляют на сервер для идентификации. Веб-сайты часто используют User-Agent для фильтрации запросов от ботов. При парсинге рекомендуется подменять этот заголовок на строку, соответствующую настоящему браузеру. Например, для Python можно использовать библиотеку fake_useragent, чтобы автоматически генерировать случайные строки User-Agent. Вот пример кода:

from fake_useragent import UserAgent

import requests

ua = UserAgent()

headers = {'User-Agent': ua.random}

response = requests.get('https://example.com', headers=headers)

Такой подход помогает избежать блокировки, поскольку сервер будет воспринимать запрос как исходящий от реального пользователя.

Паузы между запросами – еще один важный элемент, позволяющий избежать подозрений со стороны серверов. При отправке запросов с высокой частотой сайт может начать блокировать IP-адрес за подозрительную активность. Чтобы этого избежать, нужно добавлять случайные паузы между запросами. Например, можно использовать функцию sleep из библиотеки time, чтобы сделать паузу в пределах 1-3 секунд:

import time

import random

# Пауза от 1 до 3 секунд

time.sleep(random.uniform(1, 3))

Эти случайные задержки делают поведение скрипта более похожим на действия человека, что снижает вероятность блокировки.

Прокси-серверы помогают скрыть реальный IP-адрес и могут быть использованы для обхода блокировок на основе IP. Прокси могут быть как бесплатными, так и платными. Использование нескольких прокси-серверов позволяет распределить нагрузку на запросы и снизить вероятность попадания в черные списки. Для автоматизации этого процесса в Python можно использовать библиотеку requests с прокси-серверами:

proxies = {

'http': 'http://username:password@proxyserver:port',

'https': 'http://username:password@proxyserver:port'

}

response = requests.get('https://example.com', proxies=proxies)

Важно помнить, что бесплатные прокси часто менее надежны и могут быть заблокированы. Лучше использовать проверенные платные сервисы, чтобы гарантировать стабильность работы.

Также стоит учесть, что многие сайты используют капчи для защиты от ботов. В этом случае нужно использовать решения для автоматического решения капчи, такие как сервисы 2Captcha или Anti-Captcha, либо вручную проходить проверку.

Комплексный подход к обходу защиты от парсинга (поменять User-Agent, использовать паузы и прокси) позволяет минимизировать риски блокировки и обеспечивает стабильную работу парсера.

Вопрос-ответ:

Как с помощью Python получить данные с сайта?

Для получения данных с сайта можно использовать библиотеки, такие как `requests` и `BeautifulSoup`. Библиотека `requests` позволяет отправлять HTTP-запросы, а `BeautifulSoup` помогает парсить HTML-контент. Процесс начинается с отправки GET-запроса на сайт с помощью `requests`, после чего можно использовать `BeautifulSoup` для извлечения необходимой информации из полученного HTML-кода страницы.

Как обработать ошибки при запросах данных с сайта в Python?

При запросах данных с сайта важно учитывать возможные ошибки, такие как недоступность сайта или неверный URL. Для этого можно использовать блоки `try-except` для обработки исключений. Например, если сайт недоступен, может возникнуть ошибка соединения, и её можно отловить, чтобы не прерывать выполнение программы. Также можно проверять статус-код ответа, чтобы убедиться, что запрос был успешным (код 200).

Какие библиотеки Python лучше использовать для парсинга данных с веб-сайтов?

Для парсинга веб-страниц часто используются две популярные библиотеки: `BeautifulSoup` и `lxml`. `BeautifulSoup` удобна для простых задач и работает с HTML и XML, обеспечивая гибкие возможности для извлечения данных. `lxml` — это более быстрая и мощная библиотека для работы с XML и HTML, но её использование может требовать больше настроек. Также можно использовать `Selenium` для взаимодействия с динамическими страницами, если данные загружаются с помощью JavaScript.

Можно ли собирать данные с сайтов автоматически с использованием Python, и как избежать блокировки?

Да, автоматический сбор данных с сайтов с помощью Python возможен, однако важно соблюдать этические и юридические нормы. Чтобы избежать блокировки, следует использовать заголовки HTTP-запросов, имитирующие действия реального пользователя (например, изменять `User-Agent`). Также стоит ограничивать количество запросов, чтобы не перегружать серверы. Для более сложных случаев можно применять прокси-сервера или использовать паузы между запросами, чтобы снизить риск блокировки.