Эффективная индексация сайта в поисковых системах начинается с точной настройки технических параметров WordPress. В первую очередь необходимо проверить файл robots.txt, чтобы убедиться, что важные страницы не закрыты от обхода поисковыми роботами. Оптимальный вариант – разрешить индексацию основных разделов и запретить доступ к административным страницам и временным файлам.

Следующий ключевой элемент – карта сайта в формате sitemap.xml. Использование плагинов, таких как Yoast SEO или Rank Math, позволяет автоматически генерировать и обновлять карту сайта, что существенно ускоряет обработку новых и изменённых страниц поисковыми системами.

Правильное управление мета-тегами robots на уровне отдельных страниц и постов предотвращает дублирование контента и помогает сконцентрировать вес ссылок на основных URL. Для крупных сайтов с большим количеством категорий важно внедрить канонические URL, чтобы избежать распыления SEO-эффекта.

Выбор и настройка правильной структуры постоянных ссылок

Оптимальная структура постоянных ссылок (permalinks) должна обеспечивать удобочитаемость и четкую иерархию URL. В WordPress рекомендуется использовать формат «%postname%» или «%category%/%postname%», что позволяет поисковым системам лучше понимать тематику страницы и улучшает пользовательский опыт.

Избегайте использования параметров и числовых идентификаторов, например, «?p=123» – они не информативны и плохо влияют на SEO. В настройках WordPress перейдите в «Настройки» → «Постоянные ссылки» и выберите «Произвольно», задав структуру «/%postname%/» или «/%category%/%postname%/».

Если сайт содержит много разделов, добавление категории в URL помогает структурировать контент, однако не стоит использовать слишком длинные или многослойные пути – они усложняют индексацию и ухудшают восприятие пользователем.

Важно исключить из URL стоп-слова и служебные символы, а также использовать дефисы для разделения слов, так как поисковики воспринимают их как пробелы. Пример правильного URL: site.ru/tekhnologii/obzor-novykh-smartfonov.

После изменения структуры ссылок следует настроить 301 редиректы со старых URL на новые, чтобы сохранить позицию в выдаче и избежать ошибок 404. Для этого можно использовать плагины типа Redirection или прописать правила в файле .htaccess.

Регулярно проверяйте в Google Search Console корректность индексации и наличие ошибок, связанных с постоянными ссылками, чтобы своевременно устранять проблемы.

Оптимизация файла robots.txt для контроля индексации страниц

Файл robots.txt управляет доступом поисковых роботов к разделам сайта и существенно влияет на индексацию. Для WordPress важно корректно настроить этот файл, чтобы исключить из индексации технические и дублирующие страницы, сохранив при этом видимость ключевого контента.

Рекомендуемые шаги для оптимизации:

- Блокировка административных и системных директорий:

Disallow: /wp-admin/– запрещает индексацию административной панели;Disallow: /wp-includes/– исключает скрипты и библиотеки, не представляющие интереса для поиска;Disallow: /wp-login.php– запрещает индексацию страницы входа.

- Исключение дублирующего контента:

Disallow: /author/– если авторские архивы дублируют контент;Disallow: /tag/иDisallow: /category/– при наличии индексации категорий и тегов через sitemap;- Запрет индексации страниц пагинации (

Disallow: /*/page/).

- Оптимизация для кэширования и ресурсов:

Disallow: /cgi-bin/, если такая папка присутствует;- Разрешение доступа к CSS и JS, чтобы не нарушать отображение страниц (

Allow: *.css,Allow: *.js).

Важно не блокировать важные страницы с помощью robots.txt, а управлять их индексацией через мета-теги noindex или HTTP-заголовки, поскольку robots.txt запрещает только сканирование, но не гарантирует исключение из индекса.

Пример минимально эффективного файла для WordPress:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-login.php

Disallow: /author/

Disallow: /tag/

Disallow: /category/

Allow: /wp-admin/admin-ajax.php

Регулярно проверяйте корректность файла с помощью Google Search Console и анализируйте логи роботов, чтобы выявлять проблемы с индексацией.

Создание и обновление карты сайта XML для поисковых систем

Карта сайта XML – ключевой инструмент для обеспечения эффективной индексации контента. Правильное создание и регулярное обновление карты влияет на скорость и полноту сканирования поисковыми роботами.

Рекомендуемые шаги:

- Выбор плагина для генерации карты сайта:

- Yoast SEO – встроенная автоматическая генерация и обновление.

- Google XML Sitemaps – классика для детальной настройки.

- Rank Math – альтернативный плагин с расширенными функциями.

- Настройка карты сайта:

- Включить все типы контента, которые нужно индексировать (страницы, записи, категории).

- Исключить из карты страницы с низкой ценностью (например, архивы, дубли).

- Установить приоритеты URL и частоту обновления для важных разделов.

- Обновление карты сайта:

- Автоматическое обновление при добавлении или изменении контента.

- При ручных изменениях – принудительно пересоздавать карту через интерфейс плагина.

- Проверять актуальность файла sitemap.xml не реже одного раза в месяц.

- Отправка карты сайта в поисковые системы:

- Добавить ссылку на sitemap.xml в файл robots.txt:

Sitemap: https://ваш_сайт.ru/sitemap.xml. - Зарегистрировать и отправить карту через Google Search Console и Яндекс.Вебмастер.

- Регулярно отслеживать ошибки и предупреждения, исправлять недоступные страницы.

- Добавить ссылку на sitemap.xml в файл robots.txt:

Оптимальная карта сайта должна содержать не более 50 000 URL или весить не больше 50 МБ. При превышении делите карту на несколько файлов и создавайте индексный sitemap.

Использование корректной карты сайта XML существенно ускоряет появление новых и обновленных страниц в поисковой выдаче и снижает вероятность пропуска важного контента.

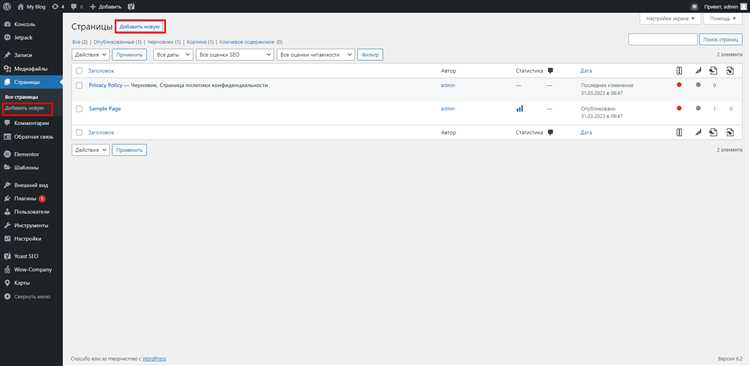

Настройка плагинов SEO для улучшения видимости сайта

Выбор плагина SEO начинается с анализа функционала: поддержка редактирования метатегов, создание карты сайта, интеграция с Google Search Console и возможность настройки микроразметки. Популярные решения, такие как Yoast SEO, Rank Math и All in One SEO, обеспечивают эти базовые функции, но имеют и отличия в деталях настройки.

Для максимальной эффективности настройте заголовки и описания страниц вручную, избегая автоматических шаблонов. Это повысит релевантность сниппетов в поисковой выдаче. Обратите внимание на функцию анализа ключевых слов в плагине – используйте её для оценки плотности и размещения ключевых фраз.

Активируйте генерацию XML-карты сайта и убедитесь, что в ней нет дублирующегося или неиндексируемого контента. При необходимости исключите из карты страницы с низкой ценностью для поисковиков (например, страницы политики конфиденциальности или корзины). Подключите карту сайта к Google Search Console для ускорения индексации.

Используйте встроенные средства плагина для настройки файла robots.txt – блокируйте доступ к техническим разделам и папкам с дублированным содержимым, сохраняя открытыми страницы с коммерческим и информационным значением.

Обратите внимание на поддержку микроразметки Schema.org: корректное внедрение структурированных данных улучшает отображение сайта в поиске и повышает кликабельность сниппетов. Настраивайте типы разметки в соответствии с тематикой сайта (статья, продукт, организация).

Регулярно обновляйте плагин, чтобы использовать новые функции и сохранять совместимость с ядром WordPress и изменениями в алгоритмах поисковых систем. Перед обновлением делайте резервные копии, чтобы избежать потери настроек.

При наличии мультиязычности применяйте совместимые с SEO плагины, позволяющие создавать hreflang-теги, корректно указывая языковые версии страниц.

Использование метатегов для управления индексированием страниц

Метатег robots позволяет задавать поисковым системам конкретные инструкции по индексации и обходу страниц. Для WordPress важно добавлять этот тег в раздел <head> каждой страницы, где требуется контроль.

Основные директивы метатега robots:

index – разрешает индексацию страницы;

noindex – запрещает индексацию, но разрешает переход по ссылкам;

follow – позволяет поисковикам следовать по ссылкам на странице;

nofollow – запрещает переход по ссылкам.

Для запрета индексации отдельных страниц, например, страниц авторов, тегов или архивов, следует использовать <meta name="robots" content="noindex, follow">. Это предотвращает попадание в индекс страниц с дублирующимся контентом и сохраняет ссылочную массу.

Для административных или технических страниц, например, страницы входа или корзины, целесообразно использовать noindex, nofollow, чтобы полностью исключить их из индекса.

В WordPress метатеги можно добавить с помощью SEO-плагинов (Yoast SEO, Rank Math), задавая правила для типов страниц и отдельных URL. Рекомендуется проверить корректность установки метатегов через просмотр исходного кода и инструменты для вебмастеров.

Важно исключать из индекса страницы с низким или дублирующимся контентом, чтобы не снижать релевантность сайта в поисковой выдаче. Метатеги robots – быстрый и эффективный инструмент для этого.

Проверка и исправление ошибок индексации через Google Search Console

Для контроля индексации сайта на WordPress используйте раздел «Покрытие» в Google Search Console. В нем отображаются страницы, которые Google успешно проиндексировал, а также страницы с ошибками.

Основные типы ошибок:

- Ошибка 404 (Не найдено) – страница отсутствует, но на нее ссылаются внутренние или внешние ссылки.

- Ошибка серверной ошибки (5xx) – проблемы с доступом к серверу.

- Страницы, заблокированные robots.txt – доступ запрещен в файле robots.txt.

- Дубликаты без канонического URL – идентичный контент на разных URL без правильной канонизации.

Для исправления ошибок:

1. Ошибки 404 – проверьте внутренние ссылки в WordPress через плагины типа Broken Link Checker, исправьте или удалите неработающие ссылки. Настройте 301 редиректы с удаленных URL на релевантные страницы.

2. Серверные ошибки 5xx – проверьте нагрузку сервера, ошибки PHP и конфигурацию хостинга. Обновите плагины и тему, устраните конфликты.

3. Блокировка в robots.txt – откройте раздел robots.txt Tester и убедитесь, что важные разделы сайта не блокируются. Внесите корректировки, если нужно разрешить индексацию.

4. Дубликаты и канонизация – в настройках WordPress или через SEO-плагины (например, Yoast SEO) задайте правильные канонические URL, чтобы избежать дублирования контента.

После внесения изменений используйте кнопку «Проверить исправление» в Google Search Console для обновления статуса ошибок. Регулярный мониторинг раздела «Покрытие» позволяет своевременно выявлять и устранять проблемы, обеспечивая корректную индексацию сайта.

Оптимизация скорости загрузки сайта для повышения индексации

Скорость загрузки страницы – один из факторов ранжирования в Google и Яндекс. Медленные сайты индексируются реже: поисковые роботы тратят меньше времени на сканирование, и часть страниц может не попасть в индекс.

Отключите и удалите неиспользуемые плагины. Каждый активный плагин увеличивает количество HTTP-запросов и размер DOM. Используйте инструменты Query Monitor или P3 Profiler для выявления ресурсоемких дополнений.

Активируйте кэширование страниц с помощью плагинов типа WP Super Cache или LiteSpeed Cache. Это позволит отдавать статичный HTML вместо генерации страниц при каждом запросе.

Минимизируйте CSS и JavaScript. Плагин Autoptimize позволяет объединить и сжать файлы, уменьшая их объем. Скрипты, не влияющие на загрузку выше экрана, необходимо отложить (defer) или загрузить асинхронно (async).

Оптимизируйте изображения до загрузки на сайт. Используйте форматы WebP и сервисы сжатия без потери качества, например TinyPNG. Установите плагин, автоматически преобразующий изображения при загрузке.

Включите lazy load для медиа. WordPress поддерживает его нативно, но убедитесь, что тема и плагины не конфликтуют с этой функцией. Это снижает первоначальную нагрузку на браузер и ускоряет отображение страницы.

Выберите качественный хостинг с поддержкой PHP 8+, SSD-накопителями и HTTP/2. Разница в скорости между дешевым shared-хостингом и оптимизированной VPS может составлять до 300–500 мс.

Используйте CDN для раздачи статических ресурсов. Это сокращает время отклика для пользователей из других регионов и уменьшает нагрузку на основной сервер.

Проверяйте производительность через Google PageSpeed Insights и Lighthouse. Устраняйте конкретные замечания: крупные DOM-структуры, избыточные reflow, неиспользуемые CSS.

Вопрос-ответ:

Нужно ли устанавливать SEO-плагины, если сайт уже индексируется?

Если сайт уже попадает в результаты поиска, это не значит, что он отображается там так, как хотелось бы. SEO-плагины, такие как Yoast SEO или Rank Math, помогают управлять заголовками, мета-описаниями, схемой страниц, а также автоматически создавать карту сайта. Это значительно упрощает контроль над тем, как контент представляется поисковым системам. Без таких инструментов приходится вручную прописывать множество технических параметров.

Чем отличается карта сайта в формате XML от обычного меню навигации?

Меню навигации предназначено для удобства посетителей. Оно показывает структуру сайта в визуальной форме и помогает пользователям переходить между разделами. XML-карта сайта — это специальный файл для поисковых систем. Он содержит список всех URL, которые должны быть проиндексированы, и может включать дополнительную информацию: дату последнего обновления, приоритет страницы и частоту обновлений. Такая карта не видна обычным посетителям, но существенно облегчает сканирование сайта роботами.

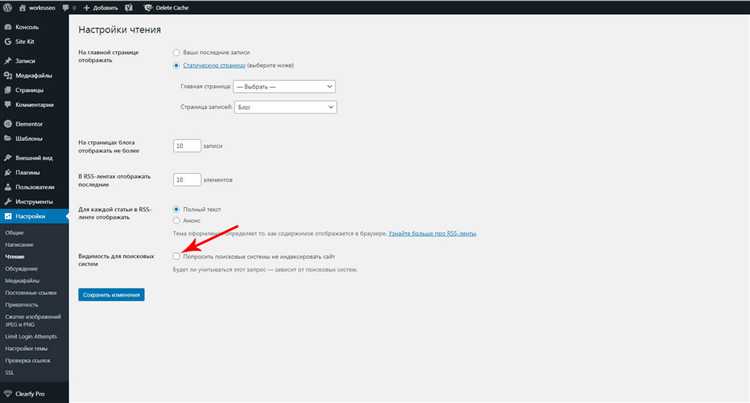

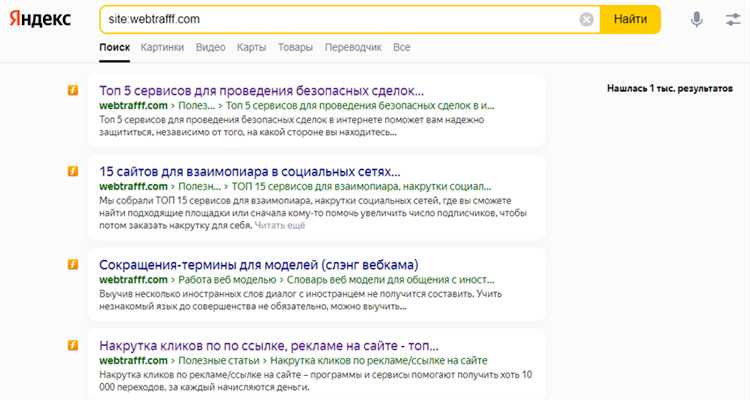

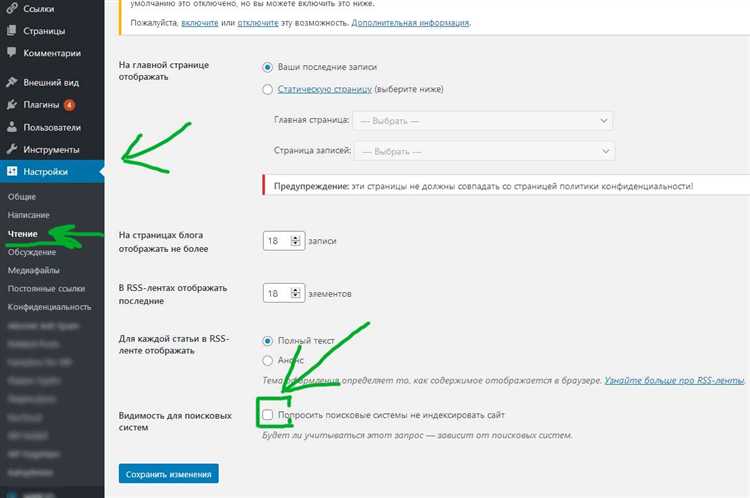

Как проверить, какие страницы сайта уже попали в индекс поисковика?

Самый простой способ — использовать оператор site: в Google. Например, введите в поисковой строке `site:вашдомен.ru`, чтобы увидеть, какие страницы уже отображаются. Также можно подключить сайт к Google Search Console или Яндекс Вебмастеру. Эти сервисы показывают более точную информацию: какие страницы были проиндексированы, какие — нет, и по каким причинам. Кроме того, они позволяют вручную отправлять страницы на переобход.

Может ли неправильная структура ссылок повлиять на индексацию?

Да. Если структура ссылок слишком запутанная, содержит параметры, дублит контент или постоянно меняется, это мешает роботам быстро и корректно обрабатывать сайт. Лучше использовать постоянные ссылки (чПУ) с понятным URL: например, `site.ru/katalog/kategoriya-tovara` вместо `site.ru/?p=123`. Это облегчает восприятие как для пользователей, так и для поисковых систем.

Какие плагины WordPress стоит использовать, чтобы улучшить индексацию сайта?

Для улучшения индексации подходят плагины, которые помогают управлять метаданными, картами сайта и редиректами. Один из самых популярных — **Yoast SEO**. Он позволяет настраивать заголовки, описания, канонические ссылки, а также автоматически создает XML-карту сайта. Еще один полезный плагин — **Redirection**, он помогает управлять перенаправлениями и устранять ошибки 404. Также стоит обратить внимание на **WP Super Cache** или **W3 Total Cache** для ускорения загрузки страниц, поскольку скорость влияет на поведение поисковых ботов. Все плагины желательно настраивать вручную и проверять изменения через Google Search Console.