Видеокарты Tesla от компании NVIDIA предназначены для высокопроизводительных вычислений, обработки больших объемов данных и научных исследований. Они используются в задачах, требующих параллельной обработки, таких как машинное обучение, симуляции и анализ данных. В отличие от обычных игровых видеокарт, Tesla ориентирована на обработку вычислений, а не на графику, что делает её идеальным инструментом для работы с большими вычислительными нагрузками.

Основное преимущество видеокарт Tesla – это поддержка вычислений с использованием технологий CUDA, которые позволяют эффективно распределять задачи между тысячами ядер. Это открывает возможности для ускоренной обработки данных, особенно в таких областях, как искусственный интеллект и глубокое обучение. Для оптимального использования Tesla важно правильно настроить рабочую среду, включая драйвера и библиотеки, которые поддерживают архитектуру CUDA.

Для начала работы с Tesla необходимо установить соответствующие драйвера NVIDIA и фреймворки, такие как TensorFlow или PyTorch, которые оптимизированы для использования GPU. Важно учитывать, что Tesla предназначена для серверных установок, и для её правильной работы потребуется серверное оборудование с поддержкой необходимого охлаждения и питания. Для пользователей, желающих использовать Tesla на рабочих станциях, стоит обратить внимание на модели с поддержкой PCIe Gen3, что обеспечивает высокую пропускную способность.

Кроме того, Tesla поддерживает технологии, такие как NVLink, которые позволяют связывать несколько видеокарт для ещё большего увеличения вычислительной мощности. Это может быть полезно при работе с крупными моделями машинного обучения или сложными вычислительными задачами. Подключение нескольких карт позволяет значительно ускорить процесс обучения нейросетей или обработки данных в параллельном режиме.

Подключение видеокарты Tesla к серверу или рабочей станции

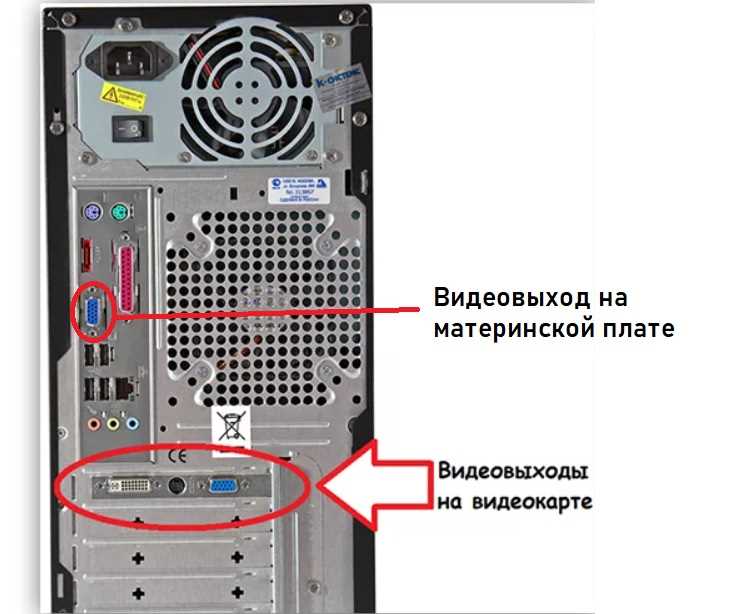

Для подключения видеокарты Tesla к серверу или рабочей станции необходимо учесть несколько факторов, таких как совместимость с аппаратным обеспечением, наличие подходящих слотов и установка необходимого ПО.

Первый шаг – установка видеокарты в соответствующий слот PCIe на материнской плате. Для этого потребуется выделенный слот PCIe x16, так как видеокарты Tesla требуют высокой пропускной способности. Убедитесь, что ваш сервер или рабочая станция поддерживает установку ускорителей CUDA, которые обычно используются с Tesla для вычислений.

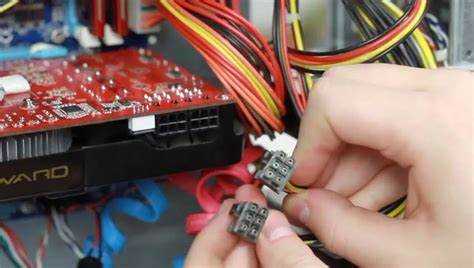

После установки видеокарты в слот, подключите её к источнику питания, если это необходимо. Некоторые модели Tesla могут требовать дополнительного питания через 6- или 8-контактный разъем питания от блока питания.

Для корректной работы видеокарты Tesla потребуется установить драйверы NVIDIA. Рекомендуется использовать драйвера, совместимые с вашей версией операционной системы, а также с версией CUDA. Эти драйвера обеспечат поддержку работы с библиотеками и инструментами для вычислений. Установка драйвера может быть выполнена через официальный сайт NVIDIA или через пакетный менеджер операционной системы (например, с помощью apt на Ubuntu).

После установки драйверов рекомендуется проверить, что видеокарта правильно подключена и распознается системой. Для этого можно использовать команду nvidia-smi в терминале, которая выведет статус видеокарты, её загрузку и температуру. Если видеокарта отображается в списке, значит, установка прошла успешно.

Если система использует несколько видеокарт Tesla, важно убедиться, что драйвера и конфигурация ПО поддерживают работу с несколькими устройствами. В таких случаях необходимо настроить параметры CUDA, чтобы эффективно распределять вычислительные задачи между картами.

Для выполнения задач с использованием видеокарты Tesla в вычислениях часто используются такие инструменты, как TensorFlow или PyTorch, которые поддерживают работу с CUDA. Они могут автоматически использовать видеокарты Tesla для ускорения вычислений без необходимости вручную настраивать параметры работы с GPU.

Также стоит обратить внимание на охлаждение видеокарты. В случае серверов и рабочих станций, используемых для интенсивных вычислений, необходимо обеспечить достаточную вентиляцию или использовать системы жидкостного охлаждения для предотвращения перегрева.

Установка драйверов и программного обеспечения для видеокарты Tesla

Для использования видеокарт Tesla в вычислительных задачах необходимо установить драйверы и программное обеспечение, которые обеспечат совместимость и максимальную производительность. Процесс установки состоит из нескольких шагов.

Сначала скачайте и установите NVIDIA Driver для вашей операционной системы с официального сайта NVIDIA. Для видеокарт Tesla рекомендуется использовать драйверы серии CUDA, так как они поддерживают вычислительные задачи и позволяют использовать GPU для параллельных вычислений.

После установки драйвера, выполните настройку CUDA Toolkit. Этот набор инструментов включает библиотеки, компиляторы и утилиты, необходимые для разработки и запуска приложений, использующих вычисления на GPU. Для этого скачайте последнюю версию CUDA с официального сайта NVIDIA и следуйте инструкциям по установке. Убедитесь, что у вас установлен соответствующий компилятор (например, GCC для Linux) и правильно настроены переменные окружения, такие как PATH и LD_LIBRARY_PATH для Linux или PATH для Windows.

Также потребуется установить NVIDIA cuDNN, если вы планируете использовать GPU для задач глубокого обучения. cuDNN – это библиотека для ускорения нейросетевых вычислений, которая тесно интегрируется с CUDA. Скачайте версию cuDNN, совместимую с вашей версией CUDA, и следуйте инструкциям по установке.

Для управления видеокартой Tesla и мониторинга ее состояния используйте утилиту nvidia-smi, которая входит в комплект драйверов NVIDIA. Эта команда позволяет отслеживать использование памяти, температуру и загрузку GPU, а также позволяет управлять режимами работы карты.

На этапе настройки программного обеспечения для вычислений также может потребоваться установка библиотек и фреймворков, таких как TensorFlow, PyTorch или других, которые поддерживают работу с CUDA. Убедитесь, что эти библиотеки установлены с поддержкой GPU и правильно конфигурированы для работы с вашей видеокартой.

После завершения установки драйверов и программного обеспечения рекомендуется перезагрузить систему, чтобы изменения вступили в силу. Проверьте корректность работы видеокарты, запустив тестовые вычисления, например, с использованием примеров из CUDA Toolkit.

Настройка CUDA для выполнения вычислений на видеокарте Tesla

Для начала работы с CUDA на видеокарте Tesla необходимо установить драйверы и библиотеку CUDA Toolkit. Эти компоненты обеспечивают связь между приложением и видеокартой, а также позволяют использовать ресурсы GPU для параллельных вычислений.

Шаг 1: Установка драйвера NVIDIA

Первым делом необходимо установить драйверы, совместимые с вашей видеокартой Tesla. Для этого скачайте актуальные версии с официального сайта NVIDIA. После загрузки выполните установку, следуя инструкциям на экране. Для успешной работы с CUDA рекомендуется использовать драйверы, которые поддерживают вашу модель видеокарты.

Шаг 2: Установка CUDA Toolkit

Загрузите последнюю версию CUDA Toolkit с официального сайта NVIDIA. Убедитесь, что версия CUDA совместима с вашим драйвером и операционной системой. При установке выберите компоненты, включая NVIDIA Compiler (nvcc), библиотеки cuBLAS, cuFFT, cuDNN и другие, которые могут понадобиться для специфических вычислений.

Шаг 3: Настройка переменных окружения

После установки CUDA необходимо настроить переменные окружения. Для этого добавьте в файл конфигурации оболочки (например, .bashrc или .zshrc) следующие строки:

export PATH=/usr/local/cuda-11.2/bin:$PATH export LD_LIBRARY_PATH=/usr/local/cuda-11.2/lib64:$LD_LIBRARY_PATH

Эти строки позволят системе распознавать команды и библиотеки CUDA. Не забудьте перезапустить терминал или выполнить команду source ~/.bashrc, чтобы изменения вступили в силу.

Шаг 4: Проверка установки

Для проверки правильности установки выполните команду nvcc --version, чтобы убедиться, что компилятор CUDA установлен правильно. Также можно запустить пример из пакета CUDA Toolkit, например deviceQuery, который даст информацию о доступных устройствах для выполнения вычислений.

Шаг 5: Разработка и запуск приложений

Теперь, когда CUDA настроена, можно разрабатывать и запускать приложения, использующие GPU для вычислений. Для этого создайте исходный код, используя CUDA API. Важно помнить, что для выполнения вычислений на видеокарте Tesla необходимо использовать правильные методы работы с памятью и потоками, чтобы максимально эффективно использовать ресурсы GPU.

Использование библиотеки cuDNN для ускорения вычислений на Tesla

Библиотека cuDNN, разработанная NVIDIA, предоставляет оптимизированные функции для работы с нейросетями и другими вычислениями, требующими интенсивных операций с матрицами и векторами. Для видеокарт Tesla, ориентированных на вычисления, использование cuDNN значительно ускоряет процесс обработки данных и обучение моделей глубокого обучения.

cuDNN предлагает ряд преимуществ при работе с архитектурами NVIDIA, такими как Tesla V100, T4 или A100. Библиотека включает в себя высокоэффективные реализации таких операций, как свертки, активации, нормализация и другие ключевые функции, которые используются в нейросетевых вычислениях. Это позволяет оптимизировать время работы алгоритмов и повысить производительность при параллельной обработке на GPU.

Для использования cuDNN на Tesla, необходимо установить драйвера CUDA и саму библиотеку cuDNN. Важно убедиться, что выбранная версия cuDNN совместима с версией CUDA, установленной на вашей системе. После установки, настройка происходит через простое подключение библиотеки в коде, используя API cuDNN для выполнения операций с тензорами.

Оптимизация вычислений заключается в использовании специализированных примитивов cuDNN для работы с нейросетями, таких как cuDNNConvolutionForward для сверток и cuDNNActivationForward для активации. Это позволяет значительно ускорить выполнение этих операций на видеокартах Tesla. Например, при обучении сверточных нейросетей ускорение может достигать 2-3 раз по сравнению с выполнением тех же операций на CPU.

Кроме того, cuDNN позволяет использовать стратегию многопоточной работы с разбиением данных по потокам, что позволяет более эффективно использовать вычислительные ресурсы Tesla. Важным аспектом является также возможность оптимизации работы с памятью, что играет ключевую роль при работе с большими моделями и большими объемами данных, характерными для вычислений на Tesla.

Для пользователей, работающих с библиотеками глубокого обучения, такими как TensorFlow, PyTorch или Caffe, интеграция cuDNN происходит автоматически, что делает использование библиотеки максимально удобным. Эти фреймворки автоматически используют cuDNN для ускорения операций, таких как обучение и инференс моделей, что позволяет разработчикам сосредоточиться на архитектуре нейросети, а не на оптимизации низкоуровневых операций.

Оптимизация работы с видеокартой Tesla для научных расчетов

Для максимальной производительности необходимо правильно распределить задачи между процессором и видеокартой. Использование таких инструментов, как CUDA Toolkit и cuBLAS, позволяет ускорить выполнение математических операций, таких как матричные умножения, которые являются основой многих научных приложений. Важно оптимизировать код, чтобы минимизировать операции на CPU и эффективно распределить нагрузку между GPU и CPU.

Для снижения задержек и улучшения производительности стоит учитывать характеристики видеокарты Tesla, такие как количество ядер CUDA и объем памяти. Эффективное использование памяти критично, так как ограниченные ресурсы видеокарты могут замедлить выполнение сложных вычислений. Рекомендуется оптимизировать работу с памятью, используя такие методы, как потоковая передача данных и уменьшение операций записи в память GPU.

Для ускорения научных расчетов с использованием видеокарты Tesla рекомендуется активно использовать возможности многозадачности. Использование нескольких потоков для параллельных вычислений помогает значительно ускорить процесс обработки данных. Важно настроить систему таким образом, чтобы GPU работал с несколькими задачами одновременно, эффективно используя все доступные вычислительные ресурсы.

При проведении длительных вычислений стоит следить за температурой видеокарты. Перегрев может существенно снизить производительность и привести к сбоям. Установите систему мониторинга, чтобы отслеживать рабочие параметры видеокарты в реальном времени и избежать перегрева. В некоторых случаях стоит настроить дополнительное охлаждение для более стабильной работы.

Для научных расчетов, связанных с большими объемами данных, стоит обратить внимание на использование специализированных алгоритмов с учетом архитектуры GPU. Например, алгоритмы, ориентированные на работу с векторами и матрицами, могут быть значительно ускорены за счет оптимизации для работы с массивами данных, размещенными в видеопамяти Tesla.

Мониторинг производительности видеокарты Tesla в реальном времени

Для эффективного использования видеокарты Tesla в вычислительных задачах необходимо постоянно отслеживать её производительность. Существуют несколько инструментов и методов для мониторинга в реальном времени, которые позволяют выявить узкие места и оптимизировать загрузку устройства.

Основные параметры, которые важно отслеживать:

- Загрузка процессора (GPU Utilization) – показывает процент использования графического процессора. Это ключевая метрика для оценки общей активности видеокарты.

- Температура – высокие температуры могут снижать производительность и приводить к перегреву. Мониторинг температуры помогает своевременно предотвратить проблемы с охлаждением.

- Память GPU – загрузка видеопамяти может быть критической, особенно при больших вычислительных нагрузках. Важно отслеживать как использование памяти, так и её доступность.

- Энергопотребление – мониторинг потребляемой мощности помогает предотвратить перегрузку системы и обеспечить стабильную работу устройства.

- Ошибки и сбои – важно отслеживать ошибки вычислений или состояния системы, чтобы оперативно реагировать на сбои и минимизировать потери производительности.

Для мониторинга можно использовать несколько инструментов:

- nvidia-smi – утилита командной строки, предоставляющая подробную информацию о состоянии видеокарты, включая загрузку, температуру и использование памяти. Пример команды:

nvidia-smi -q -d UTILIZATION. - DCGM (Data Center GPU Manager) – более продвинутая утилита, предназначенная для работы с несколькими картами Tesla в дата-центрах. Предоставляет расширенные возможности мониторинга и управления состоянием устройств.

- GPU-Z – графический инструмент, который предоставляет подробную информацию о видеокарте, включая температуру, загрузку, скорость вентиляторов и другие параметры в реальном времени.

Рекомендуется также интегрировать мониторинг с системами оповещений, чтобы оперативно реагировать на перегрузки или аварийные состояния. В этом случае данные о производительности могут быть отправлены в реальном времени через e-mail или в системы мониторинга типа Prometheus или Zabbix.

Оптимизация использования видеокарты Tesla невозможна без регулярного мониторинга этих показателей, что позволяет не только повысить эффективность работы, но и продлить срок службы устройства.

Настройка распределённых вычислений с видеокартой Tesla

Основные шаги:

- Выбор и настройка инфраструктуры: Для распределённых вычислений с использованием видеокарт Tesla лучше всего подходят серверы с поддержкой CUDA или OpenCL. Определите количество узлов, доступных для работы, и их расположение. Все узлы должны быть связаны высокоскоростной сетью, чтобы минимизировать задержки при обмене данными.

- Установка драйверов и библиотек: На каждом узле кластера необходимо установить драйверы для видеокарт Tesla. Рекомендуется использовать последние версии драйверов от NVIDIA. Для работы с CUDA потребуется установить CUDA Toolkit, а для OpenCL – соответствующие библиотеки. Важно также настроить переменные окружения, такие как

CUDA_HOME, для правильной работы инструментов. - Настройка распределённых вычислений: Используйте платформы для управления распределёнными вычислениями, такие как MPI (Message Passing Interface), или специализированные фреймворки, например, TensorFlow с поддержкой распределённого обучения. С помощью MPI можно эффективно распределить задачи между несколькими узлами и синхронизировать вычисления на GPU. Также важно настроить балансировку нагрузки между узлами, чтобы избежать перегрузки отдельных видеокарт.

- Мониторинг и управление ресурсами: Для мониторинга состояния видеокарт и загрузки системы используйте инструменты, такие как

nvidia-smiиnvprof. Они позволяют отслеживать температуру, использование памяти и процессора на каждой видеокарте. Для управления задачами и очередями можно настроить систему управления вычислительными задачами, например, Slurm или Kubernetes. - Оптимизация производительности: Настройте параметры производительности, такие как использование режимов энергосбережения и частоты работы видеокарт. Разделяйте задачи на более мелкие части для параллельного выполнения, что значительно улучшит производительность. Важно учитывать архитектуру используемой видеокарты Tesla (например, Volta или Ampere) для корректной настройки рабочих нагрузок и алгоритмов обработки данных.

Эффективное распределённое вычисление с использованием видеокарт Tesla требует внимательной настройки каждого компонента системы. Придерживаясь этих рекомендаций, можно существенно повысить производительность и надёжность вычислений.

Решение распространённых проблем при использовании Tesla для вычислений

Другая распространённая проблема – перегрев видеокарты. Важно следить за температурой, используя утилиты вроде nvidia-smi, для мониторинга состояния устройства в реальном времени. Если температура превышает безопасные значения (обычно выше 85°C), необходимо улучшить охлаждение, либо снизить нагрузку на карту. Установка дополнительных вентиляторов или улучшение циркуляции воздуха в серверном помещении помогает избежать перегрева.

Некоторые пользователи сталкиваются с низкой производительностью при использовании Tesla в задачах, требующих интенсивных вычислений. Часто это связано с неправильной настройкой алгоритмов или неэффективным использованием CUDA. Оптимизация программного кода и использование более высокоуровневых библиотек, таких как cuDNN или TensorRT, позволяет значительно повысить производительность. Также важно учитывать, что для работы с вычислительными задачами необходима настройка параметров работы с памятью, что позволяет избежать её перегрузки и ошибок в выполнении программ.

Могут возникать проблемы с совместимостью Tesla с некоторыми моделями серверов или рабочих станций. Это обычно связано с ограничениями по мощности блока питания или физическим размером карты. Для устранения этой проблемы стоит заранее проверять требования к питанию и совместимость с сервером, а в случае необходимости – обновить блок питания или использовать дополнительные коннекторы питания.

Ещё одной проблемой является сбой в работе при параллельных вычислениях. Это может происходить из-за неправильного распределения задач между несколькими процессорами GPU. Решением будет корректная настройка распределённых вычислений, а также использование библиотек, которые эффективно управляют многозадачностью, например, NCCL для взаимодействия между устройствами.

Также стоит обратить внимание на периодическую проверку работы видеокарты с использованием утилит диагностики, таких как Tesla Diagnostic Tool или nvidia-smi. Эти инструменты позволяют выявлять потенциальные проблемы на ранних стадиях, например, сбои в работе памяти или процессора видеокарты.

Вопрос-ответ:

Как можно использовать видеокарту Tesla для вычислений?

Видеокарты Tesla от NVIDIA предназначены для высокопроизводительных вычислений, таких как обработка данных в области машинного обучения, моделирования и научных расчетов. Они могут эффективно использоваться для задач, требующих параллельной обработки данных, например, в нейронных сетях и больших вычислительных задачах. Видеокарты Tesla обладают большим количеством ядер CUDA, что позволяет ускорить выполнение различных алгоритмов, таких как матричные операции, что полезно в расчетах и симуляциях.

Какие преимущества использования видеокарты Tesla для научных вычислений?

Основное преимущество видеокарт Tesla — это способность выполнять вычисления параллельно, что значительно ускоряет обработку данных по сравнению с традиционными процессорами. Это делает их идеальными для задач, требующих высокой производительности, таких как анализ больших объемов данных или решение сложных математических моделей. Кроме того, видеокарты Tesla часто обладают более высокими объемами памяти и лучшей пропускной способностью, что также способствует ускорению вычислений в приложениях, связанных с глубоким обучением и обработкой больших данных.

Какие приложения могут воспользоваться видеокартами Tesla для работы?

Видеокарты Tesla находят применение в самых разных областях, включая медицинские исследования, финансовое моделирование, обработку видео и изображений, а также в анализе больших данных. Например, в биоинформатике Tesla могут использоваться для ускорения вычислений в исследованиях геномики, в области машинного обучения — для тренировки глубоких нейронных сетей. Видеокарты также эффективны в задачах, связанных с компьютерной графикой, рендерингом и созданием сложных трехмерных моделей.

Как настроить видеокарту Tesla для работы с CUDA?

Для использования видеокарты Tesla с платформой CUDA необходимо установить соответствующие драйверы NVIDIA и библиотеку CUDA Toolkit. Это включает в себя скачивание и установку последних версий драйверов и программного обеспечения с официального сайта NVIDIA. После установки драйверов можно настроить окружение для работы с CUDA, а затем использовать язык программирования, такой как C++ или Python, для написания программ, которые будут использовать GPU для вычислений. Важно, чтобы ваша система поддерживала работу с CUDA, а видеокарта Tesla была корректно установлена и распознана операционной системой.

Какой тип вычислений на видеокарте Tesla подойдет для машинного обучения?

Видеокарты Tesla идеально подходят для задач, связанных с машинным обучением, благодаря их способности обрабатывать огромные объемы данных одновременно. Они используются для тренировки нейронных сетей, таких как сверточные нейронные сети (CNN), которые требуют интенсивных вычислений. Использование видеокарт Tesla позволяет значительно сократить время обучения моделей, улучшая скорость и эффективность. Особенно полезными они становятся при работе с большими наборами данных, когда требуется ускорить алгоритмы обучения, такие как градиентный спуск или другие методы оптимизации.