Для повышения производительности Python на операционной системе Ubuntu существует несколько эффективных методов, которые помогут оптимизировать использование ресурсов и ускорить выполнение кода. Эти рекомендации подходят как для небольших скриптов, так и для масштабных проектов, где важна каждая единица времени.

1. Использование JIT-компиляции

Одним из способов ускорить работу Python является использование JIT-компилятора. Библиотека PyPy предоставляет такой механизм, значительно сокращая время выполнения за счет динамической компиляции кода в машинный язык. Для задач, где Python часто выполняет однотипные операции, PyPy может дать существенные преимущества по сравнению с традиционным CPython.

2. Профилирование и оптимизация кода

Не менее важным этапом является профилирование. Используйте инструменты, такие как cProfile или line_profiler, чтобы выявить узкие места в вашем коде. Эти утилиты позволяют точно определить, какие участки кода требуют оптимизации, а затем сосредоточиться на улучшении наиболее ресурсоемких функций. Например, замена стандартных циклов на эффективные алгоритмы из библиотеки NumPy или использование многопоточности поможет значительно ускорить выполнение.

3. Ускорение работы с библиотеками

Библиотеки, такие как NumPy, pandas и scipy, специально разработаны для работы с большими объемами данных и вычислениями, обеспечивая значительное улучшение производительности. Вместо работы с обычными списками в Python, используйте массивы NumPy, которые реализуют низкоуровневые оптимизации и позволяют избежать накладных расходов стандартных типов данных.

4. Использование многозадачности и многопоточности

Для многозадачных операций следует использовать многопроцессорность. Библиотека multiprocessing позволяет запускать параллельные процессы, которые могут эффективно использовать несколько ядер процессора. Однако стоит помнить, что Python не всегда идеально работает с многозадачностью через потоки из-за GIL (Global Interpreter Lock), поэтому для вычислительно сложных задач предпочтительнее использовать процессы.

5. Оптимизация работы с файлами

Оптимизация настроек интерпретатора Python

Первое, на что стоит обратить внимание, – это использование флага `-O` при запуске Python. Этот флаг исключает генерацию `.pyo` файлов, что может ускорить запуск программы. Также стоит отметить, что в режиме оптимизации Python игнорирует инструкции, связанные с отладочной информацией, что снижает накладные расходы на выполнение.

Для улучшения производительности можно использовать интерпретатор PyPy вместо стандартного CPython. PyPy использует Just-in-Time (JIT) компиляцию, что позволяет ускорить выполнение кода в несколько раз, особенно в случаях с длительными вычислениями или высокими требованиями к скорости. PyPy особенно эффективен при выполнении цикличных и числовых операций.

Если производительность критична, стоит настроить сборщик мусора. Сборщик мусора в Python иногда может замедлять выполнение программы, особенно при большом количестве объектов, подлежащих сбору. Включение флага `PYTHONMALLOC=malloc` позволяет ускорить работу с памятью. Использование библиотеки `gc` для управления сборкой мусора позволяет вручную вызывать её работу, избегая ненужных пауз в критичных местах.

Параметр `PYTHONHASHSEED` может быть полезен для ускорения работы с хешированием строк в Python. Установив его значение в фиксированное число, можно избежать изменений порядка хешей в разных запусках программы. Это улучшит предсказуемость и производительность при многократных запусках.

Настройка многозадачности в Python также оказывает влияние на производительность. Использование библиотеки `multiprocessing` для параллельного выполнения задач может существенно повысить скорость работы, особенно на многоядерных процессорах. Важно избегать блокировок GIL (Global Interpreter Lock), которые могут снижать производительность при многозадачности в стандартной реализации Python.

Использование виртуальных окружений для изоляции проектов

Для создания и управления виртуальными окружениями в Python используется инструмент venv, который входит в стандартную библиотеку. Это позволяет эффективно работать с несколькими проектами, не влияя друг на друга.

Основные шаги для работы с виртуальными окружениями:

- Установка виртуального окружения: Для создания нового окружения используйте команду:

python3 -m venv /путь/к/окружению

- Активация окружения: После создания виртуального окружения его необходимо активировать:

source /путь/к/окружению/bin/activate

- Установка зависимостей: Все пакеты, которые устанавливаются через

pip, будут сохраняться в пределах виртуального окружения. Например:pip install requests

- Деактивация окружения: Чтобы выйти из виртуального окружения, используйте команду:

deactivate

Кроме того, для управления зависимостями проекта можно использовать файл requirements.txt, который фиксирует все установленные библиотеки и их версии. Для генерации этого файла используется команда:

pip freeze > requirements.txt

Чтобы восстановить все зависимости из файла на другом устройстве или в другом окружении, достаточно выполнить:

pip install -r requirements.txt

Важно помнить, что виртуальные окружения помогают избежать множества проблем, связанных с конфликтующими зависимостями и различными версиями библиотек. Это особенно полезно при работе с проектами, которые требуют специфических версий Python или сторонних библиотек.

Кроме venv, для работы с виртуальными окружениями можно использовать virtualenv или conda, в зависимости от особенностей проекта и предпочтений. Но venv подходит для большинства случаев, так как является встроенным инструментом.

Поддержка виртуальных окружений также помогает упростить процесс разработки, так как каждый проект будет иметь изолированную среду, не влияя на систему в целом. Это значительно ускоряет разработку и снижает вероятность ошибок, связанных с несовместимостью зависимостей.

Установка и настройка компилятора Cython для ускорения выполнения кода

Для ускорения выполнения Python-кода на Ubuntu можно использовать Cython – компилятор, который преобразует Python-код в C-расширения. Это позволяет значительно повысить производительность, особенно в вычислительно интенсивных задачах. В следующем разделе рассмотрим, как установить и настроить Cython для ускорения выполнения программ.

Шаг 1: Установка Cython

Для начала необходимо установить Cython на вашу систему. Это можно сделать с помощью пакетного менеджера apt и pip. В терминале выполните следующие команды:

sudo apt update

sudo apt install cython3

pip install cython

Если планируется использование Cython в виртуальной среде, сначала создайте её:

python3 -m venv venv

source venv/bin/activate

Затем установите Cython через pip в активированной среде.

Шаг 2: Написание Cython-кода

Cython позволяет писать код с расширениями, близкими к синтаксису Python, но с возможностью использования статической типизации. Создайте файл с расширением .pyx для написания Cython-кода. Например, файл example.pyx:

def fib(int n): if n <= 1: return n else: return fib(n-1) + fib(n-2)

Шаг 3: Компиляция Cython-кода

Для компиляции Cython-файлов создайте файл setup.py в том же каталоге:

from setuptools import setup

from Cython.Build import cythonize

setup(

ext_modules=cythonize("example.pyx")

)

Затем выполните команду в терминале для сборки расширений:

python3 setup.py build_ext --inplace

Этот процесс создаст скомпилированный файл расширения, который будет доступен в вашем проекте как example.cpython-XX.so, где XX – версия Python.

Шаг 4: Использование Cython в Python

После компиляции можно использовать Cython-расширения как обычный Python-модуль. В вашем Python-коде подключите скомпилированный модуль:

import example print(example.fib(10))

Шаг 5: Оптимизация с использованием типизации

Для дальнейшего увеличения производительности рекомендуется использовать статическую типизацию. Например, можно указать типы аргументов и возвращаемого значения:

def fib(int n) -> int: if n <= 1: return n else: return fib(n-1) + fib(n-2)

Это позволяет компилятору генерировать более эффективный код, что приводит к значительному ускорению выполнения.

Заключение

Cython – мощный инструмент для оптимизации Python-кода. Он позволяет интегрировать код на C с Python, значительно ускоряя выполнение. Использование Cython эффективно в задачах с высокими требованиями к производительности, таких как численные вычисления и обработка больших объемов данных.

Подключение многозадачности с использованием многопоточности и многопроцессорности

Для улучшения производительности Python на Ubuntu, особенно при обработке интенсивных задач, важно использовать подходы многозадачности. Эти подходы можно разделить на два основных типа: многопоточность и многопроцессорность. Оба метода позволяют эффективно распределять нагрузку, но выбор между ними зависит от характеристик задач.

Многопоточность подходит для задач, которые не требуют значительных вычислительных ресурсов и в основном работают с I/O операциями (например, сети, файлы, базы данных). В Python многопоточность реализована с помощью модуля threading. Однако стоит учитывать, что из-за GIL (Global Interpreter Lock) настоящий параллелизм в многозадачных Python-программах не всегда возможен. GIL ограничивает выполнение байт-кода Python в одном процессе, что делает многопоточность менее эффективной для CPU-интенсивных операций.

Пример использования многопоточности для работы с файлами:

import threading

def process_file(file):

with open(file, 'r') as f:

data = f.read()

print(f"Обработка файла {file}")

files = ['file1.txt', 'file2.txt', 'file3.txt']

threads = []

for file in files:

thread = threading.Thread(target=process_file, args=(file,))

threads.append(thread)

thread.start()

for thread in threads:

thread.join()

Для параллельных вычислений, которые требуют эффективного использования всех ядер процессора, следует использовать многопроцессорность. В Python для этого используется модуль multiprocessing, который создает независимые процессы, каждый из которых имеет свой собственный интерпретатор Python и GIL. Это позволяет полностью использовать все доступные ядра процессора, что значительно повышает производительность при высоконагрузочных задачах, таких как обработка больших данных или сложные математические вычисления.

Пример использования многопроцессорности для параллельной обработки данных:

import multiprocessing

def compute_square(number):

return number ** 2

if __name__ == '__main__':

numbers = [1, 2, 3, 4, 5]

pool = multiprocessing.Pool(processes=multiprocessing.cpu_count())

results = pool.map(compute_square, numbers)

pool.close()

pool.join()

print(results)

Использование многопроцессорности эффективно при наличии ограничений на выполнение одного потока, таких как работа с большими массивами данных или выполнение ресурсоемких вычислений. Важно помнить, что запуск процессов требует больше системных ресурсов, чем потоки, что может быть неэффективно для задач, где время обработки и нагрузка минимальны.

Микширование многопоточности и многопроцессорности возможно с использованием таких инструментов, как concurrent.futures, который предоставляет абстракции для работы с потоками и процессами. Этот подход позволяет автоматически управлять задачами и облегчить параллельное выполнение.

Чтобы максимально эффективно использовать многозадачность, рекомендуется учитывать тип задачи, архитектуру системы и ресурсы, доступные в момент выполнения программы. Своевременная оптимизация этих процессов обеспечит значительное ускорение работы Python-программ на Ubuntu.

Управление зависимостями и оптимизация библиотек для быстродействия

Первым шагом в оптимизации является минимизация количества используемых зависимостей. Часто программисты добавляют библиотеки без предварительного анализа их необходимости. Для этого можно использовать инструменты, такие как `pipdeptree` или `pip-check`, чтобы выявить неиспользуемые пакеты и ненужные зависимости, которые не только увеличивают время старта программы, но и добавляют лишнюю нагрузку на систему.

Важно обновлять библиотеки до последних стабильных версий, так как в новых релизах часто устраняются баги и добавляются улучшения производительности. Используйте `pip install --upgrade

Для работы с большими объемами данных вместо чистого Python-кода используйте библиотеки, написанные на C или C++, такие как `Cython`. Это позволит значительно ускорить вычисления. Примером может быть использование `cythonize` для компиляции Python-кода в C-код, что особенно эффективно для численных расчетов.

Использование виртуальных окружений, например, через `venv` или `conda`, помогает изолировать проект и избежать конфликтов версий зависимостей. Это важно для стабильности и быстродействия, так как старые или несовместимые библиотеки могут замедлять работу всего проекта.

Еще одной важной практикой является использование профилирования кода для выявления узких мест в производительности. Инструменты, такие как `cProfile` или `line_profiler`, позволяют точно измерить, какие функции и библиотеки занимают больше всего времени, что позволяет нацеленно оптимизировать те части кода, которые оказывают наибольшее влияние на быстродействие.

Наконец, стоит обратить внимание на загрузку библиотек. Некоторые из них, например, `matplotlib` или `seaborn`, могут быть излишне ресурсоемкими для определенных задач. В таких случаях можно рассмотреть использование более легких альтернатив, например, `plotly` или `ggplot` для визуализации, которые могут предложить лучший баланс между возможностями и производительностью.

Настройка Ubuntu для улучшения работы с Python: конфигурация системы

Одним из ключевых моментов является настройка производительности диска. Для этого стоит установить и настроить файловую систему с поддержкой журналирования, например, ext4, а также включить опцию «noatime», чтобы уменьшить нагрузку от записи на диск при каждом доступе к файлам.

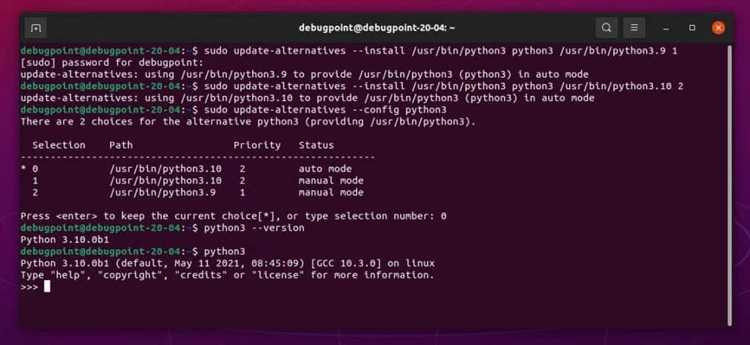

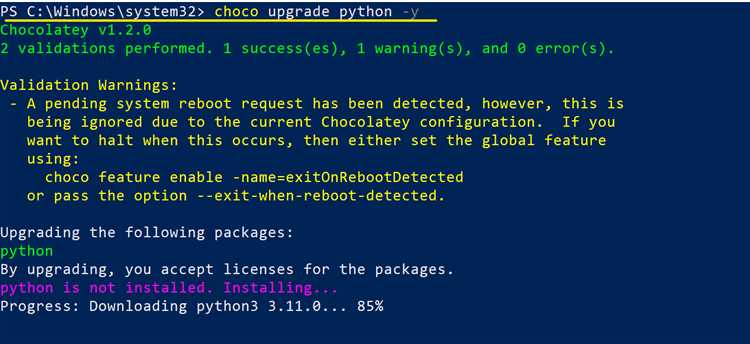

Убедитесь, что ваша система использует оптимальную версию Python. Для этого можно установить версию, подходящую для ваших задач, через пакетный менеджер apt или pyenv. Не стоит использовать старые или экспериментальные релизы для рабочих приложений.

Использование виртуальных окружений через venv или conda поможет изолировать зависимости проекта и ускорить работу Python. Это предотвратит возможные конфликты между библиотеками, а также позволит уменьшить нагрузку на систему.

Важно отключить ненужные сервисы, которые могут потреблять ресурсы. Для этого можно использовать команду systemctl для управления автозагрузкой служб, таких как Bluetooth или графические службы, если они не используются при работе с Python.

Один из аспектов улучшения работы с Python в Ubuntu – это использование кэширования. Для часто выполняемых операций можно настроить кэширование через библиотеки, такие как joblib, или использовать Redis для хранения промежуточных данных.

Для работы с большими объемами данных полезно оптимизировать использование памяти. Использование профайлеров, таких как memory_profiler или guppy3, поможет выявить утечки памяти и оптимизировать код.

Также рекомендуется настроить SWAP-файл для улучшения работы с памятью в случае высоких нагрузок. Размер swap-файла можно настроить в /etc/fstab, обеспечив более стабильную работу при нехватке оперативной памяти.

Если вы работаете с сетевыми приложениями, настройка параметров сетевого стека может ускорить работу с удаленными серверами. Настройка keepalive-соединений, увеличение буферов TCP и оптимизация параметров DNS помогут ускорить сетевые операции.

Вопрос-ответ:

Как можно ускорить выполнение Python-скриптов на Ubuntu?

Для ускорения работы Python-скриптов на Ubuntu стоит обратить внимание на несколько аспектов. Один из них — использование более производительных версий Python. Например, Python 3.10 и выше часто показывают лучшие результаты по сравнению с более старыми версиями. Также стоит оптимизировать код, избегая ненужных циклов и операций, а для многозадачных приложений можно применить многозадачность с помощью модуля concurrent.futures. Другой способ — использование Cython для компиляции критичных частей кода в C, что значительно ускоряет выполнение.

Как можно улучшить производительность Python при работе с большими данными?

Для работы с большими объемами данных можно использовать несколько подходов. Во-первых, стоит применять библиотеку NumPy для числовых вычислений, так как она оптимизирована для работы с массивами и матрицами. Во-вторых, использование библиотек, таких как Pandas, также может ускорить обработку данных благодаря оптимизированному коду на C. Для параллельной обработки данных можно применять библиотеки, такие как Dask, которые позволяют работать с большими наборами данных, распределяя их по нескольким процессам или машинам.

Как можно ускорить загрузку модулей в Python на Ubuntu?

Загрузка модулей в Python можно ускорить с помощью нескольких техник. Во-первых, стоит убедиться, что не загружаются лишние модули, и использовать только необходимые библиотеки. Во-вторых, можно использовать importlib для динамической загрузки модулей, что позволяет загружать только те модули, которые реально используются в текущий момент. Кроме того, полезно использовать кеширование и не загружать один и тот же модуль несколько раз в процессе работы программы.

Что такое профилирование кода и как оно может помочь в оптимизации Python на Ubuntu?

Профилирование кода помогает выявить узкие места в программе, которые замедляют её работу. В Python для этого можно использовать встроенные инструменты, такие как модуль cProfile, который собирает статистику о времени выполнения каждого метода или функции. После анализа профиля можно увидеть, какие участки кода требуют оптимизации. Например, можно сократить время работы, уменьшив количество вызовов медленных функций или заменив их более быстрыми аналогами.

Как настроить Python для работы с несколькими процессами на Ubuntu?

Для работы с несколькими процессами в Python можно использовать модуль multiprocessing. Этот модуль позволяет создать несколько процессов, каждый из которых будет выполняться на отдельном ядре процессора, что ускоряет выполнение программы, особенно если она выполняет независимые вычисления. Важно помнить, что для эффективной работы с многозадачностью необходимо правильно организовать обмен данными между процессами и управлять ими с помощью очередей и синхронизации.

Как ускорить работу Python на Ubuntu?

Чтобы ускорить работу Python на Ubuntu, можно использовать несколько стратегий. Во-первых, обновление версии Python до последней стабильной может повысить производительность, так как новые версии часто включают улучшения в интерпретаторе и библиотеках. Во-вторых, оптимизация кода с использованием профилирования позволяет выявить узкие места в программах, например, с помощью модуля cProfile. Также стоит обратить внимание на использование виртуальных окружений, чтобы избежать проблем с зависимостями и улучшить совместимость пакетов. Еще один вариант — использование компиляции с помощью Cython или PyPy, что позволяет ускорить выполнение вычислений. Наконец, настройка параметров системы и использование многозадачности с помощью потоков или процессов может значительно повысить производительность в многозадачных приложениях.

Какие инструменты можно использовать для ускорения Python-скриптов на Ubuntu?

Для ускорения работы Python-скриптов на Ubuntu можно применить несколько инструментов. Один из самых популярных — PyPy. Это альтернативный интерпретатор Python, который использует JIT-компиляцию для ускорения выполнения кода. Также можно использовать Cython, который позволяет компилировать Python-код в C-расширения, что значительно ускоряет работу, особенно для вычислительно тяжелых задач. Если необходимо оптимизировать работу с памятью, можно использовать библиотеку memory_profiler для отслеживания использования памяти в процессе выполнения. Для многозадачных приложений полезны такие инструменты, как multiprocessing для параллельных вычислений или использование очередей с помощью asyncio. Важно не забывать про профилирование кода с помощью таких утилит, как cProfile или line_profiler, чтобы точно знать, где происходят задержки в исполнении.