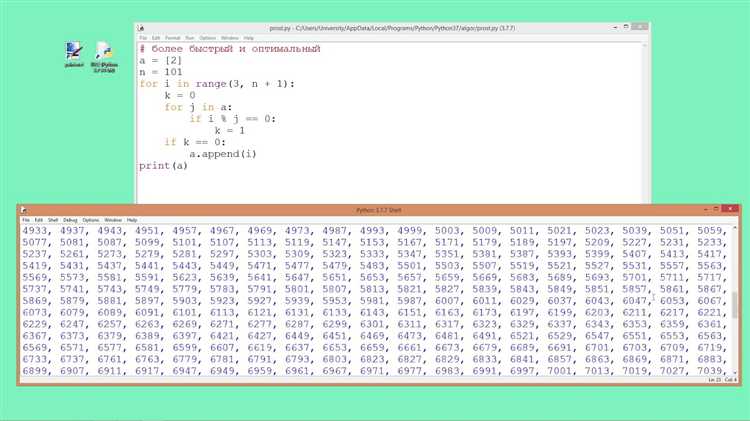

Одной из ключевых особенностей Python является его простота и удобство, но это также приводит к относительно низкой скорости выполнения кода по сравнению с языками, такими как C или C++. Однако есть несколько эффективных методов оптимизации, которые могут значительно повысить производительность. В этой статье мы рассмотрим конкретные подходы к ускорению вычислений в Python, включая использование более быстрых алгоритмов, библиотек и возможностей самого языка.

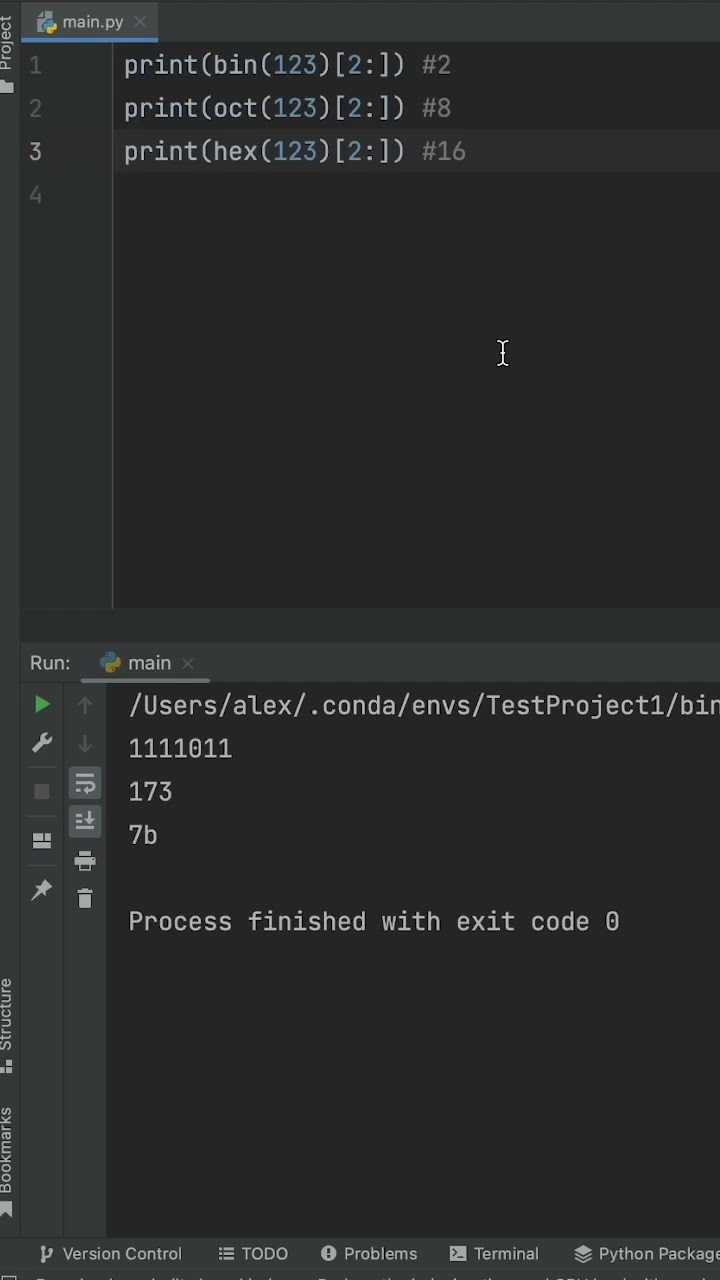

1. Использование встроенных функций и библиотек

Многие встроенные функции Python и стандартные библиотеки написаны на C, что значительно ускоряет их выполнение по сравнению с собственноручно написанным кодом на Python. Например, itertools или functools предлагают эффективные реализации для задач, связанных с итерациями и функциональным программированием. Также стоит обратить внимание на библиотеки, такие как NumPy и Pandas, которые оптимизируют работу с массивами и таблицами данных благодаря реализации на C и Fortran.

2. Векторизация с NumPy

Вместо того, чтобы обрабатывать данные в цикле, использование векторизации с библиотекой NumPy позволяет выполнять операции над массивами целиком, что снижает время вычислений за счет использования более быстрых внутренних операций. Например, выражение numpy.sum() выполняется гораздо быстрее, чем аналогичный цикл for, поскольку NumPy использует оптимизированные C-библиотеки для работы с массивами.

3. Параллелизм и многозадачность

Многозадачность с помощью concurrent.futures или multiprocessing может существенно ускорить выполнение задач, которые можно разделить на независимые части. multiprocessing позволяет использовать несколько ядер процессора, что особенно полезно при вычислениях, требующих интенсивных вычислительных ресурсов, таких как обработка больших данных или параллельные вычисления в машинном обучении.

4. Использование JIT-компиляции

Библиотека Numba предоставляет возможность компиляции Python-кода в машинный код с использованием JIT (Just-In-Time) компилятора. Этот подход позволяет ускорить выполнение функций, особенно при числовых расчетах, благодаря преобразованию Python в более быстрый код, исполнимый на процессоре или GPU.

Использование многозадачности и многопоточности для ускорения Python-программ

В Python многозадачность и многопоточность играют важную роль в ускорении вычислений, особенно при работе с задачами, которые могут быть параллелизованы. Важно понимать различия между этими подходами и их особенности для эффективного применения в конкретных случаях.

Многозадачность (Concurrency)

Многозадачность в Python предполагает выполнение нескольких задач одновременно, но не обязательно в реальном времени. Это особенно полезно, когда задачи блокируют выполнение других операций, например, при работе с I/O (сеть, файлы, базы данных).

- threading – стандартный модуль для создания потоков. Потоки работают параллельно в одном процессе и могут быть полезны для задач, требующих много I/O, но не параллельной работы с данными в памяти.

Многопоточность (Multithreading)

Многопоточность позволяет использовать несколько потоков в одном процессе. В Python каждый поток использует один и тот же адрес памяти, что упрощает обмен данными, но Global Interpreter Lock (GIL) ограничивает настоящую параллельную обработку в многопоточных приложениях, особенно на многоядерных процессорах.

- Для CPU-ограниченных задач многопоточность с GIL не даст значительного ускорения. В таких случаях лучше использовать многозадачность или многопроцессорность.

Многопроцессорность (Multiprocessing)

Многопроцессорность – это создание нескольких процессов, каждый из которых выполняется независимо. Это эффективный способ обойти ограничения GIL, так как каждый процесс работает в своем собственном адресном пространстве и может использовать отдельное ядро процессора.

- multiprocessing – стандартная библиотека Python для работы с многопроцессорностью. Каждый процесс имеет свой GIL, что позволяет обеспечить настоящую параллельность при выполнении вычислений.

- Для задач, которые требуют интенсивных вычислений, многопроцессорность является предпочтительным методом, так как она позволяет эффективно использовать многоядерные процессоры.

Рекомендации для эффективного применения

- Используйте многозадачность для I/O-ограниченных операций. Для задач, где основное время занимает ожидание ответа от внешнего источника (например, чтение из файла или сетевой запрос), лучше использовать

asyncioилиthreading. - Используйте многопроцессорность для вычислительно сложных задач. Для интенсивных вычислений, таких как обработка больших данных или машинное обучение, лучше применить

multiprocessing, чтобы эффективно распределить нагрузку между ядрами процессора. - Учитывайте накладные расходы. Многозадачность и многопоточность имеют свои накладные расходы, такие как переключение контекста и синхронизация. Чем меньше задачи, тем больше накладных расходов, поэтому важно не использовать параллелизм для тривиальных операций.

Использование правильного подхода зависит от типа задачи и характера вычислений. Многозадачность и многопоточность позволяют эффективно ускорять программы, но важно правильно выбрать инструмент в зависимости от ограничений, которые накладывает Python и особенности используемой задачи.

Оптимизация работы с массивами данных с помощью NumPy

Вот несколько способов улучшить скорость вычислений с массивами данных:

- Использование векторизации: Векторизация позволяет выполнить операции над массивами без явных циклов Python. Вместо того, чтобы перебирать элементы массива в цикле, NumPy применяет операции непосредственно ко всему массиву, что значительно ускоряет процесс. Например, для сложения двух массивов достаточно написать:

result = a + b, гдеaиb– это массивы, и операция выполнится за один шаг. - Меньше использование циклов: Python-циклы работают медленно по сравнению с векторизованными операциями. Например, чтобы умножить каждый элемент массива на скаляр, вместо цикла можно использовать операцию умножения на массив:

a * scalar. - Предпочтение встроенным функциям: NumPy предоставляет множество встроенных функций для работы с массивами, которые оптимизированы на уровне C. Это означает, что их производительность значительно выше, чем выполнение эквивалентных операций через циклы. Например,

np.dot(a, b)выполняет умножение матриц гораздо быстрее, чем реализация через цикл Python. - Использование типов данных с фиксированным размером: Стандартные списки Python являются динамическими и могут содержать элементы разных типов. NumPy позволяет создавать массивы с типами данных фиксированного размера (например,

int32илиfloat64). Это позволяет уменьшить расход памяти и ускорить вычисления за счет оптимизации операций с числами фиксированного типа. - Сортировка массивов с помощью

np.argsort: Для сортировки массивов, особенно больших, можно использоватьnp.argsort, который возвращает индексы элементов в отсортированном порядке. Это быстрее и эффективнее, чем использование стандартной функцииsortedили методаsort()в Python. - Использование

np.arrayвместо списков: Стандартные списки Python поддерживают элементы разных типов и являются более универсальными, но их производительность значительно уступает массивам NumPy. Массивы NumPy, напротив, обеспечивают быстрые вычисления благодаря использованию однотипных элементов. Использованиеnp.arrayдля числовых данных всегда будет быстрее, чем стандартные списки Python. - Использование многомерных массивов: Когда речь идет о многомерных данных, например, матрицах или тензорах, NumPy предоставляет инструменты для работы с такими структурами. Многомерные массивы NumPy представляют собой последовательности данных, упорядоченные по строкам и столбцам, что позволяет выполнять быстрые математические операции и манипуляции с такими массивами.

Каждый из этих методов позволяет значительно улучшить производительность при работе с большими объемами данных, делая вычисления быстрыми и эффективными. Важно помнить, что оптимизация – это не только использование библиотек, но и правильный выбор инструментов для решения конкретных задач. С помощью NumPy можно добиться значительного ускорения вычислений, если правильно использовать векторизацию, типизацию и встроенные функции.

Использование компиляции с Cython для повышения производительности

Cython позволяет преобразовывать код Python в скомпилированный C-код, что значительно ускоряет выполнение программ, особенно в случае вычислительно интенсивных задач. Это достигается благодаря прямому взаимодействию с C-библиотеками и компиляции в машинный код, что позволяет избежать накладных расходов интерпретатора Python.

Одной из главных особенностей Cython является возможность добавления типов данных на уровне C. Это позволяет существенно сократить время выполнения программ, так как Python не нужно динамически определять типы во время выполнения. Например, для числовых операций можно указать типы int или double, что значительно увеличивает скорость вычислений по сравнению с использованием стандартных типов Python.

Для того чтобы начать использовать Cython, достаточно установить его с помощью pip: pip install cython. После установки можно писать Cython-код в файле с расширением .pyx. В отличие от обычного Python-кода, Cython позволяет вставлять C-определения прямо в код, что особенно полезно при работе с внешними C-библиотеками или при необходимости выполнения низкоуровневых операций.

Для компиляции Cython-кода необходимо создать файл setup.py, который укажет компилятору, как собирать расширение. Например:

from Cython.Build import cythonize

from setuptools import setup

setup(

ext_modules=cythonize("my_module.pyx")

)

Затем выполняется командой python setup.py build_ext --inplace, что скомпилирует расширение и позволит использовать его в проекте. В результате выполнения такого кода будет создан скомпилированный файл, который можно импортировать, как обычный Python-модуль.

Еще одной полезной функцией является возможность интеграции с существующими библиотеками, написанными на C или C++. Для этого Cython позволяет создавать биндинги, которые облегчают взаимодействие Python с внешними библиотеками, позволяя использовать их функции и структуры данных без необходимости писать обертки вручную.

С помощью Cython можно также ускорить выполнение многозадачных приложений. Однако стоит помнить, что для многозадачности в Cython требуется использовать дополнительные инструменты, такие как OpenMP или многопоточные библиотеки, чтобы эффективно распределить нагрузку между ядрами процессора.

Использование Cython требует внимательности при разработке, поскольку некорректное указание типов или неправильная работа с памятью могут привести к ошибкам, трудным для отладки. Однако с учетом значительного прироста производительности, особенно при масштабируемых вычислениях, Cython является мощным инструментом для оптимизации кода Python.

Ускорение работы с большими данными с помощью библиотеки Dask

Библиотека Dask предоставляет мощные инструменты для работы с большими данными в Python. Она позволяет эффективно обрабатывать данные, которые не помещаются в память, и выполнять параллельные вычисления. Dask расширяет возможности стандартных библиотек Python, таких как pandas, numpy и scikit-learn, сохраняя знакомый интерфейс и минимизируя усилия на миграцию к более сложным решениям.

Одной из основных особенностей Dask является её способность распределять вычисления на несколько ядер или даже на несколько машин, что значительно ускоряет обработку данных. В отличие от традиционных библиотек, которые работают с данными в памяти, Dask делит данные на более мелкие блоки и обрабатывает их поочередно, что позволяет работать с большими объемами данных, не требуя значительных ресурсов памяти.

Основные подходы к ускорению работы с Dask:

- Разбиение данных на части. Dask использует структуру данных, подобную pandas DataFrame, но вместо того, чтобы загружать все данные в память, они разбиваются на более мелкие блоки, которые обрабатываются параллельно. Это позволяет работать с данными, которые не помещаются в оперативную память.

- Параллельное выполнение задач. Dask использует планировщик, который распределяет задачи по доступным ядрам процессора, обеспечивая максимальную загрузку всех вычислительных ресурсов. Это позволяет значительно ускорить выполнение сложных операций, таких как группировка или объединение данных.

- Интеграция с распределенными вычислениями. Для задач, требующих ещё большей мощности, Dask позволяет распределять вычисления не только на несколько ядер, но и на несколько машин, создавая распределённую вычислительную среду. Это особенно полезно для работы с очень большими наборами данных, которые не помещаются в память одной машины.

- Оптимизация вычислений. Dask позволяет выполнять операции «лениво», то есть вычисления запускаются только при необходимости, а не сразу. Это позволяет избежать лишних вычислений и значительно ускоряет обработку данных, особенно когда операции могут быть скомбинированы или пропущены.

Пример простого использования Dask для работы с большими данными:

import dask.dataframe as dd

# Загружаем данные в Dask DataFrame

df = dd.read_csv('large_dataset.csv')

# Выполняем операции, как в pandas, но с разбиением на блоки

result = df.groupby('column_name').mean().compute()

Этот код позволяет работать с большими CSV файлами, которые не помещаются в память, благодаря ленивым вычислениям и разбиению на блоки. Операция `compute()` инициирует выполнение только тогда, когда результат действительно необходим.

Кроме того, Dask поддерживает интеграцию с другими библиотеками, такими как scikit-learn, для параллельной тренировки моделей машинного обучения на больших наборах данных, а также с cuDF для ускорения вычислений на GPU. Это открывает возможности для использования Dask в самых различных областях, от обработки данных до высокопроизводительных вычислений.

Таким образом, библиотека Dask предоставляет эффективные решения для работы с большими данными, обеспечивая параллельные вычисления, распределение нагрузки и ленивые вычисления. Это делает её отличным инструментом для анализа и обработки данных в условиях ограниченных ресурсов и больших объёмов информации.

Использование встроенных функций и библиотек для ускорения операций

Для значительного ускорения вычислений в Python важно правильно использовать встроенные функции и специализированные библиотеки. Это позволяет избежать необходимости реализации базовых алгоритмов с нуля, а также получить доступ к оптимизированным и высокоэффективным методам обработки данных.

Функции Python обладают высокой производительностью благодаря своей реализации на C. Например, использование встроенной функции sum() для суммирования элементов списка значительно быстрее, чем реализация аналогичного алгоритма через цикл. Аналогично, для проверки наличия элемента в коллекции предпочтительнее использовать in вместо ручного перебора через цикл.

Математические операции ускоряются с помощью библиотеки NumPy. В отличие от стандартных списков Python, массивы NumPy представляют собой оптимизированные структуры данных, которые эффективно работают с большими объемами числовых данных. Применение векторизации позволяет значительно сократить время выполнения арифметических операций.

Использование NumPy для операций, таких как матричное умножение или транспонирование, может ускорить вычисления в несколько раз по сравнению с реализацией на стандартных списках Python. Например, операция матричного умножения с использованием метода np.dot() выполняется намного быстрее, чем при использовании вложенных циклов.

Библиотека itertools предоставляет инструменты для эффективной работы с итераторами. Применение таких функций, как itertools.combinations() или itertools.permutations(), позволяет избежать лишних вычислений при переборе комбинаций или перестановок, особенно при работе с большими наборами данных.

Библиотека Cython позволяет скомпилировать код Python в C-код, что дает значительный прирост производительности, особенно в числовых вычислениях. Оптимизация циклов и массивов с помощью Cython может уменьшить время выполнения программы на несколько порядков.

В случае работы с большими объемами данных и необходимостью их обработки на диске, библиотека dask предоставляет высокоуровневые инструменты для распределенной обработки данных. Она эффективно работает с большими наборами данных, позволяя выполнять вычисления на множестве серверов или даже в клауде, при этом код остается практически неизменным, как при использовании Pandas.

Оптимизация вычислений в Python невозможна без использования правильных инструментов, которые предоставляют встроенные функции и библиотеки. Для достижения высокой производительности важно выбирать правильные методы и подходы в зависимости от характера задачи и структуры данных.

Профилирование кода и нахождение узких мест с помощью cProfile

Для повышения производительности Python-скриптов важно не только правильно реализовать алгоритмы, но и тщательно анализировать, где именно происходят задержки. Один из наиболее эффективных инструментов для этого – встроенный модуль cProfile.

cProfile позволяет отслеживать время работы функций, их частоту вызовов и определять, какие участки кода требуют оптимизации. Это достигается благодаря сбору статистики о каждом вызове функций, что позволяет точно локализовать «узкие места» в программе.

Для базового профилирования достаточно запустить скрипт с использованием cProfile.run(), указав функцию или весь скрипт. Например:

import cProfile

def some_function():

# Ваш код

pass

cProfile.run('some_function()')

- ncalls – количество вызовов функции;

- tottime – общее время, затраченное на выполнение функции без учета времени её дочерних вызовов;

- percall – время на один вызов функции;

- cumtime – общее время, затраченное на выполнение функции, включая время всех её дочерних вызовов;

- filename:lineno(function) – путь и номер строки, где была вызвана функция.

import cProfile

import pstats

profiler = cProfile.Profile()

profiler.enable()

# Ваш код

profiler.disable()

stats = pstats.Stats(profiler)

stats.sort_stats('cumulative').print_stats(10)

Это покажет 10 функций с наибольшим суммарным временем выполнения, включая время их дочерних вызовов.

Важно: при профилировании стоит учитывать, что из-за накладных расходов на сбор статистики время выполнения может быть несколько увеличено. Для точной оценки производительности следует проводить тестирование на реальных данных или в условиях, максимально приближенных к рабочим.

Применяя cProfile, можно значительно упростить поиск и устранение проблем с производительностью, что важно при оптимизации сложных и ресурсоемких алгоритмов.

Вопрос-ответ:

Как можно ускорить выполнение программы на Python, если основная нагрузка приходится на циклы?

Один из способов ускорить работу циклов — это использование библиотеки NumPy для выполнения математических операций. NumPy оптимизирован для работы с большими массивами данных и может значительно сократить время выполнения по сравнению с обычными Python-циклами. Кроме того, можно попробовать использовать генераторы и списковые выражения, которые часто быстрее обычных циклов `for`. Для работы с большими объемами данных также полезно распараллеливание вычислений с помощью библиотеки `concurrent.futures` или использования многозадачности через `asyncio`.

Как уменьшить время работы программы на Python при больших объемах данных в функции?

Для улучшения производительности при работе с большими объемами данных стоит рассмотреть использование таких методов, как кэширование результатов, использование эффективных алгоритмов для обработки данных (например, алгоритмы с меньшей сложностью) и применение специализированных библиотек. Например, `pandas` часто быстрее работает с табличными данными, чем стандартные структуры Python. Также важно избегать избыточных операций внутри функций, таких как многократное вычисление одинаковых значений. В таких случаях можно использовать мемоизацию с помощью библиотеки `functools.lru_cache` для хранения ранее вычисленных результатов.

Как можно ускорить выполнение многократных операций с большими строками в Python?

Для работы с большими строками в Python можно использовать метод `join()` для объединения строк, так как это значительно быстрее, чем многократное использование оператора сложения `+`. Также полезно использовать буферизацию, если предстоит много операций с большими строками. В случае, если строки часто модифицируются, можно использовать объект `StringIO` из библиотеки `io`, который работает быстрее, чем обычная конкатенация строк. Также стоит использовать библиотеки C-расширений, такие как `Cython` или `PyPy`, для ускорения строковых операций.

Как ускорить выполнение кода, если он зависит от работы с большими файлами?

Если ваша программа работает с большими файлами, можно улучшить производительность за счет использования потоковой передачи данных. Вместо того чтобы загружать целиком большие файлы в память, можно читать и обрабатывать их по частям, используя генераторы или библиотеку `itertools`. Также полезно использовать буферизацию при чтении и записи файлов, что позволяет существенно ускорить операции ввода-вывода. В случае работы с бинарными файлами лучше использовать методы, оптимизированные для быстрого чтения и записи, например, `mmap` или другие низкоуровневые подходы.

Что такое профилирование кода в Python и как оно помогает ускорить программу?

Профилирование кода позволяет определить, какие части программы занимают наибольшее количество времени при выполнении. Для этого можно использовать стандартные инструменты, такие как модуль `cProfile` или внешние библиотеки, например, `line_profiler`. Эти инструменты показывают, сколько времени затрачивается на каждую функцию и строку кода. Полученные данные позволяют сфокусироваться на наиболее «тяжелых» участках программы и оптимизировать их, например, заменить неэффективные алгоритмы или уменьшить количество операций в циклах.