Правильное определение кодировки строки – важная задача при работе с текстовыми данными в Python. Особенно это актуально при обработке файлов, данных из интернета или при взаимодействии с различными API, где кодировка может варьироваться. Понимание того, какая кодировка используется, позволяет избежать ошибок при чтении и записи данных, а также обеспечить корректное отображение символов.

Для выявления кодировки строки в Python чаще всего используют библиотеку chardet, которая автоматически определяет наиболее вероятную кодировку на основе анализа байтов данных. Этот метод является довольно точным, но, тем не менее, не всегда может гарантировать абсолютную точность, особенно когда строка короткая или текст имеет неоднозначные символы.

Кроме того, для определения кодировки можно использовать стандартную библиотеку Python – codecs. Однако этот подход требует больше ручной настройки, так как необходимо предварительно попытаться декодировать строку в предполагаемой кодировке и обработать возможные исключения. В отличие от chardet, это позволяет более точно управлять процессом, но требует больше времени на настройку.

Если вы работаете с текстовыми данными, поступающими в разных кодировках, важно заранее определить их тип для корректной обработки. Например, кодировка UTF-8 считается универсальной, но также встречаются и другие популярные кодировки, такие как Windows-1251, ISO-8859-1 и другие, которые нужно учитывать при разработке программ.

Использование библиотеки chardet для автоматического определения кодировки

Для начала работы с chardet достаточно установить библиотеку через pip:

pip install chardet

После установки можно использовать библиотеку для определения кодировки. Для этого применяется функция chardet.detect(), которая принимает байтовое представление строки и возвращает словарь с результатами. В нем указаны:

- encoding – предполагаемая кодировка;

- confidence – уверенность в правильности результата (от 0 до 1);

- language – возможный язык текста (не всегда присутствует).

Пример использования:

import chardet data = b'\xd0\x9f\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82' result = chardet.detect(data) print(result)

В этом примере мы определяем кодировку байтовой строки, содержащей текст на русском языке. Результат может быть таким:

{'encoding': 'windows-1251', 'confidence': 0.99, 'language': 'Russian'}

При работе с файлами chardet также удобно применять для их открытия с правильной кодировкой. Например:

with open('file.txt', 'rb') as f:

raw_data = f.read()

result = chardet.detect(raw_data)

encoding = result['encoding']

with open('file.txt', 'r', encoding=encoding) as f:

content = f.read()

print(content)

Это позволяет избежать ошибок при чтении файлов с неизвестной кодировкой. Однако стоит помнить, что chardet не всегда гарантирует 100% точность. Для коротких строк уверенность может быть низкой, и в таких случаях результат следует проверять вручную или использовать дополнительные методы.

Преимущества и ограничения метода с помощью codec.detect()

Однако, несмотря на свою полезность, метод имеет ряд ограничений. Прежде всего, он может ошибаться в случае, если строка имеет малый объём или если текст слишком однообразен, например, состоит только из символов одного алфавита. В таких случаях вероятность ошибки возрастает, так как алгоритм не может точно предсказать кодировку при нехватке данных для анализа.

Еще одним ограничением является невозможность работы с не-UTF-8 строками, закодированными в нестандартных или редких кодировках. В таких ситуациях detect() может вернуть результат с низким уровнем уверенности или ошибочно определить кодировку. Это особенно важно при работе с текстами, полученными из неизвестных или нестабильных источников.

Кроме того, результат работы detect() не всегда является абсолютным. Алгоритм предоставляет вероятность, с которой он уверен в своей догадке, но при недостаточном контексте эта уверенность может быть низкой, что требует дополнительных проверок или вмешательства пользователя.

В целом, метод codec.detect() представляет собой мощный инструмент для работы с кодировками, но для критически важных приложений, где ошибки недопустимы, рекомендуется комбинировать его с другими способами проверки или использовать для более длинных строк с четкими признаками кодировки.

Определение кодировки с использованием Python 3.x стандартных функций

В Python 3.x нет встроенной функции, которая бы напрямую определяла кодировку строки, но можно воспользоваться различными методами для её анализа и корректного выбора. Простейшие способы включают использование стандартных библиотек для работы с кодировками, таких как chardet или cchardet, но здесь мы рассмотрим подходы с использованием стандартных средств Python.

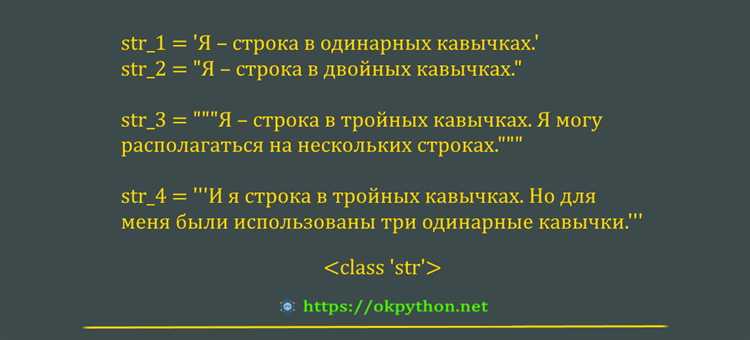

Для определения кодировки строки важно понимать, что строка в Python 3.x представлена в виде объекта str, который всегда использует кодировку UTF-8, а байтовые данные представлены в виде объектов bytes.

Когда данные представлены в виде объекта bytes, необходимо определить, в какой кодировке они были закодированы. Для этого можно использовать следующий подход:

- Метод

encodeиdecode: Один из способов – это попытка декодирования байтовых данных в строку с использованием предполагаемой кодировки. - Исключение ошибок: При неправильном выборе кодировки Python выбрасывает ошибку

UnicodeDecodeError. Это можно использовать для проверки возможности декодирования.

Пример кода:

# Пример с ошибкой декодирования

def check_encoding(data):

try:

data.decode('utf-8')

return 'utf-8'

except UnicodeDecodeError:

return 'Не удалось декодировать в utf-8'

# Пример использования

data = b'\xd0\x9f\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82'

encoding = check_encoding(data)

print(encoding) # 'utf-8'

Если строка корректно декодируется в одну из стандартных кодировок (например, UTF-8, ISO-8859-1 и т.д.), то мы можем утверждать, что данные использовали эту кодировку. В противном случае следует пытаться применить другие кодировки.

Для более точного определения кодировки можно использовать библиотеку chardet. Она предлагает более сложные алгоритмы для определения кодировки, что особенно полезно при работе с неизвестными или смешанными данными.

import chardet

def detect_encoding(data):

result = chardet.detect(data)

return result['encoding']

# Пример использования

data = b'\xd0\x9f\xd1\x80\xd0\xb8\xd0\xb2\xd0\xb5\xd1\x82'

encoding = detect_encoding(data)

print(encoding) # 'utf-8'

Хотя встроенные средства Python 3.x не позволяют автоматически определить кодировку строки, с помощью этих методов можно значительно упростить процесс работы с данными, особенно если кодировка неизвестна заранее.

Как обрабатывать ошибку при неправильной кодировке с помощью ошибок в Python

При работе с текстовыми данными в Python часто возникает ситуация, когда кодировка строки не соответствует ожидаемой. Это может привести к ошибкам при чтении, записи или преобразовании данных. В таких случаях полезно уметь правильно обрабатывать ошибки, связанные с кодировками.

Для обработки ошибок в Python используется механизм исключений. При неправильной кодировке строки Python выбрасывает исключение типа UnicodeDecodeError или UnicodeEncodeError, в зависимости от того, пытаемся ли мы декодировать или закодировать строку.

Вот несколько важных подходов для обработки таких ошибок:

- Использование параметра

errorsв функциях декодирования и кодирования: при указании параметраerrorsможно выбрать способ обработки ошибок. - Типы обработки ошибок:

strict(по умолчанию) — выбрасывает исключение при ошибке.ignore— игнорирует ошибки и пропускает символы, которые не могут быть декодированы.replace— заменяет ошибочные символы на символ�(заполнитель).backslashreplace— заменяет ошибочные символы на эквивалентное представление в виде escape-последовательности.

Пример использования параметра errors:

text = b'Hello \x80 World' # Неверная байтовая последовательность

try:

decoded_text = text.decode('utf-8', errors='replace')

print(decoded_text) # Выведет: Hello � World

except UnicodeDecodeError as e:

print(f"Ошибка декодирования: {e}")

Еще один способ – это использование конструкции try-except для перехвата и обработки ошибок. Это позволяет более гибко управлять ситуацией и принимать необходимые меры при возникновении проблемы.

try:

text = b'Hello \x80 World'

decoded_text = text.decode('utf-8')

except UnicodeDecodeError as e:

print(f"Ошибка декодирования: {e}")

decoded_text = text.decode('latin1') # Попытка использовать другую кодировку

print(f"Решение: {decoded_text}")

Важно понимать, что выбор стратегии обработки ошибок зависит от ситуации. Если вам нужно продолжить обработку данных, даже если часть символов не может быть правильно интерпретирована, стоит использовать ignore или replace. Если же ошибка критична для целостности данных, лучше отловить исключение и предложить пользователю альтернативные способы обработки.

Также можно использовать библиотеки для автоматического определения кодировки, такие как chardet или cchardet, чтобы минимизировать ошибки при работе с различными кодировками.

Ручная проверка кодировки строки с помощью байтовых последовательностей

Для точной проверки кодировки строки без использования стандартных библиотек в Python можно воспользоваться байтовыми последовательностями. Каждая кодировка имеет свои уникальные байтовые представления символов, что позволяет различать одну кодировку от другой.

Для начала строку нужно преобразовать в байты с использованием различных кодировок. Например, для кодировки UTF-8 и CP1251 строка «Привет» будет иметь разные байтовые последовательности.

Пример преобразования строки в байты:

s = "Привет"

utf8_bytes = s.encode('utf-8')

cp1251_bytes = s.encode('cp1251')

Чтобы вручную определить кодировку, необходимо проанализировать полученные байты. Для этого можно воспользоваться следующими методами:

1. Проверка на допустимые байтовые значения. Каждая кодировка имеет свои допустимые диапазоны значений для байтов. Например, в UTF-8 байты могут быть многобайтовыми, а в CP1251 большинство символов укладываются в один байт, кроме нескольких специфических символов, требующих двух байтов.

2. Попытка декодирования. Попробуйте декодировать байтовую строку с разными кодировками и проверьте, не возникнут ли ошибки. Например:

try:

decoded_utf8 = utf8_bytes.decode('utf-8')

except UnicodeDecodeError:

print("Ошибка при декодировании в UTF-8")

try:

decoded_cp1251 = cp1251_bytes.decode('cp1251')

except UnicodeDecodeError:

print("Ошибка при декодировании в CP1251")

3. Проверка на BOM (Byte Order Mark). Некоторые кодировки, например UTF-16 и UTF-32, используют специальную метку (BOM), которая указывает порядок байтов. Эта метка позволяет точно определить кодировку на ранней стадии.

4. Использование статистики. Для определённых текстов можно определить кодировку, основываясь на частоте появления определённых байтов. Например, в UTF-8 часто встречаются байты с диапазоном от 0xC0 до 0xFD, что является характерным для многобайтовых символов.

Ручная проверка требует внимательности, так как одинаковая строка в разных кодировках может выглядеть абсолютно по-разному, особенно при наличии нестандартных символов. Этот метод не всегда гарантирует успех при работе с большими текстами или неизвестными кодировками, однако он позволяет более точно понять, как и почему строка может быть повреждена или неправильно интерпретирована.

Как работать с текстовыми файлами и их кодировкой в Python

При работе с текстовыми файлами в Python важно учитывать кодировку, поскольку это влияет на правильное чтение и запись данных. Встроенные функции Python, такие как open(), позволяют гибко управлять кодировками при обработке файлов.

При открытии файла важно указать его кодировку. Это делается через параметр encoding. Если кодировка не указана, Python использует стандартную кодировку системы. Однако, для кросс-платформенной совместимости и корректной обработки разных символов, рекомендуется явно указывать кодировку, например, utf-8 или cp1251, в зависимости от региона или специфики файла.

Пример открытия текстового файла с указанием кодировки:

with open('example.txt', 'r', encoding='utf-8') as file:

content = file.read()Если кодировка файла неизвестна, можно использовать библиотеку chardet для попытки автоматического определения кодировки. Она анализирует байты в файле и выдает наиболее вероятную кодировку. Однако такой метод не всегда точен, особенно для коротких или неструктурированных данных.

Пример использования chardet:

import chardet

with open('example.txt', 'rb') as file:

raw_data = file.read()

result = chardet.detect(raw_data)

print(result['encoding'])При записи данных в файл также важно указывать кодировку, чтобы избежать проблем с отображением символов при открытии файла в других программах. Если не указать кодировку при записи, Python может использовать дефолтную кодировку, которая зависит от операционной системы, что может привести к несовместимости на других платформах.

Пример записи в файл с указанной кодировкой:

with open('output.txt', 'w', encoding='utf-8') as file:

file.write('Текст на русском языке')Важное замечание: при работе с бинарными файлами (например, изображениями или видео) следует использовать режимы 'rb' или 'wb', чтобы избежать ошибок при попытке интерпретировать байтовые данные как текст.

В случае ошибок кодировки, таких как UnicodeDecodeError или UnicodeEncodeError, необходимо проверить соответствие кодировки данных и файла. В некоторых случаях можно воспользоваться параметром errors='ignore' или errors='replace' для игнорирования или замены некорректных символов, однако это может привести к потере информации.

Работа с текстовыми файлами в Python требует внимательности при выборе кодировки, особенно при обмене данными между различными системами или при обработке данных, содержащих символы, не входящие в стандартную кодировку системы.

Преобразование кодировки строки в Python с использованием библиотеки iconv

Для работы с iconv в Python можно использовать обёртки к системной утилите iconv, например, через модуль subprocess. Это особенно полезно при необходимости точного соответствия поведения системному iconv, включая поддержку специфичных кодировок.

Пример преобразования строки из CP1251 в UTF-8:

import subprocess

def convert_encoding(text: str, from_enc: str, to_enc: str) -> str:

process = subprocess.Popen(

['iconv', '-f', from_enc, '-t', to_enc],

stdin=subprocess.PIPE,

stdout=subprocess.PIPE,

stderr=subprocess.PIPE

)

stdout, stderr = process.communicate(input=text.encode(from_enc))

if process.returncode != 0:

raise RuntimeError(stderr.decode('utf-8'))

return stdout.decode(to_enc)

original = 'Пример строки'

converted = convert_encoding(original, 'CP1251', 'UTF-8')

print(converted)

Убедитесь, что iconv установлен в системе. В Linux он обычно доступен по умолчанию. В Windows потребуется установка через Cygwin, WSL или сторонние сборки.

При использовании iconv важно строго указывать реальные кодировки, соответствующие исходным данным. Неверная кодировка на входе приведёт к искажению текста или ошибке преобразования. Проверяйте кодировку источника заранее, например, с помощью chardet или cchardet.

Преобразование через iconv может быть полезно при массовой перекодировке файлов, особенно если встроенные средства Python (например, str.encode и bytes.decode) не поддерживают нужную кодировку или ведут себя иначе на разных платформах.