При разработке на Python важным аспектом является производительность, которая напрямую зависит от скорости выполнения операций. Python – это язык с интерпретируемым кодом, что уже накладывает определенные ограничения по сравнению с языками, компилируемыми в машинный код, такими как C или C++. Однако, несмотря на это, благодаря активному развитию и оптимизациям, Python обладает достаточно высокой производительностью для широкого спектра задач.

Для оптимизации скорости выполнения можно использовать несколько подходов. Один из них – выбор более быстрых библиотек и инструментов. Например, операции с большими массивами чисел можно значительно ускорить, используя NumPy, который реализует операции на основе C. Для многозадачности и параллельных вычислений рекомендуется применять модуль multiprocessing, так как стандартный threading в Python не дает существенного прироста производительности из-за GIL (Global Interpreter Lock).

Также стоит помнить, что Python предоставляет инструменты для профилирования кода. Использование cProfile позволяет выявить узкие места и определить, какие операции занимают больше всего времени. Это позволит более эффективно оптимизировать код, не тратя время на изменения, которые не влияют на производительность. Важно помнить, что оптимизация на ранних стадиях разработки может привести к излишней сложности, поэтому необходимо подходить к ней с учетом реальной необходимости в ускорении.

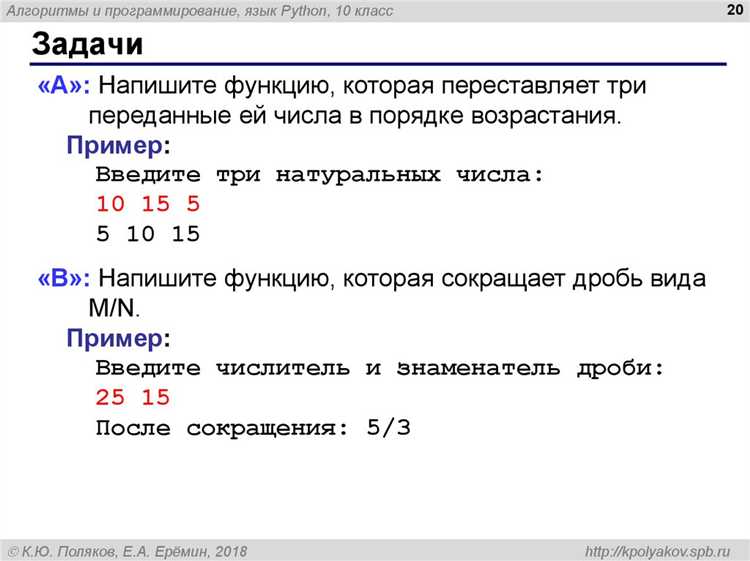

Как измерить время выполнения кода в Python?

Для измерения времени выполнения кода в Python существует несколько подходов, каждый из которых имеет свои особенности и области применения.

Самый простой способ – это использование встроенного модуля time. Функция time.time() возвращает текущее время в секундах с начала эпохи (обычно это 1970 год). Для измерения времени работы блока кода достаточно зафиксировать время до и после его выполнения, а затем вычислить разницу.

import time

start_time = time.time()

# Ваш код

end_time = time.time()

print(f"Время выполнения: {end_time - start_time} секунд")

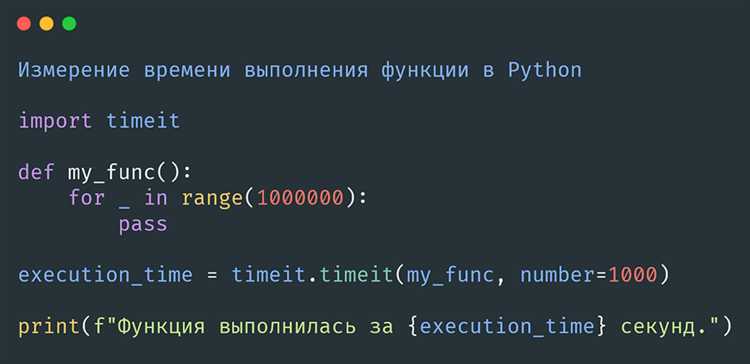

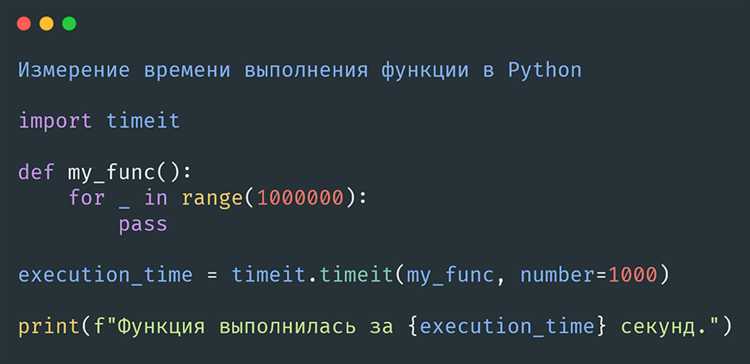

Однако такой метод может быть неточным из-за влияния других процессов в операционной системе. Чтобы уменьшить погрешности, можно воспользоваться модулем timeit, который предоставляет более точные измерения и автоматическое повторение тестов для получения статистически значимых данных.

Модуль timeit позволяет измерить время выполнения фрагмента кода, повторив его несколько раз и вычислив среднее время. Это позволяет избежать случайных отклонений, связанных с фоновыми процессами.

import timeit

# Измерение времени выполнения однократного выполнения функции

execution_time = timeit.timeit('your_function()', setup='from your_module import your_function', number=1000)

print(f"Среднее время выполнения: {execution_time / 1000} секунд на одну операцию")

Для большинства случаев timeit предпочтительнее, так как он учитывает множественные факторы, влияющие на точность измерений, такие как фоновая нагрузка. Важно помнить, что при использовании timeit вы можете указать параметр number, который задает количество повторений кода для статистической точности.

Если необходимо провести измерения на уровне более низких операций или выполнить код в контексте более сложных нагрузок, можно использовать профайлеры, такие как cProfile, которые дают полную картину того, какие участки кода занимают больше всего времени.

import cProfile

def my_function():

# Ваш код

pass

cProfile.run('my_function()')

Этот инструмент предоставляет подробную информацию о количестве вызовов функций, времени, затраченном на каждый вызов, и других метрик, которые могут быть полезны для анализа производительности.

Таким образом, для точных измерений времени выполнения кода в Python следует использовать timeit для простых случаев и cProfile для более сложных приложений. Важно выбирать инструмент в зависимости от нужд и сложности задачи.

Влияние типов данных на производительность Python

Типы данных в Python напрямую влияют на производительность программ. Каждый тип данных имеет свои особенности в плане скорости операций, использования памяти и возможности оптимизации. Основные типы данных, такие как списки, кортежи, множества и строки, различаются по этим характеристикам, что важно учитывать при проектировании эффективного кода.

Списки в Python – это изменяемые коллекции, которые часто используются для хранения последовательностей. Однако, они имеют высокую стоимость при добавлении или удалении элементов в середине или в начале. Операции доступа к элементам списка быстры, но из-за необходимости динамического перераспределения памяти они медленнее, чем у массивов в языках с фиксированным типом данных, например, в C. При работе с большими объемами данных стоит использовать массивы, предоставляемые библиотеками типа array или numpy, которые предлагают меньшую нагрузку на память и более высокую скорость.

Кортежи, в отличие от списков, являются неизменяемыми объектами. Это делает их не только более быстрыми для операций чтения, но и менее затратными по памяти. Их использование оправдано, если требуется неизменяемая коллекция, поскольку Python может оптимизировать кортежи, их создание и доступ к элементам значительно быстрее, чем у списков. В случае использования неизменяемых коллекций, кортежи предпочтительнее, если важно снижение времени выполнения.

Множества и словари основаны на хэш-таблицах, что делает операции поиска, добавления и удаления элементов очень быстрыми, с амортизированным временем O(1). Это делает их идеальными для ситуаций, где необходимо быстро искать или проверять наличие элементов. Однако при работе с большими наборами данных стоит учитывать, что множества требуют больше памяти, чем списки или кортежи, из-за необходимости хранения хэш-значений и управления коллизиями.

Строки в Python – неизменяемые объекты, что означает, что каждый раз при изменении строки создается новый объект. Это может стать проблемой при частых изменениях строк в цикле. Для операций с большими объемами строк лучше использовать класс StringIO из модуля io или работать с массивами байтов, чтобы минимизировать накладные расходы на создание новых объектов.

Типы данных, такие как int и float, имеют довольно высокую производительность для базовых операций, но стоит помнить, что работа с числами с плавающей точкой может быть медленнее из-за ограничений точности и затрат на выполнение операций с плавающей точкой в интерпретаторе Python. В случаях, когда требуется высокая производительность при работе с числами, полезно обратить внимание на библиотеки вроде numpy, которые используют более оптимизированные структуры данных и алгоритмы.

При проектировании системы важно не только выбирать подходящий тип данных, но и следить за их комбинированным использованием. Например, использование множества для поиска уникальных значений в большом списке будет быстрее, чем использование списка с операциями поиска в нем. Комбинированные структуры, такие как deque из модуля collections, могут предложить лучшую производительность для операций вставки и удаления элементов с обеих сторон коллекции.

Влияние типов данных на производительность можно минимизировать, используя правильные структуры данных в зависимости от задач. Для ускорения работы программы стоит анализировать, какие типы данных лучше подходят для конкретной задачи, и использовать более специализированные библиотеки, такие как numpy, для работы с числовыми массивами или pandas для анализа больших наборов данных.

Что влияет на скорость работы циклов в Python?

Скорость выполнения циклов в Python зависит от множества факторов, включая выбор типа цикла, структуру данных и особенности самого интерпретатора. Прежде всего, важно учитывать, что Python использует интерпретируемую модель исполнения, что ограничивает производительность по сравнению с компилируемыми языками.

Одним из ключевых факторов является тип цикла. Например, цикл for в Python может быть медленнее, чем аналогичный цикл в языках с компиляцией, из-за того, что Python обрабатывает итерации через механизмы работы с объектами и динамическую типизацию. В то время как цикл while может быть быстрее, поскольку его структура проще, однако это не всегда так, если цикл выполняет сложные вычисления или включает дорогостоящие операции внутри.

На производительность влияет также выбор структуры данных. Использование списков (list) в качестве контейнеров для хранения элементов может быть медленным при частых изменениях их размеров, так как каждый раз происходит перераспределение памяти. В то же время кортежи (tuple), будучи неизменяемыми, обеспечивают большую скорость в операциях перебора элементов.

Если в цикле приходится часто обращаться к элементам с помощью индексации, использование структуры данных типа dict или set может быть эффективнее, так как эти структуры обеспечивают доступ за время O(1) на основе хеширования. Списки же обеспечивают время доступа O(n) в худшем случае при использовании индексации с отрицательными индексами или методом list.index().

Еще одним важным аспектом является использование встроенных функций и методов Python, таких как map(), filter() и генераторы. Они могут значительно повысить скорость работы циклов, так как они оптимизированы на уровне интерпретатора и избегают дополнительных накладных расходов, связанных с традиционными циклами. Особенно это актуально при обработке больших объемов данных.

При работе с большими объемами данных полезно использовать пакет NumPy, который позволяет осуществлять операции над массивами гораздо быстрее благодаря векторизации. Вместо написания циклов, выполняющих операции поэлементно, NumPy позволяет работать с целыми массивами за одну операцию, что существенно снижает время выполнения.

Наконец, важное влияние на скорость циклов оказывает использование оптимизаций интерпретатора Python. Например, в Python 3.x улучшены механизмы работы с байт-кодом, а также оптимизированы операции с объектами. Использование JIT-компилятора, такого как PyPy, также может значительно ускорить выполнение циклов, особенно если код выполняется в условиях интенсивных вычислений.

Таким образом, для повышения производительности циклов в Python необходимо учитывать выбор правильного типа цикла, оптимизацию работы с данными и использование более высокоуровневых абстракций, таких как встроенные функции или специализированные библиотеки.

Как оптимизировать работу с большими списками в Python?

Работа с большими списками в Python требует внимательного подхода, чтобы избежать значительных потерь по производительности. Рассмотрим несколько ключевых методов оптимизации, которые позволят значительно улучшить время выполнения операций.

- Использование генераторов вместо списков: Генераторы занимают меньше памяти и работают быстрее, поскольку элементы вычисляются по мере необходимости. Например, вместо создания списка можно использовать генератор, который возвращает элементы по запросу.

generator = (x * 2 for x in range(10**6))lst = [0] * 106deque, может ускорить выполнение.numpy для числовых данных: Если список содержит только числа, использование библиотеки numpy вместо стандартных списков Python значительно повысит производительность за счет оптимизированных операций с массивами.import numpy as np

arr = np.array(range(106))map() и filter(): Для выполнения операций над списками быстрее и с меньшими затратами памяти, лучше использовать функции map() и filter() вместо явных циклов. Они реализуют операции в виде итераторов, что снижает нагрузку на память.sorted(), которая использует эффективный алгоритм Timsort.sorted_lst = sorted(large_list)itertools: Модуль itertools предоставляет эффективные способы работы с большими объемами данных, используя итераторы. Например, для работы с комбинациями или перестановками можно использовать itertools.combinations, что значительно сокращает время работы по сравнению с ручными алгоритмами.concurrent.futures или multiprocessing может ускорить выполнение операций.from concurrent.futures import ThreadPoolExecutor

with ThreadPoolExecutor() as executor:

results = list(executor.map(process, large_list))Применяя эти методы, можно значительно ускорить работу с большими списками и улучшить производительность Python-кода. Важно учитывать, что оптимизация всегда должна быть осознанной и ориентированной на конкретные задачи и объем данных.

Особенности работы с многозадачностью и параллельными вычислениями в Python

Многозадачность и параллельные вычисления в Python представляют собой важные инструменты для повышения производительности приложений, однако их реализация имеет свои особенности, обусловленные особенностями работы интерпретатора Python и моделей выполнения кода.

Многозадачность в Python традиционно реализуется с помощью потоков и процессов. Стандартная библиотека Python предоставляет два основных модуля для работы с многозадачностью: threading и multiprocessing.

Модуль threading позволяет создавать потоки для выполнения параллельных задач в одном процессе. Однако Python использует механизм, известный как Global Interpreter Lock (GIL), который ограничивает выполнение нескольких потоков одновременно в рамках одного процесса. Это означает, что, несмотря на наличие нескольких потоков, только один поток может выполнять байткод Python в любой момент времени. ГИЛ существенно ограничивает эффективность многозадачности для вычислительных задач, особенно на многоядерных процессорах.

Если задача требует настоящей параллельной обработки и использует значительные вычислительные ресурсы, стоит обратить внимание на модуль multiprocessing. Он создает независимые процессы, каждый из которых работает в своей собственной памяти, что позволяет обойти ограничения GIL. Это решение идеально подходит для выполнения задач, требующих интенсивных вычислений, так как каждый процесс может работать на отдельном ядре процессора.

Параллельные вычисления в Python могут быть реализованы с помощью библиотеки concurrent.futures, которая предоставляет абстракции для работы с пулом процессов и потоков. Для процессов используется ProcessPoolExecutor, а для потоков – ThreadPoolExecutor. Эта библиотека позволяет упростить распределение задач и обработку результатов, обеспечивая более высокоуровневый интерфейс для многозадачности.

Для задач, требующих параллельного выполнения на нескольких ядрах, можно также воспользоваться библиотеками, такими как Joblib и Dask, которые предоставляют более гибкие возможности для распределенных вычислений и могут быть использованы для работы с большими объемами данных.

Важным аспектом при работе с параллельными вычислениями является управление синхронизацией между процессами или потоками. При параллельной обработке данных важно учитывать возможные гонки данных, когда несколько потоков или процессов одновременно пытаются изменить общие данные. Для решения этих проблем Python предоставляет механизмы синхронизации, такие как Lock, Semaphore, Event, которые обеспечивают корректную работу многозадачных приложений.

Для максимально эффективного использования многозадачности и параллельных вычислений важно понимать природу задачи и правильно выбирать между потоками и процессами. В случае вычислительных задач с интенсивным использованием процессора стоит отдавать предпочтение многопроцессорным решениям, а для задач, связанных с ожиданием (например, запросы к сети), – многозадачности с потоками.

Вопрос-ответ:

Какие факторы влияют на скорость выполнения операций в Python?

На скорость выполнения операций в Python влияет несколько факторов, включая особенности интерпретатора, тип данных, используемый в операции, оптимизацию кода, а также эффективность алгоритмов. Python – это язык с динамической типизацией, что может замедлять выполнение по сравнению с языками с жесткой типизацией. Кроме того, использование встроенных функций и библиотек часто бывает быстрее, чем написание аналогичных операций вручную, потому что они уже оптимизированы на низком уровне.

Почему Python считается медленным по сравнению с другими языками программирования?

Одной из причин, почему Python может быть медленнее других языков, является его интерпретируемая природа. В отличие от языков, которые компилируются в машинный код заранее, Python выполняет код построчно, что добавляет накладные расходы. Также динамическая типизация и отсутствие жесткой компиляции вносит дополнительную нагрузку. Однако стоит отметить, что Python часто используется для разработки на уровне прототипов или в тех случаях, когда производительность не является главным приоритетом.

Как можно улучшить производительность кода на Python?

Для улучшения производительности кода на Python можно использовать несколько подходов. Во-первых, важно использовать более быстрые структуры данных, например, вместо списков можно использовать множества или словари, которые обеспечивают более быстрое выполнение операций. Во-вторых, стоит избегать использования циклов, если можно воспользоваться встроенными функциями и методами, такими как `map()`, `filter()` или генераторы списков. Также полезно использовать библиотеки, такие как NumPy для численных вычислений, которые используют оптимизированные C-библиотеки для работы с массивами данных.

Как можно ускорить выполнение численных операций в Python?

Для ускорения численных операций в Python лучше всего использовать библиотеки, такие как NumPy или Pandas. Эти библиотеки содержат высокопроизводительные реализации математических операций на основе C, что значительно быстрее, чем стандартные Python-операции. Также важно правильно выбирать тип данных, например, использовать `numpy.array` вместо обычных списков Python. Для многозадачности и параллельных вычислений можно воспользоваться многозадачностью с помощью библиотеки `multiprocessing` или асинхронными операциями с использованием `asyncio`.

В чем разница между временем выполнения кода в Python и в C или Java?

Основная разница между временем выполнения кода в Python и в C или Java заключается в том, как эти языки управляют выполнением. C и Java компилируются в машинный код, что позволяет выполнять программы напрямую на процессоре с минимальными накладными расходами. В Python же код выполняется интерпретатором, что добавляет дополнительный слой обработки, что, в свою очередь, снижает скорость. Однако Python часто выигрывает в гибкости и простоте разработки, что делает его подходящим выбором для быстрого прототипирования, в то время как C и Java могут быть предпочтительнее для высокопроизводительных приложений.

Как влияет использование различных типов данных на скорость выполнения операций в Python?

В Python скорость выполнения операций зависит от выбранного типа данных. Например, операции с числами (целыми и с плавающей точкой) обычно выполняются быстрее, чем с более сложными структурами данных, такими как списки, множества или словари. Встроенные типы данных, такие как целые числа или строки, оптимизированы для быстрого выполнения базовых операций. Однако, если данные требуют сложных преобразований или многократных манипуляций, производительность может снизиться. Также важно учитывать алгоритмическую сложность операций: например, доступ к элементу списка по индексу работает за время O(1), а поиск элемента в списке – O(n). В свою очередь, множество и словарь обеспечивают доступ и поиск за время O(1), что делает их более быстрыми для этих операций по сравнению с обычными списками.

Что можно сделать, чтобы ускорить выполнение операций в Python, если программа работает слишком медленно?

Если ваша программа на Python работает медленно, есть несколько методов оптимизации. Во-первых, стоит обратить внимание на использование более быстрых алгоритмов и структур данных. Например, если вы используете списки для поиска элементов, замените их на множества или словари, которые имеют более быструю временную сложность для поиска. Во-вторых, можно использовать встроенные функции Python, так как они часто более оптимизированы, чем собственные реализации. В-третьих, для критически важных частей программы можно использовать библиотеки, написанные на C, такие как NumPy для работы с массивами или Cython для компиляции кода. Также полезно профилировать код с помощью инструментов, таких как cProfile, чтобы найти узкие места и оптимизировать их. Еще один способ ускорить работу — это параллелизация и многозадачность, если задачи могут выполняться одновременно.