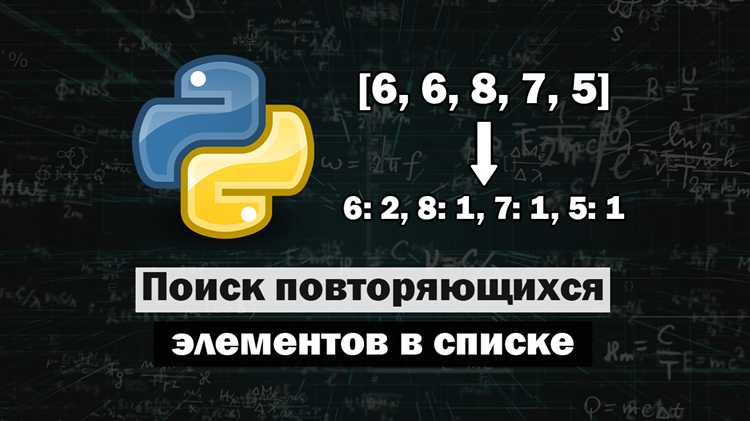

Проверка списка на повторяющиеся элементы является частой задачей при разработке на Python, особенно когда важно убедиться в уникальности данных перед их дальнейшей обработкой. В Python существует несколько способов, как это можно сделать, и каждый из них имеет свои особенности в зависимости от условий задачи.

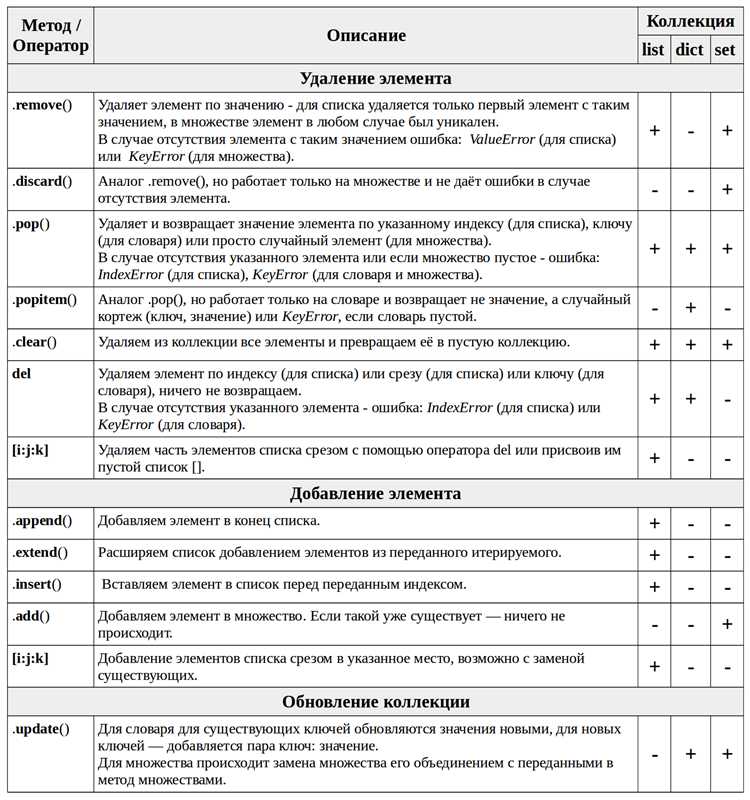

Самый простой способ – это использование структуры данных set. Поскольку set не допускает дублирование элементов, можно преобразовать список в множество и сравнить длину исходного списка с длиной множества. Если эти длины не совпадают, значит, в списке есть повторяющиеся элементы. Это решение эффективно по времени, но оно меняет порядок элементов и не сохраняет исходные данные.

Для более гибкого подхода можно воспользоваться циклом for с использованием словаря или множества для отслеживания уже встреченных значений. Это решение позволяет не только обнаружить дубли, но и дать более детальное представление о частоте повторений элементов, что может быть полезно в ряде случаев, например, при анализе данных.

Кроме того, для сложных типов данных, таких как списки внутри списка, стоит обратить внимание на алгоритмы, которые смогут правильно обрабатывать вложенные структуры и работать с ними на более глубоком уровне. В таких ситуациях может потребоваться рекурсивная проверка.

Использование оператора «in» для поиска дубликатов в списке

Для поиска дубликатов с помощью «in» можно использовать такой подход: перебираем все элементы списка и проверяем, встречался ли этот элемент ранее. Если встречался, значит, это дубликат. Однако, данный метод не является самым оптимальным с точки зрения производительности, особенно для больших списков.

Пример кода:

lst = [1, 2, 3, 4, 2, 5, 6, 3]

duplicates = []

for i in lst:

if i in duplicates:

print(f"Дубликат найден: {i}")

else:

duplicates.append(i)

Этот метод работает, но его производительность страдает, так как операция «in» для списка имеет сложность O(n), что делает проверку для каждого элемента менее эффективной. На практике для списков с большим количеством элементов стоит рассмотреть другие методы.

Таким образом, использование оператора «in» полезно в ситуациях с небольшими списками, когда важна простота кода. Для более крупных данных лучше использовать другие методы, такие как преобразование списка в множество, что значительно ускоряет поиск и удаление дубликатов.

Проверка на повторяющиеся элементы с помощью коллекции set

Использование коллекции `set` в Python – один из самых эффективных способов проверки на наличие повторяющихся элементов в списке. Коллекция `set` автоматически удаляет дубликаты, что позволяет легко определить, есть ли в исходном списке одинаковые элементы.

Для проверки на повторы достаточно преобразовать список в множество с помощью функции `set()`. Если размер множества меньше размера исходного списка, значит, в списке присутствуют повторяющиеся элементы.

Пример проверки:

lst = [1, 2, 3, 4, 5, 1]

if len(lst) != len(set(lst)):

print("Есть повторяющиеся элементы.")

else:

print("Повторяющихся элементов нет.")

Этот метод работает эффективно для списков любых размеров. Важно отметить, что преобразование в множество происходит за время O(n), где n – количество элементов в списке, что делает метод достаточно быстрым даже для больших данных.

При этом важно помнить, что множества не сохраняют порядок элементов. Если для вашей задачи важно сохранять исходный порядок, то для более точной проверки повторов можно воспользоваться дополнительными проверками или использовать другие структуры данных.

Метод count() для выявления повторений элементов списка

Метод count() в Python позволяет быстро подсчитать количество вхождений конкретного элемента в список. Это полезный инструмент для выявления повторений в списках, особенно когда нужно узнать, как часто встречается тот или иной элемент.

Синтаксис метода следующий: list.count(element), где element – это элемент, для которого нужно подсчитать количество вхождений. Метод возвращает целое число, указывающее на количество повторений элемента в списке.

Пример использования:

my_list = [1, 2, 3, 4, 1, 1, 5]

count_ones = my_list.count(1)

print(count_ones) # Выведет 3Однако стоит отметить, что метод count() работает только для поиска повторений одного элемента. Если нужно выявить все элементы, которые встречаются более одного раза, стоит использовать этот метод в сочетании с циклом или другими функциями.

Пример поиска всех повторяющихся элементов:

my_list = [1, 2, 3, 4, 1, 1, 5, 3]

duplicates = []

for element in set(my_list):

if my_list.count(element) > 1:

duplicates.append(element)

print(duplicates) # Выведет [1, 3]Метод count() не самый быстрый для больших списков, так как он выполняет поиск по всему списку каждый раз. Если требуется высокоэффективный способ проверки на повторяющиеся элементы, можно воспользоваться структурами данных, такими как множества или словари, которые оптимизированы для быстрого поиска.

Несмотря на свои ограничения, метод count() является простым и эффективным для задач с небольшими списками или когда важна простота кода.

Как использовать словарь для нахождения дубликатов

Для нахождения дубликатов в списке можно эффективно использовать словарь, так как он позволяет быстро проверять наличие уже встречавшихся элементов. В словаре ключами могут быть элементы списка, а значениями – их количество или флаг присутствия.

Пример простого подхода: создаём пустой словарь и проходим по списку, добавляя элементы в словарь как ключи. Если элемент уже существует в словаре, это означает, что он встречался ранее, и мы можем считать его дубликатом.

my_list = [1, 2, 3, 4, 1, 2]

duplicates = []

element_count = {}

for element in my_list:

if element in element_count:

duplicates.append(element)

else:

element_count[element] = 1

print(duplicates)

В этом примере создаётся словарь element_count, который хранит элементы списка как ключи, а их количество появления – как значения. Если элемент появляется второй раз, его добавляют в список дубликатов. Такой подход имеет временную сложность O(n), где n – количество элементов в списке, что делает его достаточно быстрым для больших данных.

Если вам нужно получить уникальные дубликаты (без повторений), используйте множества. Например, можно заменить список для хранения дубликатов на множество, чтобы автоматически исключать повторяющиеся значения.

duplicates = set() for element in my_list: if element in element_count: duplicates.add(element) else: element_count[element] = 1 print(duplicates)

Этот метод позволяет избавиться от дублирования самих дубликатов, сохраняя только уникальные элементы, которые встречались более одного раза.

Использование itertools для проверки уникальности элементов

Основная идея заключается в следующем: если после сортировки два или более элемента имеют одинаковое значение, они будут сгруппированы. Это позволяет легко выявить повторяющиеся элементы.

groupby()не возвращает информацию о всех повторениях сразу, но можно обрабатывать каждую группу по мере итерации.- Для проверки всех элементов на уникальность в списке нужно сначала отсортировать его, а затем использовать

groupby()для группировки. - Также можно применить

itertools.combinations()для поиска всех возможных пар элементов, что также поможет в проверке на уникальность.

Пример использования itertools.groupby() для поиска повторений:

from itertools import groupby # Исходный список data = [1, 2, 3, 2, 4, 1, 5] # Сортировка данных data_sorted = sorted(data) # Группировка и поиск повторений duplicates = [key for key, group in groupby(data_sorted) if len(list(group)) > 1]

Данный метод эффективен для списков с небольшим количеством элементов, но для больших коллекций можно столкнуться с проблемой производительности, так как groupby() требует сортировки данных, что увеличивает время работы алгоритма.

Альтернативным методом является использование комбинации itertools.combinations() для более комплексной проверки уникальности:

from itertools import combinations # Исходный список data = [1, 2, 3, 2, 4, 1, 5] # Поиск всех уникальных пар combs = combinations(data, 2) duplicates = [pair for pair in combs if data.count(pair[0]) > 1 or data.count(pair[1]) > 1]

Этот метод не требует предварительной сортировки и может использоваться для более детальной проверки, хотя также менее эффективен с точки зрения производительности для больших наборов данных.

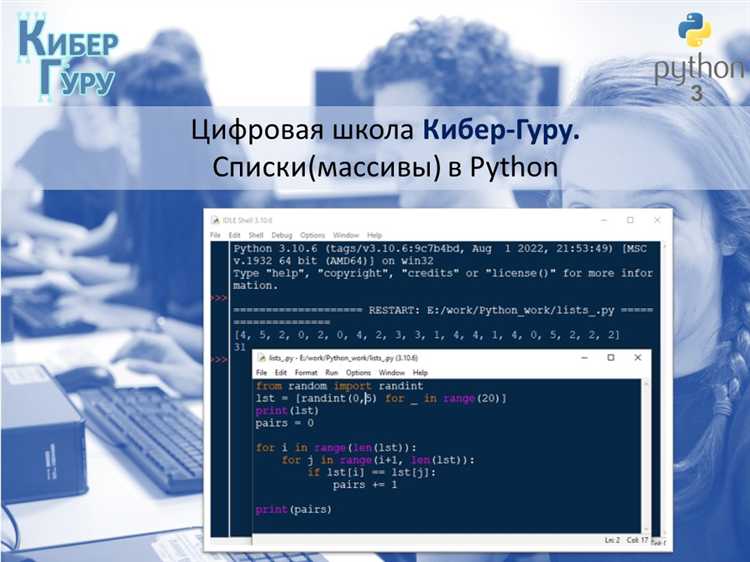

Поиск повторяющихся элементов через цикл for и условные операторы

Для поиска повторяющихся элементов в списке можно использовать цикл for и условные операторы. Этот метод подходит для небольших списков и позволяет точно контролировать процесс поиска.

Алгоритм поиска состоит из следующих шагов:

- Проходим по каждому элементу списка.

- Для каждого элемента проверяем, встречался ли он уже в предыдущих элементах.

- Если элемент встречается снова, добавляем его в список повторяющихся.

Пример кода:

список = [1, 2, 3, 2, 4, 5, 1] повторяющиеся = [] for i in range(len(список)): if список[i] in список[:i]: повторяющиеся.append(список[i]) print(повторяющиеся)

В данном примере:

- Мы используем цикл

forдля перебора элементов списка. - Для каждого элемента проверяем, есть ли он в подсписке, который состоит из всех элементов до текущего.

- Если элемент найден в подсписке, он добавляется в список

повторяющиеся.

Этот метод работает корректно, но его эффективность зависит от размера списка, так как проверка наличия элемента в подсписке выполняется за время O(n) для каждого элемента, что в сумме даёт сложность O(n^2).

Преимущества метода:

- Простота реализации.

- Понимание каждого шага алгоритма.

Недостатки:

- Низкая производительность для больших списков.

- Неэффективность при наличии большого числа повторяющихся элементов.

Этот метод удобен для небольших задач или случаев, когда важно контролировать процесс поиска вручную. Однако для более эффективных решений можно рассмотреть использование коллекций или других структур данных.

Как сделать поиск повторений в списке быстрее с помощью множеств

Для ускорения поиска повторений в списке Python можно использовать множества (set). Основная причина, по которой множества ускоряют процесс, заключается в их свойствах: операция проверки наличия элемента в множестве выполняется за время O(1), тогда как для списка эта операция требует времени O(n).

Чтобы найти повторяющиеся элементы в списке, можно пройтись по списку, добавляя элементы в множество, и сразу проверять, встречался ли элемент ранее. Этот подход значительно сокращает время работы по сравнению с методом, в котором мы проверяем каждый элемент списка на наличие в другом списке.

Пример реализации поиска повторений с использованием множества:

def find_duplicates(lst): seen = set() duplicates = set() for item in lst: if item in seen: duplicates.add(item) else: seen.add(item) return duplicates

В этом примере мы используем два множества: одно для хранения уже встреченных элементов, а другое для хранения повторяющихся элементов. Если элемент уже есть в множестве «seen», то он добавляется в «duplicates». Такой способ значительно ускоряет выполнение программы, особенно если список большой.

Важно помнить, что множества не сохраняют порядок элементов. Если порядок появления повторений имеет значение, можно использовать дополнительные структуры данных, например, списки или словари. Однако для большинства случаев этот метод идеально подходит.

Использование множеств для поиска повторений особенно эффективно в ситуациях, когда список очень длинный, и нужно минимизировать время обработки данных. Время работы такого алгоритма – O(n), где n – количество элементов в списке, что делает его гораздо быстрее, чем решение с вложенными циклами.

Преимущества использования библиотеки pandas для анализа списка

Библиотека pandas предоставляет мощные инструменты для работы с данными в Python, что делает её идеальным выбором для анализа списков. Один из ключевых факторов – возможность работы с большими объёмами данных, в том числе с проверкой на повторяющиеся элементы. Рассмотрим несколько преимуществ её использования.

1. Простота в работе с данными

С помощью pandas можно легко конвертировать списки в объекты типа Series или DataFrame, что даёт удобство при обработке и анализе данных. Эти структуры данных оптимизированы для работы с большими объёмами информации, что позволяет быстро находить дубликаты с использованием метода duplicated().

2. Эффективность в поиске дубликатов

Метод duplicated() позволяет не только найти повторяющиеся элементы, но и исключить их с минимальными затратами ресурсов. В отличие от стандартных методов Python, pandas оптимизирован для работы с массивами данных и может справляться с задачами анализа на больших объёмах информации, которые сложно обработать традиционными методами.

3. Возможности для фильтрации и группировки данных

После того как дубликаты в списке обнаружены, pandas предлагает дополнительные инструменты для их дальнейшей обработки. Например, с помощью метода groupby() можно легко сгруппировать элементы по уникальности и применить различные агрегатные функции. Это значительно расширяет возможности анализа и помогает выявить закономерности в данных.

4. Удобство работы с недостающими значениями

Pandas эффективно справляется с недостающими значениями (NaN), что важно при работе с реальными данными, где часто встречаются пропуски. Специальные методы, такие как dropna() и fillna(), позволяют обрабатывать такие значения и продолжать анализ без потери качества данных.

5. Скорость выполнения операций

При использовании pandas операции с большими списками выполняются значительно быстрее, чем при использовании стандартных методов Python. Благодаря использованию в pandas оптимизированных алгоритмов на основе библиотеки numpy, время выполнения анализа, в том числе поиска повторяющихся элементов, существенно сокращается.

Таким образом, использование библиотеки pandas для анализа списка позволяет значительно повысить эффективность работы с данными, улучшить скорость выполнения операций и минимизировать возможные ошибки при обработке больших объёмов информации.