Использование графических процессоров (GPU) для ускорения вычислений становится стандартной практикой в области научных исследований, обработки данных и машинного обучения. Применение библиотеки CUDA от NVIDIA позволяет эффективно распределять вычисления между многочисленными ядрами GPU, значительно ускоряя выполнение задач. В Python для этого существуют специализированные инструменты, такие как библиотека PyCUDA, которая дает доступ к мощным возможностям CUDA прямо из высокоуровневого языка программирования.

Для эффективного распараллеливания вычислений важно понимать, как правильно использовать ресурсы GPU. В отличие от традиционного многозадачного выполнения на CPU, где процессы делят ограниченные вычислительные мощности, GPU может одновременно выполнять тысячи потоков, что особенно полезно при обработке больших объемов данных. Для оптимизации работы на CUDA важно грамотно распределять данные и минимизировать число обращений к памяти, так как пропускная способность памяти на GPU значительно выше, чем на CPU.

Один из ключевых аспектов работы с CUDA – это правильная организация данных. В Python важно не только перенести вычисления на GPU, но и обеспечить эффективное взаимодействие между CPU и GPU, минимизируя задержки при передаче данных. С использованием PyCUDA можно управлять памятью, запускать ядра на GPU и даже интегрировать написанный код CUDA с другими Python-библиотеками для создания сложных решений с высокой производительностью.

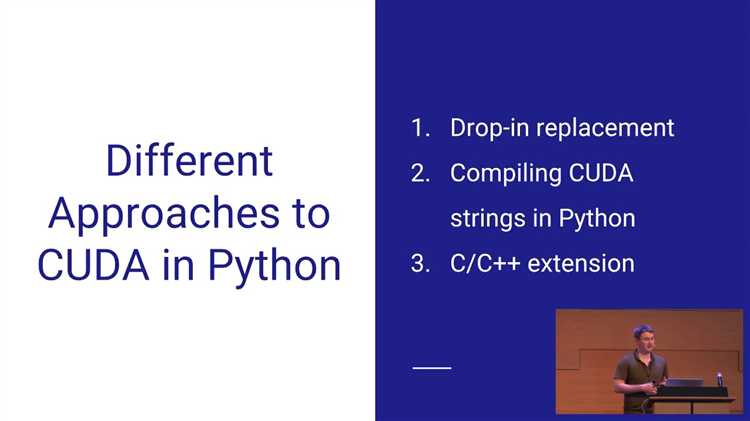

В этой статье будут рассмотрены основные подходы к распараллеливанию вычислений на CUDA с помощью Python. Мы обсудим, как оптимизировать производительность, решая практические задачи, и как минимизировать сложности, возникающие при переходе от одноядерных вычислений к многозадачным, основанным на использовании GPU.

Как установить и настроить библиотеку PyCUDA для работы с CUDA

1. Установка CUDA Toolkit. Перейдите на официальную страницу NVIDIA и скачайте последнюю стабильную версию CUDA Toolkit для вашей операционной системы. Следуйте инструкциям по установке, ориентируясь на конкретную версию драйвера и операционную систему.

2. Установка Python и pip. Убедитесь, что на вашей системе установлен Python версии 3.x. Для установки PyCUDA используется менеджер пакетов pip. Если pip ещё не установлен, вы можете установить его с помощью команды:

python -m ensurepip --upgrade

3. Установка библиотеки PyCUDA. После того как CUDA Toolkit и Python настроены, можно установить саму библиотеку PyCUDA. Для этого достаточно выполнить следующую команду в терминале:

pip install pycuda

4. Проверка установки. Чтобы убедиться в корректности установки, выполните тестирование через Python. Откройте интерактивную оболочку Python и выполните следующий код:

import pycuda.driver as cuda

cuda.init()

print(f"Количество доступных устройств CUDA: {cuda.Device.count()}")

Этот код должен вывести количество устройств CUDA, доступных для работы. Если вы видите ошибку, это может означать, что CUDA не была правильно установлена или не найдена нужная видеокарта.

5. Конфигурация окружения. В некоторых случаях может потребоваться вручную настроить переменные окружения. Для этого добавьте пути к CUDA в системные переменные. На Linux добавьте следующие строки в файл ~/.bashrc:

export PATH=/usr/local/cuda/bin:$PATH export LD_LIBRARY_PATH=/usr/local/cuda/lib64:$LD_LIBRARY_PATH

После этого выполните команду:

source ~/.bashrc

На Windows необходимо настроить переменные окружения через панель управления, добавив путь к папке CUDA в переменные PATH и LIBRARY_PATH.

6. Решение возможных проблем. Если при установке или настройке PyCUDA возникнут проблемы, убедитесь, что у вас установлена совместимая версия Python и CUDA. Также полезно обновить драйвера GPU до последней версии. Если ошибка касается несовместимости версий, попробуйте использовать другую версию PyCUDA, соответствующую версии CUDA, с помощью команды:

pip install pycuda==<номер_версии>

Соблюдение этих шагов поможет вам правильно установить и настроить PyCUDA для работы с CUDA, что позволит эффективно использовать возможности GPU для параллельных вычислений на Python.

Использование потоков и блоков для параллельных вычислений на GPU

В CUDA моделирование параллельных вычислений происходит через потоки и блоки. Это важный элемент, который позволяет эффективно распределить задачи между тысячами вычислительных единиц GPU. Понимание организации потоков и блоков критически важно для достижения максимальной производительности.

Каждое вычисление в CUDA запускается в виде потока, который является базовой единицей выполнения на GPU. Потоки объединяются в блоки, а блоки, в свою очередь, составляют сетку. Операции параллелизма происходят за счет того, что потоки в блоках выполняются независимо друг от друга, что дает возможность обрабатывать большие объемы данных одновременно.

Основные аспекты организации потоков и блоков:

- Размер блока: Блоки могут содержать до 1024 потоков. Однако, оптимальный размер блока зависит от архитектуры устройства и конкретной задачи. Обычно рекомендуется начинать с размера 256 или 512 потоков, так как это обеспечивает хорошее использование вычислительных ресурсов и кэш-памяти.

- Количество блоков: Сетку из блоков можно сконфигурировать в одном или нескольких измерениях, в зависимости от задачи. Например, для обработки изображений удобна 2D-сетка, а для линейных операций – 1D.

- Использование потоков в блоках: Потоки в одном блоке могут обмениваться данными через общую память, что ускоряет доступ к данным, но важно учитывать, что доступ к общей памяти может привести к конфликтам, если потоки не синхронизированы должным образом.

- Предельные значения: Количество блоков, которое можно запустить одновременно, ограничено количеством мультипроцессоров (SM) на GPU. Например, в некоторых моделях GPU можно запустить до 16 тысяч блоков одновременно, что позволяет эффективно использовать доступные ресурсы.

Важно настроить количество потоков и блоков таким образом, чтобы максимизировать использование всех доступных вычислительных единиц. В противном случае можно столкнуться с неэффективным использованием GPU, что приведет к снижению производительности.

Рекомендации по организации вычислений:

- Размеры блоков и сеток: Начинайте с сетки 1D или 2D, где количество блоков кратно количеству доступных потоков, и используйте блоки размером 256 или 512 потоков.

- Доступ к памяти: Следите за правильной организацией доступа к глобальной памяти, минимизируя количество конфликтов между потоками при чтении и записи данных.

- Использование общей памяти: Используйте общую память для хранения данных, которые должны быть доступны всем потокам в блоке. Это ускоряет доступ к данным, но требует внимательной синхронизации потоков.

- Управление синхронизацией: Потоки внутри блока могут синхронизироваться с помощью встроенной функции __syncthreads(), но это может снизить производительность, если синхронизация используется избыточно. Планируйте её использование только в критических точках.

Правильная настройка потоков и блоков позволяет эффективно использовать мощности GPU и значительно повысить производительность вычислений, особенно при работе с большими объемами данных или сложными алгоритмами.

Оптимизация передачи данных между CPU и GPU для ускорения вычислений

Для начала важно учитывать, что передача данных между CPU и GPU осуществляется через память хоста (CPU) и память устройства (GPU). Если данные часто переносятся между этими двумя типами памяти, это может привести к значительным задержкам. Для уменьшения этих потерь следует учитывать следующие методы оптимизации.

1. Минимизация передачи данных: Одним из наиболее эффективных способов оптимизации является уменьшение объема данных, передаваемых между CPU и GPU. Это можно добиться путем выполнения более сложных вычислений на GPU, оставляя на CPU только те данные, которые невозможно эффективно обработать на графическом процессоре. Также можно использовать технику «передачи только необходимых данных», т.е. загружать в память GPU только те части данных, которые требуются для текущей вычислительной задачи.

2. Параллельная передача данных: Для оптимизации процесса передачи можно использовать параллельную загрузку данных в память устройства, параллельно с выполнением вычислений на GPU. Это позволяет значительно сократить время, когда GPU простаивает, ожидая завершения загрузки данных. Один из популярных методов – использование потоков или асинхронных операций для загрузки данных, что дает возможность одновременно выполнять вычисления и передачу данных.

3. Использование Pinned Memory: Обычная память хоста (RAM) имеет низкую пропускную способность при передаче данных между CPU и GPU. Для увеличения скорости передачи рекомендуется использовать «запрещенную память» (pinned memory), которая позволяет ускорить этот процесс. Pinned memory позволяет GPU напрямую работать с данными в памяти хоста без необходимости копирования их в память устройства, что существенно сокращает время передачи.

4. Передача данных по частям: Когда объем данных слишком велик для одновременной загрузки в память GPU, необходимо использовать подход с передачей данных частями. Это позволяет значительно снизить нагрузку на канал передачи и сократить количество операций копирования данных. Однако важно учитывать, что при использовании такого подхода необходима оптимизация алгоритмов обработки данных для минимизации задержек, возникающих при передаче больших массивов информации.

5. Обработка данных на месте (in-place computation): В случае, если вычисления можно провести непосредственно в памяти GPU, это исключит необходимость постоянной передачи данных между CPU и GPU. Важно использовать алгоритмы, которые позволяют изменять данные в памяти GPU без их копирования назад в память хоста, что значительно ускоряет выполнение программ.

6. Использование эффективных библиотек для передачи данных: Важным инструментом для оптимизации является использование библиотек, специально предназначенных для высокоскоростной передачи данных. Например, библиотеки cuBLAS и cuDNN для линейной алгебры и нейронных сетей предоставляют встроенные функции для эффективной работы с памятью и передачи данных, что сокращает время на выполнение операций передачи.

7. Оптимизация использования копий данных: В некоторых случаях можно уменьшить время передачи, эффективно используя копии данных. Это значит, что данные можно дублировать на стороне GPU, что позволяет избежать постоянных копий в память хоста, улучшая общую производительность приложения. Однако важно следить за тем, чтобы не создавать лишних копий данных, которые могут привести к избыточному потреблению памяти и замедлению вычислений.

8. Использование прямого доступа к памяти (Direct Memory Access, DMA): При возможности использования Direct Memory Access можно значительно ускорить передачу данных между памятью устройства и памяти хоста, поскольку DMA позволяет передавать данные без участия CPU. Это также снижает нагрузку на процессор, ускоряя общую производительность приложения.

Внедрение этих стратегий в код позволяет значительно сократить время на передачу данных между CPU и GPU, тем самым улучшая общую производительность вычислений при использовании CUDA.

Параллельные алгоритмы на Python с использованием CUDA: примеры реализации

Пример 1: Параллельное сложение массивов. Один из самых простых алгоритмов, который легко распараллелить на GPU, – это сложение двух массивов. В CUDA это можно реализовать следующим образом:

import pycuda.driver as cuda

import pycuda.autoinit

import numpy as np

from pycuda.compiler import SourceModule

# Генерация данных

N = 1000000

a = np.random.rand(N).astype(np.float32)

b = np.random.rand(N).astype(np.float32)

# Выделение памяти на GPU

a_gpu = cuda.mem_alloc(a.nbytes)

b_gpu = cuda.mem_alloc(b.nbytes)

c_gpu = cuda.mem_alloc(a.nbytes)

# Копирование данных на GPU

cuda.memcpy_htod(a_gpu, a)

cuda.memcpy_htod(b_gpu, b)

# CUDA код для сложения массивов

mod = SourceModule("""

__global__ void add_arrays(float *a, float *b, float *c, int N)

{

int i = threadIdx.x + blockIdx.x * blockDim.x;

if (i < N)

c[i] = a[i] + b[i];

}

""")

# Получение функции из модуля

add_arrays = mod.get_function("add_arrays")

# Запуск параллельного вычисления

block_size = 256

grid_size = (N + block_size - 1) // block_size

add_arrays(a_gpu, b_gpu, c_gpu, np.int32(N), block=(block_size, 1, 1), grid=(grid_size, 1))

# Копирование результатов обратно на CPU

c = np.empty_like(a)

cuda.memcpy_dtoh(c, c_gpu)

В этом примере данные копируются на GPU, затем выполняется параллельное сложение с использованием ядра CUDA, которое выполняет вычисления на каждом блоке и потоке. Результат копируется обратно на CPU.

Пример 2: Матричное умножение. Матричное умножение – одна из типичных задач для ускорения с помощью CUDA. Для эффективного выполнения этой операции на GPU важно правильно распределить работу между блоками и потоками. Пример реализации на Python с PyCUDA:

# Генерация данных

A = np.random.rand(512, 512).astype(np.float32)

B = np.random.rand(512, 512).astype(np.float32)

C = np.zeros((512, 512), dtype=np.float32)

# Выделение памяти на GPU

A_gpu = cuda.mem_alloc(A.nbytes)

B_gpu = cuda.mem_alloc(B.nbytes)

C_gpu = cuda.mem_alloc(C.nbytes)

# Копирование данных на GPU

cuda.memcpy_htod(A_gpu, A)

cuda.memcpy_htod(B_gpu, B)

# CUDA код для матричного умножения

mod = SourceModule("""

__global__ void matmul(float *A, float *B, float *C, int N)

{

int row = blockIdx.y * blockDim.y + threadIdx.y;

int col = blockIdx.x * blockDim.x + threadIdx.x;

if (row < N && col < N)

{

float sum = 0;

for (int k = 0; k < N; k++)

sum += A[row * N + k] * B[k * N + col];

C[row * N + col] = sum;

}

}

""")

# Получение функции из модуля

matmul = mod.get_function("matmul")

# Запуск параллельного вычисления

block_size = (16, 16, 1)

grid_size = (32, 32)

matmul(A_gpu, B_gpu, C_gpu, np.int32(512), block=block_size, grid=grid_size)

# Копирование результатов обратно на CPU

cuda.memcpy_dtoh(C, C_gpu)

В данном примере используется двумерная сетка блоков для распределения вычислений, что позволяет эффективно использовать GPU для матричного умножения. Важно подобрать размер блоков и сетки в зависимости от характеристик GPU.

Пример 3: Параллельная обработка изображений. CUDA также отлично подходит для задач обработки изображений, таких как фильтрация или преобразование. Например, можно параллельно применить операцию свертки к изображению. В PyCUDA это может быть реализовано следующим образом:

import cv2

# Загрузка изображения

image = cv2.imread('image.jpg', 0).astype(np.float32)

# Выделение памяти на GPU

image_gpu = cuda.mem_alloc(image.nbytes)

result_gpu = cuda.mem_alloc(image.nbytes)

# Копирование изображения на GPU

cuda.memcpy_htod(image_gpu, image)

# CUDA код для применения фильтра

mod = SourceModule("""

__global__ void apply_filter(float *image, float *result, int width, int height)

{

int x = blockIdx.x * blockDim.x + threadIdx.x;

int y = blockIdx.y * blockDim.y + threadIdx.y;

if (x < width && y < height)

{

result[y * width + x] = image[y * width + x] * 0.5f;

}

}

""")

# Получение функции из модуля

apply_filter = mod.get_function("apply_filter")

# Запуск параллельного вычисления

block_size = (16, 16, 1)

grid_size = (image.shape[1] // 16, image.shape[0] // 16)

apply_filter(image_gpu, result_gpu, np.int32(image.shape[1]), np.int32(image.shape[0]), block=block_size, grid=grid_size)

# Копирование результата обратно на CPU

result = np.empty_like(image)

cuda.memcpy_dtoh(result, result_gpu)

В данном примере выполняется параллельная обработка изображения с использованием простого фильтра, где каждый поток GPU обрабатывает отдельный пиксель или группу пикселей.

Для эффективной работы с CUDA в Python важно правильно настроить параметры ядра: размер блоков и сетки, количество потоков, использование общей памяти и другие параметры, которые зависят от задачи и архитектуры устройства. Правильное распределение вычислительных ресурсов GPU позволяет существенно ускорить выполнение алгоритмов, особенно при решении сложных задач обработки данных или математических вычислений.

Как избежать типичных ошибок при распараллеливании задач на CUDA

Распараллеливание на CUDA требует внимательности на каждом этапе разработки, поскольку ошибки могут существенно снизить производительность или вызвать сбои. Вот несколько основных рекомендаций, которые помогут избежать распространённых ошибок.

1. Неверная конфигурация блоков и сеток

Количество блоков и потоков должно быть оптимизировано в зависимости от архитектуры используемой GPU. Часто встречаются ошибки в расчетах размера сетки и блоков. Например, если количество блоков не соответствует размеру устройства или слишком велико, это может привести к неэффективному использованию ресурсов. Важно учитывать ограничение на количество потоков в блоке (до 1024 для большинства GPU) и размер сетки, подходящий для выбранного устройства.

2. Недостаточное управление памятью

Ошибки при управлении памятью, например, несоответствие между выделением и деаллокацией памяти на GPU, могут привести к утечкам и снижению производительности. Важно внимательно следить за размещением данных в глобальной, общей и локальной памяти GPU. Недооценка необходимости использования shared memory или чрезмерное обращение к глобальной памяти может существенно замедлить выполнение программы.

3. Неоптимизированные операции с памятью

Память, которая используется слишком часто, или чрезмерное использование глобальной памяти вместо shared memory или constant memory, может быть причиной потерь в производительности. Также важно помнить, что доступ к памяти в разных потоках должен быть организован так, чтобы минимизировать явления, такие как bank conflicts в shared memory.

4. Неверная синхронизация потоков

Использование неэффективной синхронизации между потоками может привести к блокировкам и неоправданным задержкам. Важно использовать команду __syncthreads() только там, где это действительно необходимо. Частые синхронизации замедляют выполнение, а их излишек может вызвать неоправданное ожидание потоков.

5. Неэффективное использование потоков

Не все задачи можно эффективно распараллелить на CUDA. Часто встречается ситуация, когда задача слишком мала, чтобы оправдать распараллеливание, или имеет зависимость, которая не позволяет потокам работать независимо. Также стоит избегать задач с малым количеством операций, так как затраты на организацию параллелизма могут превысить выгоду от ускорения вычислений.

6. Отсутствие профилирования

Без тщательного профилирования кода нельзя точно понять, какие части программы являются узкими местами. Использование инструментов, таких как nvprof или Nsight, поможет выявить ошибки в архитектуре программы, неправильно распределённые ресурсы и избыточные операции, которые замедляют выполнение программы.

7. Использование устаревших библиотек и функций

В старых версиях CUDA или устаревших библиотеках могут быть проблемы с производительностью или совместимостью. Рекомендуется регулярно обновлять CUDA и использовать более новые и оптимизированные версии библиотек, таких как cuBLAS, cuFFT или cuDNN, которые могут дать значительное улучшение производительности.

8. Ошибки при переходе данных между CPU и GPU

Каждое копирование данных между памятью CPU и GPU – это дорогостоящая операция. Часто бывает, что данные копируются слишком часто или неэффективно, что снижает производительность. Следует минимизировать количество копий, используя подходы, такие как асинхронные операции копирования или управление буферами данных на GPU.

9. Игнорирование ограничений GPU

Каждая архитектура GPU имеет свои особенности, такие как количество потоков, доступных блоков или максимальный размер shared memory. Использование этих параметров в расчётах конфигурации может существенно повысить производительность. Игнорирование этих особенностей может привести к неверной настройке, что снижает производительность даже при правильном алгоритме.

10. Неоптимальные алгоритмы

Не каждый алгоритм легко адаптируется для параллельного выполнения на GPU. Некоторые алгоритмы могут иметь слишком высокую степень зависимости между данными, что ограничивает распараллеливание. Важно выбирать такие алгоритмы, которые могут быть эффективно разделены на независимые задачи для каждого потока.

Следуя этим рекомендациям, можно избежать большинства типичных ошибок при распараллеливании задач на CUDA и значительно повысить производительность своих программ. Важно не только правильно организовать вычисления, но и профилировать код на каждом этапе для выявления узких мест и возможных улучшений.

Вопрос-ответ:

Что такое распараллеливание на CUDA и как оно работает в Python?

Распараллеливание на CUDA – это процесс разделения задачи на несколько частей, которые могут выполняться одновременно на разных вычислительных единицах графического процессора (GPU). В Python для этого используется библиотека Numba или PyCUDA, которые позволяют писать код, использующий вычисления на GPU. Это позволяет значительно ускорить выполнение задач, особенно тех, которые требуют обработки больших массивов данных или сложных вычислений.

Как настроить среду для использования CUDA в Python?

Для того чтобы начать использовать CUDA в Python, нужно выполнить несколько шагов. Во-первых, нужно установить драйверы NVIDIA и библиотеку CUDA, которая предоставляет доступ к GPU. Затем следует установить подходящую библиотеку для Python, например, Numba или PyCUDA. Важно, чтобы ваша видеокарта поддерживала CUDA, и чтобы все компоненты системы были совместимы. Также рекомендуется использовать Python версии, поддерживающей эти библиотеки, например, Python 3.x.

Какие задачи можно ускорить с помощью распараллеливания на CUDA в Python?

Распараллеливание на CUDA в Python эффективно для задач, которые требуют обработки больших объемов данных, таких как численные вычисления, моделирование, обработка изображений и видео, машинное обучение, а также любые задачи, где присутствуют многочисленные одинаковые операции. Например, обучение нейронных сетей, обработка больших массивов данных или выполнение операций с матрицами могут быть значительно ускорены благодаря распараллеливанию.

Сколько времени займет обучение CUDA в Python для новичка?

Время, которое потребуется для освоения CUDA в Python, зависит от исходных знаний в области программирования и параллельных вычислений. Для новичков в программировании и CUDA процесс может занять несколько недель или месяцев, чтобы полностью освоить все возможности и эффективно использовать GPU для ускорения вычислений. Однако уже через несколько дней обучения можно научиться простым приемам, таким как создание функций на GPU с использованием Numba или PyCUDA.

Какие преимущества и ограничения использования CUDA в Python для распараллеливания?

Основное преимущество использования CUDA – это значительное ускорение выполнения вычислений за счет параллельной обработки на графическом процессоре, что особенно важно для задач с большими объемами данных или сложными вычислениями. Однако есть и ограничения. Во-первых, CUDA требует наличия совместимой видеокарты от NVIDIA. Во-вторых, не все задачи могут быть эффективно распараллелены, особенно если алгоритм требует интенсивных последовательных вычислений. Также необходимо учитывать, что настройка и оптимизация программ под CUDA может быть сложной и потребовать дополнительных знаний.

Что такое распараллеливание на CUDA и как оно помогает улучшить производительность?

Распараллеливание на CUDA позволяет разделить вычисления между несколькими потоками и запускать их одновременно на GPU (графическом процессоре). Это значительно ускоряет выполнение задач, особенно при работе с большими объемами данных. В отличие от традиционного выполнения на центральном процессоре (CPU), GPU может обрабатывать множество операций одновременно, что сокращает время вычислений в несколько раз. Использование CUDA в Python через библиотеки, такие как Numba или PyCUDA, позволяет эффективно переносить части кода на GPU и ускорять выполнение программ.