Python – один из самых популярных языков программирования, благодаря широкому набору библиотек, которые позволяют решать самые разнообразные задачи. Важность выбора правильной библиотеки для конкретной задачи невозможно переоценить. Использование готовых решений не только ускоряет разработку, но и значительно повышает качество кода.

Второй шаг – освоение документации и примеров. Каждая библиотека имеет свой стиль работы, свои функции и особенности. К примеру, в NumPy работа с многомерными массивами отличается от стандартных операций с массивами Python, и для эффективного использования этих возможностей важно понимать как оптимизировать работу с большими данными и матрицами.

Третий шаг – это практическое применение библиотеки в реальных задачах. Начать стоит с небольших проектов, чтобы понять, как библиотека решает конкретные задачи, и какие паттерны лучше всего подходят для эффективного кода. Например, в машинном обучении часто используется scikit-learn, который предоставляет простые интерфейсы для создания моделей, а также инструменты для настройки гиперпараметров и кросс-валидации.

Для повышения продуктивности и написания качественного кода не забывайте о совместимости библиотек и зависимостях между ними. Инструменты вроде pip или conda помогут вам следить за версиями и пакетами, а виртуальные окружения позволят избежать конфликтов между проектами.

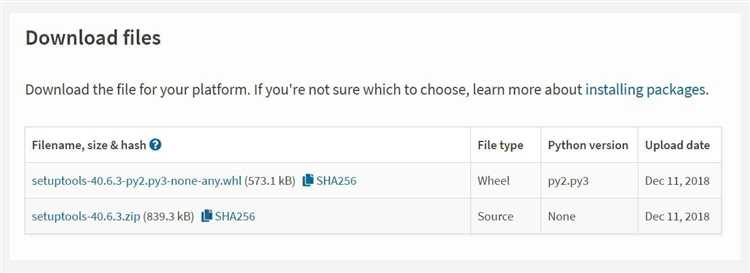

Как установить и настроить необходимые библиотеки для проекта

pip install <название_библиотеки>

Если проект требует определённых версий библиотек, укажите версию через `==`:

pip install <название_библиотеки>==<версия>

Если вам нужно установить несколько библиотек сразу, используйте файл зависимостей requirements.txt. Он содержит список всех нужных пакетов и их версий. Для его создания выполните команду:

pip freeze > requirements.txt

После этого любой участник проекта может установить все библиотеки с помощью команды:

pip install -r requirements.txt

Кроме того, рекомендуется использовать виртуальное окружение для изоляции зависимостей проекта. Виртуальное окружение помогает избежать конфликтов между библиотеками разных проектов. Для создания виртуального окружения используйте следующую команду:

python -m venv <путь_к_окружению>

Активировать окружение можно так:

source <путь_к_окружению>/bin/activate (Linux/macOS)

<путь_к_окружению>\Scripts\activate (Windows)

Для деактивации окружения используйте команду:

deactivate

Для настройки библиотек, которые не входят в стандартную библиотеку Python, но являются обязательными для проекта, часто используются дополнительные инструменты, такие как `pipenv` или `poetry`. Эти утилиты позволяют более гибко управлять зависимостями и версиями пакетов, обеспечивая лучшую совместимость и безопасность проекта.

При работе с конфигурацией зависимостей стоит следить за безопасностью. Регулярно обновляйте библиотеки с помощью команды:

pip list --outdated

Это позволяет контролировать актуальность используемых версий и избегать уязвимостей в проекте.

В случае необходимости установить библиотеки, которые требуют прав администратора, используйте команду с флагом `—user`, чтобы избежать проблем с правами доступа:

pip install --user <название_библиотеки>

Тщательно проверяйте документацию каждой библиотеки на наличие специфических инструкций по установке, чтобы исключить проблемы с несовместимостью версий или зависимостями между библиотеками.

Работа с числовыми данными: использование NumPy для быстрого вычисления

Основная структура данных в NumPy – это массив ndarray, который является более эффективным по памяти и скорости выполнения операций, чем стандартные списки Python. Например, NumPy позволяет выполнять операции над массивами без явных циклов, что значительно ускоряет выполнение программы.

Чтобы начать работу с NumPy, необходимо сначала импортировать библиотеку:

import numpy as npСоздание массивов с использованием NumPy:

np.array: создание массива из обычного списка Python.np.zeros: создание массива, заполненного нулями.np.ones: создание массива, заполненного единицами.np.arange: создание массива с заданным шагом.np.linspace: создание массива с заданным количеством элементов в заданном диапазоне.

Пример создания массива:

arr = np.array([1, 2, 3, 4])Базовые операции с массивами NumPy включают:

- Арифметические операции:

+, -, *, /, //, %, **. - Математические функции:

np.sum(), np.mean(), np.median(), np.std(), np.min(), np.max(). - Логические операции:

np.all(), np.any(), np.logical_and(), np.logical_or(). - Матричные операции:

np.dot(), np.matmul().

В отличие от стандартных списков Python, NumPy выполняет операции элемент-wise, то есть применяет операцию ко всем элементам массива одновременно, что значительно ускоряет вычисления. Например, умножение всех элементов массива на 2:

arr = np.array([1, 2, 3, 4])

arr = arr * 2 # Результат: [2, 4, 6, 8]Для работы с многомерными массивами NumPy поддерживает операции на различных осях, например, суммирование элементов по строкам или столбцам в матрице:

arr_2d = np.array([[1, 2, 3], [4, 5, 6]])

np.sum(arr_2d, axis=0) # Суммирование по столбцам: [5, 7, 9]Еще одно полезное применение NumPy – это работа с линейной алгеброй. Например, вычисление собственных значений и собственных векторов матрицы:

eigvals, eigvecs = np.linalg.eig(arr_2d)NumPy также полезен при решении систем линейных уравнений. Для этого можно использовать функцию np.linalg.solve(), которая решает систему вида Ax = b:

A = np.array([[3, 2], [1, 4]])

b = np.array([5, 6])

x = np.linalg.solve(A, b) # Результат: [1. 1.]

Для более сложных вычислений NumPy интегрируется с другими библиотеками, такими как SciPy, которая предоставляет более специализированные функции для оптимизации, интерполяции и численного решения дифференциальных уравнений. Для статистических задач часто используется библиотека pandas, которая также основана на NumPy, но предоставляет более удобные структуры данных.

Таким образом, NumPy является незаменимым инструментом для работы с числовыми данными, особенно когда важны скорость и эффективность выполнения операций. Его возможности позволяют легко и быстро решать широкий спектр задач, от простых математических операций до сложных вычислений в области линейной алгебры и статистики.

Как обрабатывать данные с помощью Pandas и анализировать таблицы

Для начала работы с Pandas необходимо импортировать библиотеку:

import pandas as pdОсновной структурой данных в Pandas является DataFrame. Это двумерная таблица с индексами строк и столбцов. Создание DataFrame из различных источников данных, таких как CSV, Excel или SQL, не вызывает трудностей:

df = pd.read_csv('data.csv')После загрузки данных можно применить основные методы для их анализа:

- Просмотр первых строк таблицы: Для быстрого анализа данных используйте head(), который возвращает первые 5 строк по умолчанию.

df.head()- Информация о данных: Метод info() позволяет узнать типы данных, количество строк и столбцов, а также количество ненулевых значений.

df.info()- Описательные статистики: Метод describe() предоставляет информацию о статистических характеристиках числовых столбцов: среднее, стандартное отклонение, минимальные и максимальные значения.

df.describe()Для фильтрации данных в Pandas можно использовать простые условия. Например, чтобы выбрать все строки, где значение в столбце age больше 30:

df[df['age'] > 30]Чтобы работать с отсутствующими данными, используйте методы isnull() и dropna(). Для заполнения пропущенных значений на основе других данных используется fillna():

df.fillna(df.mean())Для агрегации данных по группам в Pandas используется метод groupby(). Например, для вычисления среднего значения в столбце salary по группам в столбце department:

df.groupby('department')['salary'].mean()Если требуется выполнить несколько операций сразу, можно использовать метод agg():

df.groupby('department').agg({'salary': 'mean', 'age': 'max'})Для работы с временными рядами Pandas предоставляет мощные инструменты. Например, преобразование строки в формат даты и времени с помощью метода to_datetime():

df['date'] = pd.to_datetime(df['date'])С помощью resample() можно агрегировать данные по временным промежуткам. Например, для подсчета средней температуры за каждый месяц:

df.resample('M').mean()Когда необходимо создать новые столбцы, комбинируя значения из других столбцов, можно использовать простую операцию присваивания. Например, для вычисления возраста на основе даты рождения:

df['age'] = (pd.to_datetime('today') - df['birth_date']).dt.days // 365Кроме того, с помощью Pandas можно визуализировать данные, интегрируя библиотеку с Matplotlib. Например, для построения гистограммы значений в столбце salary:

df['salary'].plot(kind='hist')Таким образом, Pandas – это мощный инструмент для работы с данными, позволяющий эффективно обрабатывать, анализировать и визуализировать таблицы. С помощью его методов можно быстро находить нужную информацию и принимать обоснованные решения.

Использование Matplotlib для визуализации данных в Python

Для начала работы с Matplotlib достаточно импортировать библиотеку:

import matplotlib.pyplot as pltДалее можно использовать основные функции для создания различных типов графиков. Вот несколько ключевых аспектов:

- Графики линий: Этот тип визуализации используется для отображения зависимостей между переменными. Например, если нужно показать изменение значения какой-либо величины во времени, можно использовать следующий код:

plt.plot(x, y)

plt.show()- Гистограммы: Гистограммы полезны для анализа распределения данных. Чтобы создать гистограмму, используйте функцию

hist(), передав ей набор данных:

plt.hist(data, bins=20)

plt.show()- Диаграммы рассеяния: Этот тип графика отображает связи между двумя переменными. Чтобы построить диаграмму рассеяния, используйте метод

scatter(), как показано ниже:

plt.scatter(x, y)

plt.show()Важно: для улучшения восприятия графиков стоит настроить оси, добавить метки и заголовки. Для этого используются методы xlabel(), ylabel() и title().

plt.xlabel('X-axis')

plt.ylabel('Y-axis')

plt.title('Scatter Plot')

plt.show()- Множественные графики на одном изображении: Для отображения нескольких графиков на одном холсте, можно использовать функцию

subplot(). Она позволяет размещать несколько графиков в одной фигуре. Например:

plt.subplot(2, 1, 1) # 2 строки, 1 столбец, первый график

plt.plot(x, y)

plt.subplot(2, 1, 2) # 2 строки, 1 столбец, второй график

plt.scatter(x, y)

plt.show()С помощью Matplotlib можно изменять стили графиков: цвет линий, тип маркеров и линии. Это позволяет сделать визуализацию более читаемой и информативной. Используйте аргументы color, linestyle, marker для настройки внешнего вида графиков:

plt.plot(x, y, color='r', linestyle='--', marker='o')

plt.show()Также стоит учитывать, что Matplotlib хорошо работает в сочетании с другими библиотеками для анализа данных, например, Pandas. Для удобства можно преобразовать данные в объект DataFrame и строить графики напрямую:

import pandas as pd

df = pd.DataFrame({'x': x, 'y': y})

df.plot(x='x', y='y', kind='line')

plt.show()- Советы для улучшения визуализаций:

- Используйте сетки (метод

grid()) для лучшего восприятия данных. - Не перегружайте графики большим количеством информации.

- Используйте различные типы графиков для разных типов данных (например, линейные графики для временных рядов и гистограммы для распределений).

- Добавляйте легенды для объяснения значений на графиках (

plt.legend()).

Работа с Matplotlib позволяет создавать эффективные и наглядные визуализации, которые помогают анализировать данные, выявлять зависимости и тренды. Важно не только правильно выбрать тип графика, но и настроить его параметры так, чтобы информация была доступна для восприятия и понимания.

Реализация машинного обучения с библиотеками Scikit-learn и TensorFlow

Scikit-learn и TensorFlow – две ведущие библиотеки Python для реализации машинного обучения, каждая из которых имеет свои особенности и применения. Scikit-learn оптимален для классических задач машинного обучения, таких как классификация, регрессия и кластеризация, в то время как TensorFlow чаще используется для более сложных задач, включая нейронные сети и глубокое обучение.

Scikit-learn предоставляет простоту и удобство работы с данными, что делает её подходящей для быстрых прототипов. Например, для классификации данных с использованием метода опорных векторов (SVM) код может выглядеть следующим образом:

from sklearn import datasets

from sklearn.model_selection import train_test_split

from sklearn.svm import SVC

from sklearn.metrics import accuracy_score

# Загрузка данных

data = datasets.load_iris()

X = data.data

y = data.target

# Разделение на обучающую и тестовую выборки

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3)

# Обучение модели

model = SVC(kernel='linear')

model.fit(X_train, y_train)

# Оценка качества

y_pred = model.predict(X_test)

accuracy = accuracy_score(y_test, y_pred)

print(f'Accuracy: {accuracy}') Этот пример демонстрирует процесс от загрузки данных до оценки качества модели. Scikit-learn поддерживает широкий спектр алгоритмов, что позволяет решить многие стандартные задачи с минимальными усилиями.

TensorFlow же подходит для работы с более сложными моделями, включая нейронные сети. Он предоставляет мощный инструментарий для обучения моделей глубокого обучения и работы с большими данными. Пример создания и обучения простой нейронной сети с использованием TensorFlow:

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense

from tensorflow.keras.datasets import mnist

# Загрузка и подготовка данных

(X_train, y_train), (X_test, y_test) = mnist.load_data()

X_train, X_test = X_train / 255.0, X_test / 255.0

# Создание модели

model = Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28)),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# Компиляция модели

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# Обучение модели

model.fit(X_train, y_train, epochs=5)

# Оценка модели

test_loss, test_acc = model.evaluate(X_test, y_test)

print(f'Accuracy: {test_acc}') Этот код строит нейронную сеть для классификации изображений из набора MNIST, с использованием слоя Flatten для преобразования изображений в одномерные массивы и слоев Dense для обучения нейронной сети. TensorFlow требует больше усилий для настройки, но предоставляет гораздо более гибкие возможности для работы с различными архитектурами нейронных сетей.

Scikit-learn идеально подходит для простых и классических моделей машинного обучения, где не требуется глубокой настройки или сложных алгоритмов. TensorFlow, в свою очередь, следует использовать, когда задача включает в себя обработку больших данных или создание сложных нейронных сетей, где требуется высокая степень настройки и вычислительных ресурсов.

Как работать с API и получать данные через запросы с использованием Requests

Для начала необходимо установить библиотеку. Это можно сделать с помощью команды:

pip install requests

После установки, чтобы отправить запрос, достаточно вызвать функцию requests.get(), передав в неё URL-адрес API. Например, запрос к публичному API для получения информации о пользователях может выглядеть так:

import requests

response = requests.get('https://jsonplaceholder.typicode.com/users')

Результат запроса сохраняется в объекте response. Чтобы извлечь данные из этого объекта, можно использовать атрибут response.json(), который автоматически преобразует JSON-ответ в Python-словарь:

data = response.json() print(data)

При работе с API важно также учитывать статус-код ответа. Он помогает понять, успешно ли выполнен запрос. Статус-код можно получить через атрибут response.status_code. Например, если код равен 200, значит запрос прошёл успешно:

if response.status_code == 200:

print('Запрос выполнен успешно!')

else:

print(f'Ошибка: {response.status_code}')

Если API требует авторизации, то для передачи токена или других данных можно использовать заголовки. Это делается с помощью параметра headers. Например, для передачи токена авторизации:

headers = {'Authorization': 'Bearer your_token'}

response = requests.get('https://api.example.com/data', headers=headers)

Кроме того, в библиотеке Requests есть возможность отправлять данные методом POST. Для этого используется метод requests.post(). При отправке данных часто требуется передавать их в формате JSON. Это можно сделать следующим образом:

import json

data = {'key': 'value'}

response = requests.post('https://api.example.com/submit', json=data)

Стоит учитывать, что не все API возвращают данные в формате JSON. В некоторых случаях, например, при работе с веб-страницами, данные могут быть возвращены в виде HTML. В таких случаях для извлечения данных можно использовать атрибут response.text:

html_content = response.text print(html_content)

Если необходимо работать с параметрами в URL, их можно передавать через параметр params в методах requests.get() и requests.post(). Это удобный способ динамически формировать запросы с параметрами:

params = {'q': 'python', 'page': 1}

response = requests.get('https://api.example.com/search', params=params)

Иногда нужно управлять временем ожидания ответа. Для этого в библиотеке Requests есть параметр timeout, который позволяет задать максимальное время ожидания в секундах:

response = requests.get('https://api.example.com/data', timeout=5)

Если запрос не выполняется в течение указанного времени, будет выброшено исключение requests.exceptions.Timeout. Это можно обработать с помощью конструкции try-except:

try:

response = requests.get('https://api.example.com/data', timeout=5)

except requests.exceptions.Timeout:

print('Время ожидания истекло!')

Библиотека Requests предоставляет гибкие инструменты для работы с API. Для эффективного использования важно учитывать тип запроса, формат ответа и корректно обрабатывать возможные ошибки и исключения.

Организация тестирования кода с помощью библиотеки unittest

Для начала тестирования необходимо импортировать модуль unittest и создать класс, который будет наследовать unittest.TestCase. Этот класс позволяет использовать методы для проверки результатов выполнения функций и методов. Например:

import unittest

class MyTestClass(unittest.TestCase):

def test_addition(self):

self.assertEqual(1 + 1, 2)

В приведённом примере создается класс MyTestClass, который включает метод test_addition, тестирующий сложение. Метод assertEqual проверяет, что результат выражения 1 + 1 равен 2. Если условие не выполнится, тест завершится с ошибкой.

Тестирование в unittest можно организовать с помощью нескольких важных методов:

assertEqual(a, b)– проверяет, чтоa == b.assertNotEqual(a, b)– проверяет, чтоa != b.assertTrue(x)– проверяет, чтоxявляется истинным.assertFalse(x)– проверяет, чтоxявляется ложным.assertRaises(exception, callable, *args, **kwargs)– проверяет, что при вызове функции с аргументами генерируется исключение.

Пример использования assertRaises для проверки исключений:

def divide(a, b):

if b == 0:

raise ValueError("division by zero")

return a / b

class TestMathOperations(unittest.TestCase):

def test_divide_by_zero(self):

with self.assertRaises(ValueError):

divide(1, 0)

В данном примере проверяется, что функция divide выбрасывает исключение ValueError при делении на ноль.

Для организации более сложных сценариев тестирования используются методы setUp и tearDown, которые выполняются перед и после каждого теста соответственно. setUp можно использовать для инициализации данных или ресурсов, которые будут использованы в тестах, а tearDown – для их очистки.

class MyTestClass(unittest.TestCase):

def setUp(self):

self.data = [1, 2, 3]

def test_data_length(self):

self.assertEqual(len(self.data), 3)

def tearDown(self):

self.data = None

В этом примере перед каждым тестом создается список self.data, а после каждого теста он обнуляется в методе tearDown.

Для организации группировки тестов и улучшения структуры тестирования используют методы unittest.main() и запуск тестов через командную строку. Если тесты находятся в отдельных модулях, можно запустить все тесты с помощью:

python -m unittest discover

Команда unittest discover автоматически найдет все тестовые модули и выполнит их. Также можно указать путь к директории и шаблон имен файлов для тестов.

Для улучшения структуры тестов рекомендуется разбивать их на отдельные модули и использовать именование классов и методов в соответствии с их назначением. Например, для тестирования математических функций можно создать модуль test_math_operations.py, а для тестирования работы с данными – test_data_processing.py.

Кроме того, полезно использовать setUpClass и tearDownClass, если необходимо выполнить инициализацию и очистку ресурсов на уровне класса. Эти методы выполняются один раз до и после всех тестов класса:

class MyTestClass(unittest.TestCase):

@classmethod

def setUpClass(cls):

print("Setting up class resources")

@classmethod

def tearDownClass(cls):

print("Tearing down class resources")

Таким образом, unittest является мощным инструментом для организации тестирования кода в Python, позволяя обеспечить автоматизацию и стабильность работы программы. Правильное использование методов для проверки, инициализации и очистки позволяет создать качественные тесты и эффективно управлять тестированием.

Вопрос-ответ:

Что такое библиотеки Python и зачем они нужны?

Библиотеки Python — это наборы готовых функций, классов и инструментов, которые упрощают решение различных задач. Вместо того чтобы писать код с нуля, разработчики могут использовать библиотеки для работы с данными, создания веб-приложений, анализа информации и других целей. Это экономит время и позволяет быстро решать сложные задачи, используя проверенные решения.

Какие библиотеки Python самые популярные и почему?

Среди самых известных библиотек Python можно выделить NumPy для работы с массивами и матрицами, pandas для анализа данных, matplotlib и seaborn для визуализации данных, а также TensorFlow и PyTorch для машинного обучения. Эти библиотеки широко используются, так как предлагают эффективные методы обработки данных и машинного обучения, а также имеют большое сообщество и поддержку.

Как установить библиотеку Python и начать с ней работать?

Для установки библиотеки в Python обычно используется менеджер пакетов pip. Например, чтобы установить библиотеку pandas, достаточно в командной строке ввести команду pip install pandas. После этого библиотека будет доступна для импорта в вашем коде, и вы сможете использовать ее функции. Важно также следить за совместимостью библиотек с вашей версией Python.

Как выбрать подходящую библиотеку для решения задачи?

Выбор библиотеки зависит от типа задачи. Например, если нужно работать с большими объемами данных, лучше использовать pandas. Для задач машинного обучения и искусственного интеллекта подойдут библиотеки TensorFlow или PyTorch. Для статистического анализа можно обратить внимание на SciPy. Важно понимать особенности каждой библиотеки и изучить документацию перед использованием.

Какие ошибки часто делают новички при работе с библиотеками Python?

Одной из распространенных ошибок является неправильная установка или версия библиотеки, что может привести к ошибкам при импорте. Также начинающие разработчики могут не учитывать зависимости между библиотеками, что приводит к конфликтам версий. Еще одной ошибкой является недостаточное изучение документации, из-за чего использование библиотеки может быть неэффективным или неправильным. Чтобы избежать таких проблем, полезно работать в виртуальных окружениях и тщательно изучать каждый инструмент, с которым работаете.