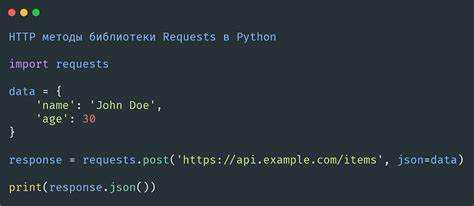

Библиотека requests является одной из самых популярных в Python для работы с HTTP-запросами. Однако, несмотря на свою простоту и удобство, она может демонстрировать низкую производительность при обработке большого числа запросов или при работе с API с высоким временем отклика. Чтобы повысить эффективность работы с requests, важно правильно настроить использование ресурсов и минимизировать время задержек.

Одним из основных способов ускорения работы библиотеки является использование сессий (session). Сессии позволяют повторно использовать одно и то же соединение для нескольких запросов, что снижает накладные расходы на установку TCP-соединений. В отличие от стандартных запросов, каждый из которых устанавливает новое соединение, сессия управляет подключениями и использует их повторно, что значительно ускоряет работу при выполнении множества запросов.

Ещё одним важным аспектом является правильная настройка таймаутов. Без заданных таймаутов библиотека будет ожидать ответа от сервера неопределённое время, что может затормозить выполнение запросов. Настройка таймаутов для requests позволяет избежать блокировки процесса при отсутствии отклика от сервера и ограничивает время ожидания, что в итоге ускоряет обработку запросов.

Также стоит обратить внимание на использование параллельных запросов. Библиотека requests по умолчанию работает синхронно, но можно ускорить выполнение, используя многозадачность через concurrent.futures или сторонние библиотеки, такие как grequests или aiohttp. Эти инструменты позволяют отправлять несколько запросов одновременно, что значительно снижает общее время выполнения при большом количестве запросов.

Использование сессий для многократных запросов

При выполнении нескольких запросов к одному и тому же серверу библиотека requests предлагает использовать сессии. Это позволяет уменьшить накладные расходы, связанные с повторным открытием соединений и аутентификацией.

Сессия позволяет повторно использовать соединения, что ускоряет выполнение запросов. Каждый запрос, сделанный через сессию, будет использовать те же настройки соединения и заголовки, что и предыдущие. Это значительно сокращает время на установление соединений и пересылку данных для каждого нового запроса.

Для использования сессии создайте объект requests.Session(), а затем выполняйте запросы через его методы. Пример:

import requests

session = requests.Session()

session.get('https://example.com')

# Выполнение еще нескольких запросов с использованием той же сессии

session.get('https://example.com/page1')

session.get('https://example.com/page2')

Важно: сессия сохраняет куки, что позволяет использовать их при последующих запросах. Это полезно для работы с авторизацией, когда сервер требует наличие идентификаторов сессии для доступа к ресурсам.

Если вам нужно задать заголовки, параметры или другие настройки, это можно сделать один раз для всей сессии. Например:

session.headers.update({'User-Agent': 'MyApp/1.0'})

Кроме того, сессии позволяют управлять тайм-аутами, прокси-серверами и аутентификацией, задавая эти параметры один раз для всех запросов. Это особенно эффективно при работе с API, которые требуют аутентификации с токенами или другими методами авторизации.

Использование сессий снижает задержки и нагрузку на сервер, что особенно важно при высокочастотных запросах или работе с большими объёмами данных. Сессии идеально подходят для взаимодействия с RESTful API, где необходимо поддерживать состояние между запросами.

Как снизить время отклика с помощью прокси

Использование прокси-серверов может существенно сократить время отклика при работе с библиотекой requests, особенно если вы взаимодействуете с ресурсами, находящимися в разных регионах или имеющими высокую нагрузку. Важно правильно настроить прокси, чтобы избежать ненужных задержек и обеспечить стабильную скорость работы.

Во-первых, прокси помогает распределять нагрузку и уменьшать вероятность блокировки запросов. С помощью нескольких прокси-серверов можно чередовать их использование, что позволяет снизить количество запросов, поступающих с одного IP-адреса, и уменьшить шансы на блокировку. Также стоит учитывать географическую близость прокси-сервера к целевому ресурсу: использование прокси, находящегося ближе к серверу, может снизить время отклика.

Во-вторых, важно выбирать качественные прокси. Бесплатные или открытые прокси часто бывают медленными и ненадежными, что может наоборот увеличить время отклика. Использование платных и проверенных прокси-сервисов или создание собственных прокси-серверов позволит добиться стабильной скорости.

Пример настройки прокси для библиотеки requests:

import requests

proxies = {

'http': 'http://user:password@proxyserver:port',

'https': 'https://user:password@proxyserver:port',

}

response = requests.get('https://example.com', proxies=proxies)

print(response.text)Кроме того, использование прокси-серверов с поддержкой HTTP/2 может ускорить время отклика за счет более эффективного мультиплексирования запросов. В этом случае стоит убедиться, что ваш прокси-сервер и целевой ресурс поддерживают этот протокол.

Не стоит забывать и о настройке таймаутов. Прокси-сервер может быть недоступен по разным причинам, и если таймауты не настроены должным образом, это приведет к задержкам. Используйте параметр timeout в запросах, чтобы избежать зависания программы в случае проблем с прокси:

response = requests.get('https://example.com', proxies=proxies, timeout=10)Наконец, для улучшения стабильности работы рекомендуется использовать ротацию прокси. Это можно реализовать с помощью специальных библиотек, например, requests-ip-rotator, которые автоматически переключают прокси при каждом запросе. Это позволяет минимизировать риски блокировок и сделать работу с requests быстрее и эффективнее.

Настройка таймаутов для улучшения скорости

Таймауты – важный инструмент для контроля времени ожидания ответа от серверов, что помогает улучшить производительность при работе с библиотекой requests. Установка правильных значений таймаутов предотвращает зависания и лишние задержки, особенно при работе с внешними API или серверными запросами, которые могут быть нестабильными.

Использование параметра `timeout` в requests позволяет задать максимальное время ожидания ответа от сервера. Это значение передаётся как аргумент при вызове функции `requests.get()` или `requests.post()`. Таймаут можно установить как одно число (время в секундах), так и кортеж, где первое значение – это время для установления соединения, а второе – для ожидания данных.

Пример для запроса с таймаутом 3 секунды:

import requests

response = requests.get('https://example.com', timeout=3)

Когда используется кортеж, например, `(1, 5)`, первое значение указывает на время подключения (1 секунда), а второе – на ожидание получения данных (5 секунд). Это полезно, когда важно быстро установить соединение, но время для получения ответа может быть немного длиннее.

import requests

response = requests.get('https://example.com', timeout=(1, 5))

Важно выбирать разумные значения таймаутов, которые балансируют между необходимостью получения данных и ожиданием, чтобы избежать блокировок и ненужных задержек. Для большинства API время соединения можно ограничить 1-2 секундами, а ожидание ответа – 5-10 секундами, в зависимости от сложности и объёма данных.

Для быстрого выполнения множества запросов рекомендуется использовать таймауты для каждого запроса. Если не указать таймаут, библиотека будет ожидать ответа от сервера по умолчанию, что может привести к длительным задержкам при неудачных или медленных соединениях.

Наконец, полезно учитывать, что таймауты не должны быть слишком короткими. Установка слишком низких значений может привести к тому, что запросы будут часто прерываться, даже если сервер работает стабильно, но с задержками. Правильная настройка таймаутов позволяет оптимизировать производительность, уменьшив общее время ожидания на каждом этапе запроса.

Оптимизация работы с HTTPS: сертификации и шифрование

Для ускорения работы с HTTPS стоит начать с обновления сертификатов. Старые или ненадёжные сертификаты могут замедлить процесс подключения. Использование библиотеки `certifi`, которая включает актуальный набор корневых сертификатов, поможет избежать проблем с безопасностью и повысить скорость установления соединений. Подключив её к requests, вы гарантированно используете оптимизированный и безопасный сертификатный стек.

Ещё одним важным аспектом является настройка шифрования. HTTP/2, поддерживаемый многими современными серверами, предлагает улучшенные методы обработки запросов, включая мультиплексирование и сжатие заголовков. Использование HTTP/2 в requests возможно через поддержку на уровне библиотеки, но важно удостовериться, что сервер также поддерживает этот протокол. Это позволяет значительно сократить задержки и повысить скорость обработки данных.

Для ускорения работы также важно использовать проверку сертификатов. Библиотека requests по умолчанию включает в себя механизм проверки SSL-сертификатов. Отключение этой проверки (например, через параметр `verify=False`) может ускорить соединение, но стоит делать это только в тех случаях, когда безопасность не является приоритетом, например, для внутренних тестов или работы с ненадёжными источниками.

Другой рекомендацией является использование постоянных подключений. Библиотека requests поддерживает сессии, что позволяет переиспользовать одно и то же соединение для нескольких запросов. Это значительно снижает накладные расходы на установление нового соединения и делает обработку запросов более быстрой.

Наконец, стоит обратить внимание на правильную настройку таймаутов. Устанавливая параметры `timeout`, можно избежать ситуаций, когда библиотека будет ждать ответа слишком долго. Слишком большие таймауты могут привести к ненужным задержкам, а их оптимальная настройка позволяет повысить производительность работы с сервером.

Сжатие данных: как уменьшить объём передаваемой информации

Сжатие данных позволяет значительно снизить объём передаваемой информации, ускоряя загрузку и экономя ресурсы сети. В библиотеке requests можно использовать различные методы сжатия, что делает работу с большими объёмами данных более эффективной.

HTTP-заголовок Accept-Encoding сообщает серверу, какие алгоритмы сжатия поддерживает клиент. Например, gzip, deflate, br – это самые распространённые варианты.

Библиотека requests автоматически обрабатывает сжатые данные, если сервер отправляет их в одном из поддерживаемых форматов. Чтобы воспользоваться сжатием, достаточно добавить заголовок Accept-Encoding в запрос:

import requests

url = "https://example.com"

headers = {"Accept-Encoding": "gzip, deflate, br"}

response = requests.get(url, headers=headers)

Если сервер поддерживает сжатие, он вернёт данные в одном из указанных форматов. Вы можете проверить, применялось ли сжатие, по заголовку Content-Encoding в ответе:

print(response.headers.get('Content-Encoding'))

Библиотека requests автоматически распакует такие данные, но если по каким-то причинам нужно самому обработать сжатие, можно использовать дополнительные библиотеки, такие как gzip или brotli.

- Gzip – один из самых распространённых алгоритмов сжатия. Он хорошо поддерживается как клиентами, так и серверами.

- Brotli – более новый и эффективный формат, который даёт лучшее сжатие при меньшем времени обработки.

Для использования Brotli в Python потребуется установить библиотеку brotlicffi:

pip install brotlicffi

После этого можно вручную распаковать данные, полученные в формате Brotli:

import brotlicffi

import requests

url = "https://example.com"

response = requests.get(url)

if response.headers.get('Content-Encoding') == 'br':

content = brotlicffi.decompress(response.content)

print(content)

Каждый алгоритм имеет свои особенности, и их выбор зависит от требований к скорости и степени сжатия. Важно помнить, что чрезмерное сжатие может увеличить нагрузку на процессор, так что всегда стоит искать баланс.

Использование сжатия не только ускоряет передачу данных, но и снижает использование пропускной способности, что особенно важно при работе с ограниченными сетями или большим количеством запросов.

Параллельные запросы с использованием threading или asyncio

Для повышения производительности библиотеки requests в Python часто применяют параллельные запросы. Это позволяет выполнять несколько HTTP-запросов одновременно, что сокращает общее время выполнения программы. В качестве основных инструментов для параллельных запросов часто используются threading и asyncio.

Threading работает путем создания нескольких потоков, каждый из которых выполняет отдельный запрос. Это подходит для задач, где важна простота реализации, но не требуется высокая производительность при большом количестве запросов. Чтобы использовать threading с библиотекой requests, можно применить ThreadPoolExecutor из модуля concurrent.futures. Пример кода:

import requests from concurrent.futures import ThreadPoolExecutor def fetch(url): response = requests.get(url) return response.text urls = ['https://example.com', 'https://example.org', 'https://example.net'] with ThreadPoolExecutor(max_workers=5) as executor: results = list(executor.map(fetch, urls))

Здесь создается пул потоков, каждый из которых выполняет запрос в пределах максимального числа потоков (max_workers). Этот подход эффективен, но его производительность ограничена GIL (Global Interpreter Lock), который ограничивает работу потоков на одном ядре процессора.

Asyncio позволяет создавать асинхронные задачи, которые не блокируют выполнение программы, что делает его более подходящим для задач с большим числом запросов. Он основан на событийном цикле, который выполняет задачи, не требуя блокировки потока. Для использования requests с asyncio лучше использовать библиотеку aiohttp, так как она предоставляет асинхронные аналоги функций requests. Пример кода:

import aiohttp import asyncio async def fetch(url): async with aiohttp.ClientSession() as session: async with session.get(url) as response: return await response.text() async def fetch_all(urls): tasks = [fetch(url) for url in urls] return await asyncio.gather(*tasks) urls = ['https://example.com', 'https://example.org', 'https://example.net'] results = asyncio.run(fetch_all(urls))

В этом примере используется aiohttp.ClientSession для асинхронных HTTP-запросов. Задачи выполняются параллельно, и программа не блокирует выполнение между запросами, что значительно ускоряет обработку большого числа URL.

Выбор между threading и asyncio зависит от задачи. Threading проще в реализации, но подходит для меньших объемов запросов и может столкнуться с проблемами при интенсивном использовании процессора. Asyncio более эффективен для задач с большим количеством I/O-операций, таких как HTTP-запросы, но требует дополнительных усилий для освоения асинхронного программирования.

Вопрос-ответ:

Как ускорить работу библиотеки requests при выполнении нескольких запросов?

Для ускорения запросов можно использовать несколько подходов. Один из них — это использование сессий с помощью `requests.Session()`. Сессии позволяют повторно использовать соединения TCP, что сокращает время на установку соединения для каждого запроса. Также полезно настроить пул соединений с помощью библиотеки `urllib3`, которая используется внутри `requests`. Это позволяет сделать несколько запросов за один и тот же период времени.

Как уменьшить время ожидания при использовании библиотеки requests?

Время ожидания можно снизить с помощью нескольких методов. Один из них — настройка тайм-аутов. Используя параметр `timeout` при отправке запроса, можно указать максимальное время ожидания ответа. Это предотвратит зависание программы в случае долгих задержек со стороны сервера. Также рекомендуется использовать асинхронные запросы, например, с библиотекой `aiohttp`, чтобы не блокировать выполнение программы во время ожидания ответа от сервера.

Можно ли ускорить работу с большими файлами через библиотеку requests?

Для работы с большими файлами можно использовать потоковую передачу данных. Это позволяет загружать файлы частями, а не загружать их целиком в память. В `requests` для этого нужно передавать параметр `stream=True` при отправке запроса. Это уменьшит нагрузку на память и ускорит загрузку, особенно если файл большой.

Как ускорить множество запросов с помощью библиотеки requests?

Для ускорения большого количества запросов можно использовать многозадачность, например, через библиотеку `concurrent.futures`. В случае с `requests` можно создавать пул потоков или процессов для выполнения запросов параллельно. Такой подход значительно уменьшает время выполнения при большом числе запросов, так как каждый запрос выполняется в отдельном потоке или процессе, что исключает блокировки.

Как ускорить обработку ответа от сервера при использовании requests?

Для ускорения обработки ответа можно работать с потоками. Например, при использовании метода `.iter_content()` можно обрабатывать данные, получаемые от сервера, по частям, что позволяет не загружать все данные в память сразу. Также стоит избегать ненужных преобразований данных и работать с ними в том виде, в каком они приходят, например, передавать данные напрямую в обработчики или записывать в файл без предварительных изменений.

Какие способы существуют для ускорения работы библиотеки requests в Python?

Для ускорения работы библиотеки requests можно использовать несколько подходов. Во-первых, можно включить сессионные соединения с помощью `requests.Session()`, что позволяет повторно использовать TCP-соединения, уменьшая время на установку новых подключений. Во-вторых, стоит обратить внимание на использование асинхронных библиотек, таких как `aiohttp`, которые позволяют выполнять несколько запросов одновременно, тем самым значительно сокращая общее время работы программы. В-третьих, важно минимизировать количество заголовков и параметров запроса, так как это может повлиять на скорость обработки. Наконец, следует избегать излишней обработки данных на стороне клиента, чтобы не замедлять выполнение программы.»

Как можно ускорить выполнение запросов в requests, если я отправляю много данных на сервер?

Если вы отправляете большие объемы данных на сервер с использованием библиотеки requests, есть несколько способов повысить скорость. Во-первых, можно использовать потоковую передачу данных с помощью параметра `stream=True`. Это позволяет не загружать все данные в память сразу, а передавать их частями, что особенно полезно при отправке больших файлов. Во-вторых, для ускорения отправки больших объемов данных можно воспользоваться параметром `timeout`, чтобы установить более короткое время ожидания ответа от сервера и предотвратить длительные задержки. Кроме того, стоит использовать сессию (`requests.Session()`), так как она позволяет переиспользовать соединения и тем самым ускоряет передачу данных при многократных запросах.»