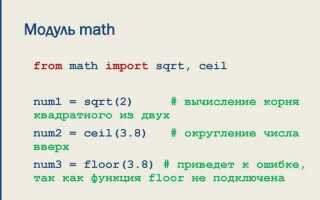

Собственный язык программирования создаётся не ради экзотики, а для решения задач, которые плохо укладываются в рамки существующих синтаксисов. Python позволяет построить DSL (domain-specific language) с нуля или встроить его в уже существующий код. Основные инструменты: модуль ast для работы с деревом разбора, tokenize для разбора текста на токены, ply и lark для создания парсеров.

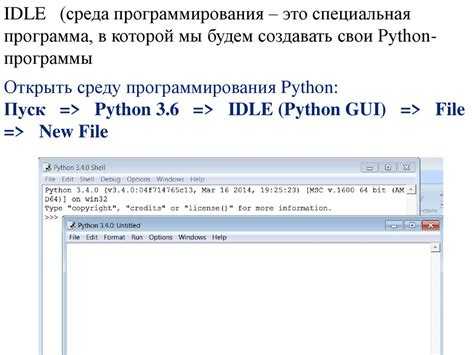

Минимальная реализация языка требует как минимум: определения грамматики, лексического анализа, синтаксического анализа и интерпретатора. В Python можно начать с простого REPL, используя eval и exec. Для более строгого управления синтаксисом применяют BNF-грамматику и генераторы парсеров, такие как PLY (Python Lex-Yacc).

Грамматика задаётся в виде правил: каждое правило – это функция, имя которой отражает структуру языка. Например, выражение сложения описывается функцией p_expression_plus, которая разбирает последовательность вида expression ‘+’ expression. Лексеры пишутся с помощью регулярных выражений, ассоциированных с токенами, например: t_PLUS = r’\+’.

После разбора создаётся абстрактное синтаксическое дерево. Его можно либо интерпретировать напрямую, либо транслировать в Python-код. Модуль ast позволяет генерировать корректные узлы дерева, которые затем можно компилировать через compile() и исполнять с помощью eval().

Для более сложных проектов разумно разделить язык на этапы: сначала реализовать арифметику, потом ветвления и циклы, затем – функции. Это позволяет изолировать ошибки и упростить отладку. Тестирование отдельных узлов дерева – обязательный шаг, особенно при реализации собственных типов или операторов.

Создание языка на Python – это не только упражнение в синтаксисе, но и инструмент для построения удобных интерфейсов, безопасного исполнения или генерации кода. Понимание процесса даёт больше контроля над кодом и открывает возможность создавать инструментальные языки для специфических задач.

Определение синтаксиса и грамматики будущего языка

На этапе проектирования синтаксиса необходимо определить, как будут записываться конструкции языка: объявления переменных, функции, условные операторы, циклы и другие элементы. Следует выбрать стиль: ближе к C-подобным языкам, Lisp или, например, использовать отступы, как в Python.

- Определите список ключевых слов. Они не должны пересекаться с идентификаторами.

- Установите правила именования переменных, функций и структур данных.

- Определите допустимые типы выражений: литералы, арифметические операции, вызовы функций, обращения к структурам.

- Решите, как будет выглядеть синтаксис условных операторов: использовать скобки, ключевые слова или специальные символы.

- Определите способ объявления функций и аргументов: позиционные, именованные, со значениями по умолчанию.

- Задайте правила вложенности блоков: через скобки или отступы.

Для формального описания грамматики используется BNF или её расширения (EBNF, PEG). Это необходимо для автоматической генерации парсера.

- Сформулируйте грамматические правила для каждого синтаксического элемента: выражения, инструкции, блоки.

- Избегайте неоднозначности: грамматика должна однозначно интерпретировать любую конструкцию.

- Продумайте приоритет операций и ассоциативность: это указывается в грамматике отдельно или через правила разбора.

- Минимизируйте количество исключений из общего синтаксиса. Чем он строже, тем проще реализация компилятора.

Перед реализацией стоит протестировать грамматику с помощью генераторов синтаксических деревьев (например, ANTLR или Lark), чтобы выявить конфликты и неоднозначности.

Выбор способа парсинга: генераторы парсеров против ручной реализации

Генераторы парсеров позволяют описывать грамматику в виде декларативных правил, из которых автоматически строится дерево разбора. Наиболее известные инструменты – PLY (Python Lex-Yacc), Lark, ANTLR (с поддержкой Python). Они подходят для сложных грамматик и упрощают поддержку кода. Например, в Lark можно задать правила в формате EBNF, а затем использовать встроенные трансформеры для построения абстрактного синтаксического дерева. Это сокращает время на отладку и уменьшает вероятность ошибок при изменении синтаксиса.

Недостатки генераторов – дополнительный уровень абстракции и сложность при интеграции с нестандартными структурами. Например, для реализации контекстно-зависимого синтаксиса потребуется постобработка или расширение базового парсера. Также, генераторы создают промежуточный код, который не всегда прозрачен для отладки.

Ручная реализация даёт полный контроль над процессом разбора. Это может быть удобно при написании компактных языков или DSL с ограниченным синтаксисом. Использование рекурсивного спуска позволяет точно управлять порядком разбора и реакцией на ошибки. Например, для арифметических выражений достаточно написать несколько функций: parse_expression, parse_term, parse_factor. Такая реализация проще встраивается в существующие проекты и не требует внешних зависимостей.

Основной минус ручного парсинга – высокая вероятность логических ошибок при росте грамматики. Изменение правил может потребовать переработки нескольких функций. Также усложняется поддержка при увеличении количества операторов и конструкций.

Рекомендация: для языков с простой или нестандартной грамматикой – ручной парсинг. Для полноценного языка с расширяемым синтаксисом – генератор парсеров. Важно учитывать объём планируемых изменений и требования к читаемости кода.

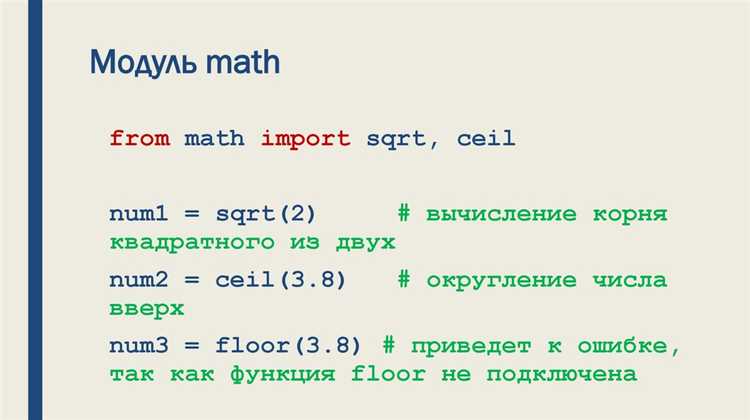

Реализация лексического анализатора с использованием регулярных выражений

Лексический анализатор (лексер) отвечает за разбиение исходного текста на элементы, которые называют токенами. Регулярные выражения предоставляют эффективный способ выделения токенов в строках. Для реализации лексера на Python, регулярные выражения можно использовать с модулем re.

Основная задача лексера – идентификация различных типов токенов. Пример токенов: идентификаторы, числа, операторы, ключевые слова. Регулярные выражения позволяют определить шаблоны для каждого из типов токенов. Например, для чисел можно использовать выражение \d+, для идентификаторов – [a-zA-Z_][a-zA-Z0-9_]*.

Чтобы создать лексер, первым шагом создается список регулярных выражений, каждое из которых будет соответствовать одному типу токена. Затем в коде используется цикл для поиска совпадений в строке с помощью функции re.match() или re.search(). Для каждого совпадения создается объект токена, который будет хранить тип токена и его значение.

Пример реализации лексического анализатора:

«`python

import re

# Список регулярных выражений для токенов

token_specs = [

(‘NUMBER’, r’\d+’),

(‘IDENTIFIER’, r'[a-zA-Z_][a-zA-Z0-9_]*’),

(‘OPERATOR’, r'[+\-*/=]’),

(‘WHITESPACE’, r’\s+’),

(‘UNKNOWN’, r’.’)

]

# Компиляция всех регулярных выражений

token_regex = ‘|’.join(f'(?P<{pair[0]}>{pair[1]})’ for pair in token_specs)

def lexer(code):

line_num = 1

line_start = 0

for match in re.finditer(token_regex, code):

kind = match.lastgroup

value = match.group()

if kind == ‘WHITESPACE’:

continue

elif kind == ‘UNKNOWN’:

raise SyntaxError(f’Неизвестный символ: {value}’)

yield kind, value

# Пример использования

code = «a = 10 + 20»

for token in lexer(code):

print(token)

В этом примере используются регулярные выражения для чисел, идентификаторов и операторов. Каждое совпадение обрабатывается в соответствии с типом токена, который определяется в token_specs.

Важный момент – исключение пробелов и обработка ошибок для неизвестных символов. Это позволяет лексическому анализатору работать с реальными программами и корректно распознавать синтаксические ошибки.

Использование регулярных выражений делает процесс лексического анализа простым и быстрым, что позволяет сосредоточиться на более сложных аспектах парсинга и компиляции.

Создание парсера с помощью библиотеки Lark или PLY

Для создания парсера на Python используются различные библиотеки, среди которых Lark и PLY предоставляют мощные инструменты для синтаксического анализа. Оба инструмента предлагают разные подходы к решению задачи, поэтому важно выбрать подходящий в зависимости от особенностей проекта.

Lark – это современная библиотека для парсинга, которая поддерживает несколько типов синтаксических анализаторов, включая LL(1), LALR(1) и Earley. Она подходит для работы с языками, требующими высокой гибкости, и легко интегрируется с Python-кодом. Lark позволяет использовать грамматики в формате EBNF, что упрощает создание парсеров для сложных языков.

PLY (Python Lex-Yacc) – это библиотека, которая реализует классы для лексического и синтаксического анализа в стиле классического инструмента Lex и Yacc. Она подходит для создания парсеров для более простых и традиционных языков. PLY требует явного указания грамматики, что может потребовать больше времени для настройки, но при этом предоставляет высокий контроль над процессом парсинга.

Для использования Lark необходимо установить библиотеку с помощью команды:

pip install lark-parser

Пример простого парсера на Lark:

from lark import Lark

grammar = """

start: "hello" "world"

"""

parser = Lark(grammar, start='start')

tree = parser.parse("hello world")

print(tree)

В данном примере парсер распознает строку «hello world» и генерирует синтаксическое дерево. Lark автоматически создает лексер и синтаксический анализатор на основе грамматики.

Для PLY установка выглядит следующим образом:

pip install ply

Пример парсера на PLY:

import ply.lex as lex

import ply.yacc as yacc

tokens = ('HELLO', 'WORLD')

t_HELLO = r'hello'

t_WORLD = r'world'

t_ignore = ' \t\n'

def t_error(t):

print("Error at '%s'" % t.value)

t.lexer.skip(1)

lexer = lex.lex()

def p_start(p):

'start : HELLO WORLD'

print("Parsed: hello world")

def p_error(p):

print("Syntax error")

parser = yacc.yacc()

lexer.input("hello world")

for token in lexer:

print(token)

parser.parse("hello world")

В примере для PLY сначала создается лексер с помощью регулярных выражений, а затем синтаксический анализатор, который обрабатывает структуру «hello world».

Обе библиотеки позволяют эффективно создавать парсеры для разных типов языков. Выбор между Lark и PLY зависит от нужд проекта: Lark больше подходит для гибких и сложных грамматик, в то время как PLY идеально подходит для реализации традиционных компиляторов и парсеров с явным контролем над процессом анализа.

Проектирование структуры абстрактного синтаксического дерева (AST)

Абстрактное синтаксическое дерево (AST) представляет собой иерархическую структуру, отображающую синтаксическую структуру исходного кода программы. При проектировании AST важно учитывать следующие аспекты:

- Типы узлов: Каждый узел AST должен представлять синтаксическую конструкцию. Например, узлы для операций (сложение, умножение), выражений, литералов, переменных и функций. Для каждого типа конструкции нужно создать отдельный класс или структуру данных.

- Дерево как иерархия: Важно, чтобы дерево правильно отражало приоритет операторов и структуру выражений. Операторы с более высоким приоритетом должны быть расположены ближе к корню, а операнды и их аргументы – на нижних уровнях дерева.

- Использование полиморфизма: Для того чтобы избежать дублирования кода при обработке различных типов узлов, можно использовать полиморфизм. Например, все узлы могут наследовать общий интерфейс, а конкретные реализации будут отвечать за выполнение операций, специфичных для своего типа узла.

- Оптимизация структуры: Для повышения производительности важно минимизировать количество узлов. Например, если два идентичных выражения встречаются несколько раз, можно использовать ссылки на уже созданные узлы для их повторного использования.

- Реализация узлов: Каждый узел должен содержать данные, которые позволяют выполнить соответствующие операции. Например, для арифметических операций узлы могут хранить данные о типах операндов и операторах. Для условных операторов узлы будут хранить ссылки на условия и блоки кода.

Пример структуры узлов для арифметических выражений:

- Листовой узел: Листовые узлы могут содержать примитивные данные, такие как числа, строки или переменные.

- Операторы: Узлы, представляющие операторы (например, +, -, *, /), должны иметь два или более дочерних узла, которые будут операндами.

- Функции и выражения: Для функций или вызовов можно создать отдельные узлы, которые будут хранить ссылки на их параметры и тело.

Для каждой операции важно грамотно спроектировать взаимодействие узлов, чтобы дерево оставалось логичным и легко модифицируемым. Рекомендуется начать с малого и постепенно расширять структуру AST, добавляя новые типы узлов по мере необходимости.

При проектировании AST стоит учитывать, что его структура должна быть удобной не только для компилятора, но и для инструментов анализа кода, таких как линтеры, автодополнение и отладчики. Понимание того, как будет использоваться AST в дальнейшем, помогает принять решения о его архитектуре.

Интерпретация AST: реализация семантики команд

Интерпретация абстрактного синтаксического дерева (AST) представляет собой ключевой этап в создании языка программирования. На этом этапе важно не только корректно интерпретировать структуру команд, но и правильно реализовать их семантику, чтобы обеспечить правильное выполнение программы.

Каждая команда, представленная в AST, содержит информацию о своем типе и операндах. Интерпретатор должен учитывать контекст выполнения этих команд, а также определять, как каждая из них влияет на состояние программы. Важно правильно работать с различными типами выражений: арифметическими операциями, условными конструкциями, циклическими структурами и вызовами функций.

Для реализации семантики команд необходимо организовать обработку каждой структуры дерева с учетом ее типа. Например, арифметические выражения нужно интерпретировать как операции над значениями, а условия – как проверки истинности выражений. Важно учитывать, как переменные и функции взаимодействуют друг с другом в рамках выполнения программы.

Основной задачей интерпретатора на этом этапе является приведение данных, представленных в AST, к исполнению в реальном времени. Это требует использования механизма сохранения состояния и контекста исполнения, таких как стеки вызовов и таблицы символов. Семантическая проверка помогает избежать ошибок, связанных с неопределенными или некорректными операциями.

Для корректной интерпретации AST и реализации семантики команд важно продумать и организовать обработку ошибок. При некорректных операциях или нарушениях логики исполнения интерпретатор должен возвращать понятные ошибки, чтобы разработчик мог быстро локализовать проблему.

Заключительный этап – выполнение команд. Это связано с разбором AST и их переводом в действия, которые взаимодействуют с системой или интерпретатором, обеспечивая нужный результат программы.

Добавление поддержки переменных, арифметики и управляющих конструкций

Для создания собственного языка программирования на Python важно правильно реализовать поддержку переменных, арифметических операций и управляющих конструкций. Это основные элементы, на которых строится синтаксис большинства языков.

Переменные можно реализовать через словарь, где ключами будут имена переменных, а значениями – их данные. Для этого потребуется механизм парсинга для интерпретации выражений, в которых переменные используются и присваиваются. Пример реализации для простого языка может выглядеть так:

variables = {}

def assign_variable(name, value):

variables[name] = value

Это позволит записывать значения в переменные и впоследствии использовать их в выражениях. Однако нужно учесть обработку типов данных, так как арифметика и сравнения будут зависеть от типа значений. Для этого следует добавить базовые проверки типов и поддержку преобразования типов.

Для реализации арифметических операций необходимо создать функции, которые будут обрабатывать математические выражения. Математические операции могут быть реализованы через простые функции, такие как:

def add(a, b):

return a + b

def subtract(a, b):

return a - b

def multiply(a, b):

return a * b

def divide(a, b):

if b != 0:

return a / b

else:

raise ValueError("Division by zero")

Эти функции можно вызывать в процессе интерпретации выражений, добавив механизмы для определения операндов и операций.

Для реализации управляющих конструкций, таких как условные операторы и циклы, потребуется обработка конструкций вида `if`, `else`, `while` или `for`. Одним из способов является создание парсера, который будет интерпретировать синтаксис конструкций и принимать решения на основе условий.

Пример для условных операторов:

def if_statement(condition, true_block, false_block): if condition: execute(true_block) else: execute(false_block)

Функция `execute` выполняет блоки кода, переданные в качестве аргументов. Эти блоки могут быть списками команд, которые интерпретатор обрабатывает по очереди.

Для циклов также потребуется функция, которая будет обрабатывать блоки кода до тех пор, пока условие цикла истинно:

def while_loop(condition, block): while condition: execute(block)

Таким образом, добавление переменных, арифметики и управляющих конструкций требует продуманной архитектуры парсера и интерпретатора. Сначала нужно обработать синтаксис команд, затем правильно интерпретировать операторы и выполнить соответствующие действия. По мере усложнения языка стоит добавлять поддержку более сложных конструкций, например, функций или классов.

Организация REPL или простого компилятора для языка

Основные этапы организации REPL:

1. Создание лексического анализатора (лексера), который будет разбирать строку на токены. В Python для этого удобно использовать библиотеку ply или tokenize. Лексер должен делить текст программы на слова (ключевые слова, операторы, идентификаторы и т.д.) и фильтровать их в структурированном виде.

2. Построение синтаксического анализатора (парсера). Парсер принимает список токенов и строит из них синтаксическое дерево. Для этого можно использовать библиотеки ply или lark-parser. Важно, чтобы парсер правильно определял структуру программы, например, выражения или функции.

3. Реализация семантического анализа и генерации промежуточного кода. На этом этапе производится проверка типов и других аспектов программы, чтобы убедиться в корректности ее выполнения. Промежуточный код может быть представлен в виде абстрактного синтаксического дерева (AST), которое затем используется для выполнения программы.

4. Реализация интерпретатора или транслятора. Интерпретатор будет выполнять код на лету, обходя AST. Для простого компилятора код можно преобразовывать в байт-код, который затем исполняется виртуальной машиной, такой как Python VM. В случае REPL важно, чтобы код сразу выполнялся, предоставляя пользователю мгновенную обратную связь.

Пример организации REPL на Python:

import sys

def evaluate_expression(expression):

try:

result = eval(expression)

return result

except Exception as e:

return str(e)

def repl():

while True:

try:

user_input = input(">>> ")

if user_input.lower() in ["exit", "quit"]:

break

print(evaluate_expression(user_input))

except EOFError:

break

if __name__ == "__main__":

repl()

Для создания простого компилятора, который будет генерировать байт-код, можно использовать модуль compile в Python. Сначала исходный код компилируется в байт-код, а затем исполняется через exec или другой механизм выполнения.

def compile_and_execute(source_code): try: compiled_code = compile(source_code, '', 'exec') exec(compiled_code) except Exception as e: print(f"Error: {e}") source_code = 'print("Hello, World!")' compile_and_execute(source_code)

Таким образом, можно построить базовую структуру для компилятора, который будет компилировать и исполнять код в одном процессе.

Организация REPL или компилятора требует правильного подхода к анализу и выполнению кода. Важно, чтобы система была гибкой, позволяя поддерживать расширение языка и добавление новых конструкций, не нарушая стабильности работы программы.

Вопрос-ответ:

Зачем создавать собственный язык программирования на Python?

Создание собственного языка программирования позволяет реализовать уникальные решения для специфических задач, автоматизировать процессы или улучшить понимание принципов работы языков программирования. Это может быть полезно для разработки специализированных инструментов, оптимизации кода или обучения. Также такой опыт помогает глубже понять теоретические и практические аспекты программирования, а также расширяет горизонты разработки.

Какие шаги нужно предпринять для создания языка программирования на Python?

Для создания языка программирования на Python сначала нужно определиться с целью языка — будет ли это язык для решения специфических задач или полноценная разработка. Затем необходимо разработать синтаксис, определить семантику команд и алгоритмы обработки команд. Основной задачей на следующем этапе является создание интерпретатора или компилятора, который будет обрабатывать программы на новом языке. Также важно разработать документацию и средства для тестирования, чтобы убедиться в корректности работы языка. По ходу создания можно будет улучшать и адаптировать язык в зависимости от потребностей.

Как можно начать разработку синтаксиса и грамматики собственного языка?

Разработка синтаксиса начинается с понимания, как будет выглядеть структура языка. Важно решить, будут ли в языке простые выражения или сложные конструкции. Далее нужно определить правила грамматики, например, как будут описываться операторы, переменные, функции. Это можно сделать с помощью метаязыков, таких как EBNF (Extended Backus-Naur Form), которые помогают четко описать синтаксис. Также стоит обратить внимание на наличие стандартных конструкций, таких как циклы и условия, которые необходимы для большинства языков программирования. После этого можно переходить к реализации интерпретатора или компилятора, который будет соблюдать эти правила.

Нужно ли разрабатывать компилятор для своего языка программирования на Python, или можно обойтись интерпретатором?

Для простых языков программирования часто достаточно интерпретатора, который будет выполнять команды по мере их чтения. Это упрощает разработку, так как интерпретатор не требует сложных этапов компиляции и позволяет быстрее тестировать и изменять язык. Однако если предполагается создание более сложного языка с высокой производительностью или если нужно более эффективно работать с памятью, может потребоваться компилятор. Компилятор преобразует исходный код в машинный, что позволяет ускорить выполнение программы, но также усложняет процесс разработки и тестирования. Поэтому выбор между компилятором и интерпретатором зависит от целей и сложности создаваемого языка.