В ситуациях, когда необходимо обрабатывать десятки или сотни файлов – например, логов, CSV-документов или JSON-структур – Python предоставляет гибкие и мощные инструменты. Ключевую роль играют модули os, pathlib и glob, позволяющие находить, фильтровать и систематически открывать файлы по маске, расширению и дате модификации.

Использование pathlib.Path.glob() позволяет находить файлы с заданным шаблоном и сразу работать с объектами пути. Это значительно надёжнее, чем строковая обработка путей. Например, выражение Path("logs").rglob("*.log") возвращает итератор по всем лог-файлам внутри каталога logs, включая подкаталоги.

Для параллельной обработки содержимого нескольких файлов имеет смысл использовать генераторы или библиотеку concurrent.futures. Это особенно актуально при анализе больших текстовых массивов, где чтение и предварительная фильтрация могут выполняться независимо. Подход с ThreadPoolExecutor эффективен при работе с большим количеством небольших файлов, а ProcessPoolExecutor – для ресурсоёмких операций.

Важно учитывать кодировку и формат данных: при открытии множества файлов в автоматическом режиме рекомендуется использовать chardet или cchardet для определения кодировки, а для структурированных форматов – использовать pandas с параметром chunksize для экономии памяти.

Систематизация обработки через функцию-обёртку повышает читаемость кода. Например, функция process_file(path: Path) -> dict может инкапсулировать чтение, разбор и возврат результата. Это упрощает использование map() или executor.submit() для пакетной обработки.

Чтение данных из нескольких файлов в цикле

Для обработки данных из набора однотипных файлов эффективнее всего использовать цикл с перечислением путей к файлам. На практике часто применяются функции из модуля os или glob для автоматического получения списка файлов в директории.

Пример с использованием glob:

import glob

for filepath in glob.glob('data/*.txt'):

with open(filepath, 'r', encoding='utf-8') as file:

content = file.read()

# Обработка содержимого

Маска 'data/*.txt' указывает на все текстовые файлы в папке data. Это особенно полезно, если файлы создаются автоматически и имена заранее неизвестны.

Если имена файлов формируются по шаблону, проще использовать генерацию имен:

for i in range(1, 11):

filename = f'data/file_{i}.csv'

with open(filename, 'r', encoding='utf-8') as f:

lines = f.readlines()

# Дальнейшая логика

Важно предусматривать обработку ошибок. При работе с множеством файлов возможны ситуации, когда некоторые из них отсутствуют или повреждены:

import os

filenames = ['input1.txt', 'input2.txt', 'missing.txt']

for name in filenames:

if not os.path.isfile(name):

continue

with open(name, 'r', encoding='utf-8') as f:

process(f)

Такой подход снижает вероятность сбоев при выполнении скрипта и обеспечивает устойчивость к изменениям структуры данных.

Объединение содержимого файлов в один файл

Для объединения текста из нескольких файлов в один используют чтение содержимого поочерёдно и запись в целевой файл. Оптимально применять конструкцию with для автоматического закрытия файлов.

- Соберите список путей к исходным файлам. Это можно сделать вручную или через

os.listdir()с фильтрацией по расширению:

import os

source_dir = "source_files"

files = [os.path.join(source_dir, f) for f in os.listdir(source_dir) if f.endswith(".txt")]

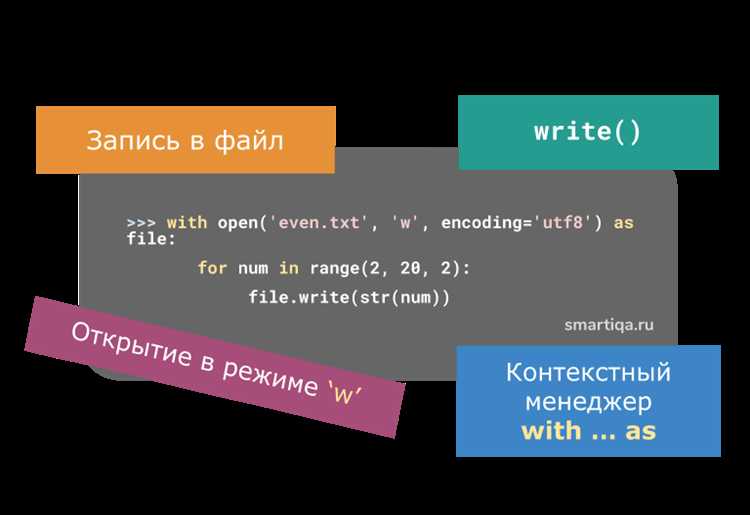

- Откройте файл назначения в режиме

'w'или'a'при необходимости дописывать, а затем поочерёдно читайте и копируйте данные:

with open("result.txt", "w", encoding="utf-8") as outfile:

for file_path in files:

with open(file_path, "r", encoding="utf-8") as infile:

outfile.write(infile.read())

outfile.write("\n") # Для разделения содержимого

- Следите за кодировкой. Все файлы должны быть в одинаковой кодировке, иначе возникнет

UnicodeDecodeError. - Избегайте дублирования данных. При необходимости проверьте уникальность содержимого до записи.

- Добавляйте разделители (например, пустую строку или маркеры), чтобы не смешивать тексты разных файлов.

- Для бинарных файлов используйте режимы

'rb'и'wb', а чтение выполняйте блоками:

with open("merged.bin", "wb") as outfile:

for file_path in binary_files:

with open(file_path, "rb") as infile:

while chunk := infile.read(8192):

outfile.write(chunk)

Скрипты подобного рода удобно оборачивать в функции и снабжать логированием для отслеживания ошибок и контроля процесса.

Обработка файлов с разными расширениями в одной директории

Для работы с файлами различных типов в одной папке используется модуль os в сочетании с glob или pathlib. Это позволяет фильтровать файлы по расширениям и применять к ним соответствующую обработку.

Пример перебора всех файлов с расширениями .txt, .csv и .json:

from pathlib import Path

directory = Path("путь/к/папке")

for file_path in directory.iterdir():

if file_path.suffix == ".txt":

with open(file_path, encoding="utf-8") as f:

text_data = f.read()

# обработка текстовых данных

elif file_path.suffix == ".csv":

import csv

with open(file_path, newline="", encoding="utf-8") as f:

reader = csv.reader(f)

csv_data = list(reader)

# обработка CSV-данных

elif file_path.suffix == ".json":

import json

with open(file_path, encoding="utf-8") as f:

json_data = json.load(f)

# обработка JSON-данных

Для массовой фильтрации и анализа можно использовать структуру словаря, где ключ – расширение файла, а значение – список соответствующих путей:

from collections import defaultdict

files_by_ext = defaultdict(list)

for file in directory.iterdir():

if file.is_file():

files_by_ext[file.suffix.lower()].append(file)

Такой подход позволяет централизованно управлять обработкой разных типов данных. Расширения рекомендуется приводить к нижнему регистру через .lower(), чтобы избежать дублирования при наличии одинаковых форматов с разным регистром (например, .CSV и .csv).

Если необходимо исключить определённые типы файлов, можно использовать условие отрицания или создать белый список разрешённых форматов:

allowed_exts = {".txt", ".csv", ".json"}

for file in directory.iterdir():

if file.suffix.lower() in allowed_exts:

# обработка разрешённых файлов

Для повышения производительности при большом числе файлов используйте генераторы и отложенную обработку, избегая загрузки всех данных в память одновременно.

Сравнение содержимого двух и более файлов

Для сравнения содержимого нескольких файлов в Python можно использовать различные подходы, в зависимости от типа данных и требуемой точности. Рассмотрим несколько способов реализации.

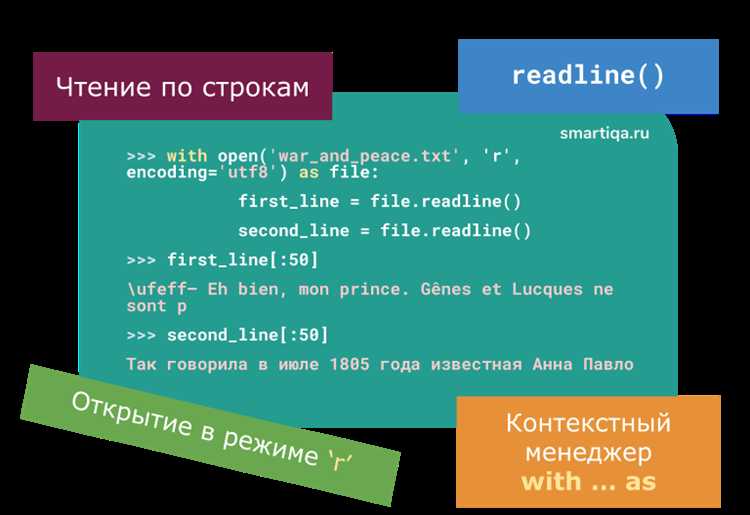

Первый метод – это посимвольное или построчное сравнение файлов. Для этого нужно открыть оба файла и читать их строки или символы поочередно. Использование функции zip() позволяет сравнивать файлы одновременно. Если файлы имеют одинаковую длину, можно сразу проверить их содержимое на совпадение:

with open('file1.txt', 'r') as f1, open('file2.txt', 'r') as f2:

for line1, line2 in zip(f1, f2):

if line1 != line2:

print("Файлы отличаются.")

break

else:

print("Файлы идентичны.")

Этот метод подходит для текстовых файлов с одинаковой структурой. Если файлы имеют разный размер, zip() прекратит сравнение после конца меньшего файла, поэтому важно учитывать этот момент.

Другой способ – это использование хеш-функций. Для файлов можно вычислить их хеши (например, с помощью алгоритма MD5 или SHA256) и сравнить их значения. Такой подход работает быстрее, особенно при большом объеме данных, так как позволяет избежать построчного чтения содержимого. Однако он требует дополнительного ресурса для вычисления хешей:

import hashlib

def get_file_hash(filename):

hash_md5 = hashlib.md5()

with open(filename, 'rb') as f:

for chunk in iter(lambda: f.read(4096), b""):

hash_md5.update(chunk)

return hash_md5.hexdigest()

hash1 = get_file_hash('file1.txt')

hash2 = get_file_hash('file2.txt')

if hash1 == hash2:

print("Файлы идентичны.")

else:

print("Файлы отличаются.")

import difflib

with open('file1.txt', 'r') as f1, open('file2.txt', 'r') as f2:

diff = difflib.unified_diff(f1.readlines(), f2.readlines(), fromfile='file1.txt', tofile='file2.txt')

for line in diff:

print(line)

Этот подход идеально подходит для текстовых файлов, где необходимо не просто проверить совпадение, но и вывести подробности различий. Для больших бинарных файлов использование difflib будет менее эффективно, так как она предназначена для работы с текстовыми данными.

Если необходимо сравнить несколько файлов одновременно, можно создать аналогичный цикл, который будет проходить по всем файлам и сравнивать их попарно. Важно помнить, что при работе с несколькими файлами нужно учитывать их размер и тип данных, чтобы выбрать наиболее подходящий способ сравнения.

Переименование и перемещение группы файлов с помощью скрипта

В Python для работы с файлами используется модуль os и shutil, которые позволяют эффективно переименовывать и перемещать несколько файлов в автоматизированном процессе.

Прежде чем приступить к перемещению и переименованию, важно учитывать структуру файловой системы и требования к новым именам. Рассмотрим пример, как выполнить эти операции для группы файлов в одном каталоге.

Переименование файлов

Для переименования файлов удобно использовать цикл и методы модуля os. Важно обеспечить уникальность новых имен, чтобы избежать ошибок при замещении файлов.

- Импортируем необходимые модули:

import os- Задаем исходную директорию и новый формат имен:

directory = "/путь/к/каталогу"

prefix = "new_file_"- Для каждого файла в директории генерируем новое имя и выполняем переименование:

for i, filename in enumerate(os.listdir(directory)):

old_path = os.path.join(directory, filename)

if os.path.isfile(old_path):

new_name = f"{prefix}{i+1}.txt" # Генерация нового имени

new_path = os.path.join(directory, new_name)

os.rename(old_path, new_path)В этом примере файлы переименовываются в формат new_file_1.txt, new_file_2.txt и так далее.

Перемещение файлов

Для перемещения файлов между каталогами можно использовать функцию shutil.move, которая переносит файлы из одного места в другое.

- Импортируем модуль

shutil:

import shutil- Указываем исходный каталог и целевой каталог:

source_directory = "/путь/к/исходному/каталогу"

destination_directory = "/путь/к/целевому/каталогу"- Перемещаем каждый файл из исходной директории в целевую:

for filename in os.listdir(source_directory):

source_path = os.path.join(source_directory, filename)

if os.path.isfile(source_path):

destination_path = os.path.join(destination_directory, filename)

shutil.move(source_path, destination_path)Этот код перемещает все файлы из исходной директории в целевую. Чтобы избежать перезаписи файлов с одинаковыми именами, можно добавить логику для генерации уникальных имен или использовать флаг replace.

Советы по работе с большими объемами файлов

- Используйте исключения для обработки ошибок. Например, проверка на существование файла или каталога поможет избежать неожиданных сбоев.

- Для увеличения производительности и упрощения кода можно использовать библиотеку

globдля получения списка файлов по шаблону. - Если нужно перемещать файлы между удаленными системами, рассмотрите использование

paramikoдля работы с SSH-протоколом.

Использование библиотеки pathlib для работы с множеством файлов

Библиотека pathlib в Python предоставляет удобные инструменты для работы с файловыми путями и их операциями. Для работы с множеством файлов она позволяет значительно упростить код и повысить его читаемость. В отличие от старого модуля os, pathlib использует объектно-ориентированный подход, что делает взаимодействие с файловой системой интуитивно понятным.

Одной из наиболее полезных функций является использование метода Path.glob(), который позволяет эффективно искать файлы в директориях по шаблону. Например, чтобы получить все текстовые файлы в каталоге, можно использовать следующий код:

from pathlib import Path

path = Path('/path/to/directory')

txt_files = path.glob('*.txt')

for file in txt_files:

print(file)Метод glob() возвращает генератор, что позволяет работать с большими наборами данных без необходимости загружать все файлы в память сразу. Если вам нужно найти файлы с определёнными расширениями в нескольких подкаталогах, можно использовать метод rglob(), который выполняет рекурсивный поиск:

all_txt_files = path.rglob('*.txt')

for file in all_txt_files:

print(file)Для выполнения операций с множеством файлов, таких как копирование или удаление, удобно использовать цикл. Например, чтобы удалить все файлы с расширением .log в каталоге, можно использовать:

for log_file in path.glob('*.log'):

log_file.unlink()При этом важно помнить, что метод unlink() удаляет файл, а не директорию. Для удаления пустой директории можно использовать метод rmdir().

В случае необходимости получить абсолютный путь к файлам, можно воспользоваться атрибутом absolute(). Это полезно, если необходимо работать с путями, независимыми от текущей рабочей директории:

for file in path.glob('*.txt'):

print(file.absolute())Работа с несколькими файлами через pathlib позволяет избежать множества трудоёмких операций, упрощая задачи, такие как поиск, сортировка и манипуляции с файлами. Библиотека предоставляет мощные инструменты для эффективного взаимодействия с файловой системой, позволяя писать компактный и понятный код.