Скачивание HTML страницы с помощью Python – это основа работы с веб-данными, которая позволяет автоматически извлекать контент для последующей обработки или анализа. Задача вполне выполнима с использованием библиотеки requests, одной из самых популярных в Python для работы с HTTP-запросами. Она позволяет быстро и просто отправить запрос к веб-ресурсу и получить HTML-код страницы.

Для начала работы необходимо установить библиотеку requests. Это можно сделать с помощью команды в терминале:

pip install requests

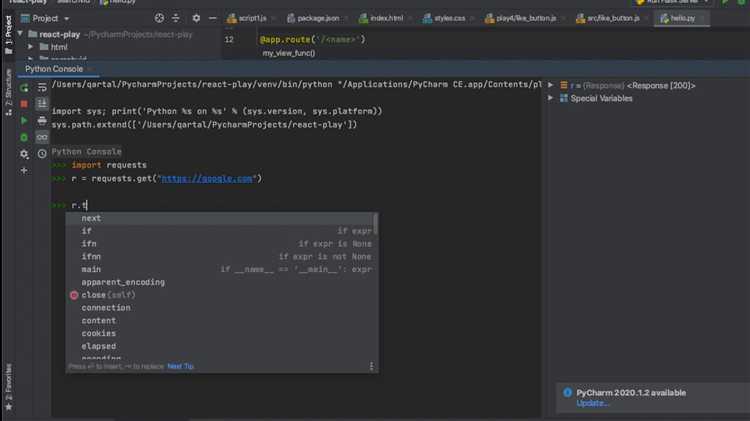

После этого достаточно вызвать функцию requests.get() для получения HTML-кода страницы. Ответ будет содержать всю информацию, включая код HTML, статус ответа и другие метаданные. Рекомендуется всегда проверять статус ответа, чтобы убедиться, что запрос был успешным (код 200), и только потом продолжать обработку.

Пример простого кода для скачивания страницы:

import requests

url = 'https://example.com'

response = requests.get(url)

if response.status_code == 200:

html_content = response.text

else:

print('Ошибка при скачивании страницы:', response.status_code)

Для удобства работы с HTML-контентом можно использовать дополнительные библиотеки, такие как BeautifulSoup для парсинга, что позволит легко извлекать нужные данные из страницы, например, ссылки или изображения.

Установка необходимых библиотек для скачивания HTML

Для загрузки HTML-страниц в Python чаще всего применяются библиотеки requests и httpx. Первая обеспечивает простую и стабильную работу с HTTP-запросами, вторая – асинхронную загрузку и более высокий контроль над соединением.

Установка выполняется через pip. Ниже приведены команды для установки:

| requests | pip install requests |

| httpx | pip install httpx |

Если планируется последующая обработка HTML, полезно установить beautifulsoup4 или lxml:

| beautifulsoup4 | pip install beautifulsoup4 |

| lxml | pip install lxml |

Для работы в Jupyter Notebook может потребоваться установка ipykernel, если библиотека не активируется автоматически:

| ipykernel | pip install ipykernel |

Перед установкой рекомендуется обновить pip до актуальной версии:

| Обновление pip | python -m pip install --upgrade pip |

Использование библиотеки requests для загрузки страницы

Для загрузки HTML-страницы через Python используется метод get() из библиотеки requests. Эта библиотека позволяет отправлять HTTP-запросы и получать содержимое страниц без необходимости эмулировать действия браузера.

- Установите библиотеку:

pip install requests - Импортируйте:

import requests - Отправьте запрос:

response = requests.get('https://example.com') - Проверьте статус:

response.status_code == 200 - Получите содержимое:

html = response.text

Если сервер требует заголовки, добавьте параметр headers:

headers = {'User-Agent': 'Mozilla/5.0'}

response = requests.get('https://example.com', headers=headers)Для обработки ошибок используйте блок try-except:

try:

response = requests.get('https://example.com', timeout=10)

response.raise_for_status()

html = response.text

except requests.exceptions.RequestException as e:

print(f'Ошибка: {e}')Если нужно сохранить страницу в файл:

with open('page.html', 'w', encoding='utf-8') as f:

f.write(response.text)Не используйте response.content для текстовых страниц – он возвращает байты. Для HTML используйте response.text с автоматическим определением кодировки.

Обработка ошибок при скачивании HTML страницы

При работе с сетью через requests нужно учитывать возможные исключения. Основные из них: requests.exceptions.RequestException – базовый класс для всех ошибок, ConnectionError – ошибка подключения, Timeout – превышено время ожидания, HTTPError – ошибка HTTP-статуса.

Рекомендуется устанавливать таймаут через параметр timeout, например: requests.get(url, timeout=5). Это предотвратит зависание при недоступных адресах.

Проверяйте код ответа сервера с помощью response.status_code. Для корректных страниц значение должно быть 200. Ошибки 4xx и 5xx следует обрабатывать отдельно. Пример: response.raise_for_status() выбросит исключение при ошибке.

Для повторных попыток можно использовать requests.adapters.HTTPAdapter с Retry из urllib3. Это позволяет задать стратегию повтора при сбоях:

from requests.adapters import HTTPAdapter

from requests.packages.urllib3.util.retry import Retry

session = requests.Session()

retries = Retry(total=3, backoff_factor=0.3, status_forcelist=[500, 502, 503, 504])

adapter = HTTPAdapter(max_retries=retries)

session.mount("http://", adapter)

session.mount("https://", adapter)

response = session.get(url, timeout=5)Также желательно логировать ошибки с сохранением адресов и описанием проблемы. Это упростит повторную отладку и исключит дублирование.

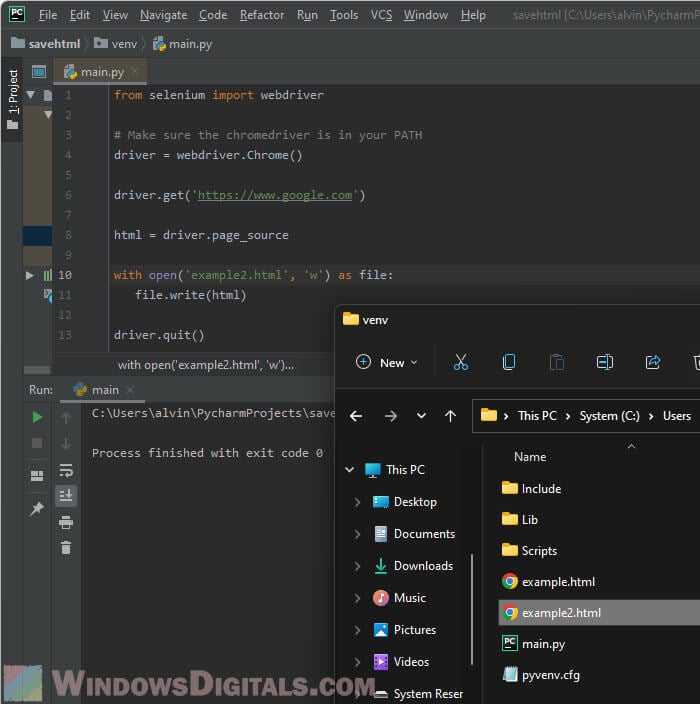

Сохранение содержимого страницы в файл

Для записи загруженного HTML-кода в файл используйте встроенные средства Python. Откройте файл в текстовом режиме с указанием кодировки, соответствующей содержимому страницы. Обычно применяется UTF-8.

Пример:

with open("страница.html", "w", encoding="utf-8") as f:

f.write(response.text)Если используется response.content, то файл нужно открывать в бинарном режиме:

with open("страница.html", "wb") as f:

f.write(response.content)Сохраняйте расширение файла в соответствии с типом контента. Для стандартных HTML-страниц – .html. Если предполагается дальнейший анализ, можно использовать .txt, но в этом случае теряется структура.

Учитывайте кодировку страницы: если сервер вернул заголовок Content-Type с параметром charset, используйте его. В противном случае используйте response.apparent_encoding из библиотеки requests:

response.encoding = response.apparent_encodingИзбегайте перезаписи существующих файлов, если важно сохранить несколько версий страницы. Для этого формируйте уникальные имена на основе времени или URL, например с использованием hashlib.md5:

import hashlib

url = "https://example.com"

filename = hashlib.md5(url.encode()).hexdigest() + ".html"

with open(filename, "w", encoding="utf-8") as f:

f.write(response.text)При работе с большим количеством файлов проверяйте наличие каталога и создавайте его при необходимости с помощью os.makedirs() и флага exist_ok=True.

Работа с заголовками HTTP и параметрами запроса

Для настройки заголовков используется параметр headers в функции requests.get(). Это позволяет имитировать поведение браузера или передавать данные, необходимые для доступа к странице. Пример: {'User-Agent': 'Mozilla/5.0', 'Accept-Language': 'ru-RU'}. Некоторые серверы блокируют запросы без заголовка User-Agent.

Параметры запроса передаются через аргумент params. Он должен быть словарём, где ключи – имена параметров, значения – передаваемые данные. Пример: params={'q': 'python', 'page': 2}. Библиотека requests автоматически кодирует параметры и добавляет их к URL.

Пример запроса с заголовками и параметрами:

import requests

url = 'https://example.com/search'

headers = {'User-Agent': 'Mozilla/5.0'}

params = {'query': 'html', 'lang': 'ru'}

response = requests.get(url, headers=headers, params=params)

html_content = response.text

Некорректные или подозрительные заголовки могут привести к ошибке 403 или 429. Для сложных случаев используйте Session из requests – это позволит повторно использовать заголовки и cookies в нескольких запросах.

Скачивание HTML страниц с учетом прокси-серверов

Для использования прокси при загрузке HTML страницы с помощью Python удобно применять библиотеку requests. Прокси может быть как HTTP, так и HTTPS. Стандартный формат словаря прокси: {"http": "http://IP:PORT", "https": "http://IP:PORT"}.

Пример загрузки с прокси:

import requests

proxies = {

"http": "http://123.123.123.123:8080",

"https": "http://123.123.123.123:8080"

}

headers = {

"User-Agent": "Mozilla/5.0"

}

response = requests.get("http://example.com", proxies=proxies, headers=headers, timeout=10)

html = response.text

Некоторые прокси требуют авторизацию. В этом случае формат меняется на http://user:password@IP:PORT. Пример:

proxies = {

"http": "http://user:pass@123.123.123.123:8080",

"https": "http://user:pass@123.123.123.123:8080"

}

Для контроля соединения указывайте таймауты, иначе скрипт может зависнуть при недоступности прокси. Таймаут задаётся в секундах: timeout=10.

Прокси часто нестабильны. Для повышения надёжности используйте список прокси с чередованием. Пример простой ротации:

from itertools import cycle

proxy_pool = cycle([

"http://123.123.123.1:8080",

"http://123.123.123.2:8080",

"http://123.123.123.3:8080"

])

for _ in range(3):

proxy = next(proxy_pool)

try:

response = requests.get("http://example.com", proxies={"http": proxy, "https": proxy}, timeout=5)

print(response.status_code)

break

except requests.exceptions.RequestException:

continue

Для массовых запросов с прокси лучше использовать библиотеку httpx с поддержкой асинхронности, что ускоряет выполнение при большом количестве URL.