Для работы с веб-страницами Python предлагает мощные инструменты, позволяющие легко извлекать HTML-код страниц. В этой статье мы рассмотрим, как скачать HTML код страницы с помощью библиотеки requests и BeautifulSoup, а также разберем основные моменты, которые стоит учитывать при парсинге данных с сайтов.

Первым шагом является установка необходимых библиотек. Для этого достаточно выполнить команды:

pip install requests

pip install beautifulsoup4

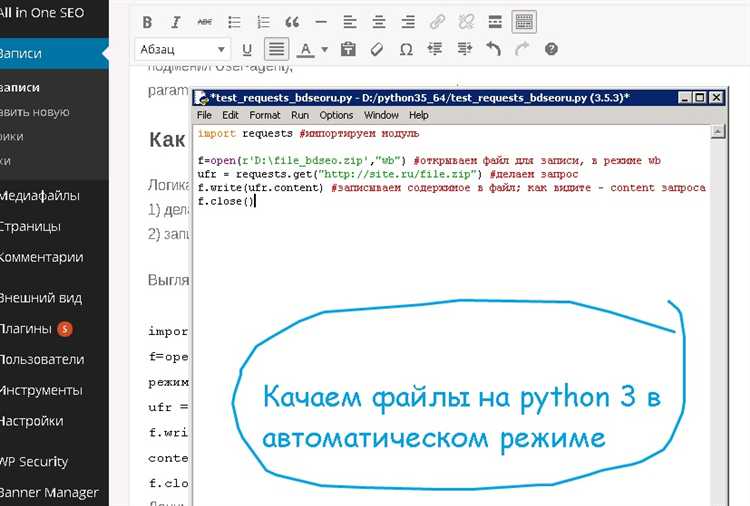

После установки можно приступать к скачиванию HTML-кода. С помощью библиотеки requests можно отправить HTTP-запрос на нужный ресурс, а затем получить текст страницы. Важно учитывать, что некоторые сайты могут блокировать запросы, сделанные с помощью Python, поэтому рекомендуется добавлять заголовки, имитирующие браузер.

Следующий шаг – парсинг полученного HTML-кода. Библиотека BeautifulSoup позволяет легко извлекать необходимые элементы из HTML-разметки, такие как теги, ссылки, изображения и другие данные. Этот инструмент помогает преобразовывать сложные веб-страницы в удобный для обработки формат.

Стоит помнить, что скачивание и использование контента с веб-страниц должно быть законным, а также следовать политике использования данных каждого сайта. Всегда проверяйте robots.txt и условия использования, чтобы избежать нарушений.

Подготовка рабочего окружения для скачивания HTML

Для скачивания HTML-кода страницы с помощью Python нужно установить несколько библиотек и настроить окружение. Рассмотрим важные шаги подготовки.

- Установка Python: Убедитесь, что у вас установлен Python. Для этого можно проверить командой

python --versionв командной строке. Если Python не установлен, скачайте его с официального сайта python.org. - Создание виртуального окружения: Чтобы избежать конфликтов между библиотеками, рекомендуется использовать виртуальное окружение. Создайте его с помощью команды:

python -m venv myenv

Для активации:

— Windows:

myenv\Scripts\activate

— macOS/Linux:source myenv/bin/activate - Установка необходимых библиотек: Для скачивания HTML-кода потребуется библиотека requests. Она позволяет отправлять HTTP-запросы и получать ответы. Установите её командой:

pip install requests

- Дополнительная библиотека: BeautifulSoup: Если планируется анализировать или парсить HTML после скачивания, полезной будет библиотека BeautifulSoup из пакета bs4. Установите её командой:

pip install beautifulsoup4

Теперь рабочее окружение настроено, и можно приступать к скачиванию HTML-страниц с помощью Python.

Установка библиотеки requests для работы с HTTP-запросами

Для выполнения HTTP-запросов в Python часто используется библиотека requests, которая упрощает взаимодействие с веб-страницами и API. Она поддерживает методы GET, POST, PUT, DELETE и другие, и позволяет работать с данными в различных форматах, таких как JSON и HTML.

Чтобы начать работать с requests, нужно сначала установить библиотеку. Для этого используйте pip – стандартный инструмент для установки пакетов в Python. Если у вас еще не установлен pip, следуйте инструкциям на официальном сайте Python для его установки.

Для установки requests откройте терминал (или командную строку) и выполните следующую команду:

pip install requestsЕсли вы используете несколько версий Python, уточните версию с помощью pip3, если это необходимо:

pip3 install requestsПосле завершения установки можно проверить, что библиотека установлена, выполнив команду:

python -c "import requests; print(requests.__version__)"Этот код выведет текущую версию библиотеки requests, что подтвердит успешную установку.

Если вы работаете в виртуальном окружении, убедитесь, что оно активировано перед установкой. Это позволит избежать конфликтов версий и обеспечить изоляцию зависимостей для вашего проекта.

Использование метода GET для получения HTML страницы

Чтобы получить HTML страницу, достаточно выполнить несколько шагов. Прежде всего, необходимо импортировать библиотеку requests. Затем можно вызвать функцию requests.get(), передав в неё URL целевой страницы. Это приведёт к отправке GET запроса и получению ответа от сервера.

Пример кода:

import requests

url = "https://example.com"

response = requests.get(url)

# Проверка успешности запроса

if response.status_code == 200:

html_content = response.text

print(html_content)

else:

print("Ошибка загрузки страницы, код статуса:", response.status_code)В данном примере выполняется запрос к странице https://example.com, после чего проверяется код статуса ответа. Если он равен 200, то сервер успешно вернул страницу, и можно обработать полученный HTML код.

Стоит учитывать, что запросы могут возвращать различные коды состояния HTTP. Например, код 404 означает, что страница не найдена, а код 500 указывает на внутреннюю ошибку сервера. Для надёжной работы с запросами важно всегда проверять код ответа, чтобы своевременно обработать ошибки.

Для более сложных запросов можно передавать дополнительные параметры, такие как заголовки (headers), cookies или данные формы. Например, если необходимо указать пользовательский агент для имитации запроса с браузера, это можно сделать, добавив заголовок User-Agent в запрос:

headers = {'User-Agent': 'Mozilla/5.0'}

response = requests.get(url, headers=headers)Использование метода GET с библиотекой requests – это простой и эффективный способ получить HTML код страницы. Однако при работе с большими объемами данных или многократными запросами важно учитывать ограничения сервера, чтобы избежать блокировок или слишком высокой нагрузки на сайт.

Обработка ошибок при скачивании HTML кода

Скачивание HTML через Python может завершиться неудачей по множеству причин: проблемы с сетью, ошибки на стороне сервера, ограничения со стороны целевого ресурса. Для надёжности необходимо обрабатывать исключения и проверять коды ответа HTTP.

- Используйте блок try-except. При работе с

requests.get()возможны исключенияrequests.exceptions.RequestException, охватывающие все сетевые ошибки. - Проверяйте статус-код ответа. Убедитесь, что код ответа сервера –

200. Другие коды, например403или404, указывают на запрет доступа или отсутствие страницы. - Ограничивайте таймаут. Устанавливайте таймаут явно, чтобы избежать зависаний:

requests.get(url, timeout=10). - Логируйте ошибки. Фиксируйте тип ошибки, URL и время запроса, чтобы упростить отладку. Пример: логируйте исключения в файл с помощью модуля

logging. - Реализуйте повторные попытки. При временных сбоях полезно автоматически повторять запросы с паузами. Используйте

urllib3.util.retry.Retryсrequests.adapters.HTTPAdapter.

Пример базовой структуры обработки:

import requests

from requests.exceptions import RequestException

url = "https://example.com"

try:

response = requests.get(url, timeout=10)

response.raise_for_status()

html = response.text

except RequestException as e:

print(f"Ошибка при скачивании: {e}")

Сохранение HTML кода в файл на локальном компьютере

Для сохранения HTML-кода страницы в файл необходимо использовать стандартные инструменты Python. После получения HTML-ответа от сервера с помощью библиотеки requests, можно записать его содержимое в файл с помощью встроенной функции open().

Пример кода:

import requests

url = "https://example.com"

response = requests.get(url)

with open("example.html", "w", encoding="utf-8") as file:

file.write(response.text)

Параметр encoding="utf-8" необходим для корректного сохранения русскоязычного контента. Расширение файла должно быть .html, чтобы его можно было открыть в браузере без ошибок. Не следует использовать бинарный режим записи ("wb"), так как строка HTML представлена в текстовом формате.

Перед сохранением рекомендуется проверить код ответа сервера: response.status_code == 200. Это предотвратит запись некорректного содержимого в случае ошибки загрузки.

При повторных сохранениях стоит реализовать проверку существования файла и при необходимости использовать уникальные имена, например с датой или временем: f"example_{datetime.now():%Y%m%d_%H%M%S}.html".

Как получить HTML код с использованием библиотеки urllib

Библиотека urllib входит в стандартную поставку Python и позволяет выполнять HTTP-запросы без установки сторонних модулей. Для получения HTML-кода страницы используется модуль urllib.request.

Пример базового запроса:

from urllib.request import urlopen

url = "https://example.com"

response = urlopen(url)

html = response.read().decode("utf-8")

print(html)

Метод urlopen() автоматически обрабатывает перенаправления и возвращает объект с методами для чтения данных. Для корректного отображения текста важно указать нужную кодировку. Если сайт использует другую кодировку, например windows-1251, её необходимо явно указать в методе decode().

Для задания пользовательского заголовка (например, User-Agent) используется объект Request:

from urllib.request import Request, urlopen

req = Request(

url="https://example.com",

headers={"User-Agent": "Mozilla/5.0"}

)

html = urlopen(req).read().decode("utf-8")

print(html)

Обработка ошибок выполняется через перехват исключений URLError и HTTPError из модуля urllib.error. Это позволяет получить точную причину неудачного запроса:

from urllib.error import URLError, HTTPError

try:

html = urlopen(req).read().decode("utf-8")

except HTTPError as e:

print(f"HTTP ошибка: {e.code}")

except URLError as e:

print(f"Ошибка URL: {e.reason}")

Для работы с HTTPS сайтами urllib использует встроенную поддержку SSL. Однако при необходимости можно отключить проверку сертификатов через параметр context с ssl._create_unverified_context().

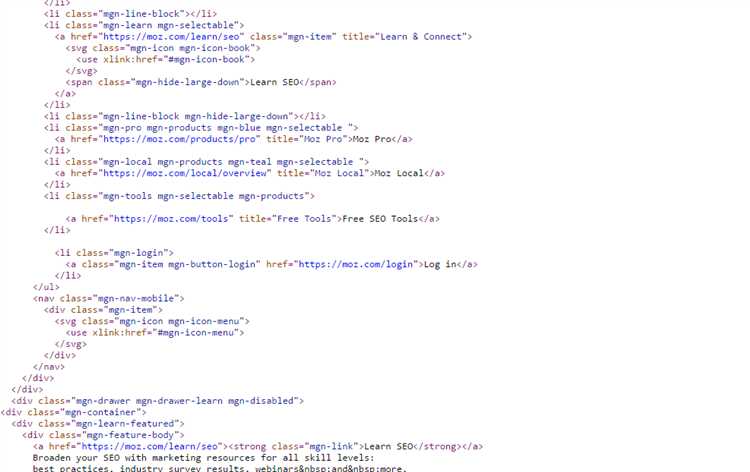

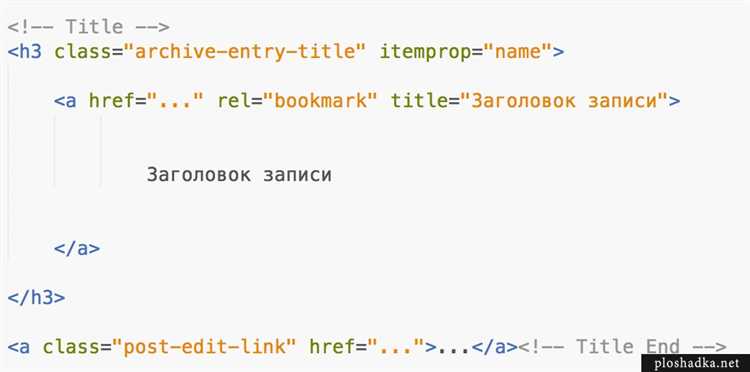

Парсинг HTML кода с использованием BeautifulSoup

Для разбора HTML-структуры используется библиотека BeautifulSoup из пакета bs4. Установить её можно через pip: pip install beautifulsoup4.

Создание объекта парсера: soup = BeautifulSoup(html_content, "html.parser"). В переменной html_content должен находиться HTML-код страницы в виде строки. Лучше использовать встроенный парсер html.parser, но при необходимости можно подключить lxml для повышения скорости.

Чтобы получить заголовок страницы: title = soup.title.string. Для извлечения всех ссылок: links = [a["href"] for a in soup.find_all("a", href=True)].

Поиск по тегу с атрибутами: divs = soup.find_all("div", {"class": "example"}). Поиск по id: element = soup.find(id="main").

Для получения текста без HTML-тегов: text = soup.get_text(strip=True). Это полезно при анализе содержимого без разметки.

Рекомендуется использовать методы select и select_one при необходимости CSS-селекторов: items = soup.select("ul.menu > li.active").

Перед парсингом стоит убедиться, что HTML загружен корректно. Используйте print(soup.prettify()) для визуальной проверки структуры.

Автоматизация процесса скачивания HTML с нескольких страниц

Для одновременного скачивания HTML-кода с множества URL-адресов рекомендуется использовать библиотеку aiohttp в сочетании с asyncio, что позволяет выполнять асинхронные HTTP-запросы и значительно ускоряет обработку.

Пример асинхронного скачивания:

import asyncio

import aiohttp

urls = [

"https://example.com/page1",

"https://example.com/page2",

"https://example.com/page3"

]

async def fetch(session, url):

async with session.get(url) as response:

return await response.text()

async def fetch_all(urls):

async with aiohttp.ClientSession() as session:

tasks = [fetch(session, url) for url in urls]

return await asyncio.gather(*tasks)

html_pages = asyncio.run(fetch_all(urls))

for i, content in enumerate(html_pages):

with open(f"page_{i+1}.html", "w", encoding="utf-8") as f:

f.write(content)

При большом количестве страниц разумно ограничить параллелизм через asyncio.Semaphore:

semaphore = asyncio.Semaphore(10)

async def fetch_limited(session, url):

async with semaphore:

return await fetch(session, url)

Для динамически формируемых списков URL (например, постраничная пагинация) используйте генераторы:

base_url = "https://example.com/page="

urls = [f"{base_url}{i}" for i in range(1, 101)] # страницы с 1 по 100

Учитывайте заголовки User-Agent и паузы между запросами, если сайт ограничивает частоту обращений:

headers = {"User-Agent": "Mozilla/5.0"}

async with session.get(url, headers=headers) as response:

...

Результаты удобно сохранять в файл или базу данных для последующей обработки. Избегайте одновременных запросов к одному и тому же домену при масштабной загрузке, чтобы снизить риск блокировки.